10分钟上手YOLOv11:最强姿态估计模型来了,代码开源,效果炸裂!

【10分钟玩转YOLOv11实时姿态估计】🚀 YOLOv11作为YOLO家族最新成员,在速度、精度和易用性上全面升级,尤其适用于姿态估计等复杂视觉任务。本文带您快速掌握: 1️⃣ 核心概念:姿态估计即识别人体17个关键点(如关节部位)并连接成数字骨架,是智能健身、体感游戏等应用的基础。 2️⃣ 技术优势: 超轻量级(最小仅2.9M参数) 极速推理(GPU仅1.7ms) 高精度(COCO mAP@

🚀 引言

作为YOLO家族的最新成员,YOLOv11不仅在速度和精度上再次突破,更重要的是,它让包括姿态估计在内的复杂视觉任务变得前所未有的简单。今天,我们就用10分钟时间,手把手带你玩转YOLOv11的实时姿态估计功能,体验一把最前沿的AI技术!

无论你是AI新手还是资深开发者,这篇教程都能让你快速上手,立即看到效果。准备好了吗?让我们开始这场AI视觉的奇妙之旅!

🤔 什么是姿态估计?3分钟让你秒懂

想象一下,你希望电脑能看懂一个人是在跑步、跳跃还是在挥手。要实现这一点,电脑首先需要识别人体的关键"节点"——比如头部、肩膀、手肘、膝盖和脚踝等,然后将这些点连接起来,形成一个"数字骨架"。

这个识别并连接人体关键点的过程,就是姿态估计(Pose Estimation)。它是实现以下酷炫应用的基础:

• 🏃♂️ 智能健身:实时纠正运动姿势

• 🎮 体感游戏:无需手柄的沉浸式体验

• 🏭 工业安全:监控工人操作规范性

• 📱 AR滤镜:精准的人体特效追踪

简单来说,姿态估计让机器拥有了"看懂人体动作"的超能力!

⚡ YOLOv11:更快、更强、更易用

YOLOv11继承了YOLO家族"快准狠"的优良传统,并通过全新优化的模型架构,实现了:

🎯 核心优势

• 参数更少:模型体积显著减小,部署更轻松

• 速度更快:推理速度大幅提升,实时性更强

• 精度更高:在COCO数据集上的mAP指标再创新高

• 易用性强:开箱即用的预训练模型,零门槛上手

📊 性能数据

以YOLOv11n-pose为例:

• mAP@50-95: 50.0%

• 推理速度: CPU上52.4ms,GPU上仅1.7ms

• 模型参数: 2.9M(超轻量级)

这意味着,我们可以在普通的个人电脑甚至手机上,流畅地运行复杂的姿态估计任务!

🛠️ 10分钟实战:手把手跑通YOLOv11姿态估计

理论不多说,我们直接上实操!三步搞定,保证你跟得上。

第一步:环境搭建 (2分钟)

首先,确保你的电脑安装了Python(推荐Python 3.8及以上版本)。然后,打开终端,只需一行命令:

pip install ultralytics没错,就是这么简单!ultralytics这个包已经为你准备好了一切,包括PyTorch等依赖。安装过程会自动进行,喝杯咖啡等待即可。☕

第二步:准备素材 (1分钟)

找一张包含人物的照片(比如运动照、生活照),或者一段有人物活动的短视频。将其保存在你方便查找的文件夹中。

💡 小贴士:如果没有合适的素材,可以直接使用网络图片URL,YOLOv11支持在线处理!

第三步:敲代码,见证奇迹 (7分钟)

这是最激动人心的部分!你既可以用命令行偷懒,也可以用Python脚本灵活控制。

方法一:命令行一键出结果(最简单)

如果你不想写任何代码,直接在终端里输入:

yolo predict model=yolo11n-pose.pt source='你的图片路径.jpg'参数说明:

• model=yolo11n-pose.pt:使用YOLOv11的nano姿态估计模型(最轻量)

• source='你的图片路径.jpg':替换成你的图片文件路径

• 支持视频文件或摄像头(source=0代表电脑摄像头)

第一次运行时,程序会自动下载模型文件,稍等片刻即可。

方法二:Python脚本(更灵活)

创建一个Python文件(例如pose_detection.py),复制以下代码:

from ultralytics import YOLO

# 加载预训练的YOLOv11姿态估计模型

model = YOLO("yolo11n-pose.pt")

# 指定你的图片或视频源

source = "你的图片路径.jpg"# 也可以是视频文件或摄像头ID

# 执行预测

results = model(source)

# 显示结果(可选)

for result in results:

# 获取关键点坐标

keypoints = result.keypoints.xy # x, y坐标

keypoints_norm = result.keypoints.xyn # 归一化坐标

# 保存结果图片

result.save(filename="result_pose.jpg")

# 打印检测到的人数

print(f"检测到 {len(keypoints)} 个人")

# 显示结果(需要GUI环境)

# result.show()

print("姿态估计完成!结果已保存为 result_pose.jpg")运行这个脚本:

python pose_detection.py🎉 结果展示

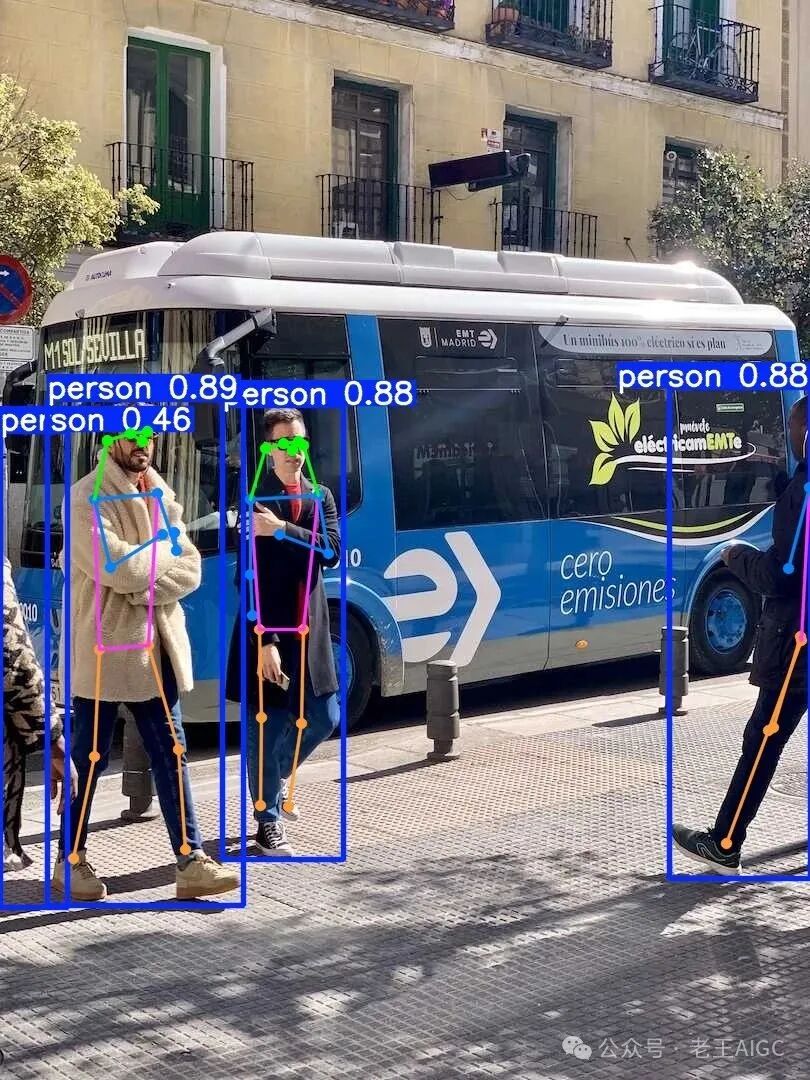

运行成功后,你将得到一张标注完美的图片!YOLOv11精准地识别出了图中人物的17个关键点:

• 面部:鼻子、左右眼、左右耳

• 上身:左右肩膀、左右手肘、左右手腕

• 下身:左右髋部、左右膝盖、左右脚踝

这些关键点用彩色圆点标出,并用线条连接成完整的人体骨架。整个过程是不是快到飞起?⚡

🚀 更进一步:从姿态到行为分析

掌握了基础的姿态估计后,你就可以构建更复杂的应用了!

💼 工业应用案例

在制造业中,可以开发一套SOP合规性监控系统:

from ultralytics import YOLO

import cv2

import numpy as np

classSafetyMonitor:

def__init__(self):

self.model = YOLO("yolo11n-pose.pt")

self.safety_violations = 0

defcheck_safety_posture(self, keypoints):

"""Check if worker posture is safe"""

# Simplified safety check logic

iflen(keypoints) > 0:

# Check for excessive bending (simplified example)

shoulder_y = keypoints[0][5][1] # Left shoulder Y coordinate

hip_y = keypoints[0][11][1] # Left hip Y coordinate

ifabs(shoulder_y - hip_y) < 50: # Adjustable threshold

return"Warning: Unsafe posture detected!"

return"Posture normal"

defdraw_keypoints(self, frame, keypoints):

"""Draw pose keypoints on the frame"""

iflen(keypoints) > 0andlen(keypoints[0]) >= 17:

# COCO pose connections for industrial safety monitoring

connections = [

(5, 6), (5, 7), (7, 9), (6, 8), (8, 10), # Arms

(5, 11), (6, 12), (11, 12), # Torso

(11, 13), (13, 15), (12, 14), (14, 16) # Legs

]

# Draw keypoints

for i, point inenumerate(keypoints[0]):

if point[0] > 0and point[1] > 0: # Valid keypoint

color = (0, 0, 255) if i in [5, 11] else (0, 255, 0) # Highlight shoulder and hip

cv2.circle(frame, (int(point[0]), int(point[1])), 6, color, -1)

cv2.putText(frame, str(i), (int(point[0])+8, int(point[1])-8),

cv2.FONT_HERSHEY_SIMPLEX, 0.4, (255, 255, 255), 1)

# Draw connections

for connection in connections:

pt1, pt2 = connection

if (pt1 < len(keypoints[0]) and pt2 < len(keypoints[0]) and

keypoints[0][pt1][0] > 0and keypoints[0][pt1][1] > 0and

keypoints[0][pt2][0] > 0and keypoints[0][pt2][1] > 0):

cv2.line(frame,

(int(keypoints[0][pt1][0]), int(keypoints[0][pt1][1])),

(int(keypoints[0][pt2][0]), int(keypoints[0][pt2][1])),

(255, 0, 0), 2)

defmonitor_video(self, video_path):

"""Monitor safety postures in video"""

cap = cv2.VideoCapture(video_path)

print("Starting industrial safety monitoring... Press 'q' to quit")

whileTrue:

ret, frame = cap.read()

ifnot ret:

break

# YOLO pose estimation

results = self.model(frame, verbose=False)

for result in results:

if result.keypoints isnotNone:

keypoints = result.keypoints.xy.cpu().numpy()

# Draw keypoints and skeleton

self.draw_keypoints(frame, keypoints)

# Check safety posture

safety_status = self.check_safety_posture(keypoints)

# Display safety information

color = (0, 0, 255) if"Warning"in safety_status else (0, 255, 0)

cv2.putText(frame, safety_status,

(10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, color, 2)

cv2.putText(frame, f"Safety Violations: {self.safety_violations}",

(10, 70), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (255, 255, 255), 2)

if"Warning"in safety_status:

self.safety_violations += 1

cv2.imshow('Industrial Safety Monitor', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

print(f"Monitoring ended! Total safety violations: {self.safety_violations}")

# Usage example

monitor = SafetyMonitor()

monitor.monitor_video("factory_surveillance.mp4")使用即梦生成视频测试如下:

🏃♂️ 健身应用案例

开发智能健身助手,实时纠正运动姿势:

from ultralytics import YOLO

import cv2

import numpy as np

import math

classFitnessMonitor:

def__init__(self):

self.model = YOLO("yolo11n-pose.pt")

self.squat_count = 0

self.in_squat = False

defcalculate_angle(self, point1, point2, point3):

"""计算三点之间的角度"""

vector1 = np.array([point1[0] - point2[0], point1[1] - point2[1]])

vector2 = np.array([point3[0] - point2[0], point3[1] - point2[1]])

cos_angle = np.dot(vector1, vector2) / (np.linalg.norm(vector1) * np.linalg.norm(vector2))

cos_angle = np.clip(cos_angle, -1.0, 1.0)

angle = math.degrees(math.acos(cos_angle))

return angle

defanalyze_squat_form(self, keypoints):

"""Analyze squat posture for correctness"""

iflen(keypoints) > 0andlen(keypoints[0]) >= 17:

try:

# Get keypoints (COCO format)

left_hip = keypoints[0][11] # Left hip

left_knee = keypoints[0][13] # Left knee

left_ankle = keypoints[0][15] # Left ankle

right_hip = keypoints[0][12] # Right hip

right_knee = keypoints[0][14] # Right knee

right_ankle = keypoints[0][16] # Right ankle

# Check if keypoints are visible

if (left_hip[0] > 0and left_knee[0] > 0and left_ankle[0] > 0and

right_hip[0] > 0and right_knee[0] > 0and right_ankle[0] > 0):

# Calculate left and right knee angles

left_knee_angle = self.calculate_angle(left_hip, left_knee, left_ankle)

right_knee_angle = self.calculate_angle(right_hip, right_knee, right_ankle)

avg_knee_angle = (left_knee_angle + right_knee_angle) / 2

# Squat counting logic

if avg_knee_angle < 100andnotself.in_squat:

self.in_squat = True

self.squat_count += 1

elif avg_knee_angle > 160andself.in_squat:

self.in_squat = False

# Posture evaluation

if avg_knee_angle < 90:

return"Great! Squat depth is sufficient", avg_knee_angle, (0, 255, 0)

elif avg_knee_angle < 120:

return"Good! Can squat deeper", avg_knee_angle, (0, 255, 255)

else:

return"Suggestion: Squat deeper", avg_knee_angle, (0, 165, 255)

except (IndexError, ZeroDivisionError):

pass

return"No complete human pose detected", 0, (0, 0, 255)

defdraw_keypoints(self, frame, keypoints):

"""Draw pose keypoints on the frame"""

iflen(keypoints) > 0andlen(keypoints[0]) >= 17:

# COCO pose connections

connections = [

(5, 6), (5, 7), (7, 9), (6, 8), (8, 10), # Arms

(5, 11), (6, 12), (11, 12), # Torso

(11, 13), (13, 15), (12, 14), (14, 16) # Legs

]

# Draw keypoints

for i, point inenumerate(keypoints[0]):

if point[0] > 0and point[1] > 0: # Valid keypoint

cv2.circle(frame, (int(point[0]), int(point[1])), 5, (0, 255, 0), -1)

cv2.putText(frame, str(i), (int(point[0])+5, int(point[1])-5),

cv2.FONT_HERSHEY_SIMPLEX, 0.3, (255, 255, 255), 1)

# Draw connections

for connection in connections:

pt1, pt2 = connection

if (pt1 < len(keypoints[0]) and pt2 < len(keypoints[0]) and

keypoints[0][pt1][0] > 0and keypoints[0][pt1][1] > 0and

keypoints[0][pt2][0] > 0and keypoints[0][pt2][1] > 0):

cv2.line(frame,

(int(keypoints[0][pt1][0]), int(keypoints[0][pt1][1])),

(int(keypoints[0][pt2][0]), int(keypoints[0][pt2][1])),

(255, 0, 0), 2)

defmonitor_video(self, video_path=0):

"""Monitor fitness movements in video"""

cap = cv2.VideoCapture(video_path)

print("Starting fitness monitoring... Press 'q' to quit")

whileTrue:

ret, frame = cap.read()

ifnot ret:

break

# YOLO pose estimation

results = self.model(frame, verbose=False)

for result in results:

if result.keypoints isnotNone:

keypoints = result.keypoints.xy.cpu().numpy()

# Draw keypoints and skeleton

self.draw_keypoints(frame, keypoints)

# Analyze squat posture

feedback, angle, color = self.analyze_squat_form(keypoints)

# Display information

cv2.putText(frame, f"Squat Count: {self.squat_count}",

(10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, (255, 255, 255), 2)

cv2.putText(frame, feedback,

(10, 70), cv2.FONT_HERSHEY_SIMPLEX, 0.8, color, 2)

if angle > 0:

cv2.putText(frame, f"Knee Angle: {angle:.1f}°",

(10, 110), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (255, 255, 255), 2)

cv2.imshow('Fitness Pose Monitor', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

print(f"Monitoring ended! Total squats completed: {self.squat_count}")

# Usage example

if __name__ == "__main__":

monitor = FitnessMonitor()

# Use camera for monitoring

# monitor.monitor_video(0)

# Or monitor video file

monitor.monitor_video("workout_video.mp4")使用即梦生成视频测试如下:

❓ FAQ 常见问题解答

Q1: YOLOv11支持哪些设备?

A: YOLOv11支持CPU、GPU(NVIDIA CUDA)、以及各种边缘设备。在普通笔记本电脑上也能流畅运行nano版本。

Q2: 可以检测多个人吗?

A: 当然可以!YOLOv11能同时检测图像中的多个人,每个人都会有独立的关键点标注。

Q3: 如何提高检测精度?

A: 可以使用更大的模型(如yolo11l-pose.pt),或者在特定场景数据上进行微调训练。

Q4: 支持实时摄像头检测吗?

A: 支持!只需将source参数设置为0(默认摄像头)或摄像头设备ID即可。

Q5: 模型文件有多大?

A: nano版本仅约6MB,small版本约22MB,非常适合移动端部署。

🎯 总结

从环境安装到代码运行,我们全程只用了不到10分钟,就成功体验了SOTA级别的YOLOv11姿态估计功能!🎉

关键收获:

• ✅ 掌握了YOLOv11的基本使用方法

• ✅ 学会了姿态估计的核心概念

• ✅ 获得了可直接运行的完整代码

• ✅ 了解了实际应用场景和扩展方向

这背后是Ultralytics团队对易用性的极致追求和对技术的持续深耕。YOLOv11的发布,无疑又一次降低了AI技术的使用门槛,让更多开发者和爱好者能够轻松地将强大的AI视觉能力应用到自己的创意中。

别再犹豫了,现在就动手试试吧!在评论区分享你的实验结果,让我们一起探索AI视觉的无限可能!💪

想了解更多AI工具和技术趋势?关注我,每周为你带来最新的AI资讯和实用教程!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)