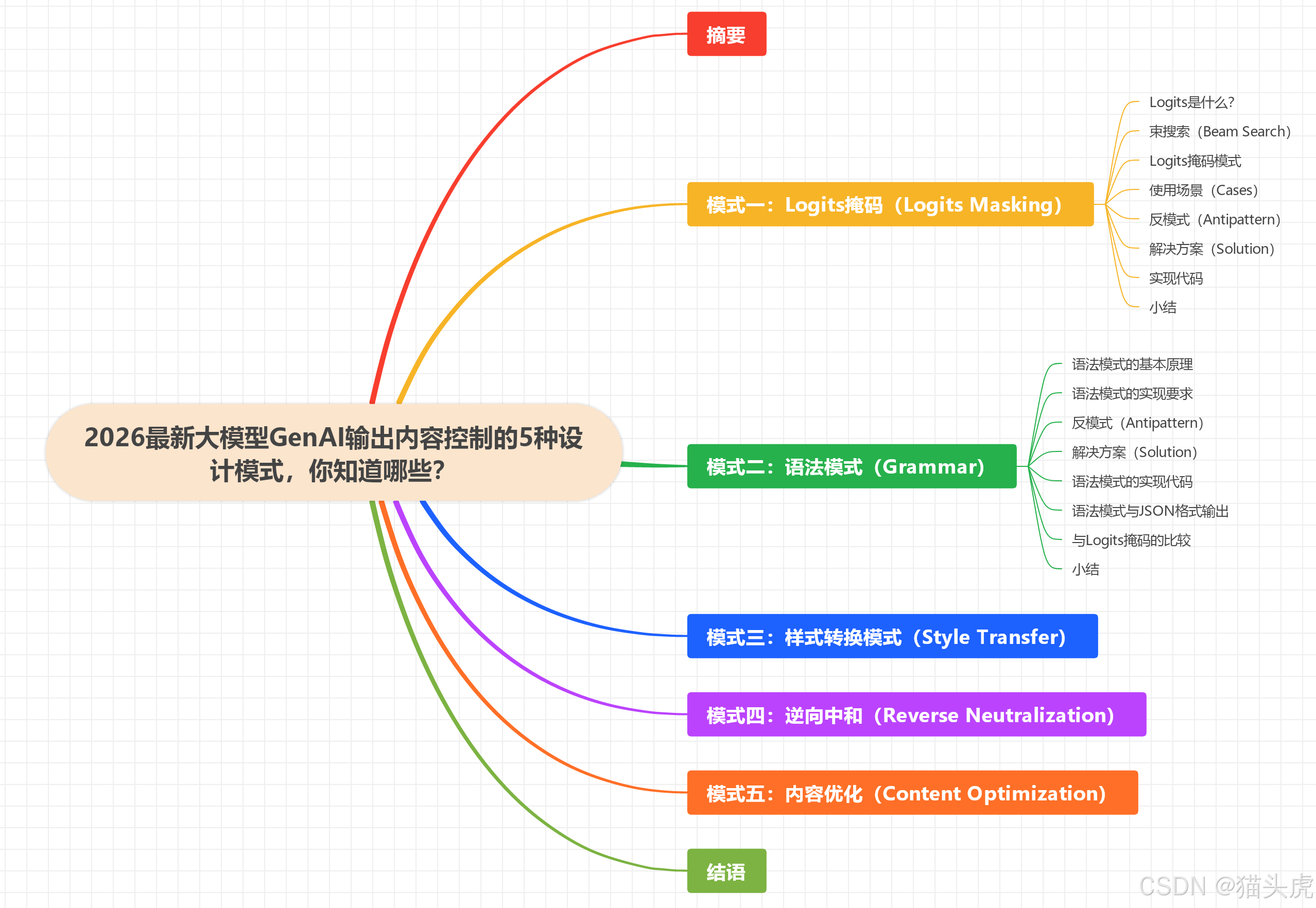

2026最新大模型GenAI输出内容控制的5种设计模式,你知道哪些?

2026年GenAI内容控制的5种设计模式:1) Logits掩码模式:通过干预token生成概率分布,确保输出符合品牌、合规等要求;2) 语法模式:基于GBNF规则约束输出格式,适用于结构化内容生成;3) 样式转换模式:调整生成内容的风格特征;4) 逆向中和模式:消除输出中的偏见或敏感内容;5) 内容优化模式:提升生成质量。这些模式通过不同技术手段实现精确控制,避免传统硬规则校验带来的效率问题,

2026最新大模型GenAI输出内容控制的5种设计模式,你知道哪些?

随着生成式人工智能(GenAI)的广泛应用,如何精确控制大规模语言模型(LLM)生成内容的样式、格式与风格,成为了开发者在应用开发过程中面临的重要挑战。为了帮助开发者应对这一挑战,业界已积累了一些通用的解决方案,其中最具代表性的便是“设计模式”。本文将系统地介绍在GenAI应用中控制模型输出内容的五种设计模式,分析各自的适用场景、优缺点,并提供典型反模式的案例,旨在为开发者提供一套系统化、结构化的内容控制方法论。

摘要

在将大规模语言模型(LLM)应用到实际开发中时,控制模型生成的内容格式、样式和风格常常是一个棘手的难题。为了解决这个问题,业界提出了几种行之有效的设计模式,旨在使开发者能够灵活地约束和定制生成内容。本文将基于如何在应用场景中高效地控制输出内容的风格,介绍五种常见的设计模式,分别是:Logits掩码模式(Logits Masking)、语法模式(Grammar)、样式转换模式(Style Transfer)、逆向中和模式(Reverse Neutralization)以及内容优化模式(Content Optimization)。通过理解和应用这些模式,开发者可以更好地优化模型的输出,确保其符合预期的需求。

文章目录

模式一:Logits掩码(Logits Masking)

在介绍Logits掩码模式之前,我们先简要了解两个关键概念:Logits是什么,以及在Logits Masking实现过程中涉及到的束搜索(Beam Search) 的概念。

Logits是什么?

LLM在生成文本时,模型并不是直接生成一个token,而是通过预测多个候选token,并为每个token分配一个分值(logits)。通过激活函数(如softmax),这些分值会被转换成概率值,所有候选token的概率加和等于1。根据这些概率,结合Sampling算法和Temperature调节,会决定哪个token作为下一个生成的结果。

束搜索(Beam Search)

束搜索用于在生成过程中实现确定性优先(每次输出概率最高的token)与随机创新(引入Temperature进行小范围随机选择)的平衡。在束搜索机制下,LLM在生成过程中维护多个候选分支(通过设置束宽beam_width来控制),每个分支都会生成多个候选token。然后,系统会通过修剪算法,保留概率加和最高的beam_width个分支,继续生成下一个token,直到句子完成(例如遇到终止符 <EOS>)。

Logits掩码模式

Logits掩码模式通过在束搜索过程中增加额外的约束和限制,对每一步的token选择进行干预,从而控制生成内容符合预期。

使用场景(Cases)

以下是一些可能适用Logits掩码模式的实际场景:

- 品牌一致性:在描述某商品时,需要使用该商品特有的品牌词汇,例如“运动”和“舒适”,避免使用其他品牌的特性词汇。

- 准确性:例如在生成账单时,账单编码和金额应只在特定位置输出,避免在正文中重复。

- 合规性:引用公司案例时,避免同时提及竞争对手的案例,以避免商业敏感问题。

- 风格指南:确保输出符合指定的语法、标点、格式或术语要求。

反模式(Antipattern)

Logits掩码模式的反面通常是“硬规则校验”,即每次生成的内容都要经过一系列规则检查,如果不符合要求则强制重新生成,直到满足规则。这种方式会导致不必要的重复调用,增加成本和响应时间,影响用户体验。

Logits Masking模式的反例描述

解决方案(Solution)

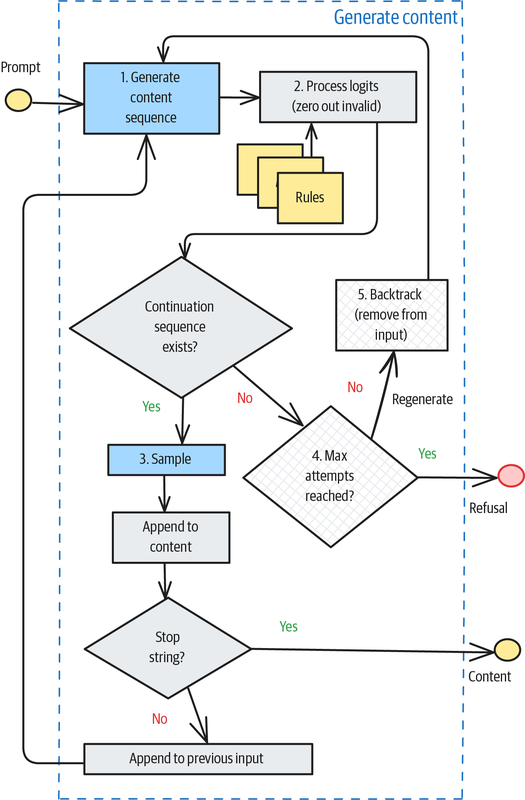

Logits掩码模式的工作流程如下:

- 规则设定:用户根据输出内容的要求定义规则,例如特定关键字的屏蔽等。

- 候选过滤:在每个生成步骤中,获取可能的后续token集合。对不符合规则的候选token,将其logits值置为0,从概率分布中排除。

- 生成推进:只要仍有至少一个符合规则的合法token,生成过程就可以继续推进。

- 回退机制:如果没有符合规则的候选token,且当前路径被标记为死胡同(dead end),则需要回退并尝试其他选择。

- 最大重试次数:若达到最大重试次数,仍无法生成符合要求的内容,则返回拒绝响应,告知“无法生成符合要求的内容”。

相关流程图如下:

Logits Masking流程图

实现代码

from transformers import pipeline

MODEL_ID = "/Users/mario/.cache/modelscope/hub/models/LLM-Research/Phi-3-mini-4k-instruct"

pipe = pipeline(

task="text-generation",

model=MODEL_ID,

kwargs={

"return_full_text": False,

},

model_kwargs={}

)

results = pipe(input_message,

max_new_tokens=512,

do_sample=True,

temperature=0.8,

num_beams=10, # 束宽为10

use_cache=True,

logits_processor=[<Your_Customized_Processor extends LogitsProcessor>]) # 设置自定义Processor实例

小结

Logits掩码模式通过对每个token生成的概率分布进行干预,可以有效地控制模型输出内容符合特定要求,避免不符合预期的结果。在实际应用中,设计模式的选择和实现方式依赖于具体的需求和场景。

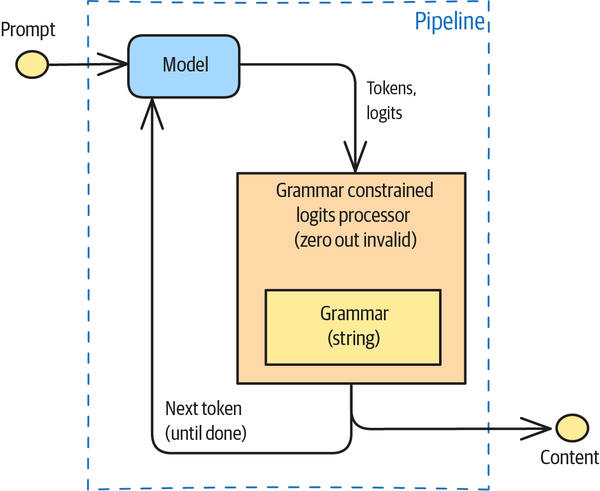

模式二:语法模式(Grammar)

语法模式(Grammar)基于语法的字符输出限制,可以看作是Logits掩码的一种特殊变体。它可以类比为内置了一套正则表达式(实际使用的是GBNF,Grammar-Based Normal Form,基于语法的范式),通过调整Logits的权重来控制模型生成内容的格式和样式。

语法模式的基本原理

在生成内容时,语法模式通过定义一套语言规则,约束模型生成的内容结构。这些规则允许开发者控制输出的格式和样式。比如,可以定义特定格式的日期时间输出、数学表达式等。

例如,下面是一个控制时间格式输出的语法规则:

grammar_str = """

timestamp_literal ::= { t 'yyyy-mm-dd hh:mi:ss' } | 'date_literal time_literal'

date_literal ::= { d'yyyy-mm-dd'} | mm-dd-yyyy | mm/dd/yyyy | mm-dd-yy | mm/dd/yy | yyyy-mm-dd | yyyy/mm/dd | dd-mon-yyyy | dd/mon/yyyy | dd-mon-yy | dd/mon/yy

time_literal ::= { t 'hh:mi:ss'} | hh:mi:ss[:mls]

"""

这段语法规则规定了时间的输出格式,支持多种日期和时间格式。模型会遵循这些规则生成符合要求的输出。

语法模式的实现要求

实现语法模式需要模型推理引擎支持GBNF解析器。由于此类解析器的集成要求,不是所有的LLM都支持这一功能。闭源的模型通常不支持这一功能,而开源模型在这方面的支持会更好。如果是私有部署的模型,开发者也可以在推理框架中集成GBNF解析器。

反模式(Antipattern)

目前,很多做法是在prompt中明确写出所需的输出格式,例如要求输出JSON格式或SQL语句。虽然一些大规模的语言模型能够较好地遵循这些指令,但对于较小的模型,输出格式的遵循性较差。此外,无论是闭源的头部大模型,还是自部署的小模型,在格式输出上的确定性都有一定的概率。

例如,LangGraph(2025年6月)采用的做法是通过额外的模型调用来调整返回格式,这种方法会引入额外的调用损耗,因此不太推荐。

解决方案(Solution)

语法模式的处理流程与Logits掩码模式类似,但原理上有所不同。语法模式通过引入语法规则来控制生成内容的结构,而Logits掩码则侧重于对生成过程中的候选token进行过滤。语法模式的工作流程如下所示:

- 定义语法规则:首先,使用GBNF语法定义输出内容的结构和格式。

- 模型推理:在生成过程中,模型会根据这些语法规则推理,确保输出符合要求的结构。

- Logits调整:在每个生成步骤,模型输出的logits(候选token分数)将依据语法规则进行调整,确保符合语法的内容被选出。

语法模式的实现代码

以下是一个简单的示例,展示了如何使用语法模式控制数学问题解答的输出格式:

from transformers import pipeline

from transformers_cfg.grammar_utils import IncrementalGrammarConstraint

from transformers_cfg.generation.logits_process import GrammarConstrainedLogitsProcessor

MODEL_ID = "/path/to/your/model"

pipe = pipeline(

task="text-generation",

model=MODEL_ID,

kwargs={"return_full_text": False},

model_kwargs={}

)

def get_expression_that_solves(math_problem: str) -> str:

system_prompt = """

You are a math instructor. I will ask you a math question.

Respond with the mathematical expression that can be used to solve the problem.

"""

# 定义语法规则

grammar_str = """

root ::= (expr "=" ws term "\n")+

expr ::= term ([-+*/] term)*

term ::= ident | num | "(" ws expr ")" ws

ident ::= [a-z] [a-z0-9_]* ws

num ::= [0-9]+ ws

ws ::= [ \t\n]*

"""

# 加载语法约束

grammar = IncrementalGrammarConstraint(grammar_str, "root", pipe.tokenizer)

grammar_processor = GrammarConstrainedLogitsProcessor(grammar)

input_message = [

{"role": "system", "content": system_prompt},

{"role": "user", "content": math_problem}

]

# 生成结果

results = pipe(input_message,

max_new_tokens=256,

do_sample=False,

logits_processor=[grammar_processor])

return results[0]['generated_text'][-1]['content'].strip()

在这个例子中,语法规则约束了生成的数学表达式必须符合特定格式。例如,标识符(ident)必须是小写字母开头,数字(num)后可以跟任意空格或制表符,表达式必须遵循一定的算术结构。

语法模式与JSON格式输出

语法模式不仅可以用于控制数学表达式的格式,还可以控制输出的整体结构。例如,要求生成符合特定JSON格式的内容,许多现有的模型API已经封装了这一功能,允许用户通过参数指定输出类型。

例如,使用OpenAI API进行JSON格式输出的例子如下:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("OPENAI_API_KEY"),

base_url="https://idealab.alibaba-inc.com/api/openai/v1",

)

system_prompt = """

You will be given a short paragraph about a book.

Extract the author, title, and publication year of the book.

Return the result as JSON with the keys author, title, and year.

If any piece of information is not found, fill the spot with NULL.

"""

completion = client.chat.completions.create(

model="DeepSeek-R1-671B",

messages=[

{'role': 'system', 'content': system_prompt},

{'role': 'user', 'content': 'Love in the Time of Cholera'}

],

response_format={"type": "json_object"},

)

print(completion.choices[0].message.content)

这种方式提供了一种灵活的控制生成输出结构的途径,同时简化了生成过程中的格式控制。

与Logits掩码的比较

语法模式与Logits掩码在多个维度上存在差异:

- 适用场景:语法模式适合用于控制输出格式和结构,而Logits掩码更适用于逻辑性约束。

- 调试和灵活性:BNF语法较难调试且不易发现错误,且调试过程较为复杂。相比之下,Logits掩码通过规则引擎进行管理,更加灵活。

- 规则引擎:语法规则可以通过规则引擎动态管理和调整,适应更多场景。

- 外部API调用:语法模式支持外部API调用,扩展性更强,能够处理更复杂的应用场景。

尽管两者都是通过对生成过程的中间结果进行干预来优化输出内容,但语法模式与Logits掩码各有其适用的场景和优缺点。语法模式能够严格控制输出格式,但其调试和实现上会更加复杂。

小结

语法模式通过引入GBNF语法规则来控制模型生成内容的格式,适用于需要严格控制输出结构的应用场景。尽管其实现相对复杂,但提供了更高的灵活性和精度。相比之下,Logits掩码适用于更加动态和灵活的规则约束,能够处理更广泛的场景。

模式三:样式转换模式(Style Transfer)

在介绍了Logits掩码和语法模式之后,我们发现这两种模式的共同前提是必须能够明确地定义规则,以便程序化地干预输出内容。但在实际应用中,很多场景并没有这样明确的规则,那么该如何处理呢?这时,样式转换模式(Style Transfer) 就是一个有效的选择。

何时使用样式转换模式?

如果您的场景符合以下三种情况之一,那么样式转换模式可能是一个不错的选择:

-

内容已经准备好,但输出需要满足额外的偏好、格式或风格要求:即内容本身已经合适,只需要在语调、风格或格式上做些微调。

-

要求细节较多,难以定义出具体的规则:某些风格要求较为复杂,无法通过程序化规则或数据格式约束来实现。

-

无法提供具体的判定规则,但可以给出一些范本或例子:这种场景适合通过示例进行学习和转换,而不依赖于硬性规则。

解决方案:Few-shot与Fine-Tuning

样式转换模式的实现主要依赖于两种方法:Few-shot和Fine-Tuning。

Few-shot(少量示例)

通过Few-shot学习,模型从提供的少量示例中学习特定输出风格的特征,如格式、语调和表达方式等。该方法非常常见,尤其在实际应用中,能够快速地根据少量示例调整输出风格。

Fine-Tuning(微调)

微调方式则是通过收集足够的样本数据,基于这些数据对模型进行训练,从而改变模型的权重参数,最终生成符合要求风格的输出。与Few-shot不同,Fine-Tuning是在整个模型训练的基础上进行深度调整,能够在更高层次上优化输出风格。

Fine-Tuning的优势

与Few-shot方法相比,微调模型具有以下优势:

-

更高的定制化效果:微调能够让模型充分学习和掌握风格细节。例如,在需要标准术语和口语风格的情况下,Fine-Tuning能帮助模型掌握术语映射和表达风格,这种需求很难通过Few-shot实现。

-

提升推理速度:相较于Few-shot,微调后的模型可以在推理过程中直接输出所需风格,不需要额外计算推理过程中的上下文,通常推理速度较快。

然而,微调模型也有其缺点:需要大量的训练数据和较长的训练时间,同时也涉及到较高的成本,尤其在部署阶段。

考虑事项(Considerations)

无论是通过Few-shot方式,还是通过Fine-Tuning方式,都可以增强模型对于结果输出样式的约束力。相比于Logits掩码和语法模式,样式转换模式在输出的确定性上可能稍显不足。然而,使用Few-shot方式可以最小化成本,并在许多实际场景中达到较好的效果。

选择Few-shot与Fine-Tuning的标准

在选择Few-shot和Fine-Tuning时,需要考虑以下几点:

-

Bigger models lead to better results:模型参数越大,在相同示例下,模型表现越好。若效果不理想,可以通过补充更多的示例进行调优。

-

Limits of the Context:示例数量越多,能够让模型更好地学习样式转换,但上下文长度会增加,从而影响模型的推理效率。为了解决这个问题,可以对用户的问题进行分类,召回与查询相关的示例,以保持适当的上下文长度。

-

推理速度(Inference Speed):使用Few-shot方式时,会增加上下文长度,导致推理响应速度变慢。若对响应时间敏感,可以考虑减少示例数量或使用较小的模型进行推理,或者通过Fine-Tuning减少对上下文的依赖。

Few-shot与Fine-Tuning的具体选择

-

Few-shot适合快速实现模型样式转换,尤其是在示例数量较少、成本要求较低的情况下。这种方式适用于对模型样式的快速微调,能在不增加大量计算成本的情况下实现风格调整。

-

Fine-Tuning适合需要高定制化、高精度要求的场景,尤其是当需要对模型的多个层次进行调整时。微调可以使模型更好地掌握复杂的风格需求,且能够在更大范围内提升模型的性能和推理速度。

小结

样式转换模式为那些无法通过明确规则进行约束的应用场景提供了有效的解决方案。通过Few-shot或Fine-Tuning,开发者可以在不需要明确规则的情况下调整模型输出风格。对于简单的场景,Few-shot方式成本低、速度快;而对于复杂的需求,Fine-Tuning提供了更高的定制化能力和更精确的控制。根据具体需求,选择合适的方式来实现目标输出风格,将大大提升开发效率和模型表现。

模式四:逆向中和(Reverse Neutralization)

与样式转换模式类似,逆向中和(Reverse Neutralization) 是将原始回答转换成特定类型和风格的最终输出。实现过程通常是先用一个通用的生成式AI(GenAI)模型生成中性的中间态结果,然后再使用一个经过微调的特定模型,将这个中间结果转化为所需的特定风格或类型的输出。

逆向中和与样式转换的区别

不同于样式转换,逆向中和模式下,模型仅需要给出目标输出的样例,通过这些样例进行微调,模型便能更好地生成符合目标风格的内容。样式转换通过提供输入-输出的样例对,使模型根据这些对进行转换,而逆向中和模式则主要关注目标输出的风格,训练过程相对简单,只需提供目标风格的输出样本。

适用场景

逆向中和模式非常适用于以下几种情况:

-

个性化风格生成:例如,如果你希望模型能根据你个人的风格生成文章或电子邮件,可以使用逆向中和模式。通过历史邮件样本进行微调,使模型能够模仿你的写作风格。

-

风格统一的内容创作:在需要统一风格的内容创作场景中,逆向中和可以有效地将中性或普通风格的内容转换为目标风格(例如,生成正式、商务化、或更友好的表达方式)。

挑战:

使用样式转换时,可能面临以下问题:

- 历史内容不足:如果没有足够的个人风格内容,或者风格内容无法与普通风格内容匹配,那么就难以通过样式转换模式获取有用的样本对。

- 有限的场景覆盖:即便有个人风格内容样本,这些样本也可能只涵盖特定主题,难以应用于更多场景。

解决方案:逆向中和

逆向中和模式的核心是微调训练一个模型,使其能够生成目标风格的输出。其训练过程包括以下几个步骤:

-

收集历史内容:收集你过往的邮件或文章等内容,让一个通用LLM(例如GPT)根据这些历史内容生成中性的版本(如商务邮件风格)。

-

生成中性结果:通过普通的GenAI模型生成中性结果,比如生成一封商务邮件样式的中性邮件。

-

样本数据创建:将中性生成的邮件与原始邮件一一对应,但交换输入和输出的角色。也就是说,把生成的中性邮件作为输入,把你个人的邮件作为输出,构建一个训练样本集。

示例:

Neutralize the tone and style from the following email to make it professional and suitable for communication between executives who may not know each other very well. -

微调训练:使用创建的训练数据,选择一个开源模型进行微调,使其能够生成符合目标风格的输出。

推理过程

在推理时,逆向中和模式通常分为两个步骤:

- 生成中性结果:首先,使用通用的生成式AI模型生成中性版本的输出。

- 风格转化:接着,将生成的中性结果输入到微调后的模型中,生成符合目标风格的最终输出。

下面是逆向中和模式推理的简化流程图:

逆向中和模式推理流程

考虑事项

在使用逆向中和时,最关键的因素是确保中性结果的生成质量。必须保证转换后,风格发生变化的部分不影响核心内容的准确性。否则,风格转换可能导致信息丢失或表达不清。

以下是一些改进和优化建议:

-

选择合适的中性风格:在生成中性版本时,可以通过调整风格的具体要求来影响输出。例如,生成的邮件风格可以根据不同的要求调整(如初中一年级水平、英国商务标准等)。测试不同风格的差异性,选择表达内容完整性最好的中性风格。

-

微调数据的选择:微调数据应涵盖丰富的主题,以确保可以应对更多的实际应用场景。此外,在生成训练数据时,需要通过人工筛选和判断,以确保数据的质量和风格的多样性。

-

保持核心内容的准确性:风格转换应该仅仅在外部表现形式上做变化,核心内容和逻辑应保持完整。确保内容不因风格转化而丢失关键信息或表达不清。

小结

逆向中和模式通过先生成中性版本,再进行微调,将中性内容转化为目标风格。与样式转换不同,逆向中和依赖于目标风格输出的样本对,而不依赖于输入-输出的样例对。在实际应用中,逆向中和可以在个性化内容生成和风格一致性要求较高的场景中发挥重要作用。

该方法虽然能够产生高质量的风格化输出,但需要特别关注生成的中性版本的质量,并确保在风格转换的同时,核心内容不发生扭曲或丢失。通过优化中性风格的选择和训练数据的筛选,可以进一步提升逆向中和模式的效果。

模式五:内容优化(Content Optimization)

内容优化(Content Optimization)是一种利用偏好调优来生成表现最优内容的模式。该模式通过持续对多个输出进行评估,标识哪些输出更优,从而增强模型在生成高质量内容上的能力。简言之,内容优化依赖于反馈机制,通过选择最受欢迎的内容,不断优化模型输出的质量。

适用场景(Cases)

传统的内容优化方式常通过A/B测试来实现,其中A/B测试的前提是明确划定A和B内容的差异因子。然而,如果无法明确定义A和B之间的差异,这种测试就会面临一定的挑战。在此背景下,内容优化提供了一种不需要明确差异因子的解决方案。

例如,在许多场景中,可能无法清楚界定生成的内容A和内容B之间的差异,但我们依然可以评估哪一个内容更好。在这种情况下,内容优化可以更有效地应用。

解决方案(Solution)

内容优化模式的核心思想是:不需要明确定义A、B之间的差异因子,只需要让用户选择更喜欢哪个内容,而不需要进一步解释为什么。然后,将“更喜欢的内容”和“不太喜欢的内容”作为数据对进行配对,并通过这些配对数据对模型进行微调,最终生成更符合用户偏好的内容。

简而言之,用户仅需要做出“更喜欢哪个”的选择,至于为什么更喜欢的理由则通过模型的数据学习来自动获取。

解决方案的整体流程:

-

生成两个候选内容:首先,根据同一Prompt生成两个不同的内容。这两个内容在保持原始意图的前提下,可以进行适当的修改或增加解释、例子等,确保它们有一定的差异性。

-

评估内容优劣:在第二步中,可以使用一个强大的语言模型(LLM)来评估两个结果的优劣,或者由专家进行人工标注。也可以通过用户反馈进行评估。这一评估的目标是标明哪个内容更优。

-

数据配对:将评估结果中的“更优内容”和“不太优内容”作为一对数据集,用于后续的训练。

-

微调模型:通过收集到的“更优”与“较差”配对数据,对模型进行微调,使模型在生成内容时更倾向于输出用户偏好的内容。

以下是内容优化流程的图示:

内容优化模式的解决方案流程图

流程关键点说明:

-

Prompt改写(Step 1):生成的内容需要在保持原意的前提下进行调整,例如通过对原始Prompt的替换、进一步的说明或提供例子等方式,确保生成的内容具有一定的差异性,以便进行对比。

-

评估优劣(Step 2):在这一环节,通常会使用LLM(如GPT等大规模预训练模型)来评估内容的优劣。理想情况下,这个模型应具有较强的推理和评估能力,能够识别哪一个内容符合用户的偏好。除此之外,也可以由专家进行标注,尤其是在特定领域中。

-

微调模型(Step 4):将根据反馈生成的标注数据(即更喜欢的和不太喜欢的内容)用来微调模型。最常见的技术之一是DPO(Direct Preference Optimization),通过调整模型偏向性,提升生成内容的质量。

考虑事项(Considerations)

在内容优化模式中,如何评估哪个输出更好是一个关键问题。以下是几种常见的评估方法:

-

使用权威的语言模型作为判定:

- 优点:权威的语言模型(如GPT等)在评估和处理大量数据时,能够较好地捕捉内容优劣。这种方法的优势是能够迅速处理大量数据并作出评估。

- 缺点:模型对于什么是“更好”的标准存在一定的黑箱性,不一定能够完全契合具体应用场景的需求。

-

专家标注:

- 优点:在处理少量数据时,专家评审能够提供准确和专业的判定,尤其是在某些高难度和主观性强的领域中。

- 缺点:专家标注的成本较高,且对于较大规模的数据,难以做到高效处理。

-

基于反馈的判定:

- 优点:通过用户的实际反馈(例如,用户点击率、互动率等指标)来判断内容的好坏,可以更贴近实际使用场景。基于反馈的判定也能够随时调整,随着更多数据的回收,评估标准可以不断完善。

- 缺点:此方法需要完整的反馈链路,并且要确保数据的回收与指标的准确性,且对用户行为的理解和分析要求较高。

小结

内容优化模式通过收集用户的偏好反馈,将更喜欢的内容与不太喜欢的内容配对,并通过这些数据进行模型微调,使得生成的内容更符合用户的需求。与传统的A/B测试不同,内容优化不需要明确划分差异因子,而是通过用户的偏好选择来不断优化模型输出。

在实际应用中,通过使用强大的语言模型或专家反馈来评估内容的优劣,以及使用基于反馈的数据来优化模型,是内容优化模式的关键。尽管这一模式需要一定的数据支持,但它能有效提高模型生成内容的质量和用户满意度,尤其在需要不断改进内容表现的场景中非常有用。

结语

为了更直观地呈现上文中讨论的几个设计模式的要点,以下是一个表格化的总结,涵盖了各个模式的问题、解决方案和适用场景。通过这个表格,读者可以快速理解每个模式的核心思想以及它们适用的实际场景,并能更好地根据自身需求选择合适的设计模式。

| 模式(Pattern) | 问题(Problems) | 解决方案(Solutions) | 使用场景(Usage Scenarios) |

|---|---|---|---|

| Logits掩码模式(Logits Masking) | 需要针对输出的内容做一些准确性、合规、风格等的规则约束 | 在模型的Sampling阶段,使用Logits掩码机制提前干预,排除不符合规则的Token生成 | 明确的屏蔽词规则、风格一致性要求、避免重复陈述内容、避免违反合规的内容 |

| 语法模式(Grammar) | 输出内容需要符合特定的格式要求或数据结构 | 使用类似BNF(基于语法的范式)的语法规则约束token生成,确保生成结果符合预期格式 | 生成SQL语句、生成标准化JSON格式、生成具有特定数据结构的返回值(如API响应) |

| 样式转换模式(Style Transfer) | 希望输出内容遵循某种特定风格或个性化要求,但难以定义精确的规则 | 使用Few-shot或Fine-Tuning方法,通过示例(Input-Output对)让模型学习目标风格 | 专业领域文本创作、面向特定受众的内容生成(如科普文章、技术文章、品牌风格内容等) |

| 逆向中和模式(Reverse Neutralization) | 无法抽象出明确的规则,无法提供Input-Output样例,只能提供目标风格的输出样例 | 首先生成中性风格内容,然后通过目标风格的样例进行微调,生成符合特定风格的输出 | 个人人设风格的邮件/文档编写(如个人化邮件、博客或正式文档的风格调整) |

| 内容优化模式(Content Optimization) | 输出内容无法明确区分A/B实验的差异因子,且无法定义明显的优化元素 | 生成多个版本的输出,并基于用户偏好(如“喜欢”或“不喜欢”)对结果进行评估,进而强化模型生成更优内容 | 无法明确拆解影响因素的场景,如优化营销文案、创作更吸引人的广告、改善教材内容等 |

进一步说明:

-

Logits掩码模式:适用于需要对生成内容进行约束,尤其是需要排除某些不符合规范的内容时。可以有效避免生成不符合品牌或合规要求的内容,保证内容的准确性与一致性。

-

语法模式:适用于需要严格控制输出格式的场景,如生成API响应、SQL查询等结构化内容。使用语法规则来规范生成的内容,是保证输出结构正确性的有效手段。

-

样式转换模式:特别适用于内容风格化的需求,尤其是在风格不易通过规则定义的情况下,利用Few-shot或Fine-Tuning帮助模型学习所需风格。它可以应用于各种内容创作,尤其是当内容需要与特定受众产生共鸣时。

-

逆向中和模式:适合个性化内容生成,当你希望模型根据特定的风格生成内容时,可以先生成中性内容,再通过风格样例对模型进行微调。尤其适合个性化的邮件和文档编写。

-

内容优化模式:适用于那些不能明确定义A/B测试差异因子的场景,特别是在内容效果较难量化的情况下。通过让模型基于用户偏好做出选择,从而不断优化输出内容。这种方式非常适用于需要持续改进和优化内容的创作场景。

总结

以上五种设计模式各有特点,适用于不同的场景和需求。在实际应用中,开发者可以根据具体问题的特点选择最合适的设计模式进行实现,从而有效控制生成内容的质量、风格和结构。理解每个模式的核心思想,结合自身的实际情况,能够帮助开发者更高效地实现目标,提高生成内容的准确性和符合度。

生成式人工智能(GenAI)相关的设计模式是一个较为新兴的话题,与Java等编程语言中的设计模式相比,尚未完全成熟,也没有统一的共识。本文列举的几种设计模式,主要围绕如何控制模型输出内容进行讨论,笔者认为这些模式能够涵盖大部分实际场景。开发者可以根据自己的具体需求,参考这些模式的思路,结合现有的做法,选择合适的实现方案。同时,在应用这些模式时,要结合自身的上下文进行权衡,考虑不同方法的优缺点,做出最适合的决策。

参考资料

1.https://learning.oreilly.com/library/view/generative-ai-design/9798341622654/

2.https://mp.weixin.qq.com/s/Sy3vBB5AMdjLJ5u7YZ9Eag

更多推荐

已为社区贡献210条内容

已为社区贡献210条内容

所有评论(0)