AI智能体(Agent)大模型入门【4】--下载训练好的大模型部署到本地上

这一篇章是教学如何在电脑部署好别人训练好的大模型,也就是gpt,qwen这些模型。别人训练好的模型,在本地直接使用,不需要使用api-key直接使用的大语言模型。注:这是在你不想花费费用,或者说已经没有费用去进行调用模型的时候选用的备选方案,因为在本地调用直接使用的模型是已经训练好的,无法获取最新数据或者联网搜索什么的,是基于训练数据来进行回答,且不同版本的模型回答和训练数据不一样,具体得看电脑来

目录

前言

这一篇章是教学如何在电脑部署好别人训练好的大模型,也就是gpt,qwen这些模型。别人训练好的模型,在本地直接使用,不需要使用api-key直接使用的大语言模型。

注:这是在你不想花费费用,或者说已经没有费用去进行调用模型的时候选用的备选方案,因为在本地调用直接使用的模型是已经训练好的,无法获取最新数据或者联网搜索什么的,是基于训练数据来进行回答,且不同版本的模型回答和训练数据不一样,具体得看电脑来进行下载安装。

下载ollama客户端

官网首页:

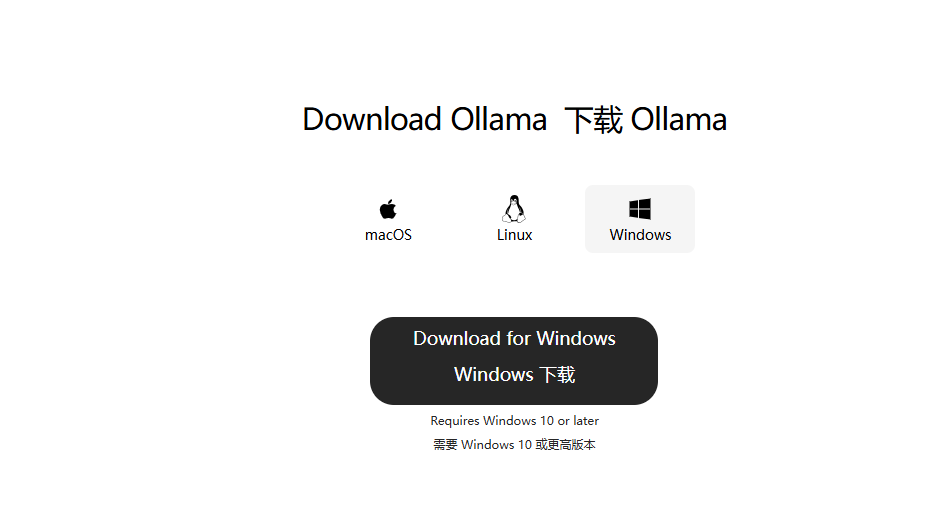

点击

然后再根据自己的需求进行下载安装。

这里会有出现个问题,很多朋友看到他会无法选择盘符直接安装到c盘,请不要慌张,这是正常的。记得自己的c盘要有足够的空间来容纳ollama客户端(约1.2G)

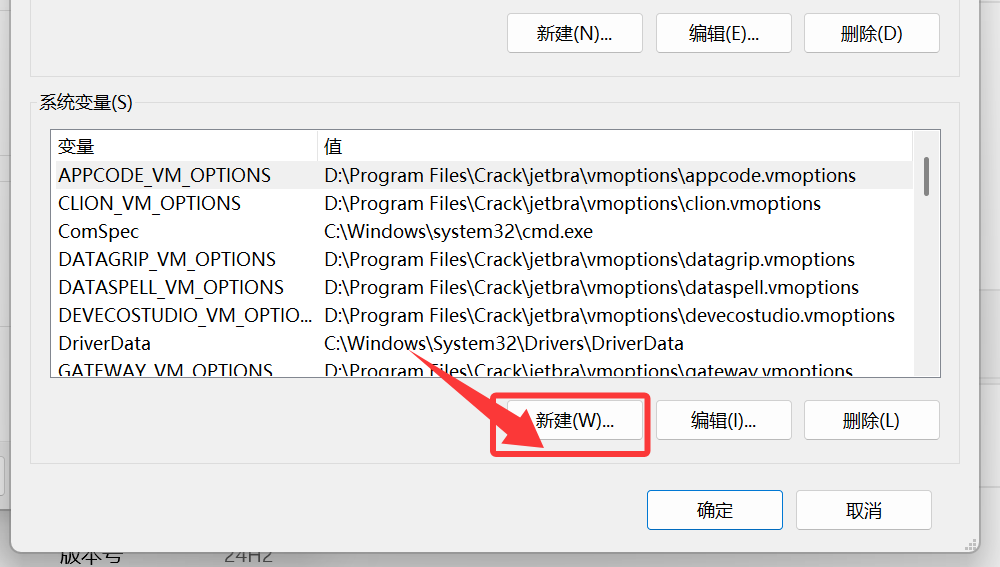

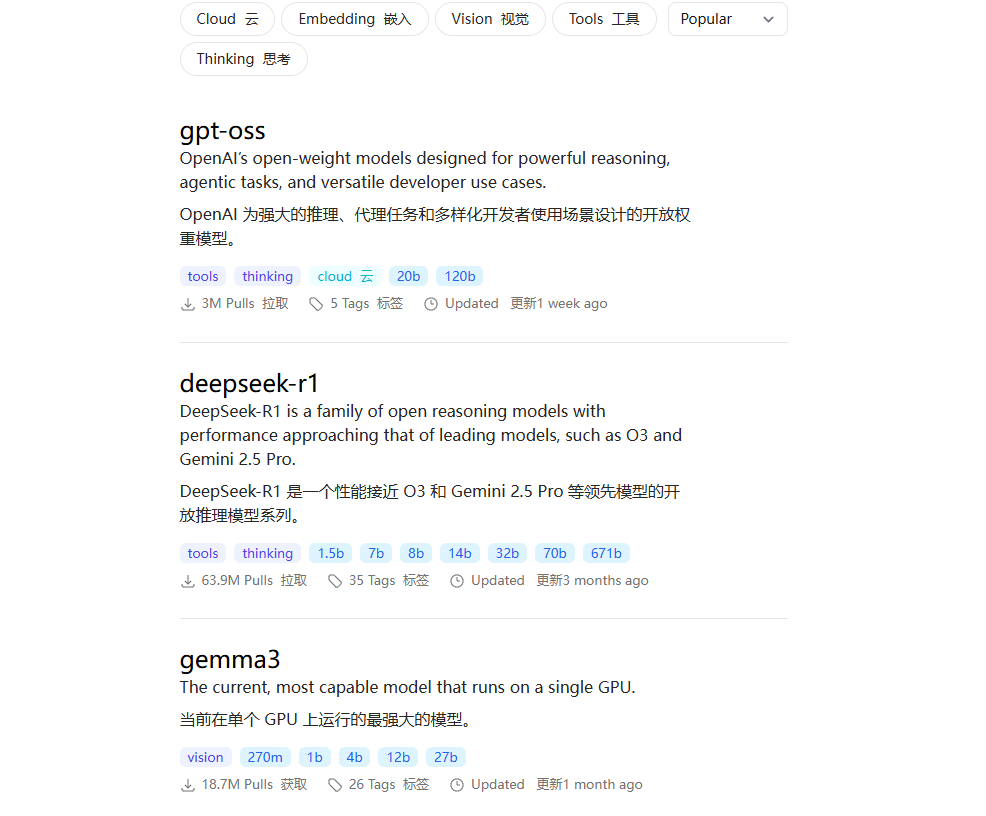

修改镜像文件存储位置

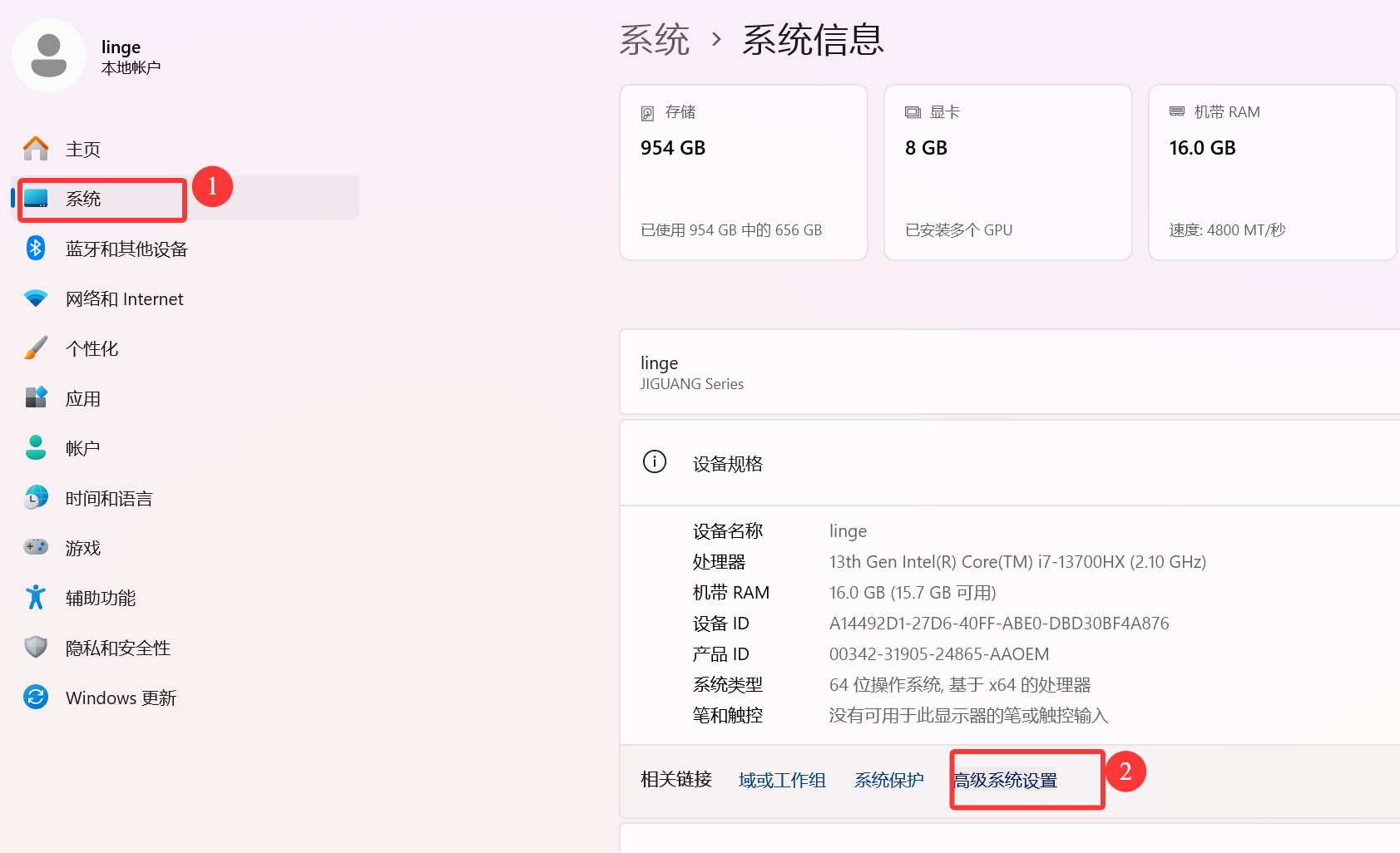

这一步是非常重要的,如果不需改,他会默认存储到c盘,到时候大语言模型是会直接下载到c盘的,若c盘不足以下载的存储的话,则会导致失败,所以这一步至关重要。

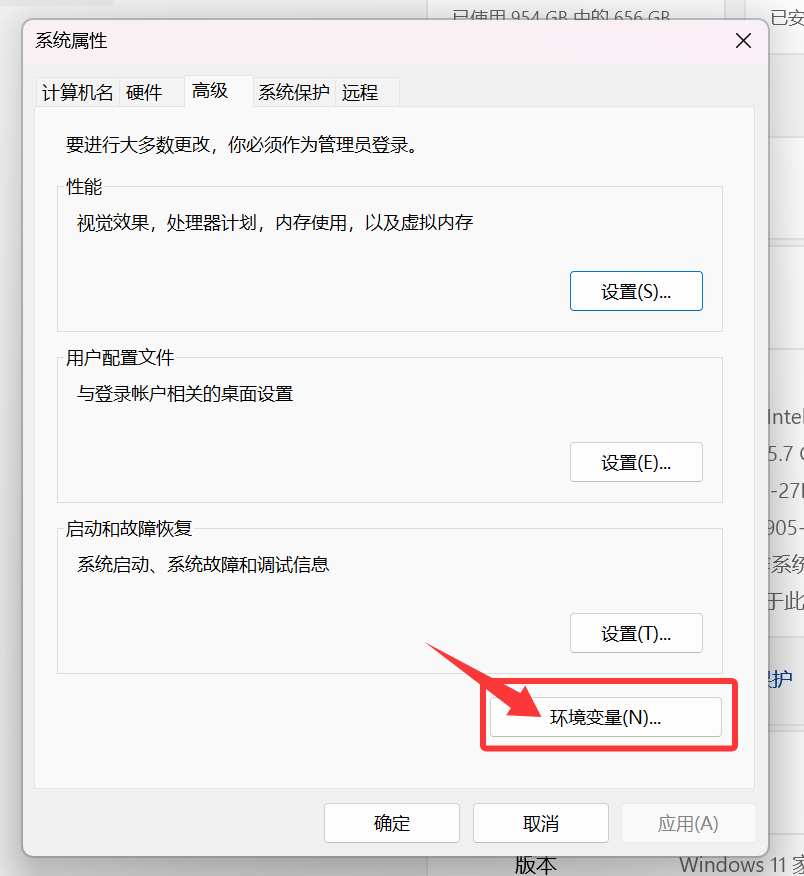

接下来跟着我修改就ok了

第一步修改ollama客户端的文件存储修改

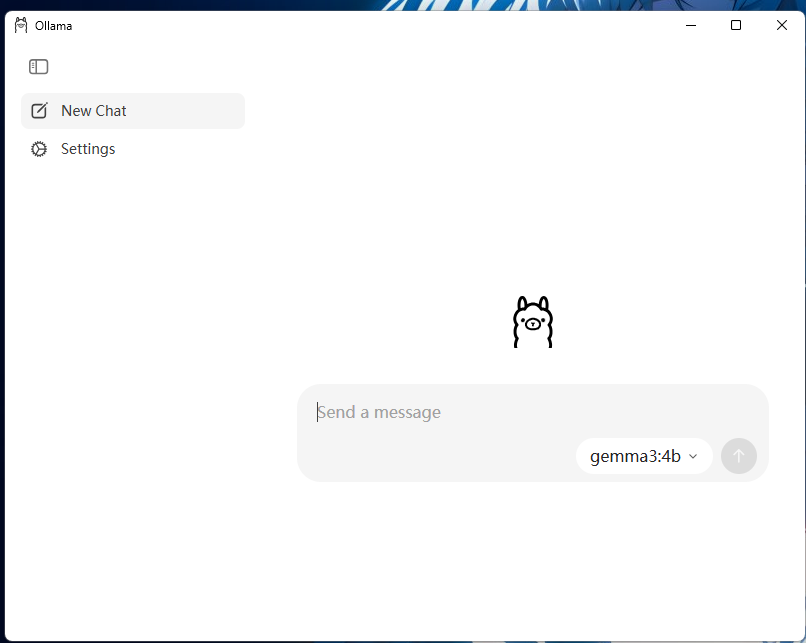

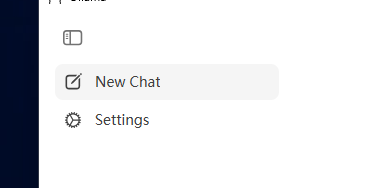

打开ollama客户端

点击settings

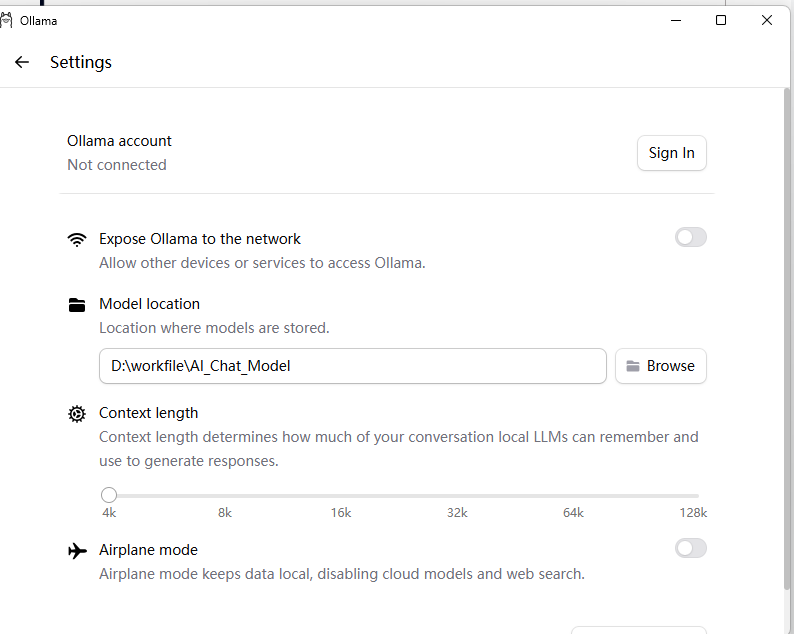

然后点击browse来进行文件存储地方的下载

记得最后一步需要点击浏览目录来进行镜像文件的地方修改,记住要选择和你的ollama存储地址是一样的文件夹,并且可以新建一个子目录来进行选择、

OK这时候环境变量就修改完了、

你就不用担心文件下载,模型下载存储到c盘里面去了。

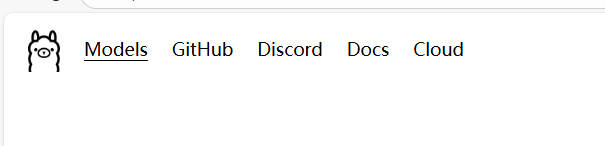

挑选相关的模型来进行下载

回到ollama页面,点击Models

这里面有很多模型来提供下载,个人觉得下载deepseek和qwen3其中一个就ok了

所以为了演示,我们这里挑选qwen3来进行下载

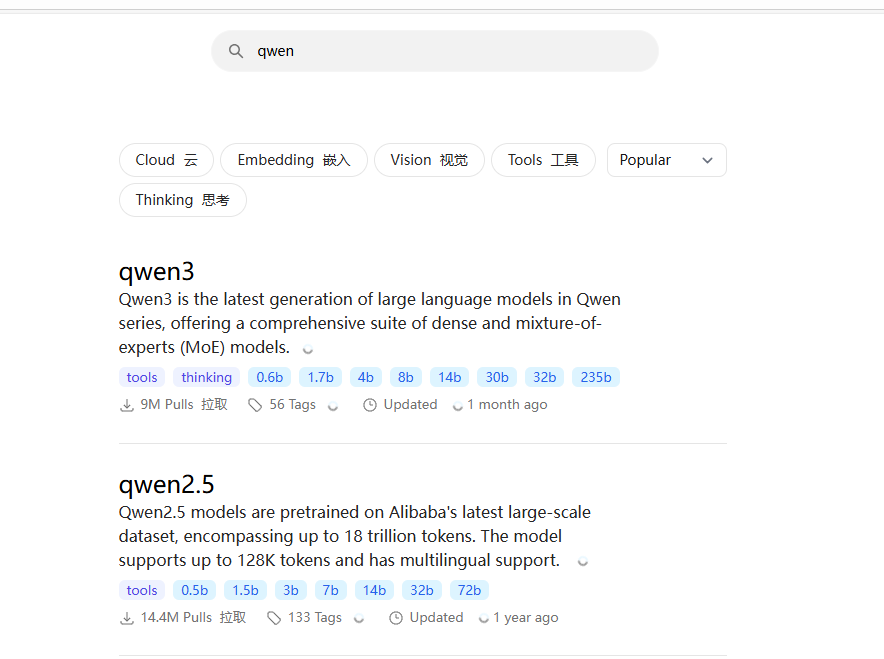

在上方搜索栏输入qwen,然后选择qwen3,点击

然后进入到这个界面

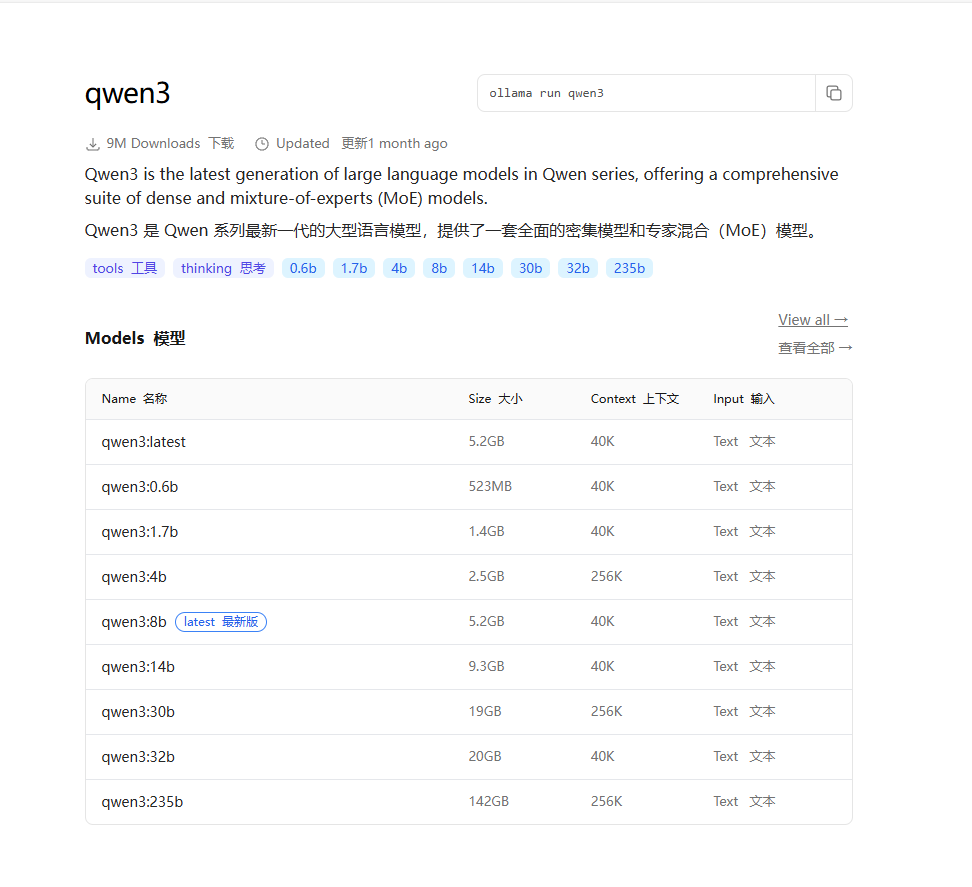

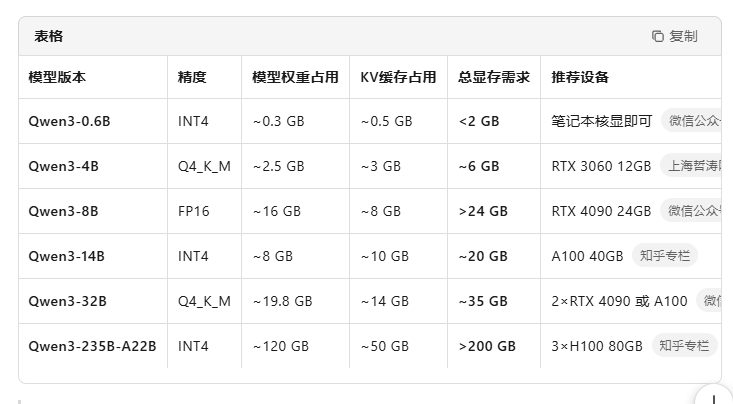

不同的大小的模型版本性能肯定是不一样的,当然,同时的所需的电脑配置需求也就越高。

这里贴一个参考,对于个人计算机来说醉倒到8b就ok了,其实大部分我还是推荐在4b及4b以下去,因为这个不仅吃cpu的性能还吃运行内存的相关性能,只是单纯一个达到的话是不足以完整的跑通的,所以还是要依据自己的电脑性能来。

为了照顾大家,我们选择1.7的版本。

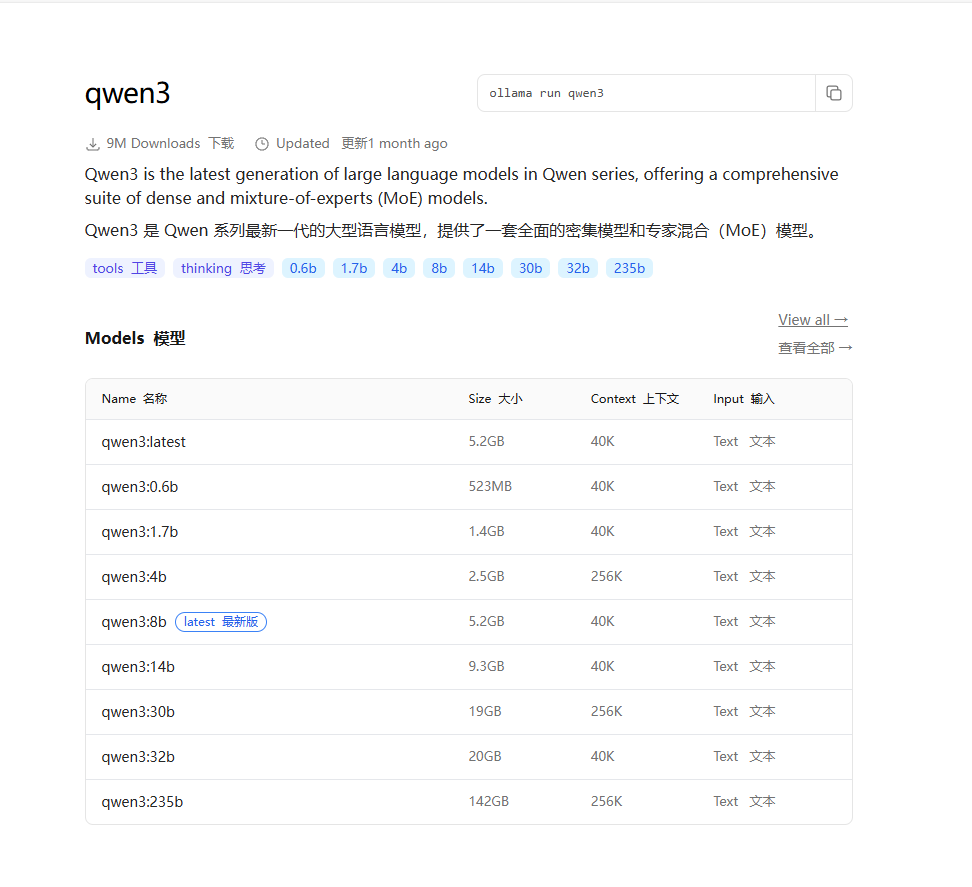

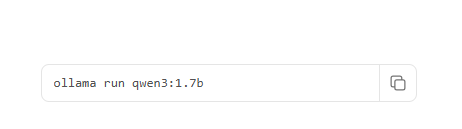

然后找到

将这串指令复制下来。

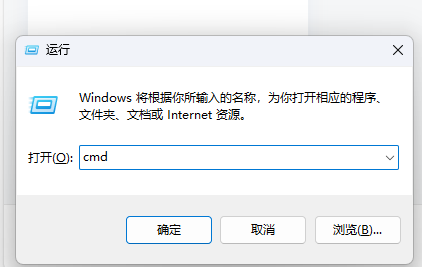

ollama run qwen3:1.7b然后win+r打开控制台

输入cmd

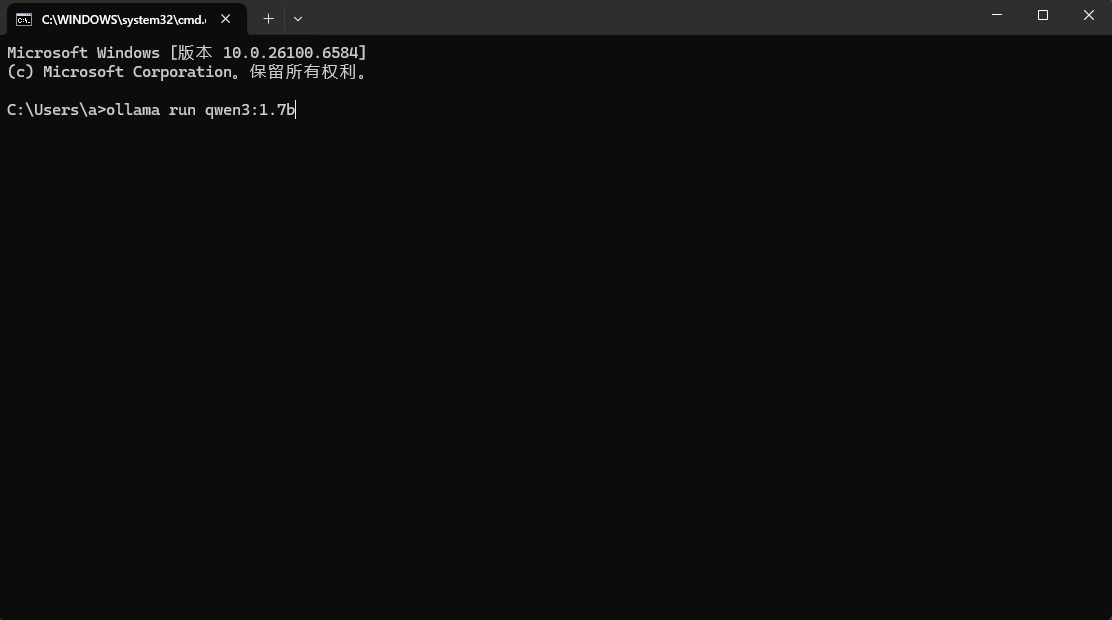

然后将上面那串指令输入进去

回车等待安装即可。

我这里就部署过了,我就不演示下载的过程了。

ollama启动本地大模型指令操作

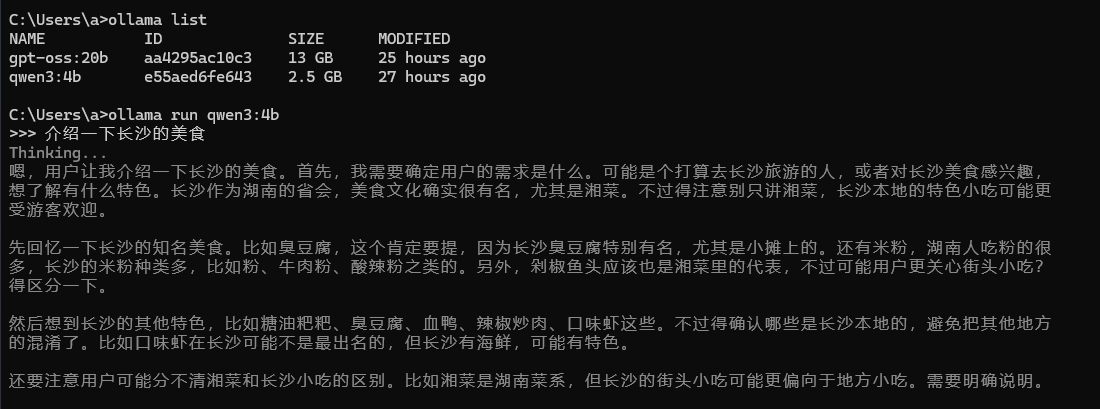

当你忘记自己电脑安装了什么大模型的时候可以输入这个指令来进行查看

ollama list

然后如何启动大模型可以输入这个指令来进行操作启动

ollama run 你的大语言模型名称如何结束对话

按住键盘的ctrl+d

ok到这里你就基本上学会了本地大模型的部署。

对话演示

在下一篇章我会演示介绍如何在python调用下载好的模型。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)