AI的个性塑造术:以LoRA为魔法棱镜,折射大模型的专属光晕

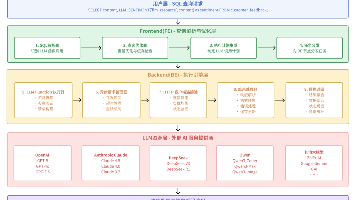

本文深入探讨大模型微调技术,重点解析如何将通用AI能力转化为专业生产力。文章对比了提示工程与微调技术的差异,指出微调在垂直领域任务中的优势。核心内容聚焦参数高效微调技术(PEFT)特别是LoRA方法,详细讲解其实现原理和代码实践,显著降低算力需求(7B模型仅需16.5GB显存)。文章提供完整的六步实战流程,从数据准备到模型部署,并给出显存占用分析和优化策略,包括4-bit量化等进阶技术。通过这套方

将通用AI能力转化为专业生产力,其核心在于高效的“精加工”。

本文深入解析了为何需要超越提示工程、如何利用LoRA等参数高效微调技术,并提供了一个清晰的GPU显存评估框架,旨在助您以最低成本为模型注入专属灵魂。

一、从“通才”到“专才”的精加工

大模型微调就像对一位“通才”进行专业领域的特训。

预训练大模型(如GPT-4、LLaMA)是知识渊博的“通才”,而微调则是利用特定领域的高质量数据集,对其进行针对性训练,使其在特定任务上表现得更专业、精准。

其核心价值在于,在不改变其通用智能底座的前提下,通过引入特定领域的高质量 “教材”(数据集),对其进行高效的 “精加工”。

加载预训练模型

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

# --- 1. 定义模型和数据集 ---

# 选择一个强大的基座模型(Base Model),这是塑造个性的基石

# 您可以根据任务需求和硬件条件,更换为其他模型,如 "mistralai/Mistral-7B-Instruct-v0.2"

model_name_or_path = "meta-llama/Llama-2-7b-chat-hf"

# --- 2. 加载分词器 (Tokenizer) ---

# 分词器负责将人类语言转换为模型能理解的数字ID

# trust_remote_code=True 允许加载模型仓库中自定义的分词器代码

print(f"正在加载分词器: {model_name_or_path}")

tokenizer = AutoTokenizer.from_pretrained(

model_name_or_path,

trust_remote_code=True

)

# 设置模型生成时的默认结束符,对于对话模型尤为重要

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

# --- 3. 加载基座模型 (Base Model) ---

# 加载预训练的模型权重

print(f"正在加载基座模型: {model_name_or_path}")

model = AutoModelForCausalLM.from_pretrained(

model_name_or_path,

torch_dtype=torch.bfloat16, # 使用 bfloat16 精度以节省显存并加速计算

device_map="auto", # 自动将模型分配到可用的 GPU/CPU 上

trust_remote_code=True

)

# 将模型设置为评估模式,这会关闭 Dropout 等训练时才需要的特性,使推理更稳定

model.eval()

print("通才模型加载完毕,基座已稳固,准备进行个性化塑造...")

# --- 4. (可选) 进行一次简单的推理测试,验证模型是否加载成功 ---

print("\n--- 进行一次快速推理测试 ---")

prompt = "你好,请介绍一下自己。"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

# 使用模型进行生成

outputs = model.generate(

**inputs,

max_new_tokens=100, # 限制生成的最大长度

temperature=0.7, # 控制生成的随机性,值越低越确定性

do_sample=True

)

# 解码并打印结果

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(f"模型回复:\n{response}")二、提示工程 VS 微调:如何选择?

若把大模型比作一位 “创作者”,那么提示工程就像 “给创作者递详细的创作大纲”—— 不改变创作者本身的能力,只通过精准引导让其输出符合需求的内容;而微调则是 “给创作者进行专项培训”—— 通过反复练习调整其认知与技能,让其从根本上具备特定领域的创作能力。

二者看似都能实现 “让模型贴合需求” 的目标,但核心逻辑、适用场景与最终效果存在本质差异,具体对比如下:

|

对比维度 |

提示工程(Prompt Engineering) |

微调(Fine-tuning) |

|

核心原理 |

「唤醒与引导」:通过精准设计输入文本(如指令、示例、约束),激发模型预训练阶段已掌握的知识,引导其按预期格式 / 风格输出,不改变模型底层参数。 |

「重塑与强化」:用任务特定的高质量数据集,对模型参数进行小范围或全量更新,让模型 “记住” 新知识、形成新技能,直接改变模型认知体系。 |

|

数据需求 |

几乎无需标注数据:仅需少量示例(Few-shot Prompt)或纯文本指令,甚至零数据(Zero-shot Prompt)即可启动。 |

依赖高质量标注数据:需针对目标任务准备结构化数据集(如 “问题 - 答案” 对、“输入 - 输出” 样本),数据量级通常从数百条(小模型 LoRA 微调)到数万条(全量微调)不等,数据质量直接决定微调效果。 |

|

成本与技术门槛 |

低门槛、低成本:无需专业算法知识,仅需理解任务逻辑与模型特性;无需高算力,普通 PC 即可完成提示调试,迭代速度快(分钟级出结果)。 |

高门槛、高成本:需掌握 PyTorch/TensorFlow 等框架,熟悉模型训练流程(如学习率调整、正则化、梯度裁剪);依赖 GPU 算力(LoRA 微调需 1-4 张 A10,全量微调需 8 张以上 A100),训练周期长(小时级至天级)。 |

|

效果上限 |

受限于模型 “原生能力”:若模型预训练未覆盖某领域知识(如小众行业术语、企业内部流程),或任务复杂度高(如精准控制输出格式、稳定模仿特定风格),提示工程易出现 “偏差”(如答非所问、格式混乱)。 |

突破原生能力边界:可让模型学习预训练未涉及的新知识(如企业私有数据、最新行业规则),且输出的格式一致性、风格稳定性、术语准确性远高于提示工程,尤其在垂直领域任务中,效果提升显著(如准确率从 60% 提升至 90%+)。 |

|

灵活性与可复用性 |

高灵活性、低复用性:可随时修改提示调整模型输出(如换风格、加约束),但每次新任务需重新设计提示,无法将 “引导逻辑” 固化到模型中。 |

低灵活性、高复用性:模型微调后 “定型”,若需更改任务目标(如从 “客服对话” 切换为 “文案生成”),需重新准备数据并再次训练;但针对同一任务,微调后的模型可直接调用,无需重复编写提示。 |

|

适用场景补充 |

1. 通用轻量任务(如写邮件、做摘要、简单问答); 2. 快速验证任务可行性(如测试模型是否能处理某类需求); 3. 无标注数据或数据稀缺场景。 |

1. 垂直领域专业任务(如医疗问诊、法律文书撰写、工业设备故障诊断); 2. 对输出格式 / 风格有严格要求的场景(如生成符合企业模板的报告、模仿特定作家的文风); 3. 需融入私有数据的场景(如让模型掌握企业内部产品信息、客户服务话术)。 |

选择提示工程还是微调,核心是平衡 “需求精度”“数据储备” 与 “成本预算”,可遵循以下阶梯式决策路径:

- 优先尝试提示工程:当任务属于通用范畴(如日常对话、基础信息查询)、无标注数据,或仅需快速验证想法时,先用提示工程搭建基础方案 —— 比如用 “指令 + 示例” 引导模型生成产品介绍文案,若输出能满足 80% 以上需求,无需启动微调。

- 当提示工程 “卡壳” 时,转向微调:若出现以下情况,说明提示工程已无法突破瓶颈,需通过微调解决:

- 格式 / 风格不稳定:多次调整提示,模型仍无法稳定输出指定格式(如带表头的表格、带编号的步骤说明);

- 知识盲区明显:模型对行业术语、私有数据理解错误(如将 “CRM 系统” 解释为 “客户关系管理软件”,但企业实际指 “内部定制的客户跟踪系统”);

- 效果无法达标:在关键指标上(如回答准确率、客户满意度),提示工程方案始终低于业务要求(如准确率需≥95%,但提示方案仅能达到 85%)。

- 小成本试错:优先选择轻量化微调:若决定微调,无需直接启动高成本的全量微调 —— 可先用 LoRA(Low-Rank Adaptation)等轻量化技术,仅更新模型的少量参数(通常仅占总参数的 0.1%-1%),在降低算力成本(仅需 1-2 张中端 GPU)的同时,快速验证微调效果;若 LoRA 效果仍不满足,再考虑全量微调。

三、关键技术演进:从“力大飞砖”到“四两拨千斤”

大模型微调技术的发展,本质是 “算力成本” 与 “效果精度” 的平衡过程 —— 从早期依赖海量算力的全参数微调,到如今聚焦 “精准更新” 的参数高效微调(PEFT),技术路径的迭代让中小团队也能低成本实现大模型个性化塑造。

1、全参数微调:时代的背影,特定场景的 “刚需选择”

全参数微调是最早的微调范式,核心逻辑是用任务特定数据对模型所有参数(从输入层到输出层)进行更新,相当于对大模型进行 “全面重塑”。

- 适用场景:仅在极少数场景下仍有价值,例如:

- 对模型精度要求极致且无算力限制(如科研领域训练专属基础模型);

- 任务与模型预训练领域差异极大(如用生物医学数据微调通用语言模型);

- 需完全改变模型核心逻辑(如将文本生成模型改造为特定任务分类模型)。

- 核心缺点:

- 算力与显存成本极高:以 7B 参数模型为例,全参数微调需至少 8 张 A100 GPU(显存 80GB / 张),训练 1 个周期的成本超过万元;175B 参数模型的全参数微调更是需数十台服务器组成分布式集群,非大型企业或科研机构难以承担。

- 易导致 “灾难性遗忘”:模型在学习新任务数据时,可能覆盖预训练阶段掌握的通用知识,出现 “学了新的,忘了旧的” 的问题(如微调后擅长医疗问答,但无法正常进行日常对话)。

- 训练周期长,迭代效率低:全参数微调需逐轮更新数十亿参数,1 个训练周期可能耗时数天,难以快速验证数据或参数调整的效果。

2、参数高效微调(PEFT):当前主流,中小团队的 “性价比之选”

PEFT(Parameter-Efficient Fine-Tuning)的核心思想是冻结大模型 99% 以上的预训练参数,仅通过引入少量可训练参数(如低秩矩阵、前缀向量)或解锁特定层参数,实现模型个性化,既降低算力成本,又避免灾难性遗忘。

- 除了当前最流行的 LoRA,PEFT 还有多种主流技术路径,各有适用场景:

|

技术类型 |

核心原理 |

优势 |

适用场景 |

|

LoRA(低秩适应) |

在模型关键层(如 Transformer 的 Query/Value 投影层)插入两个低秩矩阵(A 和 B),训练时仅更新 A 和 B,推理时将 A×B 的结果叠加到原参数上 |

显存需求极低、无推理延迟、效果稳定 |

文本生成、问答、分类等多数任务,是当前首选方案 |

|

Prefix Tuning(前缀微调) |

在输入序列前添加一段可训练的 “前缀向量”(如 “[P1, P2, ..., Pn]”),冻结模型其他参数,仅训练前缀向量 |

不改变模型主体结构,适合序列生成任务 |

对话生成、文案创作等需控制输出风格的场景 |

|

Adapter Tuning(适配器微调) |

在模型各层插入小型 “适配器模块”(如 bottleneck 结构:降维→激活→升维),仅训练适配器参数 |

可灵活调整模块大小,平衡效果与成本 |

跨模态任务(如图文生成)、需适配多任务场景 |

- 主流技术:LoRA(低秩适应)深度解析与代码实现

- 假设模型某层权重矩阵为 W(维度为 d×k),LoRA 在训练时不直接更新 W,而是引入两个低秩矩阵 A(d×r)和 B(r×k),其中 r(秩)远小于 d 和 k(通常 r=4、8、16);

- 训练过程中仅更新 A 和 B,训练完成后,将 A×B 的结果作为权重增量 ΔW,与原权重 W 叠加(W_final = W + A×B);

- 推理时,可将 ΔW 与 W 合并为一个矩阵,无需额外加载 LoRA 参数,避免推理延迟。

import torch

from peft import LoraConfig, get_peft_model

from transformers import AutoModelForCausalLM, AutoTokenizer

# 1. 先加载基座模型(延续前文的Llama-2-7b-chat-hf)

model_name_or_path = "meta-llama/Llama-2-7b-chat-hf"

tokenizer = AutoTokenizer.from_pretrained(model_name_or_path, trust_remote_code=True)

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

model = AutoModelForCausalLM.from_pretrained(

model_name_or_path,

torch_dtype=torch.bfloat16,

device_map="auto",

trust_remote_code=True

)

# 2. 配置LoRA参数(关键参数详解)

lora_config = LoraConfig(

r=8, # 低秩矩阵的维度(rank):值越小,参数越少,成本越低;通常取4-32,需根据任务调整(复杂任务选大值)

lora_alpha=32, # 缩放因子:控制LoRA更新量的权重,通常为r的2-4倍(alpha=32时,更新量缩放32倍)

target_modules=["q_proj", "v_proj"], # 目标模块:选择Transformer中对任务影响大的层(如Query/Value投影层),不同模型模块名不同(如ChatGLM为"query_key_value")

lora_dropout=0.1, # Dropout概率:防止过拟合,通常取0.05-0.2

bias="none", # 是否训练偏置参数:"none"表示不训练,降低参数规模

task_type="CAUSAL_LM" # 任务类型:因果语言模型(文本生成任务),分类任务需设为"SEQ_CLS"

)

# 3. 将LoRA配置应用到基座模型

lora_model = get_peft_model(model, lora_config)

# 4. 查看可训练参数占比:直观感受LoRA的“高效性”

lora_model.print_trainable_parameters()

# 输出示例: trainable params: 4,194,304 || all params: 6,742,609,920 || trainable%: 0.0622%

# 解读:仅需训练0.06%的参数,即可实现模型个性化,显存需求从数十GB降至数GB

# 5. (可选)冻结模型部分层,进一步降低成本(适合超大规模模型)

# for name, param in lora_model.named_parameters():

# # 冻结输出层参数(无需调整)

# if "lm_head" in name:

# param.requires_grad = False四、实战流程六步法

1、明确目标:定义具体任务和期望的输入输出格式。

核心:说清 “模型要做什么”“输入输出长什么样”

示例:任务→“法律问答”;输入→“法律问题文本”;输出→“简洁专业的法律解释(≤300 字)”

2、数据准备(最关键步骤):收集、清洗并构建高质量的(指令,输入,输出)三元组数据集

核心:做 “指令 + 输入 + 输出” 三元组,少而精(50-500 条足够)

步骤:

- 收集:从行业文档、专业问答中提取样本;

- 清洗:删重复、错漏数据(比如法律术语错误的样本);

- 格式:用统一模板整理(代码见下文)。

# 1. 定义格式模板(适配SFT训练)

def format_data(instruction, input_text="", output_text):

# 无输入时省略Input部分

if input_text:

return {"text": f"### 指令:{instruction}\n### 输入:{input_text}\n### 输出:{output_text}"}

return {"text": f"### 指令:{instruction}\n### 输出:{output_text}"}

# 2. 造示例数据(法律场景)

train_data = [

format_data("解释‘不可抗力’", "", "指不能预见、不能避免且不能克服的客观情况,如地震、战争,可免除合同责任。"),

format_data("起草软件许可核心条款", "甲方:A科技,乙方:用户", "1. 甲方授乙方非商用使用权;2. 禁止乙方破解或转授权;3. 有效期1年。")

]

# 3. 保存为JSON(供后续训练调用)

import json

with open("train_data.json", "w", encoding="utf-8") as f:

json.dump(train_data, f, ensure_ascii=False, indent=2)3、选择模型与方法:根据任务和资源选择基座模型和微调方法(首选LoRA)

模型:中小任务选 7B 模型(如 Llama-2-7B),复杂任务选 13B(如 Mistral-13B);

方法:优先 LoRA(省算力,1 张 RTX 3090 就能跑)。

4、训练执行:设置学习率、批次大小等超参数,开始训练

核心参数(不用死记,参考模板):

- 学习率:2e-4(LoRA 常用值)。

- 批次大小:4(24GB 显存够用)。

- 训练轮次:3-5 轮(避免过拟合)。

from peft import LoraConfig, get_peft_model

from transformers import AutoModelForCausalLM, TrainingArguments, Trainer

# 1. 加载模型+LoRA配置

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b-chat-hf", device_map="auto")

lora_cfg = LoraConfig(r=8, target_modules=["q_proj", "v_proj"], task_type="CAUSAL_LM")

model = get_peft_model(model, lora_cfg)

# 2. 配置训练参数

train_args = TrainingArguments(

output_dir="./lora_model", # 模型保存路径

per_device_train_batch_size=4,

learning_rate=2e-4,

num_train_epochs=3

)

# 3. 启动训练(需提前加载train_data.json)

trainer = Trainer(model=model, args=train_args, train_dataset=load_train_data())

trainer.train()5、评估迭代:在验证集上评估效果,并迭代优化

简单评估:拿 10 条新测试数据(没参与训练的)喂模型,看 3 个点:

- 输出是否符合格式(如法律解释≤300 字)。

- 内容是否准确(无法律术语错误)。

- 不满意就加 10-20 条数据重新训。

6、部署应用:将微调好的模型部署为API或集成到应用中

核心:用 LoRA 模型 + 基座模型快速部署,不用全量模型

from peft import PeftModel

# 加载基座+LoRA模型

base_model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b-chat-hf")

lora_model = PeftModel.from_pretrained(base_model, "./lora_model")

# 简单调用

def get_legal_answer(question):

prompt = f"### 指令:回答法律问题\n### 输入:{question}\n### 输出:"

outputs = lora_model.generate(prompt, max_new_tokens=300)

return outputs[0]五、【核心】GPU显存占用分析与优化实战

1、先搞懂:显存被谁 “吃” 了?

微调时 GPU 显存主要分 4 部分,不同部分的优化策略差异很大:

| 显存占用来源 | 核心作用 | 占比特点 | 优化难度 |

|---|---|---|---|

| 模型权重(Weights) | 存储大模型的基础参数(如 Transformer 层参数) | 占比固定,是 “基础开销” | 中(靠量化降低) |

| 优化器状态(Optimizer States) | 存储优化器(如 AdamW)的动量、二阶矩等参数,用于更新模型权重 | 占比高(通常是权重的 4 倍) | 高(靠 PEFT 技术削减) |

| 梯度(Gradients) | 反向传播时计算的参数梯度,用于更新权重 | 占比与权重相当,训练中临时产生 | 低(靠梯度累积 / 检查点优化) |

| 激活值 / 临时内存 | 前向传播时产生的中间计算结果(如注意力矩阵) | 占比波动,与批次大小正相关 | 低(靠调小批次 / 混合精度优化) |

2、实战对比:7B 模型不同微调方式的显存需求

以 7B 参数模型(主流中小任务选择)为例,全参数微调与 LoRA 微调的显存占用差距悬殊,直接决定了硬件门槛:

| 微调方法 | 模型权重(bf16 精度) | 优化器状态(AdamW) | 激活 / 临时内存 | 总计(近似) | 推荐 GPU 型号 | 硬件成本参考 |

|---|---|---|---|---|---|---|

| 全参数微调 | 14 GB(需实时更新) | 56 GB(权重的 4 倍) | ~8 GB | ~78 GB | A100(80GB)/H100(80GB) | 单卡数万元(数据中心级) |

| LoRA 微调(8-bit 优化器) | 14 GB(冻结,不更新) | 0.5 GB(仅更新 LoRA 参数) | ~2 GB | ~16.5 GB | RTX 3090(24GB)/RTX 4090(24GB) | 单卡数千元(消费级) |

核心结论:LoRA 通过 “冻结主模型权重 + 仅训练少量低秩矩阵”,把优化器状态显存从 56GB 砍到 0.5GB,直接将硬件门槛从 “数据中心级” 拉到 “个人 / 中小团队可承担的消费级”。

3、实战优化:3 类关键技术 + 代码示例

当显存仍紧张(如用 16GB 显存的 RTX 3080 跑 7B 模型),可通过以下技术进一步压减显存,核心逻辑是 “用少量计算时间换显存空间”。

3.1、基础优化:调整训练参数(无性能损失)

通过合理设置TrainingArguments,在不影响模型效果的前提下降低显存占用,新手优先尝试。

import torch

from transformers import TrainingArguments, AutoModelForCausalLM, AutoTokenizer

# 1. 加载模型(先按基础配置)

model_name = "meta-llama/Llama-2-7b-chat-hf"

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto", # 自动分配显存到GPU/CPU

torch_dtype=torch.bfloat16 # 用bf16精度(比fp32省一半权重显存)

)

# 2. 核心显存优化参数配置

training_args = TrainingArguments(

output_dir="./lora-7b-optimized",

per_device_train_batch_size=2, # 减小单批次大小(显存不够就往小调,如1/2)

gradient_accumulation_steps=4, # 梯度累积:等效批次=2*4=8,不丢训练效果

learning_rate=2e-4,

num_train_epochs=3,

fp16=True, # 开启混合精度训练(显存省30%-40%,几乎无精度损失)

optim="paged_adamw_8bit", # 用8-bit分页优化器(比标准AdamW省一半优化器显存)

logging_steps=10,

save_steps=500,

)

# 3. 额外优化:启用梯度检查点(再省15%-20%显存)

model.gradient_checkpointing_enable() # 反向传播时重新计算部分激活值,用时间换显存关键说明:

gradient_accumulation_steps:若单批次设为 2 仍显存不足,可设为 8,等效批次 = 2*8=16,保证训练稳定性;paged_adamw_8bit:需安装bitsandbytes库(pip install bitsandbytes),8-bit 优化器比 32-bit 省 75% 显存。

3.2、进阶优化:QLoRA(4-bit 量化,显存再砍一半)

将主模型权重从 14GB(bf16)量化到 4-bit,权重显存直接压到 7GB,适合 16GB 显存显卡跑 7B 模型,13B 模型也能尝试。

from transformers import BitsAndBytesConfig

from peft import LoraConfig, get_peft_model

# 1. 配置4-bit量化(核心:将主模型权重压到4-bit)

bnb_config = BitsAndBytesConfig(

load_in_4bit=True, # 4-bit加载模型

bnb_4bit_use_double_quant=True, # 双重量化(进一步降低量化误差)

bnb_4bit_quant_type="nf4", # 针对大模型优化的量化类型(比普通4-bit精度更高)

bnb_4bit_compute_dtype=torch.bfloat16 # 计算时用bf16,保证推理精度

)

# 2. 4-bit加载7B模型(权重显存从14GB→7GB)

model_4bit = AutoModelForCausalLM.from_pretrained(

model_name,

quantization_config=bnb_config,

device_map="auto"

)

# 3. 叠加LoRA(仅训练0.1%参数)

qlora_config = LoraConfig(

r=8, # 低秩矩阵维度(越大效果越好,显存占用略增,通常设4-16)

lora_alpha=32,

target_modules=["q_proj", "v_proj"], # 仅训练注意力层的Q/V投影

lora_dropout=0.1,

task_type="CAUSAL_LM"

)

qlora_model = get_peft_model(model_4bit, qlora_config)

qlora_model.print_trainable_parameters() # 输出:trainable%: 0.0622%(仅训练400多万参数)

# 4. 此时显存占用≈7GB(4-bit权重)+0.5GB(LoRA优化器)+2GB(激活值)≈9.5GB,16GB显卡轻松跑注意:QLoRA 量化会有微小精度损失(约 1%-3%),但对中小任务(如客服问答、文案生成)几乎无感知,性价比极高。

3.3、极限优化:CPU Offload(显存不够 CPU 补)

若只有 12GB 显存(如 RTX 3060),可将模型部分非关键层(如输入层 / 输出层)放到 CPU,仅用 GPU 跑核心注意力层,代价是训练速度变慢(约降 30%)。

# 1. 加载模型时指定“CPU Offload”策略

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

torch_dtype=torch.bfloat16,

offload_folder="./offload", # 存放CPU Offload的参数

offload_state_dict=True # 将部分状态字典放到CPU

)

# 2. 配合LoRA+8-bit优化器,12GB显存可跑7B模型

lora_config = LoraConfig(r=8, target_modules=["q_proj", "v_proj"], task_type="CAUSAL_LM")

lora_model = get_peft_model(model, lora_config)4、优化优先级建议

新手按以下顺序尝试优化,避免一上来就用复杂技术:

- 先开

bf16+fp16混合精度+paged_adamw_8bit优化器(基础操作,无代价);- 若显存仍不够,调小

per_device_train_batch_size+ 加gradient_accumulation_steps;- 还不够,启用

gradient_checkpointing_enable()(用时间换显存);- 最后尝试 QLoRA(4-bit 量化)或 CPU Offload(适合硬件极有限的场景)。

按这个流程,16GB 显存的显卡能稳定跑 7B 模型 LoRA 微调,24GB 显存能跑 13B 模型,完全满足中小团队的个性化需求。

六、结语

大模型微调是连接通用AI与专业应用的桥梁。参数高效微调技术(尤其是LoRA/QLoRA)的革命性突破,极大地降低了技术门槛和成本。通过本文提供的从技术原理到显存评估的实战框架,您可以清晰地规划资源,成功将大模型的通用能力,精细地塑造为您的专属生产力工具。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)