MCP vs LangChain:下一代AI工具编排谁更胜一筹?

在 MCP 中,工具的定义是标准化的。服务器通过tools/list方法向客户端声明自己拥有哪些工具,每个工具都包含名称、描述和输入模式(JSON Schema)。// MCP 服务器端工具定义示例description: "读取指定路径的文件内容",path: {description: "要读取的文件路径"},// 服务器将这个定义通过 tools/list 方法暴露给客户端// ... 实现

人们眼中的天才之所以卓越非凡,并非天资超人一等而是付出了持续不断的努力。1万小时的锤炼是任何人从平凡变成超凡的必要条件。———— 马尔科姆·格拉德威尔

🌟 Hello,我是Xxtaoaooo!

🌈 “代码是逻辑的诗篇,架构是思想的交响”

在人工智能的浪潮之巅,如何将强大的语言模型与现实世界的工具、数据和服务连接起来,已成为释放其全部潜能的关键。AI Agent(智能体)的概念应运而生,它赋予了模型执行任务、与环境交互的能力。在这一领域,MCP(Model Context Protocol)和 LangChain 无疑是两个备受瞩目的重量级选手。MCP,由 Anthropic 推出,旨在通过一个标准化的开放协议,为 AI 助手提供安全、可扩展的工具访问能力,它更像是一个为 AI 工具交互制定的“HTTP协议”。而 LangChain,作为一个功能强大的开源框架,通过灵活的组件化设计和庞大的生态系统,为构建端到端的语言模型应用提供了无限可能,它更像是一个全能的“Web开发框架”。

这两种技术代表了两种截然不同的设计哲学。MCP 追求的是“标准化”与“安全性”,它通过定义清晰的客户端-服务器架构和通信规范,试图在混乱的工具集成领域建立秩序。这种协议优先的思路,使得不同开发者、不同平台之间的工具可以互操作,极大地降低了集成成本和安全风险。而 LangChain 则拥抱“灵活性”与“生态系统”,它提供了一套丰富的“乐高积木”,让开发者可以自由组合,快速构建出从简单到复杂的各种 Agent 应用。这种框架优先的思路,极大地激发了社区的创造力,催生了海量的工具集成和应用范例。

本文将对这两种主流的 AI 工具编排方案进行一次全方位的深度对比。我们将从核心架构的设计理念出发,剖析它们在工具定义、Agent 执行、安全机制、性能表现和生态系统等方面的异同。通过具体的代码示例和可视化图表,我们将直观地展示它们在实际开发中的差异。这不仅仅是一次技术选型的探讨,更是一次对未来 AI 应用架构演进方向的思考。无论你是正在为项目选择合适工具的开发者,还是对 AI Agent 技术充满好奇的技术爱好者,相信这次的深度剖析都能为你带来有价值的洞见。

一、引言:AI工具编排的演进与挑战

随着大型语言模型(LLM)能力的飞速发展,我们不再满足于让它们仅仅扮演一个聊天机器人的角色。我们期望 AI 能够像人类一样,使用工具、访问数据、执行任务,从而真正成为我们工作和生活中的智能助手。这就是 AI Agent(智能体)的核心思想。然而,要实现这一目标,我们必须解决一个核心挑战:如何安全、高效地将语言模型与外部世界连接起来?

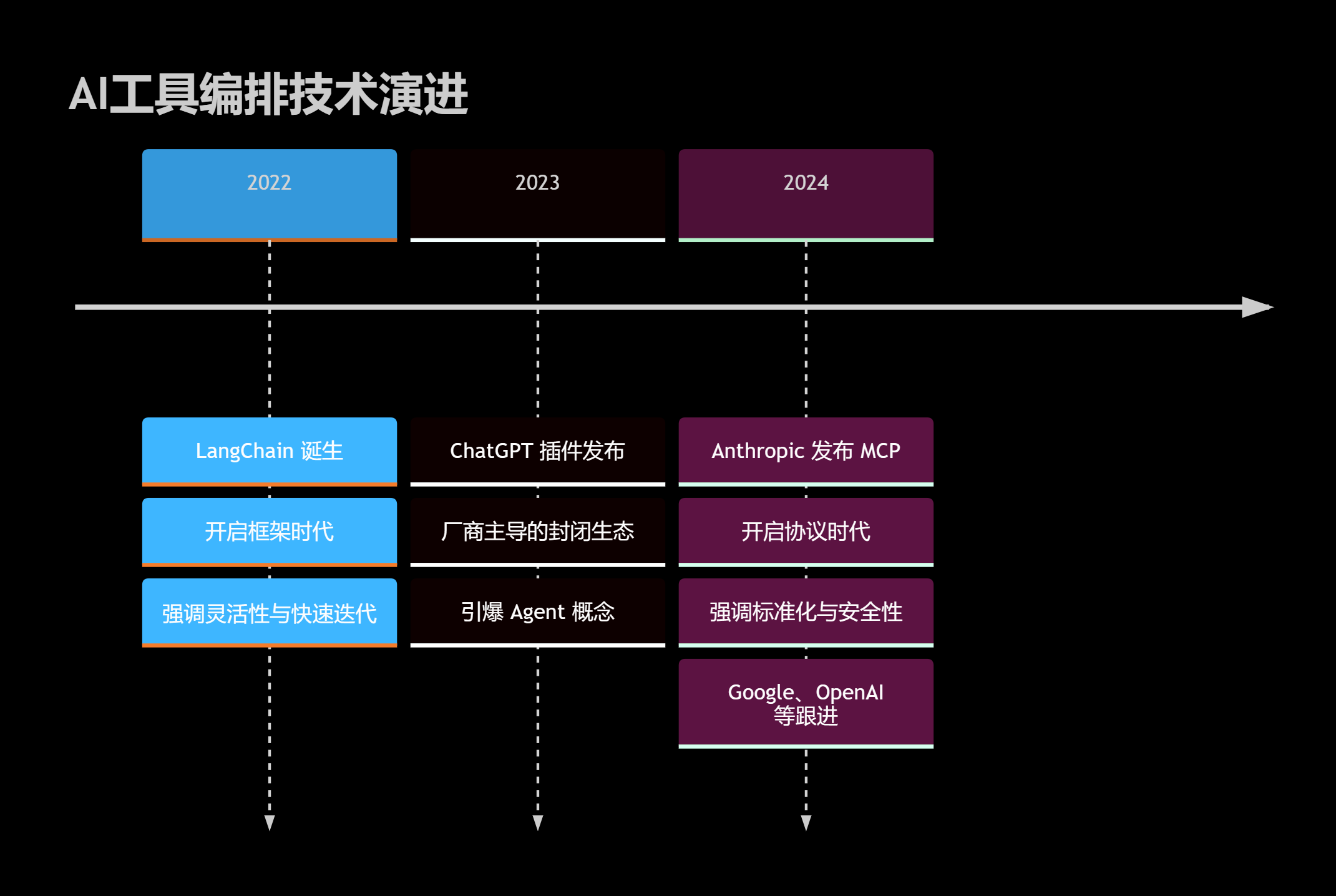

1.1 从插件到框架,再到协议

AI 工具编排技术经历了几个阶段的演进:

- 早期插件系统(Plugin Systems):以 ChatGPT 插件为代表,模型厂商定义一套封闭的 API 规范,开发者按照规范开发插件。这种方式简单直接,但生态封闭,互操作性差。

- 通用编排框架(Orchestration Frameworks):以 LangChain 为代表,提供了一套通用的组件和接口(如

Tools,Agents,Chains),让开发者可以灵活地集成各种工具和模型。这种方式极大地提高了开发的灵活性和效率,催生了庞大的开源生态。 - 标准化协议(Standardized Protocols):以 MCP 为代表,试图通过定义一个开放的、与模型无关的通信协议,来标准化工具的交互方式。这种方式旨在解决框架林立带来的“巴别塔”问题,实现真正的互操作性和安全性。

1.2 核心挑战

在工具编排的实践中,我们面临着几个核心挑战:

- 安全性:如何防止 Agent 执行恶意操作或泄露敏感数据?

- 标准化:如何让为 A 模型开发的工具也能被 B 模型使用?

- 可发现性:Agent 如何知道有哪些工具可用,以及如何使用它们?

- 性能:频繁的工具调用带来的延迟和开销如何优化?

- 可维护性:随着工具数量的增加,如何管理和维护整个系统?

MCP 和 LangChain 正是对这些挑战给出的不同答案。

图1:AI工具编排技术演进时间线 - 展示了从框架到协议的发展趋势。

二、MCP协议深度解析:标准化与安全性的新范式

MCP(Model Context Protocol)由 Anthropic 提出,其核心目标是创建一个开放、安全、可互操作的 AI 工具使用标准。它不像 LangChain 那样是一个包罗万象的开发框架,而是一个纯粹的通信协议。

2.1 核心架构:客户端-服务器模型

MCP 采用了经典的客户端-服务器(Client-Server)架构。

- MCP 客户端(Client):通常是 AI 助手或语言模型本身,负责向服务器发起请求。

- MCP 服务器(Server):是工具的提供者,负责实现具体的工具逻辑并响应客户端的请求。

两者之间通过标准的 JSON-RPC 2.0 协议进行通信,传输层可以是 WebSocket、HTTP 或标准输入/输出(Stdio)。

图2:MCP核心架构图 - 清晰地展示了客户端与服务器分离的模式。

2.2 工具定义与发现

在 MCP 中,工具的定义是标准化的。服务器通过 tools/list 方法向客户端声明自己拥有哪些工具,每个工具都包含名称、描述和输入模式(JSON Schema)。

// MCP 服务器端工具定义示例

const fileReadTool: MCPTool = {

name: "read_file",

description: "读取指定路径的文件内容",

inputSchema: {

type: "object",

properties: {

path: {

type: "string",

description: "要读取的文件路径"

}

},

required: ["path"]

}

};

// 服务器将这个定义通过 tools/list 方法暴露给客户端

class MyMCPServer extends MCPServer {

constructor() {

super({ name: "My Tool Server", version: "1.0.0" });

this.addTool(fileReadTool, this.handleReadFile);

}

private async handleReadFile(params: { path: string }) {

// ... 实现文件读取逻辑 ...

// 安全检查是关键

if (!this.isPathSafe(params.path)) {

throw new Error("Access denied.");

}

return { content: await fs.readFile(params.path, 'utf-8') };

}

}

这种方式使得 AI 模型可以“动态地”发现和理解可用的工具,而无需在提示(Prompt)中硬编码。

2.3 安全性设计

安全性是 MCP 设计的重中之重。由于服务器和客户端是分离的,工具的执行环境与模型环境完全隔离,这从根本上杜绝了模型直接执行恶意代码的风险。服务器可以实现非常细粒度的权限控制,例如限制文件访问的路径、限制数据库操作的表等。

三、LangChain框架剖析:灵活性与生态系统的力量

LangChain 是一个功能强大的开源框架,旨在简化语言模型应用的开发。它的核心优势在于其灵活性和庞大的社区生态。

3.1 核心组件:Chains, Agents, Tools

LangChain 的架构是基于一系列可组合的组件。

- Tools(工具):对外部服务(如 Google 搜索、数据库、API)的封装。开发者可以轻松定义自己的工具。

- Chains(链):将语言模型与提示、工具、记忆等组件串联起来,形成一个完整的逻辑流。

- Agents(智能体):一种特殊的链,它使用语言模型来决定下一步应该执行哪个动作(Action),直到任务完成。LangChain 提供了多种 Agent 类型,如 ReAct、Self-ask 等。

- Memory(记忆):为链或智能体提供状态保持能力,使其能够记住之前的交互。

3.2 工具定义与 Agent 执行

在 LangChain 中,定义一个工具非常直接。

# LangChain 中定义工具的示例 (Python)

from langchain.tools import tool

import os

@tool

def list_files(directory: str) -> list[str]:

"""列出指定目录下的所有文件和文件夹。"""

# 安全性完全由开发者负责

if not directory.startswith("/safe_path/"):

return "Error: Access denied."

try:

return os.listdir(directory)

except Exception as e:

return f"Error: {str(e)}"

# 创建 Agent

from langchain_openai import ChatOpenAI

from langchain.agents import create_react_agent, AgentExecutor

llm = ChatOpenAI(model="gpt-4-turbo")

tools = [list_files]

# ReAct 风格的提示模板

prompt = hub.pull("hwchase17/react")

agent = create_react_agent(llm, tools, prompt)

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# 执行任务

agent_executor.invoke({"input": "列出 /safe_path/projectA 目录下的文件"})

LangChain 的 Agent 执行流程通常是:LLM 根据输入和可用工具的描述,生成一个包含下一步动作的思考过程,AgentExecutor 解析这个输出,执行相应的工具,然后将结果返回给 LLM,循环往复,直到任务完成。

3.3 灵活性与生态

LangChain 最大的优势在于其无与伦比的灵活性和庞大的生态系统。它集成了数百种工具、数十种语言模型和向量数据库。开发者可以像搭乐高一样,快速地将这些组件组合起来,构建出功能强大的应用。然而,这种灵活性也带来了一定的复杂性和安全责任,所有安全检查都需要开发者自行实现。

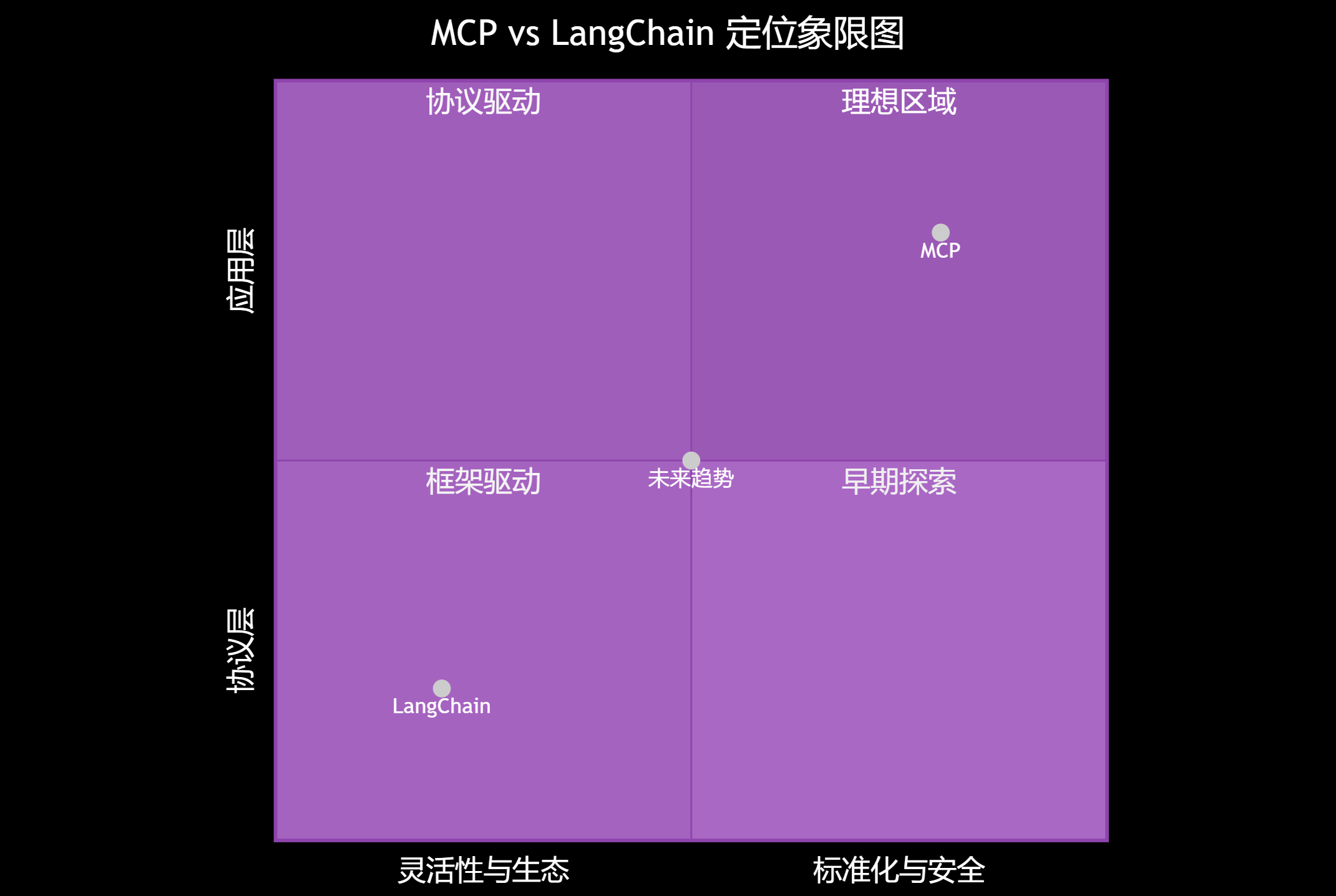

四、核心架构对比:标准化 vs 灵活性

MCP 和 LangChain 代表了两种截然不同的架构哲学。

| 特性 | MCP (Model Context Protocol) | LangChain |

|---|---|---|

| 核心定位 | 通信协议 | 开发框架 |

| 架构模型 | 客户端-服务器(解耦) | 单体应用/微服务(灵活) |

| 设计哲学 | 协议优先,强调标准化、互操作性 | 框架优先,强调灵活性、快速开发 |

| 安全性 | 协议内置,执行环境隔离 | 开发者责任,需自行实现 |

| 工具定义 | 标准化 JSON Schema | 灵活的函数/类定义 |

| 生态系统 | 尚在早期,依赖厂商推动 | 极其庞大,社区驱动 |

| 学习曲线 | 较低,理解协议即可 | 较高,需掌握框架核心概念 |

图3:MCP vs LangChain 定位象限图 - MCP 位于“协议驱动”和“标准化与安全”的象限,而 LangChain 位于“框架驱动”和“灵活性与生态”的象限。

五、功能与实现对比:从工具定义到Agent执行

通过一个具体的例子,看看两者在实现上的差异。假设我们要实现一个“执行系统命令”的工具。

5.1 MCP 实现

在 MCP 中,需要创建一个服务器来暴露这个工具。

// mcp-server.ts

import { MCPServer, MCPTool } from '@mcp/server';

import { exec } from 'child_process';

const execCommandTool: MCPTool = {

name: "execute_command",

description: "在服务器上执行一个安全的shell命令。",

inputSchema: {

type: "object",

properties: {

command: { type: "string", description: "要执行的命令" }

},

required: ["command"]

}

};

class CommandServer extends MCPServer {

constructor() {

super({ name: "Command Server", version: "1.0.0" });

this.addTool(execCommandTool, this.handleExecCommand);

}

private async handleExecCommand(params: { command: string }): Promise<{ stdout: string; stderr: string }> {

// 关键:严格的命令白名单和清理

const allowedCommands = ["ls", "echo", "pwd"];

const [cmd, ...args] = params.command.split(' ');

if (!allowedCommands.includes(cmd)) {

throw new Error(`Command not allowed: ${cmd}`);

}

return new Promise((resolve, reject) => {

exec(params.command, (error, stdout, stderr) => {

if (error) {

reject(error);

return;

}

resolve({ stdout, stderr });

});

});

}

}

// ... 启动服务器 ...

优点:安全性高,执行环境隔离。

缺点:需要额外维护一个服务器进程。

5.2 LangChain 实现

在 LangChain 中,只需要在你的应用代码中定义一个工具函数。

# langchain_app.py

from langchain.tools import tool

from langchain.agents import AgentExecutor, create_react_agent

from langchain_openai import ChatOpenAI

# ... 其他 imports

@tool

def execute_command(command: str) -> str:

"""在服务器上执行一个安全的shell命令。"""

# 关键:安全责任完全在开发者

allowed_commands = ["ls", "echo", "pwd"]

cmd = command.split(' ')[0]

if cmd not in allowed_commands:

return f"Error: Command '{cmd}' is not allowed."

try:

result = subprocess.run(command, shell=True, capture_output=True, text=True, timeout=10)

if result.returncode != 0:

return f"Error: {result.stderr}"

return result.stdout

except Exception as e:

return f"Execution failed: {str(e)}"

# ... 创建和执行 Agent ...

llm = ChatOpenAI()

tools = [execute_command]

# ...

优点:开发简单快捷,集成度高。

缺点:安全风险高,代码注入风险大,需要开发者有极高的安全意识。

5.3 交互流程对比

图4:MCP与LangChain交互时序图 - MCP通过网络调用解耦,LangChain在应用内直接调用。

六、生态系统与未来展望

6.1 生态对比

- LangChain:拥有一个极其庞大和活跃的社区。无论是模型、工具还是数据库,几乎所有主流服务都有现成的 LangChain 集成。这使得开发者可以快速启动项目。

- MCP:生态尚在起步阶段。目前主要是 Anthropic 自身在推动,但 Google 的

Toolpad、OpenAI 的Assistants API也在朝着类似的方向发展,预示着“协议化”可能成为未来的趋势。如果各大厂商能够达成共识,MCP 的生态潜力将是巨大的。

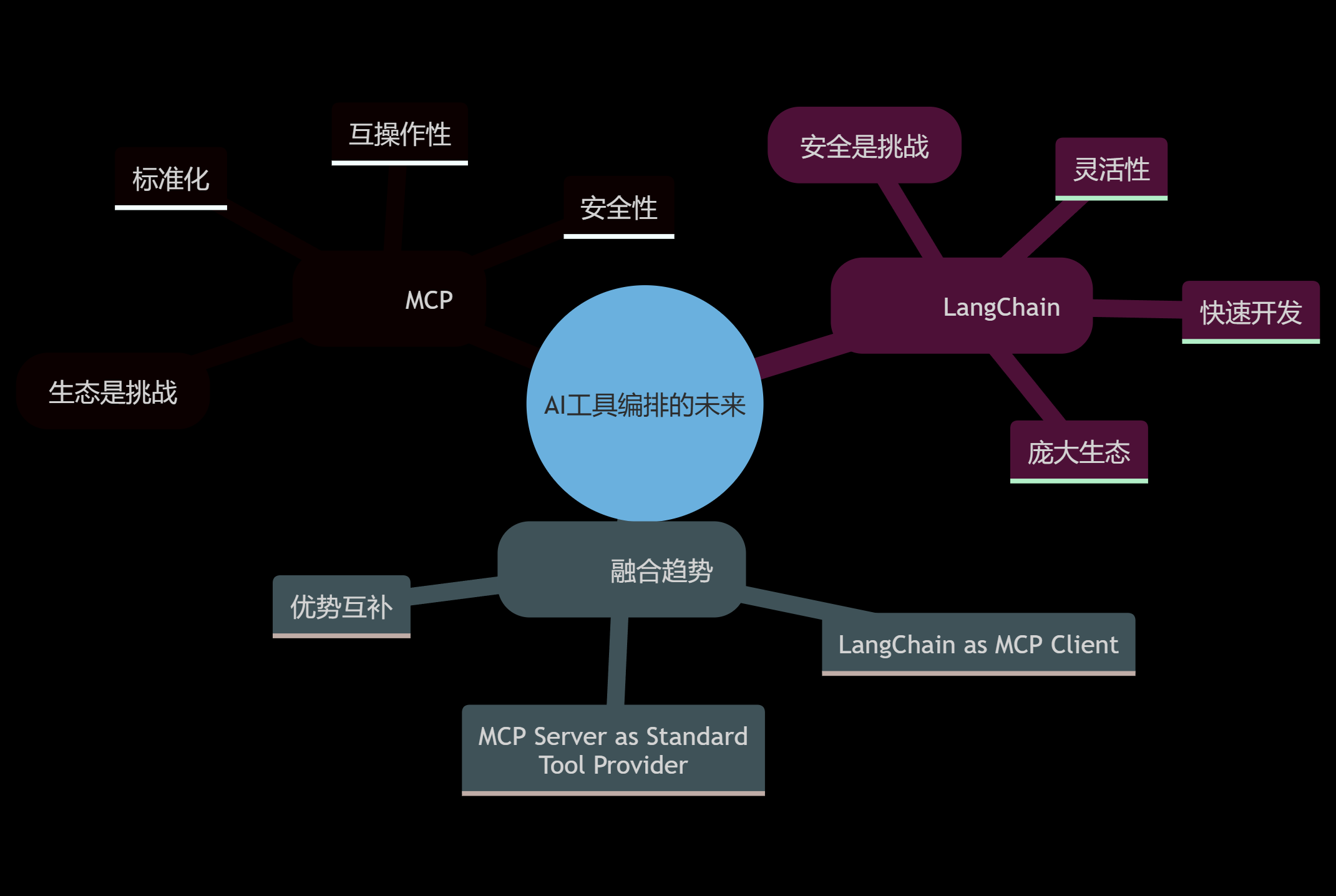

6.2 未来展望:融合还是竞争?

MCP 和 LangChain 并非完全对立,它们很可能会走向融合。

“好的协议能够催生繁荣的生态,而好的框架能够让协议的使用变得简单。”

可以预见这样一种未来:

- 越来越多的工具提供商将以 MCP 服务器的形式暴露其服务。

- LangChain 等框架将内置 MCP 客户端,使得在 LangChain 中调用一个 MCP 工具就像调用一个普通工具一样简单。

- 开发者可以同时利用 LangChain 的灵活性来编排复杂的业务逻辑,并利用 MCP 的标准化和安全性来访问外部工具。

图5:AI工具编排未来趋势思维导图 - 展示了MCP和LangChain的特点及融合的可能性。

七、结论:如何选择?

那么,在当前阶段,我们应该如何选择呢?

选择 MCP,如果你的场景是:

- 企业级应用:对安全性和稳定性有极高要求。

- 平台化服务:你需要为多个不同的 AI 应用或模型提供一套统一的、可控的工具集。

- 跨团队协作:工具开发团队和 AI 应用开发团队分离,需要清晰的边界和契约。

- 长期演进:你看好标准化协议的未来,并愿意为此进行前期投入。

选择 LangChain,如果你的场景是:

- 快速原型验证:你需要尽快将一个想法落地并进行验证。

- 中小型项目或个人项目:开发效率优先,且安全风险可控。

- 复杂的、非标的 Agent 逻辑:你需要高度的灵活性来编排自定义的链和 Agent。

- 利用现有生态:你的应用需要大量依赖 LangChain 社区已经集成的工具。

总的来说,MCP 和 LangChain 各有千秋,它们不是“你死我活”的竞争关系,而是在不同层面、为不同目标服务的解决方案。MCP 关注的是“工具如何被安全地提供和调用”,而 LangChain 关注的是“如何用工具来构建强大的应用”。理解了这一点,你就能根据自己的需求,做出最明智的选择。随着技术的发展,我们期待看到一个既标准化又灵活的 AI Agent 开发新范式。

🌟 嗨,我是Xxtaoaooo!

⚙️ 【点赞】让更多同行看见深度干货

🚀 【关注】持续获取行业前沿技术与经验

🧩 【评论】分享你的实战经验或技术困惑

作为一名技术实践者,我始终相信:

每一次技术探讨都是认知升级的契机,期待在评论区与你碰撞灵感火花🔥

参考链接

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)