Ollama本地部署DeepSeek大模型

本文介绍了如何利用Ollama开源框架在Windows和Linux平台上本地部署DeepSeek大模型。Ollama简化了大型语言模型的本地部署与管理,支持多种模型格式和硬件加速。具体步骤包括:下载安装Ollama,配置环境变量,选择合适的DeepSeek模型版本进行部署,并通过Python代码调用模型接口。文章还提供了Linux平台的一键安装命令和Windows的详细安装流程,帮助开发者高效利用

注:此文章内容均节选自充电了么创始人,CEO兼CTO陈敬雷老师的新书《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频课程【陈敬雷】

文章目录

GPT多模态大模型与AI Agent智能体系列一百九十二

Ollama本地部署DeepSeek大模型

9.1.1 Ollama本地部署DeepSeek大模型

Ollama是一个强大的开源框架,它简化了大型语言模型的本地部署和管理过程,使得开发者和研究人员能够更加高效地利用这些模型的强大能力。

1.Ollama简介

Ollama是一款专注于本地化大型语言模型部署与推理的开源框架,旨在简化复杂模型的本地运行与管理流程,赋能开发者和研究人员无需依赖云端服务即可高效利用大模型能力。其核心理念是通过轻量化设计、灵活配置和丰富的工具链,降低本地部署门槛,同时兼顾性能与隐私。其核心功能与特性如下。

1)本地化模型管理

Ollama提供了全面的模型管理功能,包括预建模型库、自定义模型集成和提示工程。

(1)预建模型库:提供丰富的预训练模型(如Llama 3、DeepSeek、Mistral等),支持一键拉取至本地,无需自行训练或寻找模型源。

(2)自定义模型集成:兼容多种模型格式,支持从PyTorch、Safetensors或第三方平台(如GGUF)导入模型,实现灵活扩展。

(3)提示工程:允许用户自定义提示模板,优化模型输出风格与内容精准性。

2)高效推理引擎

Ollama平台的高效推理引擎不仅支持硬件加速,还提供了资源可控的特性。

(1)硬件加速:支持GPU/CPU混合计算,优化显存与内存分配,适配从消费级设备到专业服务器的多种硬件环境。

(2)资源可控:轻量级架构确保低资源占用,同时允许通过环境变量(如 OLLAMA_NUM_GPU)动态调整并发数和计算设备。

3)全链路开发支持

Ollama平台提供了全面的全链路开发支持,包括多接口访问和环境变量配置。

(1)命令行工具(CLI):通过ollama run、ollama list等命令直接管理模型与交互。

(2)HTTP API:提供RESTful接口(默认端口11434),支持 Python、JavaScript 等语言集成。

(3)OpenAI兼容客户端:无缝对接OpenAI SDK,简化现有代码迁移。

(4)环境变量配置:通过OLLAMA_HOST、OLLAMA_MODELS等变量自定义服务地址、模型存储路径等。

4)跨平台与可扩展性

Ollama平台不仅支持多系统,还具备企业级扩展能力。

(1)多系统支持:提供macOS、Windows(预览版)、Linux及Docker的安装方案,覆盖主流开发环境。

(2)企业级扩展:支持与Open WebUI等工具集成,实现可视化交互、多用户权限管理、RAG增强等高级功能。

Ollama作为一个开源平台,可以轻松地在Windows和Linux平台上安装、配置和运行DeepSeek,从而充分利用其在自然语言处理和生成方面的强大能力。接下来将详细介绍如何在不同操作系统中通过Ollama部署DeepSeek大模型。

2.Windows平台下通过Ollama部署DeepSeek

部署DeepSeek前需要先安装Ollama,接下来详细介绍Ollama安装过程。

1)Ollama安装

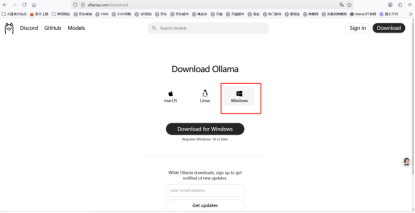

从Ollama官网下载Windows的安装包,地址是https://ollama.com/download,如图7-1所示。

图7-1 Ollama官网下载界面

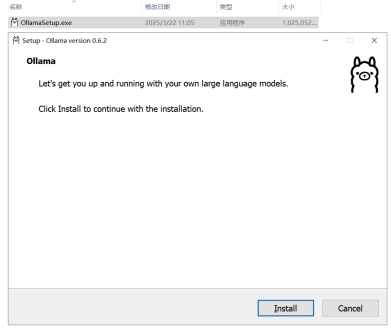

下载到本地电脑上,然后双击OllamaSetup.exe安装,安装提示如图7-2所示。

图7-2 Ollama安装首页

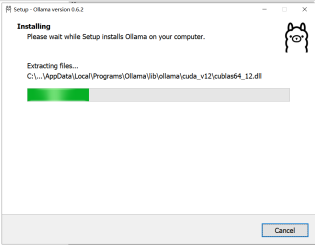

点击install按钮进行下一步的安装,默认安装在c盘,如图7-3所示。

图7-3 Ollama安装过程

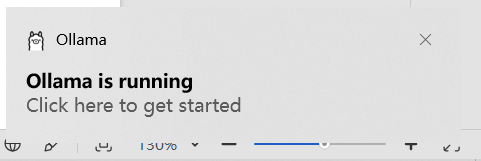

大概等待几分钟安装就完成了,安装成功会有一个提示Ollama is running,并会启动一个服务,电脑开机后会自动启动,提示如图7-4所示。

图7-4 Ollama服务运行提示

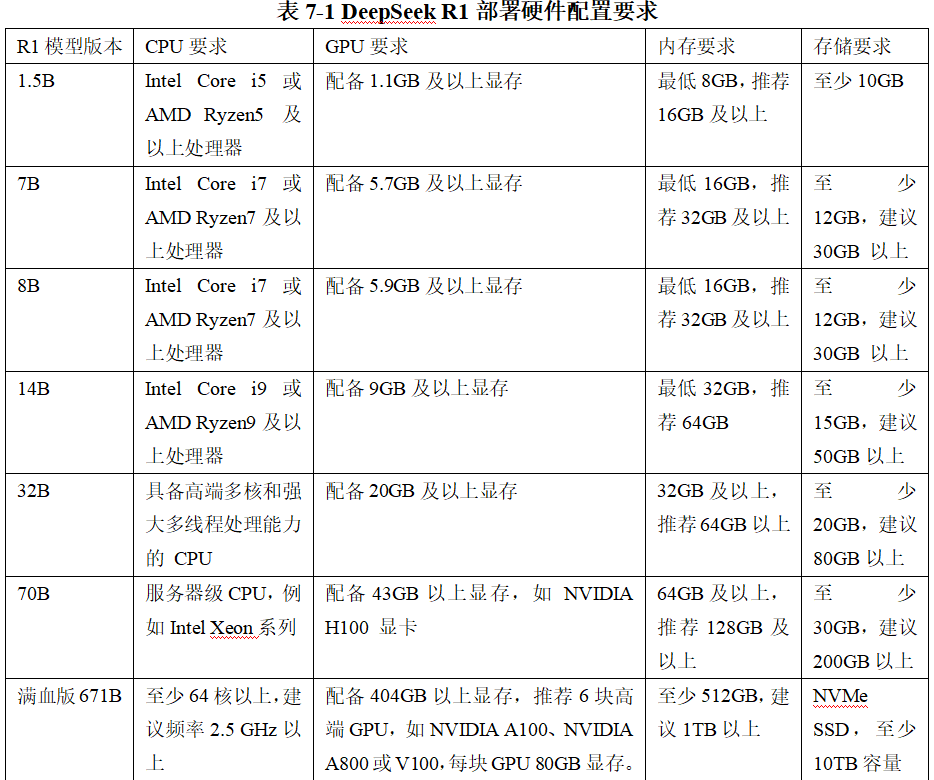

在深入运用Ollama工具时,你可通过命令行界面便捷地获取其相关信息。打开CMD控制台或Git Bash控制台,输入ollama --help命令,就能获取Ollama详细使用指南,输入 ollama --version,则能快速了解当前Ollama版本信息。命令信息如图7-5所示。

图7-5 Ollama命令

Ollama的默认模型存储路径如下:C:\Users%username%.ollama\models,无论C盘空间大小,需要安装多少模型,都建议换一个存放路径到其它盘,解决办法可设置环境变量的方式,设置步骤如下:

(1)Win+S 搜索环境变量→ 编辑系统环境变量;

(2)点击环境变量 → 系统变量 →新增;

(3)变量名为:OLLAMA_MODELS;

(3)变量值为:D:\DeepSeek\ollama\models;

(4)确定保存。

设置完成后需要重启下Ollama才能生效。Ollama安装完成后,接下来就是下载并部署DeepSeek大模型。

2)DeepSeek大模型部署

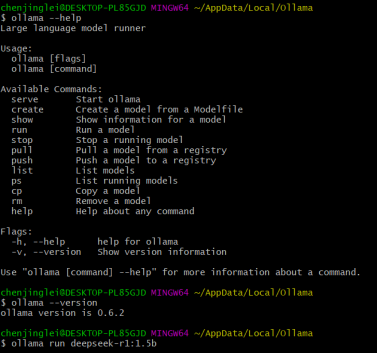

部署DeepSeek前需要选择要安装的版本,DeepSeek R1部署硬件配置要求见表7-1。

表7-1 DeepSeek R1部署硬件配置要求

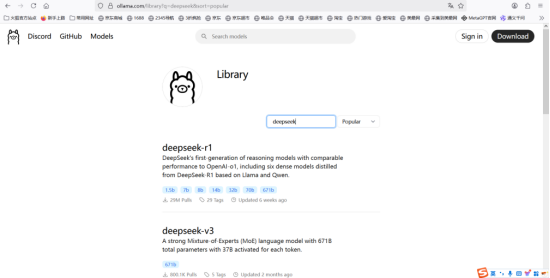

安装版本确定后,可以访问Ollama官网,访问https://ollama.com/library地址可看到所有支持的模型。可以搜索DeepSeek关键词找到Ollama支持的版本搜索,搜索页面如图7-6所示。

图7-6 Ollama支持的DeepSeek模型

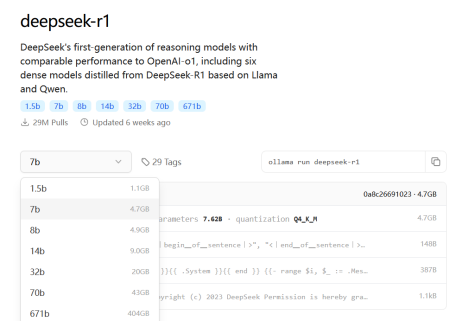

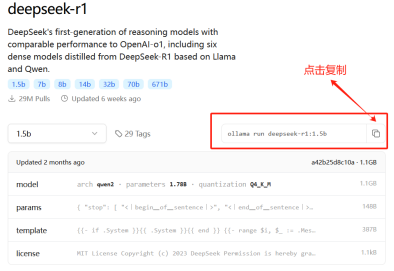

点击deepseek-r1跳转到详情页,有多个参数大小模型可以选择,如图7-7所示。

图7-7 支持的DeepSeek R1模型

比如选择最小的1.5b,会把对应的安装命令显示出来,1.5b对应的命令为:ollama run deepseek-r1:1.5b,满血版671b对应的ollama run deepseek-r1:671b。点击复制按钮,可以得到对应的部署命令,如图7-8所示。

图7-8 复制DeepSeek R1部署命令

然后在CMD控制台,或者Git Bash控制台输入命令ollama run deepseek-r1:1.5b,部署完会显示success成功提示,并且可以在控制台直接对话。通过ollama list可以看到部署了哪些模型,通过ollama rm qwen2:0.5b命令可以删除对应的模型。需要注意的是Ollama本身没有提供可以对话的Web界面,但提供了HTTP接口可以调用。如果访问http://localhost:11434/地址会返回Ollama is running的提示。可以通过Python代码调用部署好的DeepSeek模型,调用前需要通过pip3 install ollama命令安装ollama包,然后就可以通过ollama客户端工具来访问DeepSeek R1模型了,需要Python 3.8及以上版本,代码如下:

第7章/OllamaDeepSeekClient.py

从ollama库中导入Client类,用于与Ollama服务进行交互

from ollama import Client

创建一个Client对象,用于连接到本地运行的Ollama服务

host参数指定了Ollama服务的地址,这里使用的是本地地址,端口号为11434

client = Client(

host=‘http://localhost:11434’

)

调用Client对象的chat方法,向指定的模型发送聊天请求

response = client.chat(model=‘deepseek-r1:7b’, messages=[

{

‘role’: ‘user’, # 指定消息的角色为用户

‘content’: ‘您好’, # 指定用户发送的消息内容

},

])

打印模型返回的消息内容

print(response[‘message’][‘content’])

3.Linux平台下通过Ollama部署DeepSeek

在Linux环境中,可以通过执行以下命令,轻松一键安装Ollama:

curl -fsSL https://ollama.com/install.sh | sh

手动安装方式需要下载并解压安装包,命令如下:

curl -L https://ollama.com/download/ollama-linux-amd65.tgz -o ollama-linux-amd65.tgz

sudo tar -C /usr -xzf ollama-linux-amd65.tgz

然后通过以下命令启动服务:

ollama serve

服务启动后可以通过ollama -v查看安装版本。安装前如果存在旧版本,需先执行sudo rm -rf /usr/lib/ollama命令删除旧库。等Ollama安装好了,后面deepseek-r1部署和Windows平台类似,使用ollama run deepseek-r1:671b命令部署即可。Ollama本身没有提供可视化的Web大模型对话页面,但可以通过安装Open WebUI和Ollama集成,这样就可以通过Open WebUI对话页面和DeepSeek R1大模型对话了。

更多技术内容

更多技术内容可参见

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频【陈敬雷】。

更多的技术交流和探讨也欢迎加我个人微信chenjinglei66。

总结

此文章有对应的配套新书教材和视频:

【配套新书教材】

《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】

新书特色:《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)是一本2025年清华大学出版社出版的图书,作者是陈敬雷,本书深入探讨了GPT多模态大模型与AI Agent智能体的技术原理及其在企业中的应用落地。

全书共8章,从大模型技术原理切入,逐步深入大模型训练及微调,还介绍了众多国内外主流大模型。LangChain技术、RAG检索增强生成、多模态大模型等均有深入讲解。对AI Agent智能体,从定义、原理到主流框架也都进行了深入讲解。在企业应用落地方面,本书提供了丰富的案例分析,如基于大模型的对话式推荐系统、多模态搜索、NL2SQL数据即席查询、智能客服对话机器人、多模态数字人,以及多模态具身智能等。这些案例不仅展示了大模型技术的实际应用,也为读者提供了宝贵的实践经验。

本书适合对大模型、多模态技术及AI Agent感兴趣的读者阅读,也特别适合作为高等院校本科生和研究生的教材或参考书。书中内容丰富、系统,既有理论知识的深入讲解,也有大量的实践案例和代码示例,能够帮助学生在掌握理论知识的同时,培养实际操作能力和解决问题的能力。通过阅读本书,读者将能够更好地理解大模型技术的前沿发展,并将其应用于实际工作中,推动人工智能技术的进步和创新。

【配套视频】

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频【陈敬雷】

视频特色: 前沿技术深度解析,把握行业脉搏

实战驱动,掌握大模型开发全流程

智能涌现与 AGI 前瞻,抢占技术高地

上一篇:《GPT多模态大模型与AI Agent智能体》系列一》大模型技术原理 - 大模型技术的起源、思想

下一篇:DeepSeek大模型技术系列五》DeepSeek大模型基础设施全解析:支撑万亿参数模型的幕后英雄

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)