微软开源3大突破AI Agent模型

rStar2-Agent采用“非推理微调+多阶段强化学习”流程,显著降低训练成本。Azure OpenAI服务通过其大规模生成式AI模型,支持企业客户根据特定需求和场景,开发创新应用,涵盖辅助写作、代码编写、多媒体内容生成以及数据分析等多个领域,为互联网、游戏、金融、零售、医药等行业以及自动驾驶和智能制造等前沿技术领域带来深远影响。该模型基于智能体强化学习方法构建,参数量仅为140亿,却在多项基准

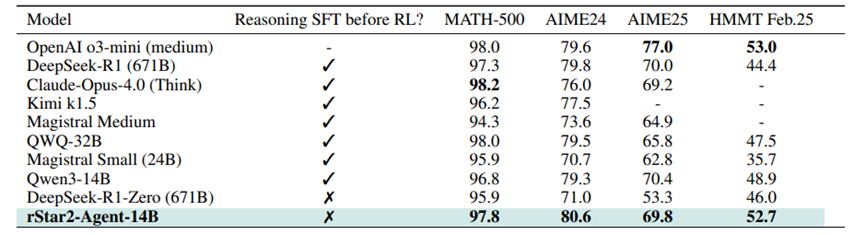

微软研究院近日开源了其新一代AI Agent推理模型rStar2-Agent。该模型基于智能体强化学习方法构建,参数量仅为140亿,却在多项基准测试中表现出卓越性能,尤其在数学推理任务上显著超越了参数规模大其48倍的DeepSeek-R1模型。

在AIME24数学推理测试中,rStar2-Agent达到了80.6%的准确率,优于DeepSeek-R1的79.8%。此外,该模型还展现出较强的泛化能力:在GPQA-Diamond科学推理基准上准确率为60.9%,高于DeepSeek-V3的59.1%;在BFCL v3智能体工具使用任务中完成率达到60.8%,同样超过DeepSeek-V3的57.6%。

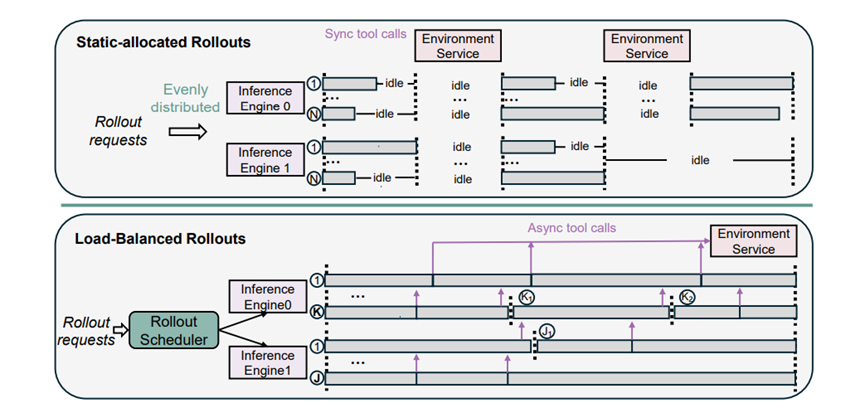

⚙️ 技术突破一:分布式训练基础设施

微软构建了高吞吐的代码执行环境,以支持大规模智能体训练。该基础设施部署于64台AMD MI300X GPU上,采用主节点-工作节点的分布式架构。主节点负责调度与任务打包,工作节点通过轻量级调度器管理1024个执行工作器,实现高效的负载均衡。这一设计可支持每训练步骤4.5万次并发工具调用,平均延迟仅为0.3秒,同时通过隔离机制保障训练稳定性。

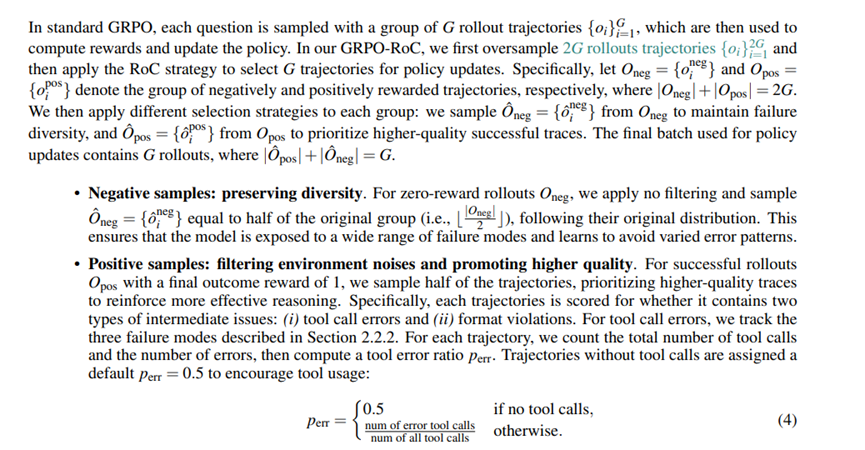

⚙️ 技术突破二:GRPO-RoC算法优化

为应对环境噪声和强化学习中的奖励误导问题,微软在GRPO算法中融合了Resample-on-Correct(RoC)策略。这一算法移除KL散度惩罚项、采用Clip-Higher策略,并取消熵损失项,鼓励模型探索有效推理路径的同时保持训练稳定性。RoC机制通过对正确轨迹进行重采样,筛选工具调用错误少、代码简洁的高质量响应,使工具错误率从15%降至5%以下,推理长度缩短30%。

⚙️ 技术突破三:多阶段强化学习训练流程

rStar2-Agent采用“非推理微调+多阶段强化学习”流程,显著降低训练成本。前期使用Tulu3和LLaMA-Nemontron数据集进行指令遵循和工具调用格式的统一微调。后续强化学习分为三个阶段,逐步提升响应长度和问题难度,最终在AIME24和AIME25准确率分别达到80%和69.8%。整个训练仅用64台GPU,历时1周共510步迭代。

该研究展示了智能体强化学习在复杂推理任务上的潜力,其核心优势在于模型能够与工具环境交互,基于反馈动态调整推理过程,从而减少中间错误并提升泛化能力。

作为微软中国南区核心合作伙伴及HKCSP 1T首批授权云服务商之一,领驭科技正积极整合Azure OpenAI的强大功能,包括先进的自然语言处理、分析和推理能力,到其产品和行业解决方案中。

Azure OpenAI服务通过其大规模生成式AI模型,支持企业客户根据特定需求和场景,开发创新应用,涵盖辅助写作、代码编写、多媒体内容生成以及数据分析等多个领域,为互联网、游戏、金融、零售、医药等行业以及自动驾驶和智能制造等前沿技术领域带来深远影响。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)