手把手教你用LangBot+Dify搭建任意平台的智能聊天机器人

本项目是在本地把Dify、RAGFlow、LangBot串成一条「私有企业级智能客服链路」,让微信群、飞书群、Discord、Slack、公众号、企业微信等所有常见聊天平台,都共享同一套完全本地部署、零依赖第三方SaaS的智能客服大脑。

项目介绍

本项目是在本地把Dify、RAGFlow、LangBot串成一条「私有企业级智能客服链路」,让微信群、飞书群、Discord、Slack、公众号、企业微信等所有常见聊天平台,都共享同一套完全本地部署、零依赖第三方SaaS的智能客服大脑。

-

Dify:既能驱动大模型,又能用可视化画布把「知识检索 → 业务接口 → 状态记忆 → 消息回复」整条链路编排成一个可热更新的智能体

-

RAGFlow:负责 Embedding、召回与重排,保证知识库实时、精准、可溯源

现在只需再补上一块拼图——LangBot。它只做一件事:把各平台的事件协议翻译成Dify的HTTP调用,再把 Dify 智能体的回答原路推回去。整套体系继续跑在同一Docker Compose 网络dify-network里,新增一个langbot服务容器即可,无须外网SaaS、无须额外账号。

完成后,你得到的不是一个简单的问答机器人,而是一个真正的「本地企业客服中心」:

-

知识侧:向 RAGFlow 扔文档即可秒级生效,无需重启

-

业务侧:Dify 画布里的工具节点能实时查订单、调 API、发邮件,甚至把多轮对话状态写回内部数据库

-

渠道侧:LangBot 负责把同一套大脑同时挂在 N 个平台,对话日志全部留在本地硬盘,满足最严苛的合规与隐私要求。

一、安装Docker、Dify

具体操作详见保姆级教程!超详细Dify+RAGFlow从部署到集成,小白也能轻松实践,速藏!同时要在Dify里提前创建好智能体/工作流。

二、安装LangBot

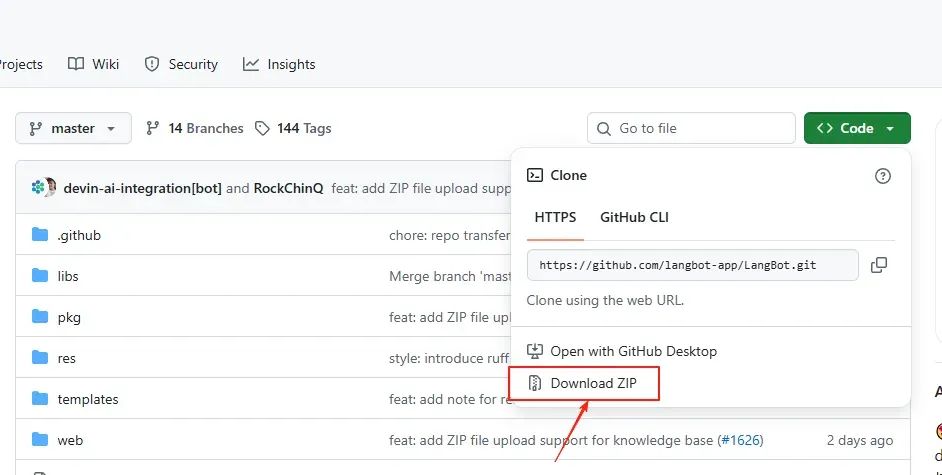

1、下载LangBot并解压

https://github.com/langbot-app/LangBot

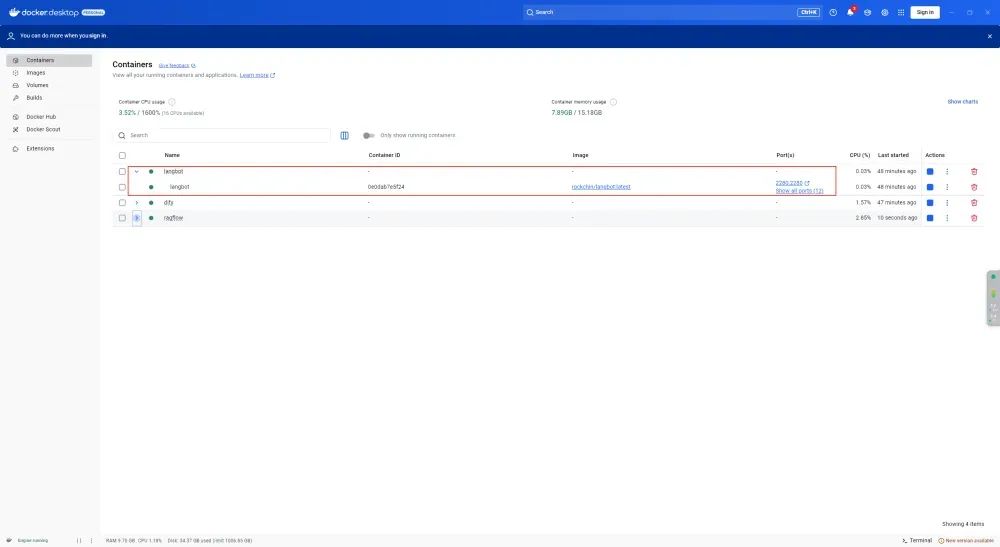

2、安装Docker镜像

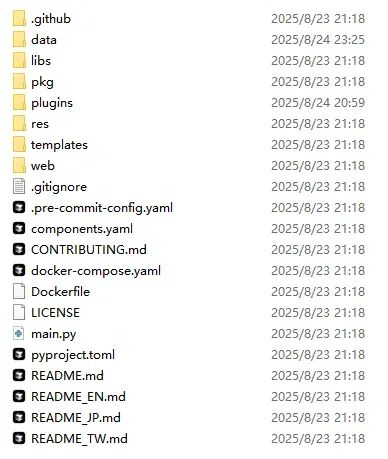

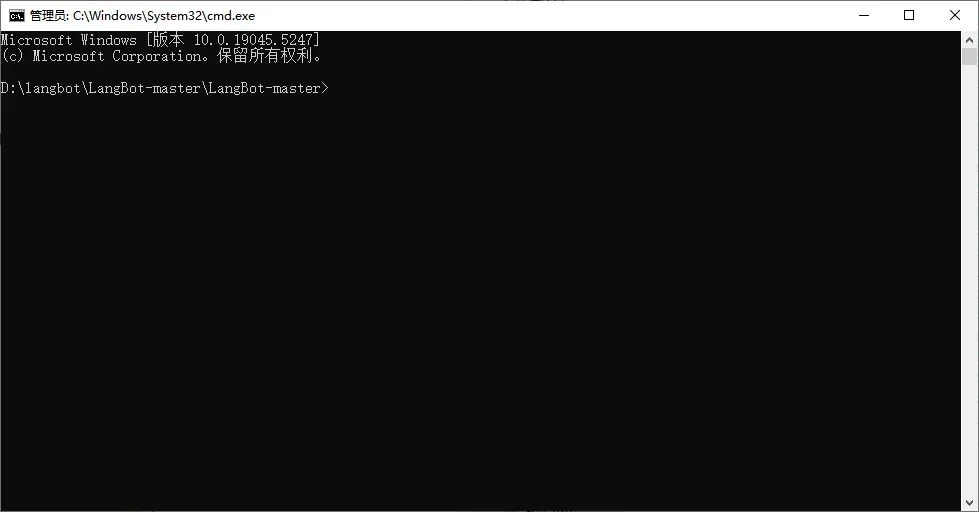

(1)进入LangBot-master文件,选中文件路径输入cmd+回车

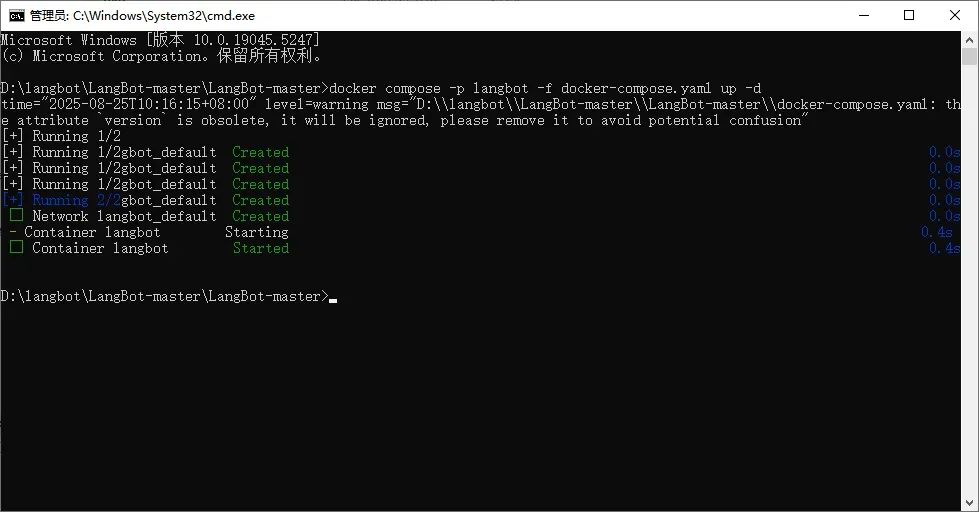

(2)安装镜像

docker compose -p langbot -f docker-compose.yaml up -d

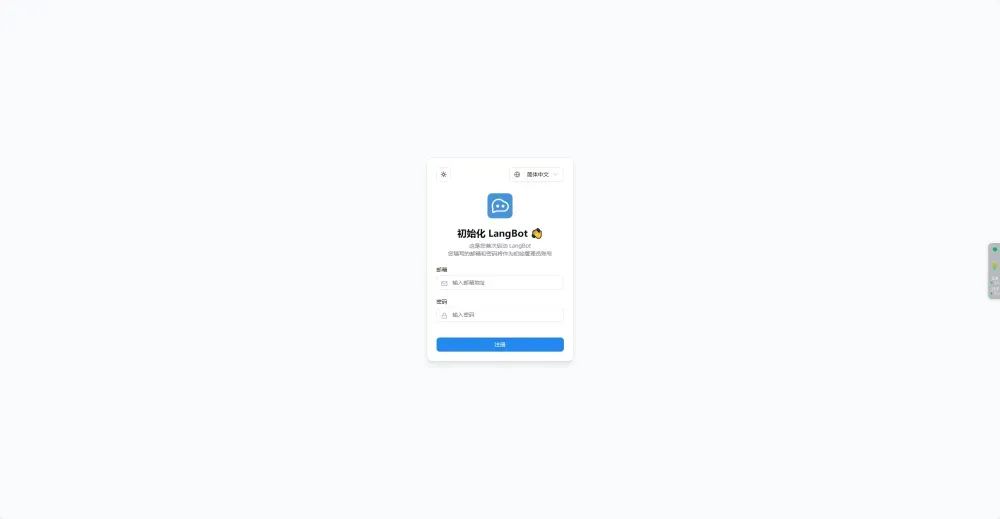

3、打开LangBot

(1)在浏览器中输入http://localhost:5300/register,注册账号进行登录

三、将LangBot和Dify设置在同一网络下【重要!!!】

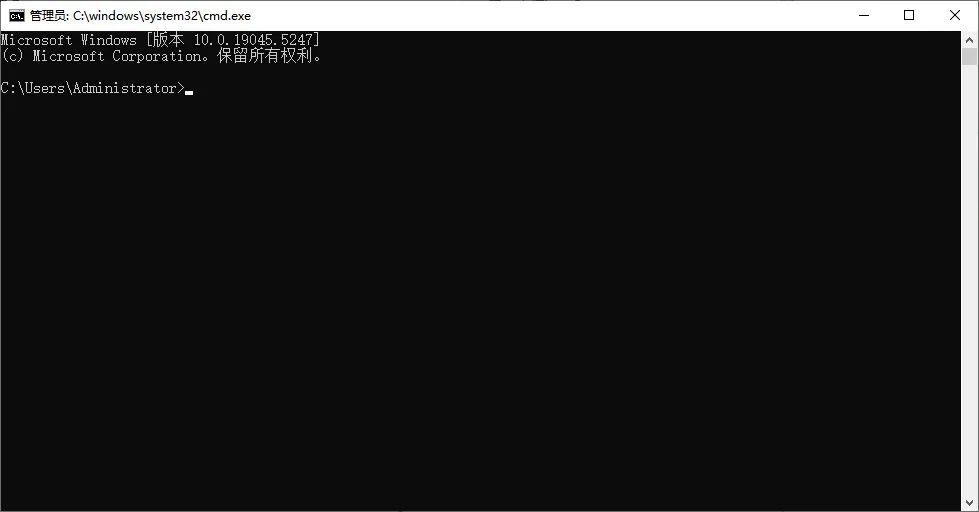

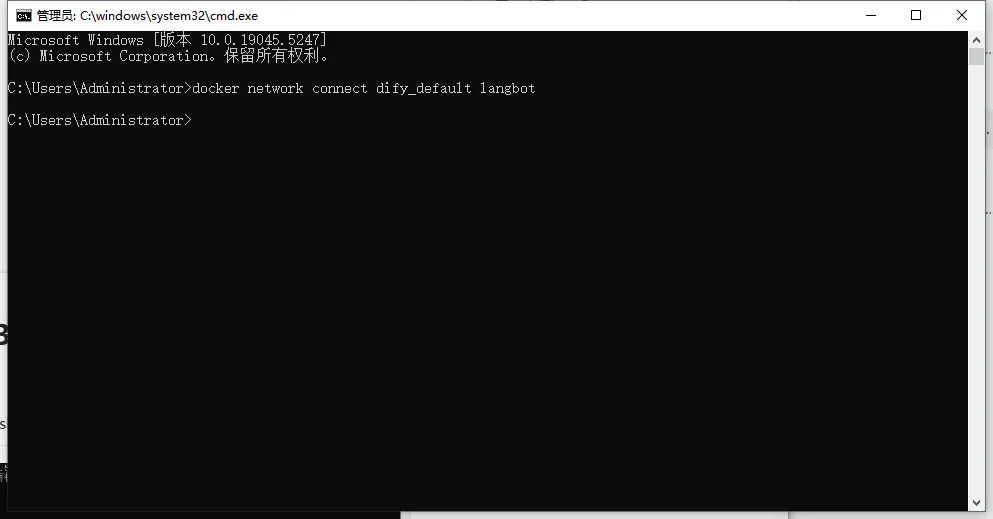

(1)打开cmd或powershell

(2)输入命令把LangBot容器挂到Dify网络

docker network connect dify_default langbot

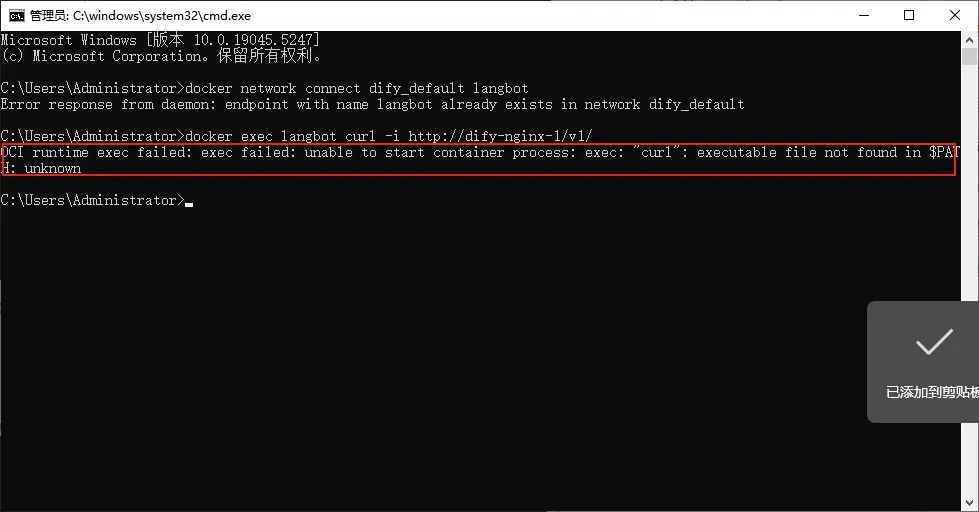

(3)验证网络已通

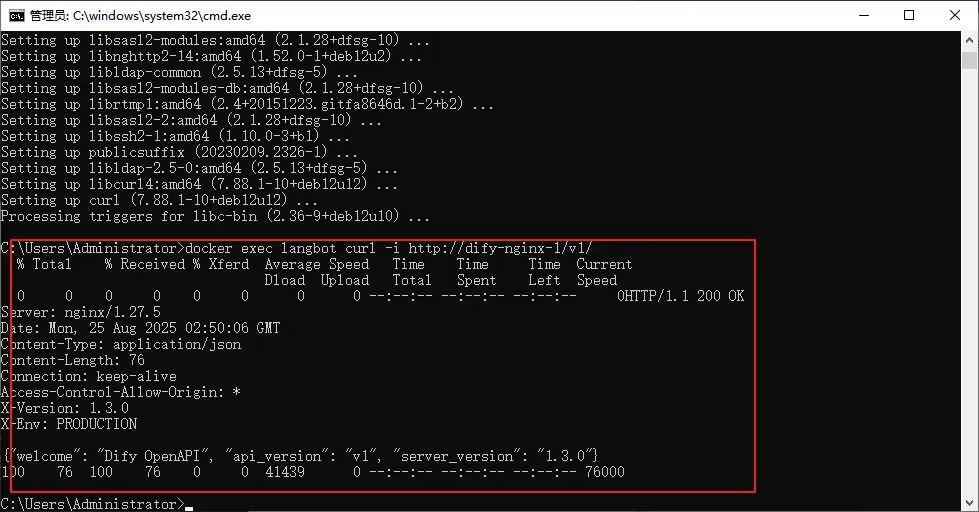

docker exec langbot curl -i http://dify-nginx-1/v1/

如果提示curl没有安装,则需要安装

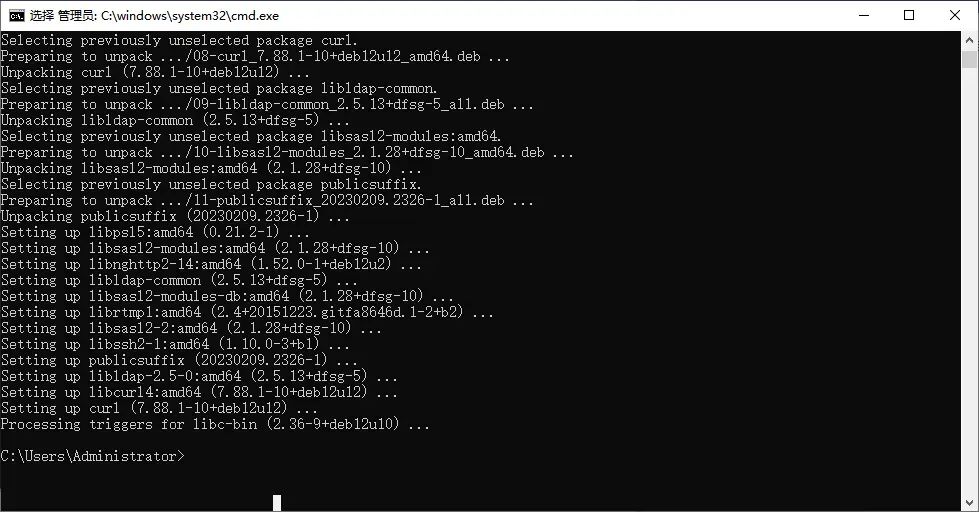

(4)安装curl

docker exec -u 0 langbot sh -c "

apt-get update -qq && apt-get install -y curl || \

apk add --no-cache curl"

(5)安装好后重新验证网络,出现下图则为网络已通

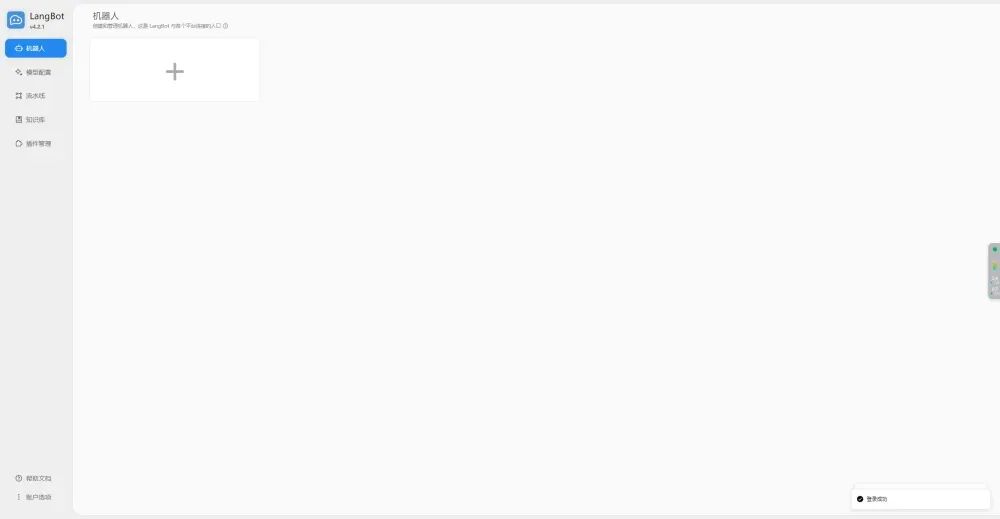

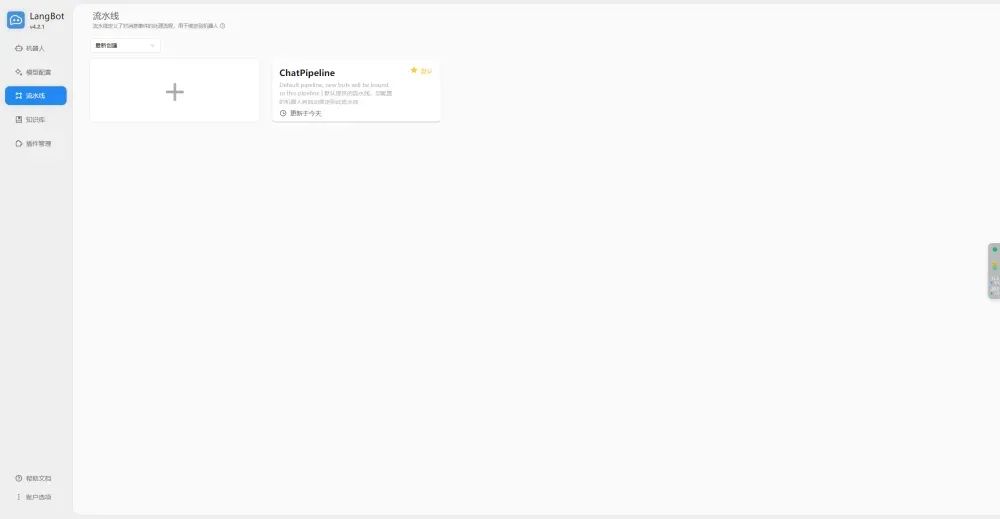

四、配置LangBot流水线(附调试办法)

1、创建

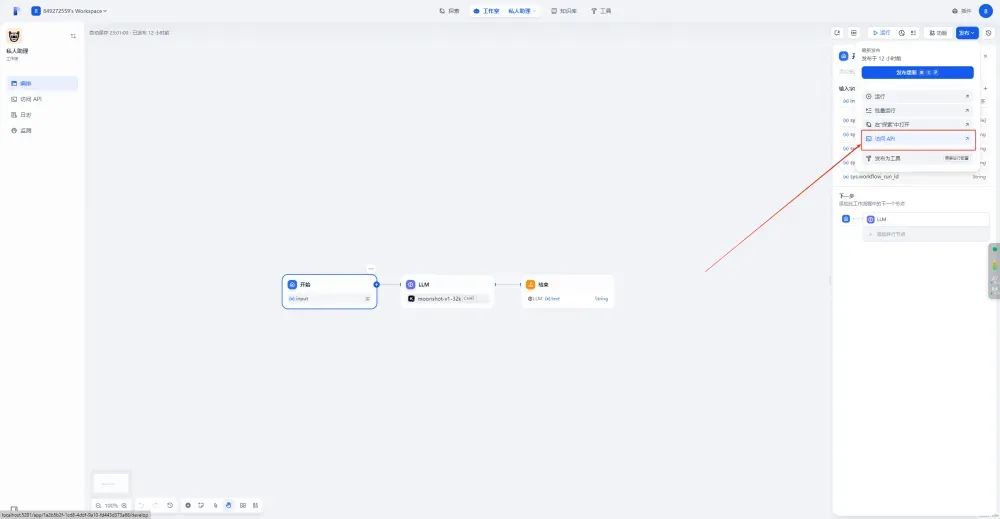

2、编辑

(1)选择运行器为Dify服务

(2)基础URL为http://dify-nginx-1/v1/

(3)应用类型:根据在Dify中创建的应用类型选择。【注意!!!】如果使用的是工作流,输出变量一定要为summary;如果自己创建了输入变量,不要选择必填

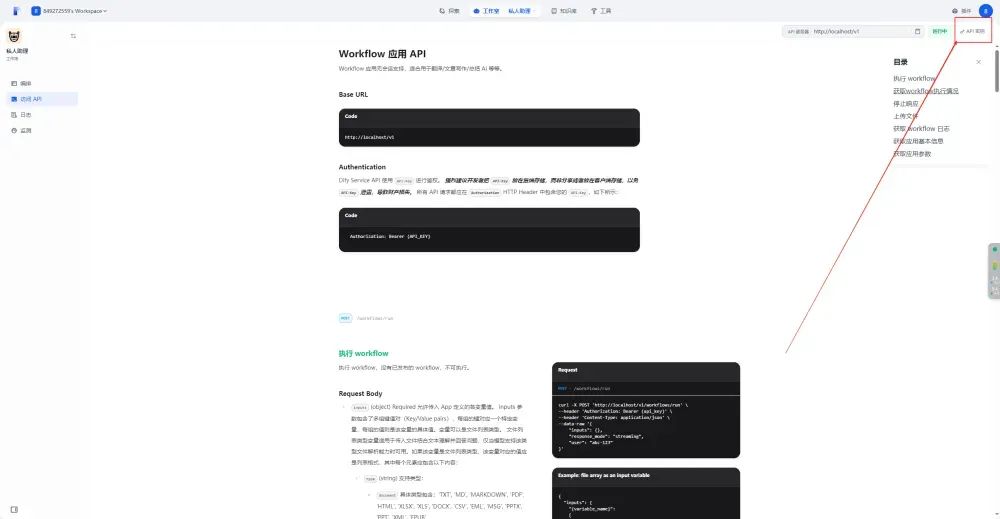

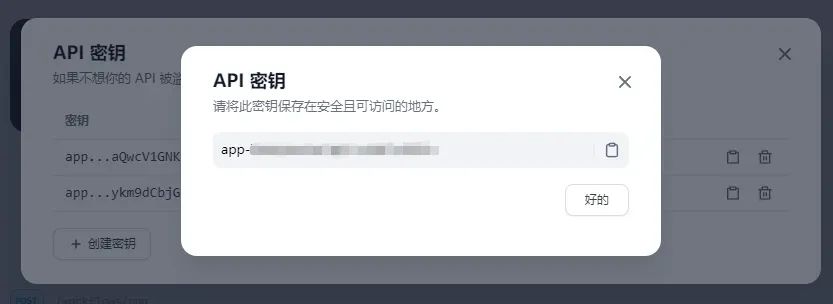

(4)API密钥:在Dify中访问API,并创建密钥

3、对话调试

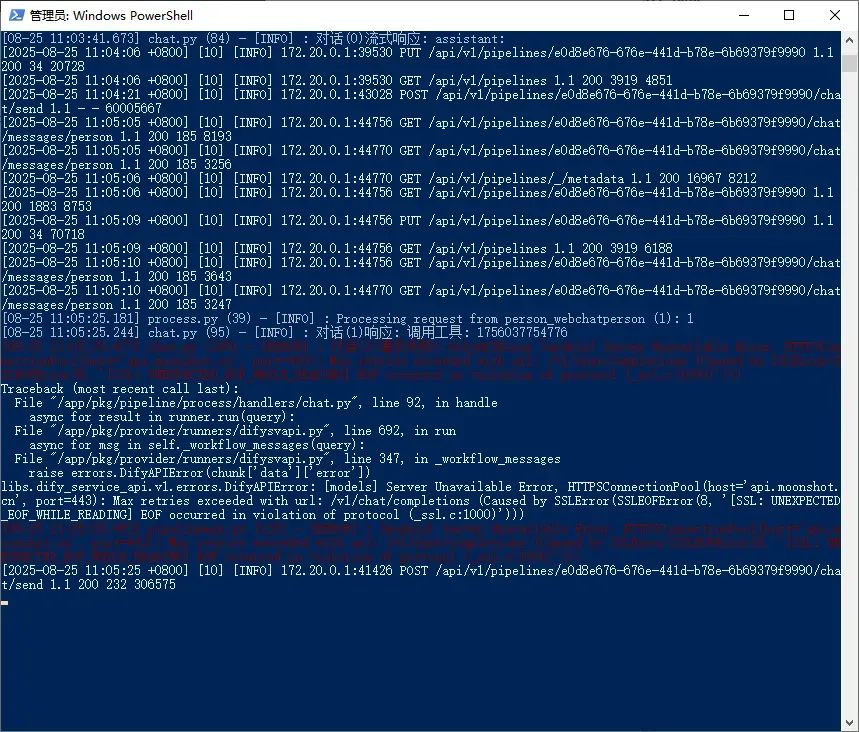

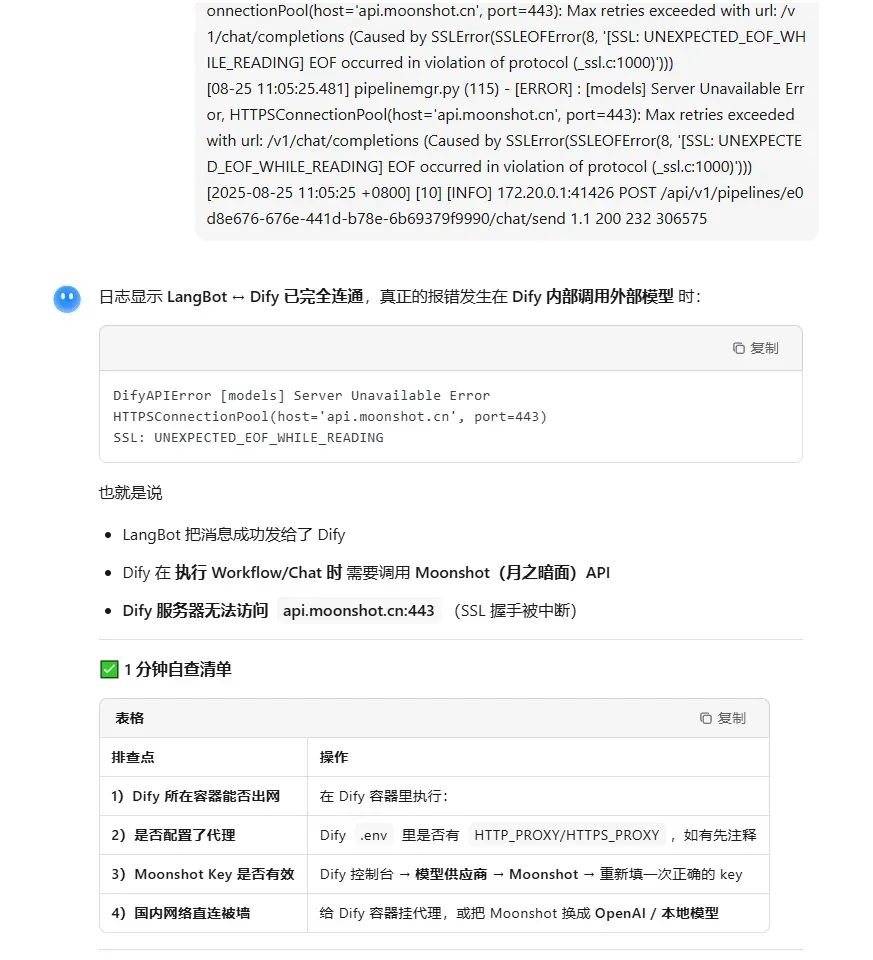

(1)检查是否能够连接Dify,如果提示请求失败,则打开日志工具将问题发送给AI(关闭流式传输效果可更快看到)

(2)win+x打开powershell,打印最近50条日志,将报错信息发给AI分析

docker logs --tail 50 -f langbot

(3)每个机器的问题都不一样,根据AI的建议一步一步解决直至调通

至此,LangBot 与 Dify 的本地链路已打通;下一步,把 LangBot 作为统一网关,让它去对接微信、飞书、Discord 等各外部通讯系统即可。

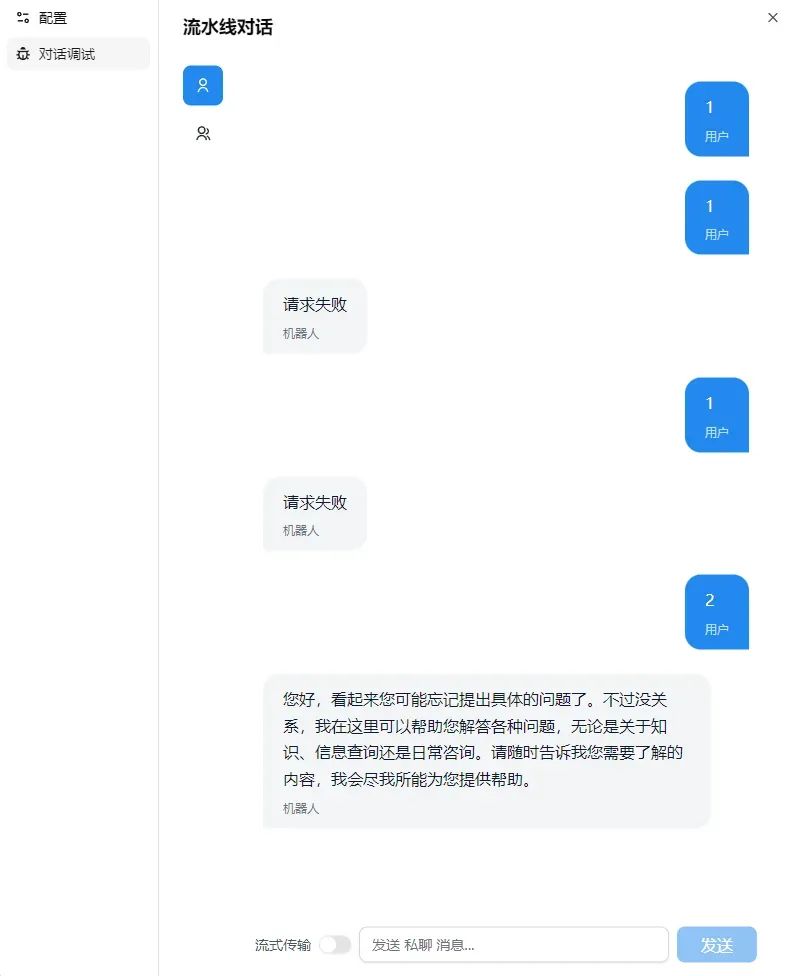

五、创建机器人【以钉钉为例】

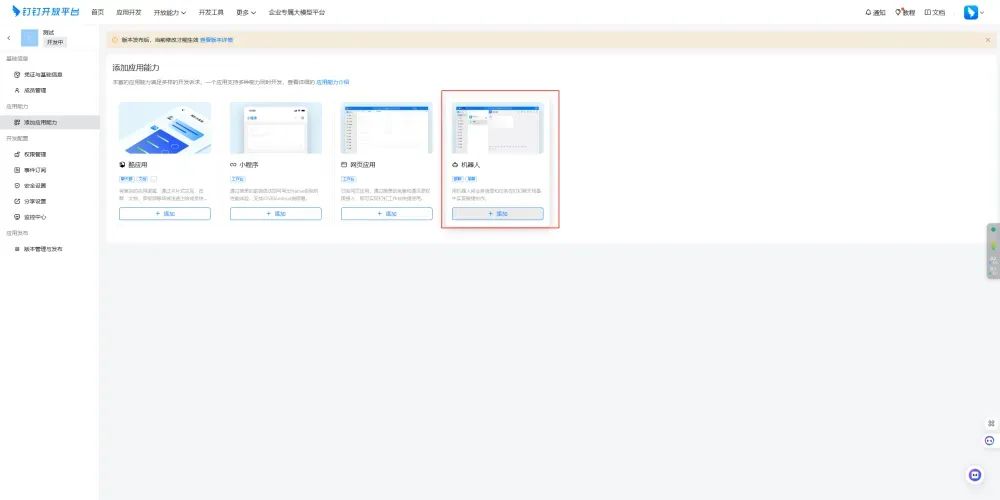

1、进入钉钉开发后台创建应用(需要是企业管理员)

(1)创建应用

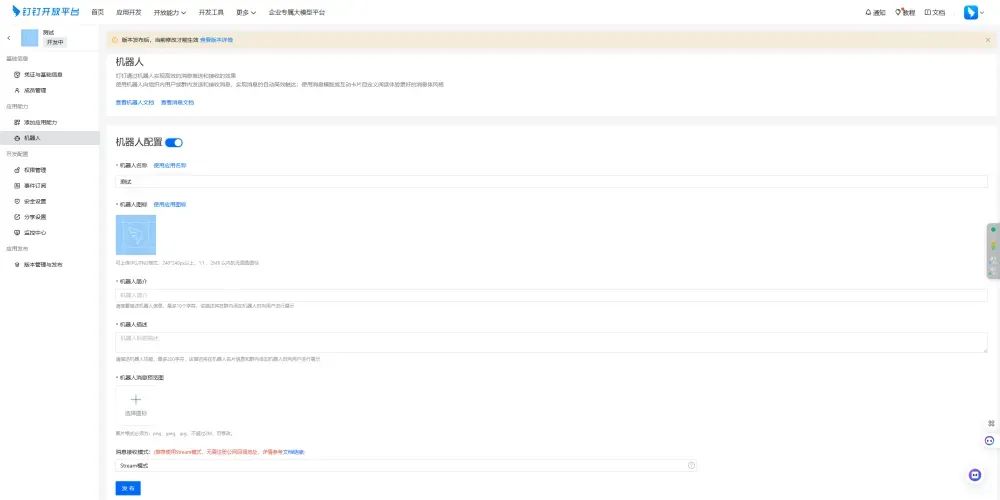

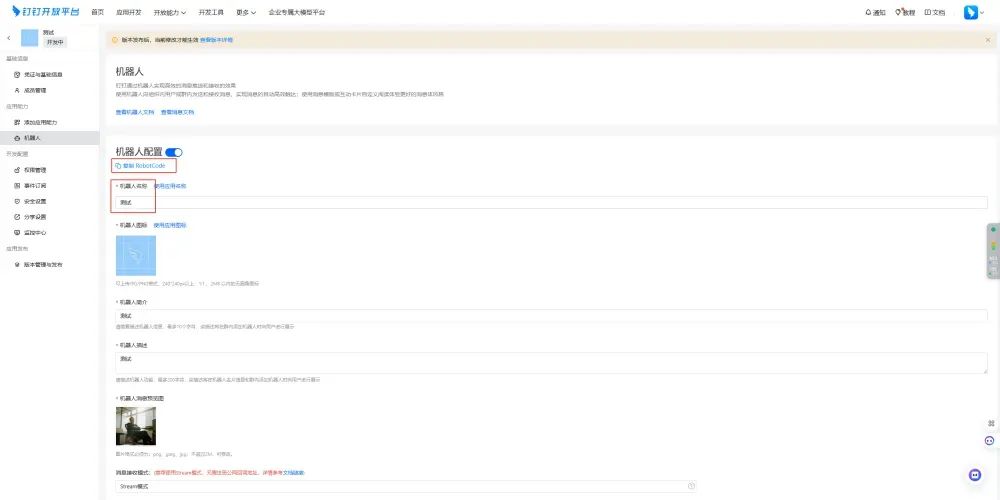

(2)添加机器人并发布:消息接收模式为Stream

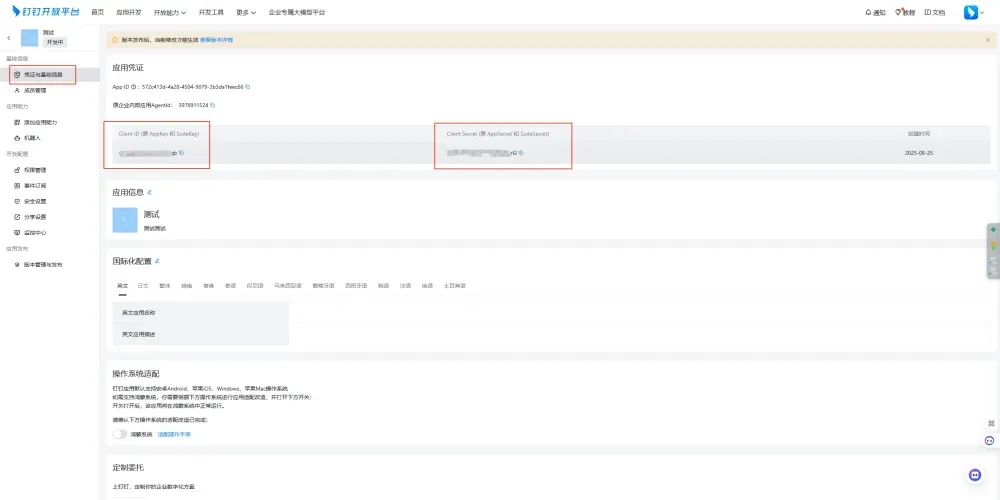

(3)记住四个值:RobotCode、机器人名称、Client ID、Client Secret

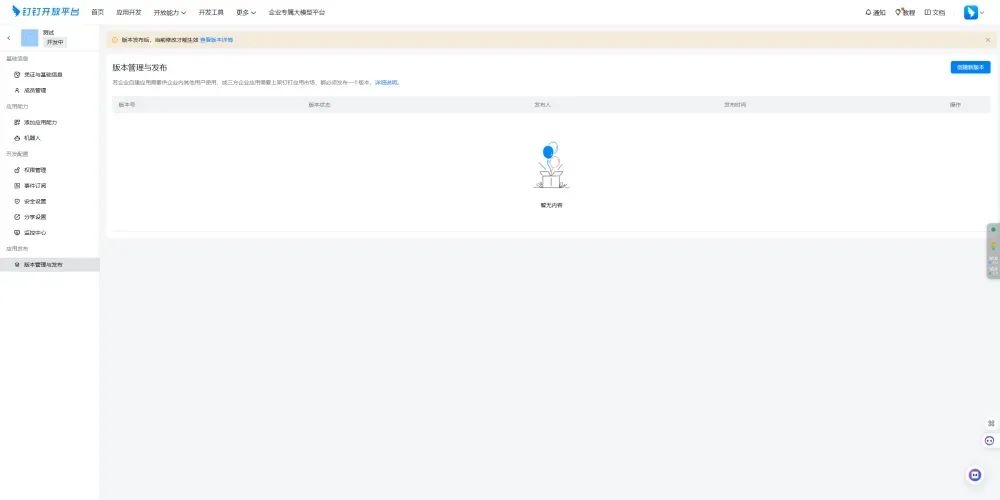

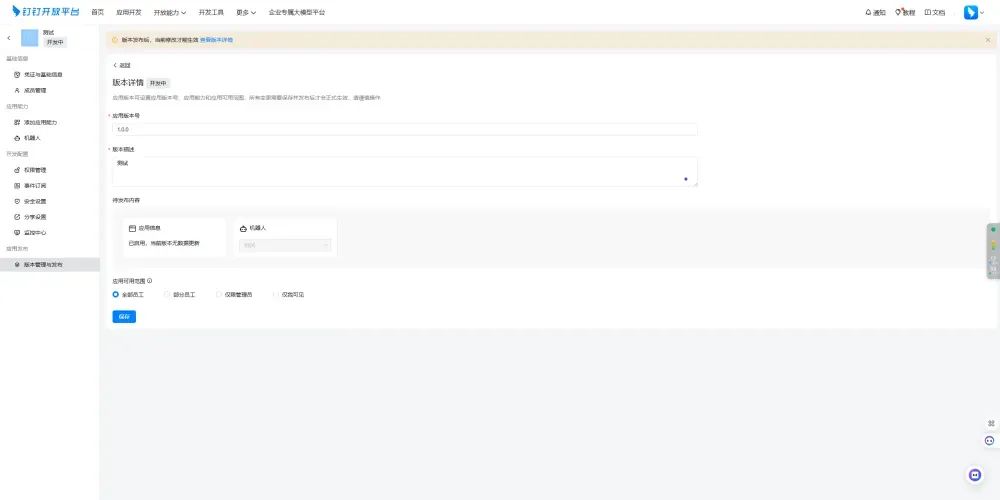

(4)创建版本:发布版本后该应用才为上线状态

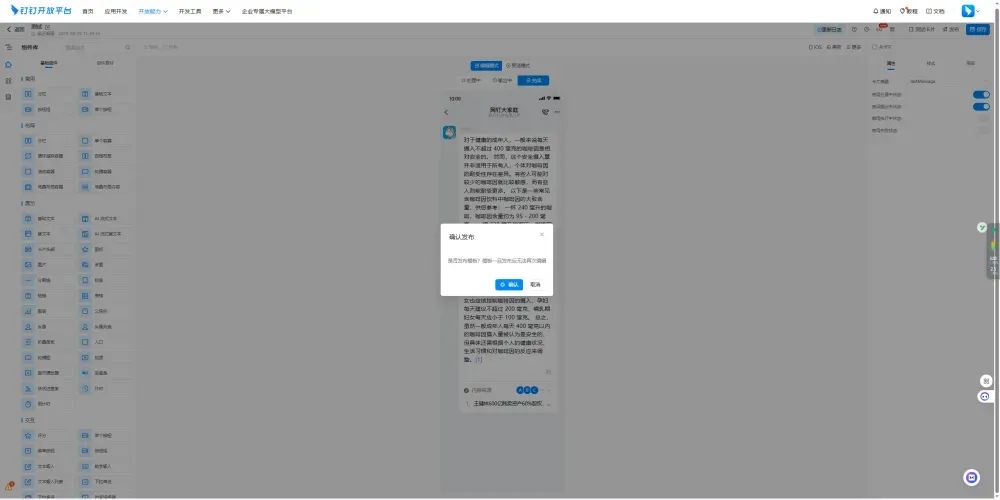

2、进入钉钉后台创建卡片(如果不需要机器人流式输出则可跳过)

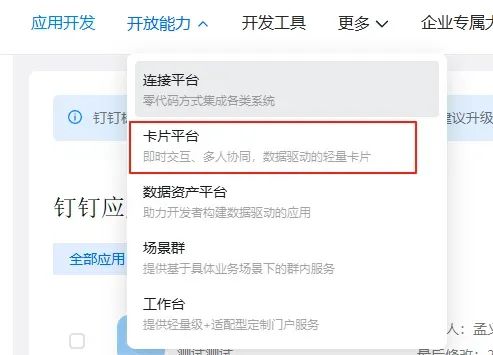

(1)进入开放能力-卡片平台

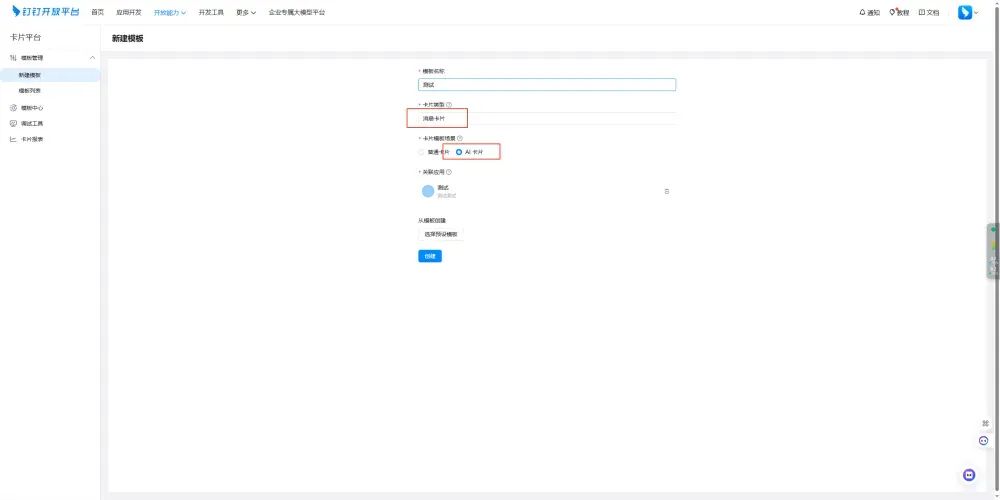

(2)新建模板:注意要选AI卡片,预设模板选择第一个即可

(3)不用编辑直接发布模板

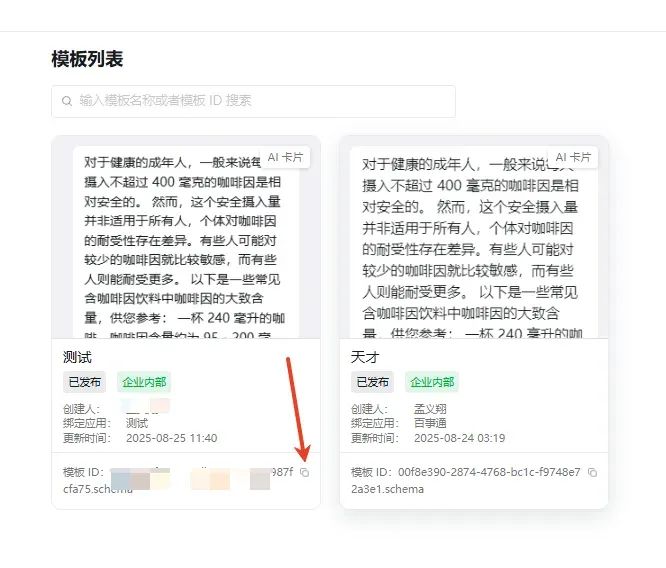

(4)记住模板ID

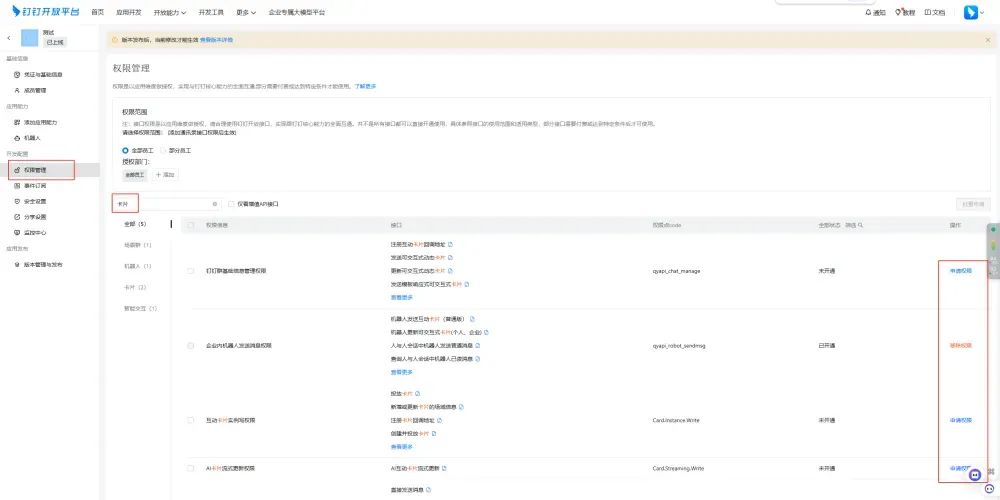

(5)进入刚刚创建的应用里开通全部卡片权限

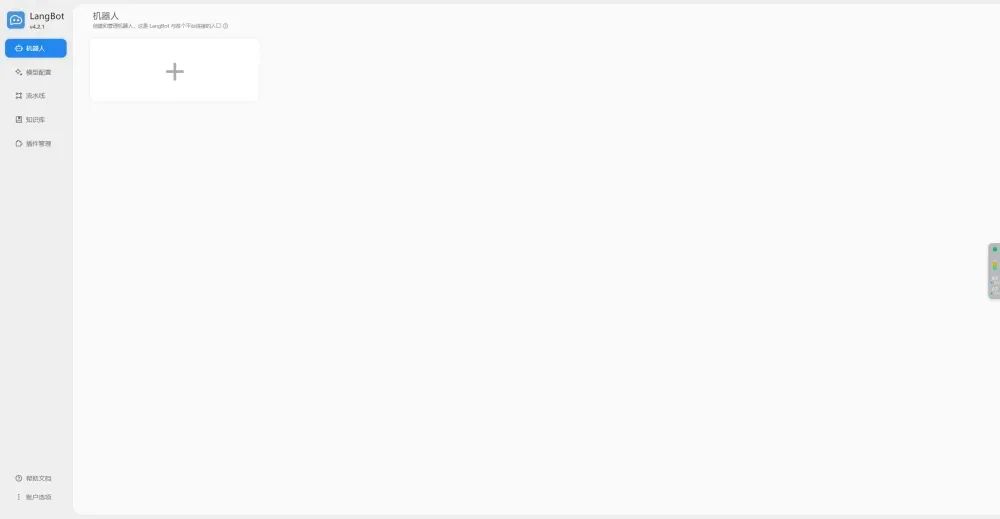

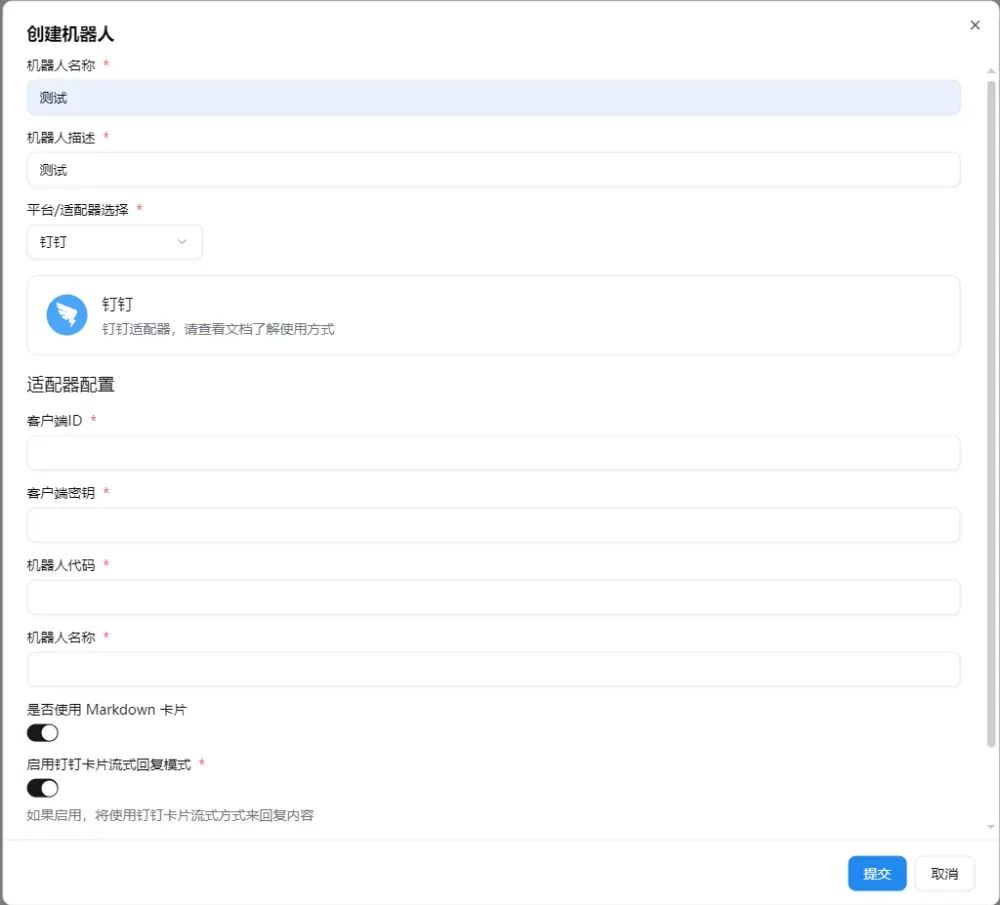

3、进入LangBot创建机器人

(1)创建:客户端ID(Client ID)、客户端密钥(Client Secret)、机器人代码(RobotCode)、机器人名称、卡片模板ID

(2)选择之前配置好的流水线并启用机器人

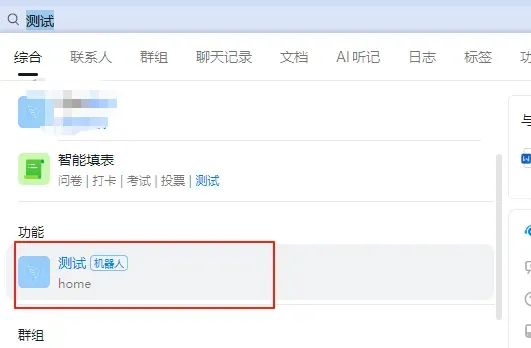

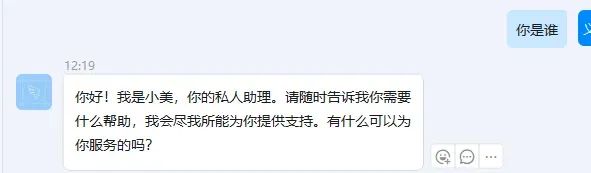

六、钉钉添加机器人

(1)直接搜机器人的名字就可以搜到(如果搜不到就从钉钉开放后台进入刚刚的应用再发布一个版本)

(2)也可以将机器人加入到群聊里,通过@机器人的方式进行对话

(3)根据我的测试,在实际使用中,有以下两个小点需要注意:

①如果Dify是工作流类型,要关闭流式输出,不然一直没响应(不知道为什么),如果是智能体则可正常流式输出;

②如果改变langbot中机器人配置(比如关闭流式输出),需要在钉钉群里把原机器人删除再重新添加才可生效,私聊是可以直接生效的。

至此,本地智能客服链路已完整就绪:RAGFlow 负责知识、Dify 负责智能体与业务流程、LangBot 负责把各平台消息原样转进来——数据不出内网,日志全部归你。随时往 RAGFlow 扔文档、在 Dify 画布拖节点、给 LangBot 加平台,无需重启即可生效。祝你用得开心!

大模型算是目前当之无愧最火的一个方向了,算是新时代的风口!有小伙伴觉得,作为新领域、新方向人才需求必然相当大,与之相应的人才缺乏、人才竞争自然也会更少,那转行去做大模型是不是一个更好的选择呢?是不是更好就业呢?是不是就暂时能抵抗35岁中年危机呢?

答案当然是这样,大模型必然是新风口!

那如何学习大模型 ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。但是具体到个人,只能说是:

最先掌握AI的人,将会比较晚掌握AI的人有竞争优势。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

但现在很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习路线完善出来!

在这个版本当中:

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型路线+学习教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

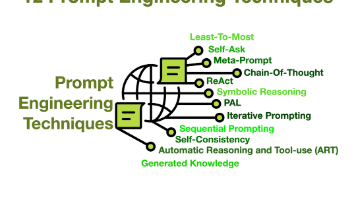

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

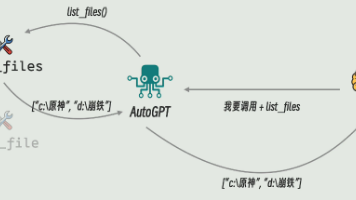

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)