查看spark任务日志的几种方式

spark运行的任务往往通过web来查看,但是,当运行的是sparkStreaming任务时,日志往往会很大,web查看并不方便,因此需要定位到服务器上去看。下面将分别介绍两种查看driver端和executor端日志的方式。一、web端日志的查看:下面是四个yarn调度spark任务的web总界面:点击第一个任务:application_1509845442132_3866 进入下面界

spark运行的任务往往通过web来查看,但是,当运行的是sparkStreaming任务时,日志往往会很大,web查看并不方便,因此需要定位到服务器上去看。下面将分别介绍两种查看driver端和executor端日志的方式。

一、web端日志的查看:

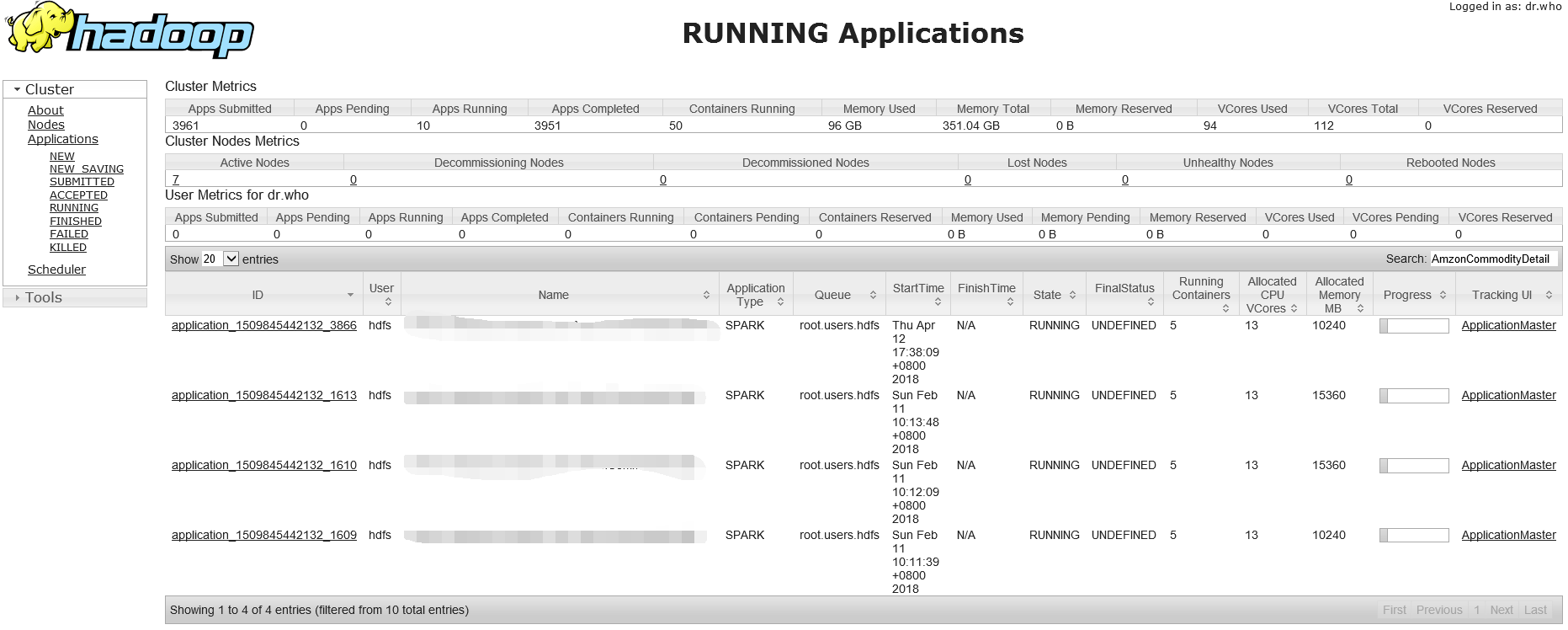

下面是四个yarn调度spark任务的web总界面:

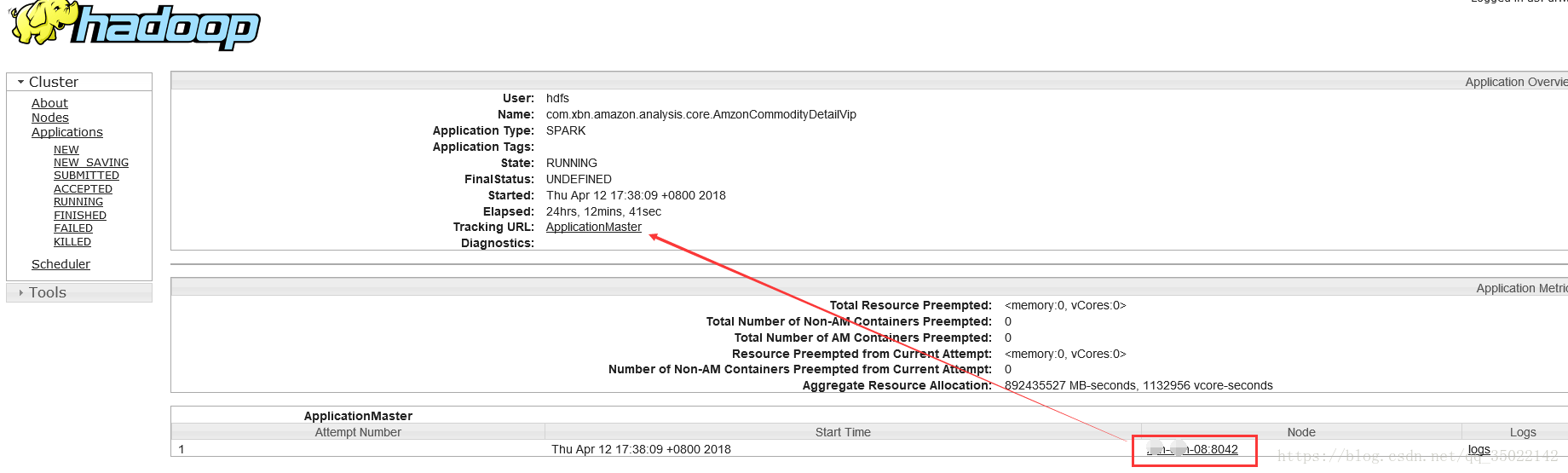

点击第一个任务:application_1509845442132_3866 进入下面界面,右下角记录的日志其实就是driver端的日志,driver端在打了马赛克的那个节点上。

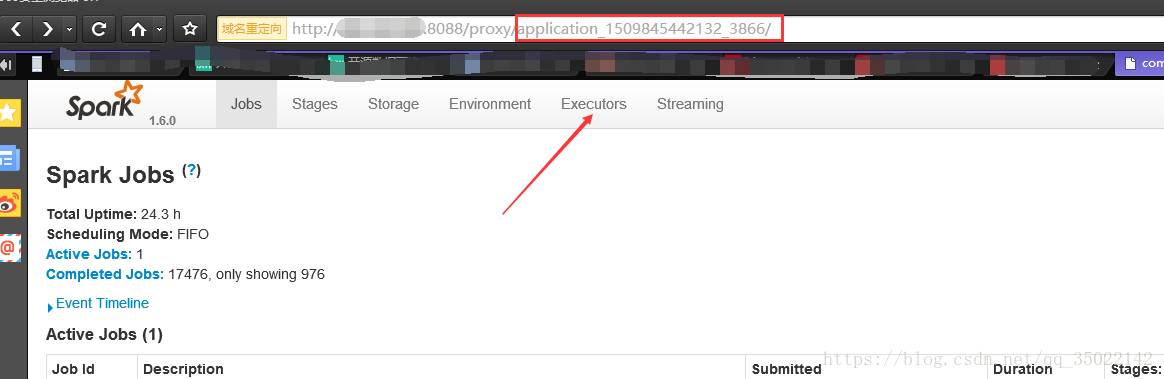

另外我们还可以查看executor节点上的日志。上图打开applicationMaster将跳转到spark的任务调度总界面

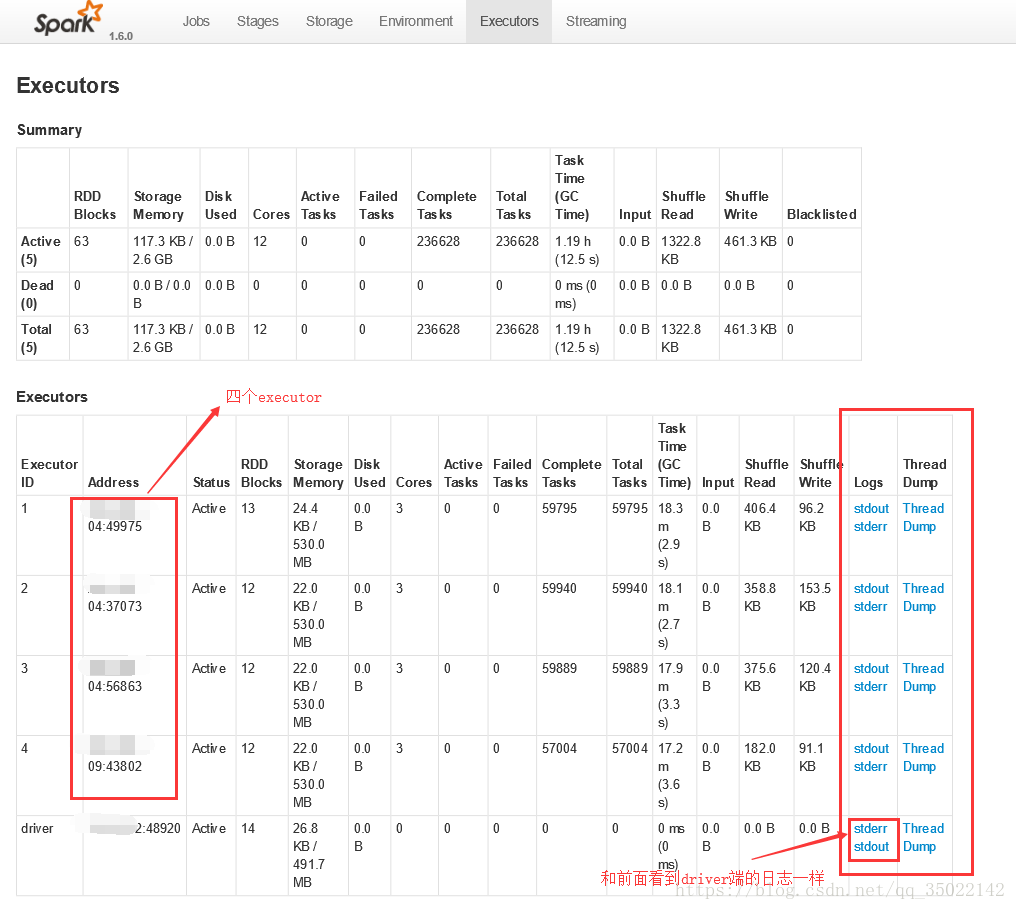

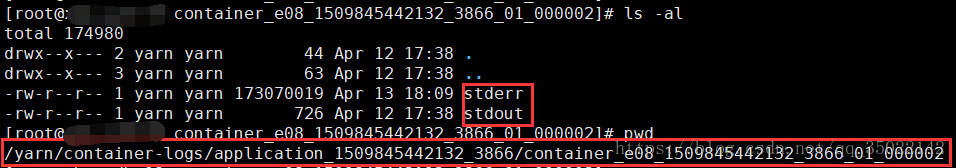

点开executor后可以看到四个executor,和一个driver。日志见右侧。stdout是自己定义println的输出日志,stderr是spark输出的规范日志。

二、服务器端日志查看

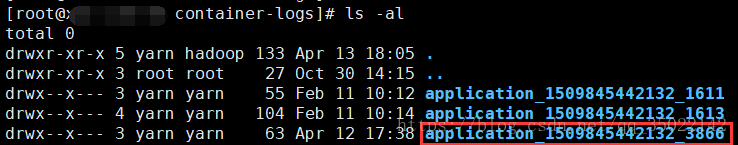

sparkStreaming的任务日志往往很大,web查看并不方便。因此需要我们定位到服务器上查看。前面web可以看到那个节点是driver。driver端的日志一般在如下目录:/yarn/container-logs/

万一不知道具体在哪个目录,可以直接find下: find / -name "application_1509845442132_3866"

对应的executor日志同样用此方式在服务器上找。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)