一文读懂生成式AI:大模型工作原理、应用场景与未来趋势!

生成式AI(GenAI)是AI的重要分支,能创造全新内容。文章系统介绍了其发展历程、核心模型(GANs、VAEs、Transformer、扩散模型)及工作原理,分析了其优势与挑战。GenAI正在深刻改变内容创作、商业运营和科学研究,未来将向自主智能体、多模态融合和可信赖性方向发展。理解并有效驾驭这一技术,是迎接AI驱动未来的必要准备。

前言:在短短几年间,人工智能(AI)的版图经历了翻天覆地的变化,而生成式人工智能(Generative AI,简称GenAI)无疑站在了这场变革的最前沿。它利用生成对抗网络(GANs)、变分自编码器(VAEs)、扩散模型(Diffusion Models)和Transformer架构等技术,学习数据中隐藏的模式以创造全新内容,如文本、图像、音乐、代码甚至蛋白质系列。自2020年代全面崛起(如ChatGPT),GenAI已展现出自动化知识工作的巨大潜力。然而,随之而来的是模型生成虚假信息(“幻觉”)、数据偏见、知识产权争议,以及高昂资源需求等挑战。深入理解其原理与边界,是驾驭这一颠覆性技术的必要前提。

自2022年底ChatGPT横空出世以来,生成式人工智能(GenAI)已成为全球科技界和公众热议的焦点。这项技术的能力,已经远远超出了传统计算机“按部就班”执行指令的范畴。它不再仅仅是用来检测欺诈或规划路线的工具,而是一个可以创造出前所未有内容——无论是文案、诗歌、音乐、软件代码、精美图像还是逼真视频甚至蛋白质序列——的数字创作者。

那么,这种“创造力”的本质是什么?它如何突破了传统技术的限制?本文将揭示生成式AI背后的核心工作原理、主要的模型类型,以及我们在享受其便利的同时,必须正视的挑战与未来方向。

一、什么是生成式AI?

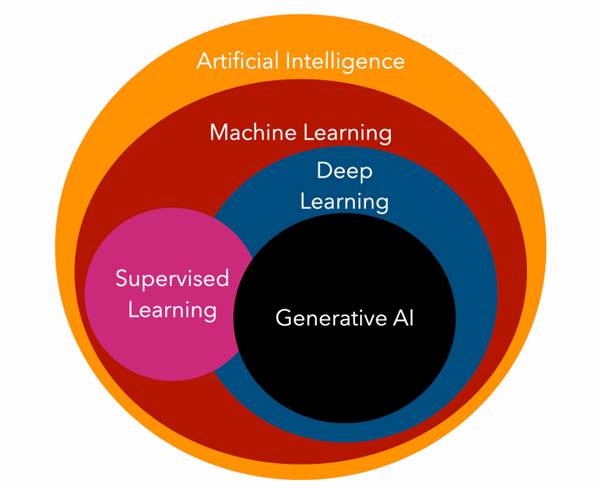

生成式人工智能(Generative AI,简称GenAI),是人工智能领域中一个特殊的子集。如果说传统AI的主要任务是“识别”和“分类”(比如判断图片里是猫还是狗,或者识别信用卡欺诈),那么生成式AI的核心能力在于“创造”和“生成”全新的内容。

简单来说,生成式AI是一种机器学习技术,它使用生成模型(Generative Models) 来学习训练数据的潜在的模式、结构和概率分布。一旦模型学会了这些模式,它就可以根据用户的输入(通常是自然语言提示词,即****Prompt) 来生成文本、图像、音频、视频、软件代码或其他形式的全新数据。

这种技术的神奇之处在于,它能够通过推断训练数据中的规律,生成出看似由人类创作的、新颖且原创的内容。

生成式AI之所以能够产生如此广泛且新颖的内容,部分原因在于其训练方式:它通常使用无监督学习(unsupervised learning)或半监督学习进行训练,这让大型神经网络得以训练,而无需人工手动标记数据。相比之下,传统AI则主要依赖于监督学习。

要理解生成式 AI 的革命性,我们需要将其与我们更熟悉的传统AI或判别式模型(Discriminative AI)进行区分:

生成式AI与传统AI的主要区别

| 特征 | 生成式AI(GenAI) | 传统AI(判别式) |

| 核心功能 | 创造全新的、原创的内容。 | 识别、分类或预测特定的结果。 |

| 任务广度 | 具有通用性,可以创建多种形式的内容。 | 通常针对特定任务设计和优化。 |

| 学习方式 | 通常在无监督学习下进行初步训练。 | 通常在有监督学习下进行训练。 |

| 数据需求 | 需要海量、多样化的数据集(如数万亿个Token)。 | 通常使用与其预期功能相关的特定数据集。 |

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

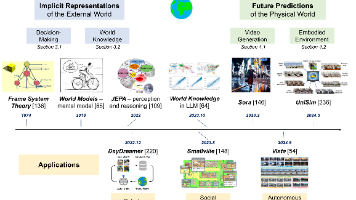

二、生成式AI的演进历程

生成式AI的发展并非一蹴而就,它经历了漫长而复杂的历史轨迹:

1、规则驱动的早期系统

1)起源与规则:自动数据生成的研究可追溯到1950年代,即符号AI兴起的时期。在这一阶段,研究人员依据人类专家的知识,设计特定的规则和指令,并将其编码到程序中,由程序执行生成任务。

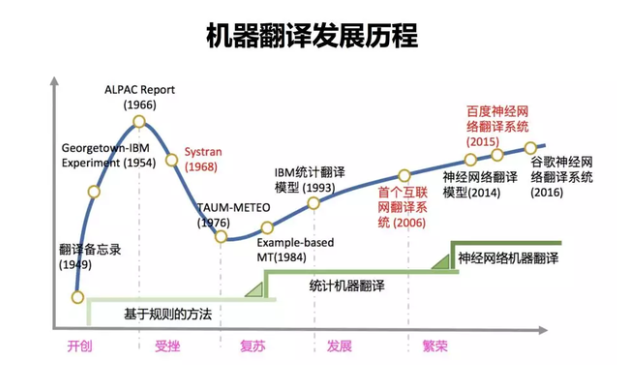

2)代表应用:1966年的第一个AI聊天机器人ELIZA,通过模式匹配来处理文本输入,并根据预设规则寻找回复。早期的机器翻译系统(如1968年的SYSTRAN)和语音合成系统也依赖于详细的语言学和语法规则。

3)**局限:**这类系统缺乏对上下文的深入理解,且仅适用于其规则设定的特定狭窄任务。

2、模型驱动的算法萌芽

在20世纪下半叶,研究转向基于统计模型或概率图模型的算法,试图捕捉数据分布的特征。这包括利用概率图模型(如马尔可夫链、隐马尔可夫模型)来显式或隐式地表示数据分布。在自然语言处理中,自回归模型的思想开始萌芽,奠定了序列生成的基础。

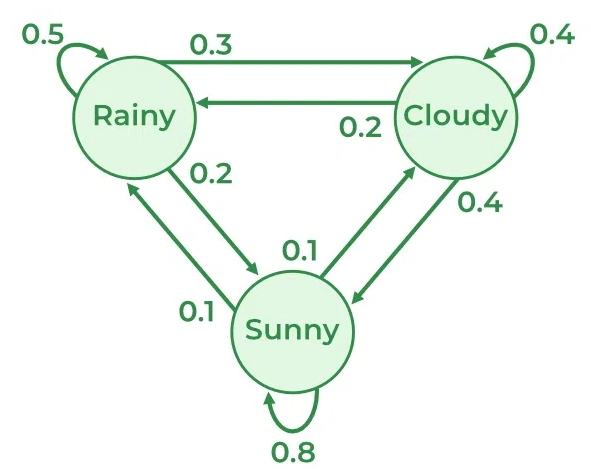

1)马尔可夫链:马尔可夫链是一种统计模型,它定义了一系列可能的状态,以及从一个状态转移到另一个状态的概率。它的核心是马尔可夫性质(Markov Property):“未来”的状态只依赖于“当前”的状态,而与“过去”所有状态都无关。

马尔可夫链核心组成要素:

| 要素 | 含义 | 示例 |

|---|---|---|

| 状态空间 (State Space) | 系统可能处于的所有状态集合 | 天气:{晴Sunny、阴Cloudy、雨Rainy} |

| 转移概率 (Transition Probability) | 从一个状态转移到另一个状态的概率 | P(晴Sunny→雨Rainy)=0.1 |

| 转移矩阵 (Transition Matrix) | 所有转移概率的矩阵表示 | 用矩阵显示各状态转移关系 |

| 初始分布 (Initial Distribution) | 初始时刻每个状态的概率 | 例如:初始为“晴Sunny”的概率0.8 |

马尔可夫链为建模和预测具有状态之间概率转换的系统提供了一个强大的框架。通过利用过渡矩阵,我们可以有效地捕获和分析从一种状态移动到另一种状态的概率。

马尔可夫链为建模和预测具有状态之间概率转换的系统提供了一个强大的框架。通过利用过渡矩阵,我们可以有效地捕获和分析从一种状态移动到另一种状态的概率。

过渡矩阵如下图所示:

| sunny | cloudy | rainy | |

|---|---|---|---|

| sunny | 0.8 | 0.1 | 0.1 |

| cloudy | 0.4 | 0.4 | 0.2 |

| rainy | 0.2 | 0.3 | 0.5 |

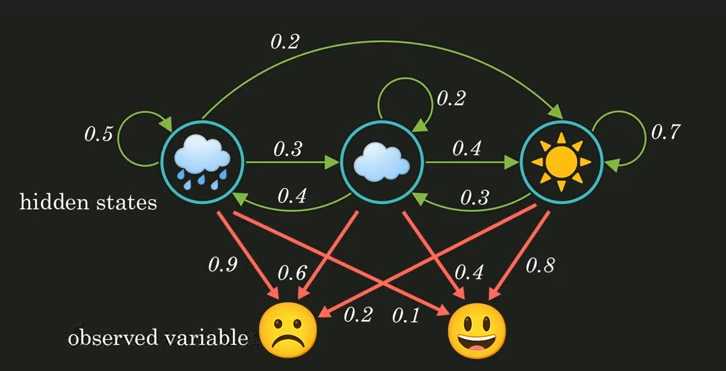

2)隐马尔可夫模型:隐马尔可夫模型(Hidden Markov Model,简称HMM)是个概率模型,非常适合处理“雾里看花”的情况。想象你猜天气:看不到云朵(隐藏状态),但能看到街上带伞的人多不多(可见观测)。HMM就是帮你从这些间接线索,反推背后的真相。它基于马尔可夫链(状态转移像链条),但加了“隐藏”层,让它更现实。

核心组件:四个概率“零件”:

- 隐藏状态:后台的“真家伙”,比如天气(晴S1、雨S2)。它们像马尔可夫链一样转移:晴天后雨天的概率0.3。

- 观测:你能看到的输出,比如“伞多O2、伞少O1”。每个状态会“发射”观测,有概率(发射概率):雨天发“伞多”的概率0.8。

- 转移概率:状态怎么跳?从S1到S2的几率。

- 初始概率:游戏开头,晴天概率0.6。

隐马尔可夫模型引入了潜在变量(即“隐藏状态”)的概念,这是现代所有先进生成模型(如 VAE、GAN 的生成器、Diffusion Models 的潜空间)的核心思想。这些模型都试图将复杂的高维数据(如图像)映射到更容易操作的低维潜在空间,并在该空间进行操作和生成。隐马尔可夫模型源于20世纪中叶的统计学,已成为生成式AI的理论基础,尤其在处理序列和概率分布时。

3)自回归模型:自回归模型(Autoregressive Model,简称AR)通过对序列中先前的输入进行测量来自动预测序列中的下一个分量。自回归是一种用于时间序列分析的统计技术,它假设时间序列的当前值是其过去值的函数。自回归模型使用类似的数学技术来确定序列中元素之间的概率相关性。然后,它们使用所得知识来猜测未知序列中的下一个元素。

3、深度生成模型的兴起(2013—2020)

真正的生成式AI热潮源于深度学习(Deep Learning)和神经网络技术的突破。受益于计算能力(GPU)和数据资源的指数级增长,深度学习在2011年左右迎来复兴。此后,深度神经网络在内容生成方面取得了突破性进展。

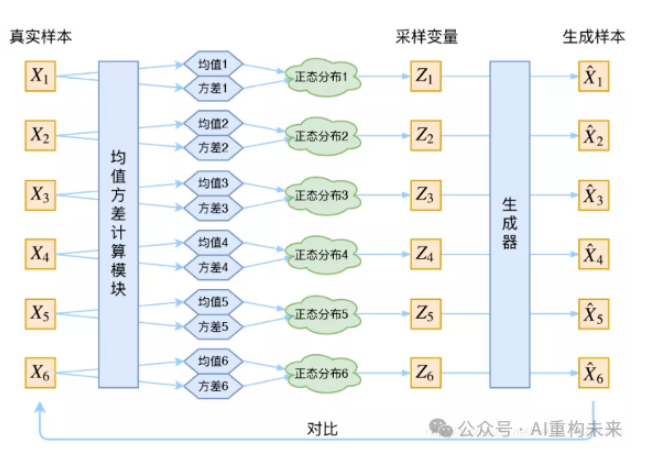

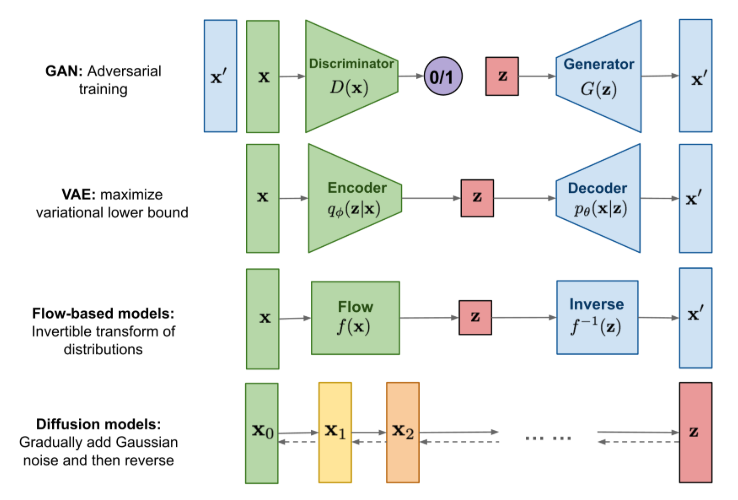

1)变分自编码器(VAEs:Auto-Encoding Variational Bayes):2013年阿姆斯特丹大学Diederik P. Kingma和导师Max Welling**(曾师从Geoffrey Hinton教授)提出了基于变分贝叶斯(Variational Bayes,VB)推断的生成式网络结构-变分自编码器生成模型,率先将神经网络与可扩展概率推理相结合,能够在高维数据上进行概率建模。VAE通过引入变分推理技术,对潜在变量的分布进行近似,将生成模型的训练转化为优化问题。具体而言,VAE通过构建编码器网络(Encoder)和解码器网络(Decoder),学习数据的潜在表示,并将原始数据压缩到一个低维的潜在空间的概率分布上。编码器负责将输入数据编码成潜在变量的分布参数,解码器则从潜在空间采样**,并重构生成新数据。****

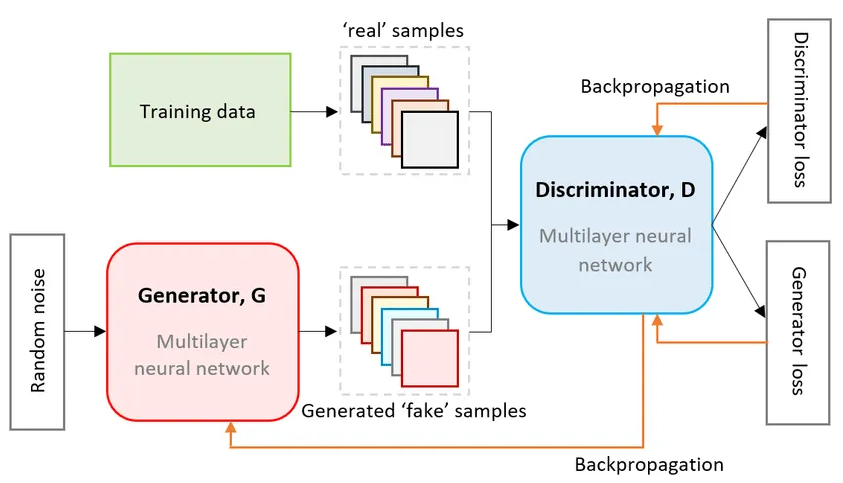

2)生成对抗网络(GANs):蒙特利尔大学机器学习博士伊恩·古德费洛****Ian Goodfellow和其导师2018年图灵奖得主约书亚·本吉奥Yoshua Bengio等在2014年提出了生成对抗网络(Generative Adversarial Networks,GANs),开创了深度生成模型的新范式。GAN由一个生成器(Generator)和一个判别器(Discriminator)组成,二者通过对抗训练的方式相互提升**,从而实现了对高维数据的生成和模拟。GAN的提出不仅极大地推动了生成模型的发展,而且在图像生成、风格转换、数据增强等多个领域取得了令人瞩目的成果。**

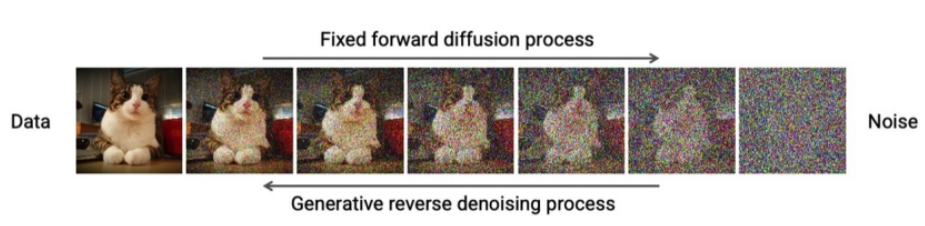

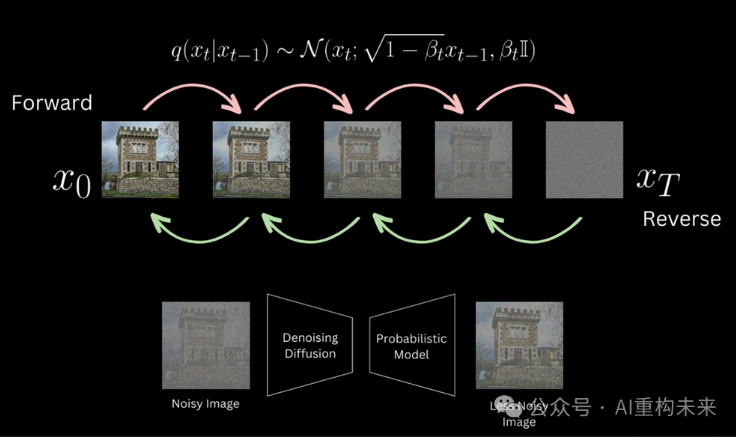

3)扩散模型的突破:扩散模型也大约在2014年出现,并在2020年通过去噪扩散概率模型(DDPM)生成模型等方式取得了重大进展。****2020年由Jonathan Ho, Ajay Jain, Pieter Abbeel提出了一种新型的去噪扩散概率模型(DDPM)生成模型。该模型通过逐步添加噪声到数据并反向推导去噪过程,形成了一个高效的生成框架,即通过构建了两个参数化的马尔可夫链(Markov Chain),用预定义的噪声在离散的时间步上扩散数据,并从噪声中重建所需的样本,最终在生成高品质图像方面表现出卓越性能。随着 Dall-E 2、Google 的 Imagen、 Stable Diffusion 和 Midjourney 的发布,扩散模型席卷了世界,激发了创造力并突破了机器学习的界限。这些模型可以根据文本提示生成近乎无限种类的图像,包括逼真的、奇幻的、未来主义的,当然还有可爱的。

4、Transformer架构与大语言模型的爆发 (2017–)

随着Transformer架构的诞生,技术发展快速进入了基础模型阶段。这些模型规模巨大(如 GPT-3具有1750 亿参数),在广泛数据集上训练,并能执行各种生成任务。

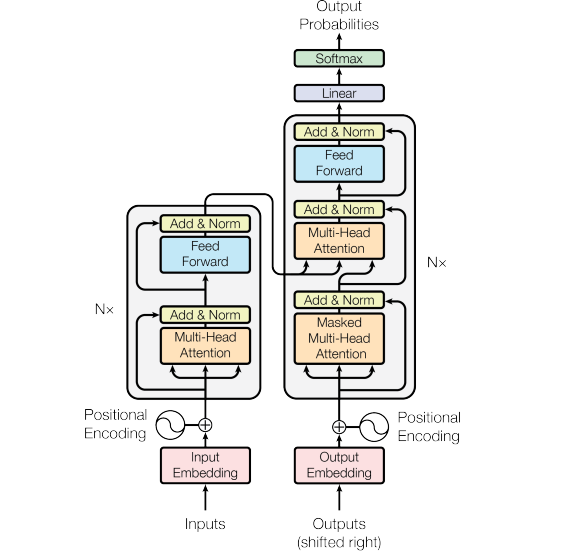

1)Transformer架构的诞生: Vaswani 等人在2017年在论文《Attention Is All You Need》中通过引入 Transformer架构的自注意力(self-attention)机制,摆脱了传统序列模型(如RNNs)对时间步长及串行处理的限制,显著提升了处理序列数据(如翻译、文本生成等任务)的效率、性能和可扩展性。采用的自注意力和位置编码两种机制使 Transformer特别擅长基于文本的生成式AI应用,这两种技术都有助于表示时间,并允许算法专注于单词在长距离内如何相互关联。

2)GPT诞生: 建立在 Transformer +自回归基础上的 生成式预训练 Transformer (GPT) 模型于 2018 年由 OpenAI 推出(GPT-1)。GPT-2 (2019) 进一步展示了模型在无监督学习下,具备处理多种自然语言处理任务的潜力。

3)**对话式AI革命:**2022年11月30日,ChatGPT的发布使得 GenAI 走向大众,引发了全球对该技术潜力的关注。

4)**多模态时代:**随后,出现了GPT-4 (2023), Gemini等多模态模型,它们可以接受图像和文本输入并产生文本输出,或处理多种数据模态。2024 年,Sora等视频生成模型进一步展示了文生视频的潜力。OpenAI最新发布的Sora 2被誉为“最强想象力引擎”。Sora 2在逼真度、运动物理学、可控性以及音画同步生成方面取得了巨大飞跃。

后续发展:Transformer作为统一生成架构,可兼容VAE编码器、GAN生成器或扩散网络。Transformer相当于“生成大脑的计算结构”,而GAN/VAE/扩散模型是“生成逻辑的算法范式”。如DiTs (Diffusion Models with Transformers)是一种简单且有效的基于Transformer的扩散模型骨干网络,它在性能上超越了以往的U-Net模型,并继承了 Transformer模型类的优秀可扩展性。

三、不同类型生成式AI的优缺点及适用场景对比

生成式AI模型种类繁多,主要包括GANs、VAEs、Transformer/GPT和Diffusion Models。它们通过不同的方式学习数据的生成分布或潜在结构,它们各有优势、局限性以及适用的场景。理解这些模型的差异,有助于我们选择合适的工具来完成特定的任务。

| 模型类型 | 核心工作原理 | 优势 | 局限性与挑战 | 适用场景 |

| 生成对抗网络(GANs) | 包含生成器(Generator)和判别器(Discriminator)两个网络进行竞争训练(零和博弈)。生成器试图生成逼真数据,判别器则尝试区分真实数据和生成数据。 | 图像生成质量高,输出内容逼真。在图像合成方面速度快。 | 训练不稳定,难以收敛;容易出现模式崩溃(生成结果缺乏多样性)。 | 图像生成 (Text-to-Image),图像到图像翻译(如马变斑马),生成逼真人脸老化图像,网络安全中生成合成流量包(Synthetic traffic packets)以测试网络防御。 |

| 变分自编码器(VAEs) | 编码-解码:编码器将数据压缩到潜在空间,解码器从潜在空间重构数据。。 | 擅长学习数据的概率分布和潜在结构,生成内容多样性好,训练相对稳定。主要用于降维和特征提取。 | 生成的图像往往比 GANs 模糊。 | 维度缩减,特征提取,图像压缩和搜索,异常检测,生成医疗合成数据。 |

| Transformer (LLMs 基础) | 基于自注意力机制,能够并行处理整个序列,通过自回归方式预测序列中的下一个 Token。 | 在处理序列数据(文本、代码)上效率高,通用性强。能够捕捉长距离依赖关系。 | 训练成本高昂,对算力要求极高。 | 文本生成(ChatGPT、Claude)、代码生成、机器翻译、多模态融合。 |

| 扩散模型 (Diffusion Models) | 定义正向过程逐步给数据加噪至高斯噪声,然后学习反向去噪过程来重建样本。 | 图像和视频生成质量极高,训练过程相对稳定。 | 训练和推理(采样)过程涉及多次迭代去噪,计算量巨大,速度较慢。 | 高质量图像生成(Stable Diffusion、DALL-E)、视频生成(Sora)、图像修复。 |

四、生成式AI基本工作原理和运作机制

生成式AI的运作基石在于神经网络和深度学习。其核心原理是:学习数据的概率分布或生成过程,并能够从中学到的分布中进行采样,生成新的数据样本。

生成式AI的总体流程包括三个主要阶段:训练、调整和生成/评估。

1、将一切信息转化为“代币” (Tokenization)

模型无法直接理解人类的文字或图像。它需要将所有输入和输出信息分解为标准化的基本单位,这些单位被称为Token。

1)**文本:**一个Token可能代表一个常用词、一个子词片段,或一个标点符号。

2)图像与声音: 图像会被分割成小块区域,声音会被分解为取样点或更高级的音频片段,然后这些片段通过编码器(Encoder)被表示成特定的 Token 序列。例如,一个16x16的图像块可以用一个Token来表示。

3)词汇表 (Vocabulary): 模型能够选择和输出的所有Token组成的集合被称为词汇表。现代LLM的词汇表往往非常庞大,可能包含数十万个 Token(例如,LLaMA模型的词汇表大小为128,000个Token)。

2、核心机制:无止境的“文字接龙”

语言模型(如 ChatGPT)的本质功能只有一件事:进行文字接龙。

1)预测概率:当用户输入一段未完成的序列(提示词,Prompt)时,模型会计算出其词汇表中每一个Token接下来出现的概率分布。例如,对于输入“人工”,模型会给“智”分配一个高概率(例如50%),给“呼”(人工呼吸)分配一个较低概率(例如 20%)。

2)**采样生成:**模型不会总是选择概率最高的Token。它会根据这个概率分布进行“掷骰子”(采样),以决定最终选择哪个Token。正是这种随机采样机制(例如 Top-k 或 Top-p 采样)使得模型能够提供多样化和具有创造性的答案,而不是机械地重复。

3)序列循环: 模型选出第一个Token后,会将其添加到原始输入序列中,形成一个新的、更长的Prompt,然后将这个新序列输入模型,继续预测下一个Token。这个过程会不断重复,直到模型生成一个代表序列结束的特殊符号为止。将这一连串的Token 串联起来,就是模型的完整输出。

3、模型如何具备“世界知识”和“理解指令”的能力?

模型如何从简单的“接龙”行为,发展到能够回答复杂问题、写代码或解释物理定律?这依赖于其巨大的参数规模(模型连接的权重)和精巧的训练对齐过程。

1)大规模训练 (Training):在预训练阶段(Pre-training),模型被输入海量、多样化、无标签的数据(例如来自互联网、书籍、代码库等)。模型通过预测下一个Token的任务,自动调整其内部的数万亿个参数,从而学习到语言的文法知识和复杂的世界知识。例如,当它看到“水的沸点是摄氏”时,它会学会接“100”。

2)潜在空间与高维数据的压缩

对于图像和视频等高维数据,模型通常使用潜在空间表示(Latent Space Representation)。

- 潜在空间: 这是一个抽象的、数学化的压缩空间,代表了模型从训练数据中学到的模式和特征。例如,VAE通过编码器将复杂的图像映射到这个低维空间,然后通过解码器将潜在空间中的点解码回全新的图像。

- 扩散模型的去噪: 扩散模型则通过反向去噪过程,从随机噪声(可以看作是潜在空间中的点)中逐步恢复出清晰、高保真的图像。

3)Transformer架构的作用:这种能力的基础是Transformer架构中的自注意力机制(Self-Attention)。它允许模型在处理一个序列中的任何一个Token时,能够同时评估并权衡序列中所有其他Token的重要性,从而理解词语之间的长距离依赖关系和上下文。

4)**调校与对齐 (Tuning):**为了让模型更好地遵循人类指令(而非只是“胡乱接龙”):

- 指令微调 (Fine-tuning): 使用包含特定指令和预期正确答案的带标签数据对模型进行二次训练。

- 人类反馈强化学习 (RLHF): 引入人类评分员对模型的不同回答进行评价(点赞或点踩)。模型通过这种反馈调整其参数,使其输出结果更符合人类的偏好、伦理和价值观(即价值对齐)。

5)上下文引导(Chat Template):为了确保模型回答问题而非继续提问,平台会在用户输入前后悄悄加上“系统提示”(System Prompt)或“聊天模板”(Chat Template)。例如,加上“使用者问:[问题] AI回答:”。这人为地限制了模型的接龙方向,使其输出答案。

6)多轮对话的实现:当用户进行第二轮追问时,模型会将过去所有的聊天记录(包括上一次的输入和模型的回答)作为新的Prompt的一部分,然后继续预测下一个Token。因此,模型“记住”了对话,因为它一直在“阅读”完整的历史记录。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

五、生成式AI的带来的好处

生成式AI是一种能够基于输入数据生成新内容的AI技术,如文本、图像、代码或音乐。它在多个领域带来了显著的好处:

1、提高生产力和效率:**生成式AI可以自动化重复性任务,如内容生成或数据处理,帮助用户快速完成工作,从而节省时间和精力。例如,它能加速知识工作流程,让团队专注于高价值活动。

2、**增强创意与创新:它能激发新想法,通过生成多样化的内容(如新角色、环境或设计方案)来放大人类的创造力,尤其在艺术、游戏开发和营销领域。

3、提高数据分析和决策效率:** 生成式AI智能的高效数据生成和分析可以合理地改善决策。例如,生成式AI可用于预测消费者行为、识别趋势和优化运营。

4、增强的客户体验:** 可以帮助企业为客户提供更加个性化和引人入胜的体验。例如,聊天机器人被广泛用于回答客户问题,甚至提供消费者支持。

5、更快的原型设计和开发:在产品开发中,可以快速生成初始原型、识别潜在问题并测试新想法,从而加快整个过程。

5、加速研究: 在制药等领域,帮助研究人员探索复杂数据、生成新的解决方案并显着加快药物发现。

六、生成式AI的局限性与挑战

生成式AI带来了前所未有的生产力提升,但同时也引发了严重的局限性与现实挑战。

1、事实错误与“幻觉”现象

“幻觉”(Hallucination):通过****概率分布来预测下一个Token。当它遇到训练数据中罕见、复杂或缺失的知识时,它会基于概率推测出一个看似合理但完全虚假或不准确的答案。

1)缺乏真实理解: 模型并没有内在的知识库或真正的理解力、同理心。它只是在做“文字接龙”。

2)不可信赖: 对于专业或高级问题,如法律案例或代码编写,模型可能给出错误的响应,如ChatGPT曾编造不存在的网址。因此,完全依赖生成式AI的回答是不可取的,使用者必须进行事实核查和监督。

3)应对措施:正在研究的技术,例如检索增强生成(RAG),通过将外部、可信的实时信息来源引入生成过程,来缓解幻觉问题。

2、伦理、偏见与滥用风险

1)训练数据中的偏见: 生成模型会学习并放大训练数据中已有的偏见,例如性别、种族或文化上的偏见。

2)深度伪造与网络犯罪:****生成式AI可用于生成高度逼真的深度伪造(Deepfakes)图像、音频和视频,可能被用于欺骗、敲诈或政治虚假信息传播。恶意工具如WormGPT 和FraudGPT已经出现,专门用于制作复杂的网络钓鱼和社会工程攻击。在音乐行业,通过AI工具甚至发布模仿知名艺术家虚假声音。

3)知识产权与隐私:由于模型在海量数据上训练,其中通常包含受版权保护的内容,其生成内容可能引发版权纠纷。此外,用户在Prompt中输入的敏感或私人信息,可能在训练过程中被模型学习或泄露,构成隐私风险。

3、巨大的资源和环境负担

1)资源集中化:训练前沿的基础模型需要巨大的计算基础设施,例如高性能GPU集群。这种资源集中在少数几家科技巨头手中,构成了进入的巨大壁垒。

2)环境成本:生成式AI系统的训练和部署消耗大量电力,导致显著的碳足迹。数据中心对水的需求也引起了环境担忧。

4、模型退化与数据污染

如果AI模型被持续用其他AI生成的合成数据进行训练,模型中固有的错误和缺陷会被反复放大,最终可能导致模型“遗忘”真实世界的模式,产生质量持续下降的“模型崩溃”(Model Collapse)现象**。此外,互联网上AI生成内容的爆炸性增长正在**污染数据集,导致未来模型难以获得高质量的真实人类数据。

七、生成式AI的应用领域

生成式AI正在多个行业产生指数级影响,其应用涵盖了从知识工作自动化到艺术创作的广泛领域。

1、文本与代码创作

这是目前最成熟的领域,主要由大型语言模型(LLMs)驱动。

1)**内容生成:**快速生成文章、报告、电子邮件、广告文案、博客内容或摘要。

2)软件开发:LLMs可以根据自然语言描述自动生成新的源代码、自动补全代码片段、在不同编程语言间进行翻译,并辅助调试和解释代码功能。代表工具有 GitHub Copilot、Codex、StarCoder等。

3)商业运营: 提升客户服务效率,通过新一代的聊天机器人提供个性化的、基于企业知识库的即时响应。在金融和法律行业,它可以自动创建报告、合同和法律文书。

2、视觉与多媒体艺术

GenAI在创造图像和视频方面的能力极大地拓展了创意产业的边界。

1)图像生成与编辑: 根据文本提示生成照片级逼真的图像或艺术作品。应用包括数字艺术、平面设计、产品原型设计,以及将图片转为不同风格(如Firefly、Stable Diffusion、DALL-E)。

2)视频生成: 根据文本描述生成视频片段,如Make-A-Video、Gen-2。2025年发布的Sora 2进一步展示了创建逼真视频场景的能力。

3)**3D建模与设计:**用于自动化3D建模(文生3D、图生3D)和计算机辅助设计(CAD),以及创建虚拟环境。RoomGPT等工具可用于家居设计。

3、声音与音乐

生成式AI能够合成逼真的人声,甚至进行音乐创作。

1)语音合成: 根据文本或音频输入生成逼真的人类语音,并可进行音调和情感的细微调整。代表工具包括WaveNet、Whisper和Synthesys。

2)音乐创作: 根据文本提示创作音乐(Text-to-Music),如 Suno、MusicLM、Jukebox、Boomy。

4、商业、研发与服务

生成式AI正将自动化带入知识工作的核心流程。

1)客户体验: 新一代聊天机器人能提供个性化、上下文感知的即时响应,提高客户满意度。

2)药物研发: 通过生成具有目标特性的新型分子结构和蛋白质序列,加速新药发现过程。

3)网络安全:GANs等算法可以生成合成流量包来模拟真实世界的网络攻击,帮助企业测试和建立更强大的网络机制,以预测和抵御入侵尝试。

4)合成数据: 当真实数据稀缺(如具身智能领域)或存在隐私顾虑时,生成式AI可以生成合成数据,用于训练和验证其他AI模型,同时保护用户隐私。

八、生成式AI未来趋势和展望

生成式AI仍处于快速演进阶段,未来几年将朝着更自主、更通用、更安全的方向发展。

1、自主智能体(Agentic AI)的崛起

未来,GenAI将从被动的“工具”进化为具有自主能力的智能体(AI Agent)。

1)自主行动: 智能体能够根据用户设定的复杂目标,自主设计工作流程、规划执行步骤,并调用外部工具(如软件服务、在线API)来完成任务,而无需人类持续干预。例如,一个智能体不仅能告诉你攀登珠穆朗玛峰的最佳时间,还能自动帮你预订机票和酒店。

2)颠覆性影响: 这种自主性将加速知识工作的自动化,并将GenAI嵌入到企业的核心业务平台中,实现流程自动化和业务流程管理(BPM)。

2、深度融合与模态统一

未来的模型将继续消除不同数据模态之间的障碍。

1)多模态模型: 模型将具备同时处理和生成文本、图像、视频、音频和 3D数据等多种模态的能力(如GPT-4o、Gemini)。例如,Google的 ImageBind模型能够结合六种类型的数据。

2)加速科学发现: 在医疗健康和生命科学领域,GenAI将加速药物发现,以及用于癌症诊断的图像和基因组分析。

3、提升可信赖性和安全性

随着技术能力的增强,对AI的治理、安全和伦理提出了更高要求。

1)可解释性(Explainability): 解决“黑箱”问题是关键。未来的研究方向之一是解密GenAI模型的决策过程,以人类可理解的方式呈现出来,从而提高模型在安全关键领域(如医疗、金融)的信任度。

2)价值对齐(Value Alignment): 确保GenAI系统理解并遵循人类的意图和价值观,防止模型被用于不道德的目的,如恶意内容生成。

3)检测与透明度: 推广使用数字水印和内容认证技术,以便用户识别AI 生成的内容。

4、就业市场的结构性变革

GenAI对劳动力市场的影响是深远且不可逆的。

1)取代重复性工作:大型语言模型自动化潜力最高的任务是常规性和重复性的知识工作,例如信用授权、文书处理、管理分析师、电话营销员和出纳员的部分工作。

2)创造新岗位: 尽管部分工作可能被取代,但历史上重大技术变革总是创造出比其淘汰的更多、价值更高的新工作岗位。未来将需要大量新的专业人士,例如AI可解释性专家和GenAI工程师。

3)重要性:个人必须优先考虑再培训和适应性,以准备迎接AI驱动的未来工作环境。

生成式AI是人类历史上一次深刻的技术飞跃,它赋予了机器前所未有的创造力,正在重塑内容生产、商业运营和科学研究的范式。这项技术,从早期的规则设定到复杂的深度神经网络,最终汇聚成了今天能够进行“文字接龙”并展现出惊人通用性的基础模型。

然而,这项强大的“创造性计算器” 并非完美无缺。我们必须正视它固有的缺陷,如“幻觉”带来的准确性危机,以及其对隐私、知识产权、计算资源和就业市场带来的结构性挑战。

驾驭这股浪潮的关键,在于建立人类与AI的有效协作模式。我们既要利用其效率和创造力,也要通过严格的监督、伦理治理和对齐技术,确保其发展始终符合人类的价值观。

九、如何学习AI大模型?

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献266条内容

已为社区贡献266条内容

所有评论(0)