简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

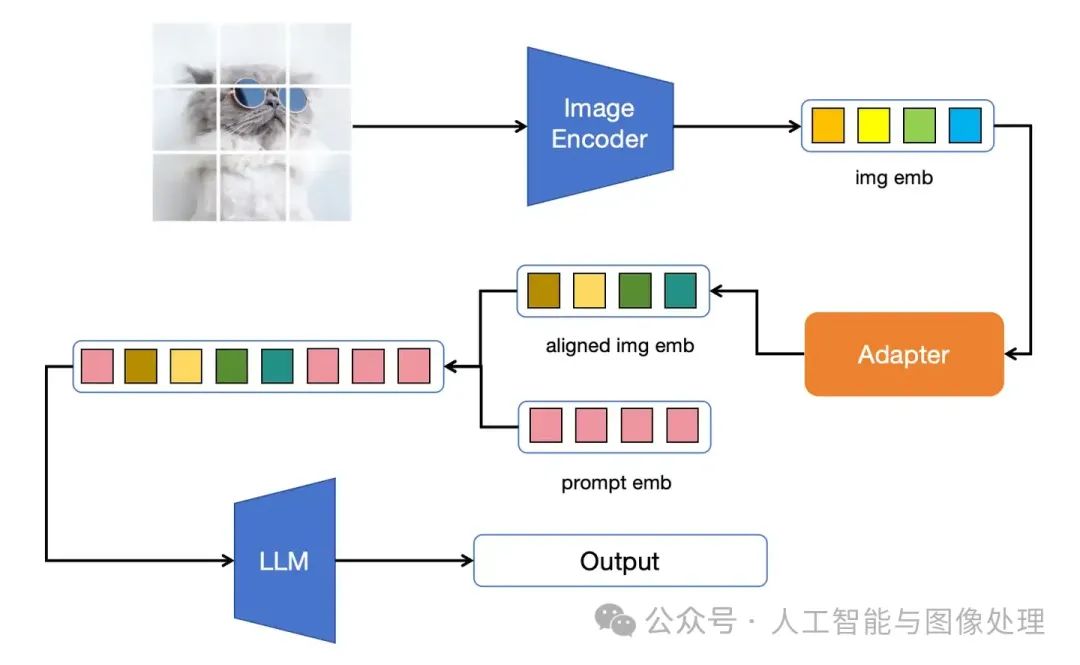

相较于之前的工作,本文的主要贡献在于将大VIT、长img_emb和动态长宽比引入了多模态大模型并扩充了训练数据集。对于富文本图片,其包含的信息量较大,此前使用的小VIT,短img_emb可能无法承载如此多的信息,大VIT,长img_emb让internVL-V1.5拥有了理解富文本图片的潜力扩充的训练数据集让internVL-V1.5拥有了理解富文本图片的能力动态长宽比的引入则让模型更好的处理极端

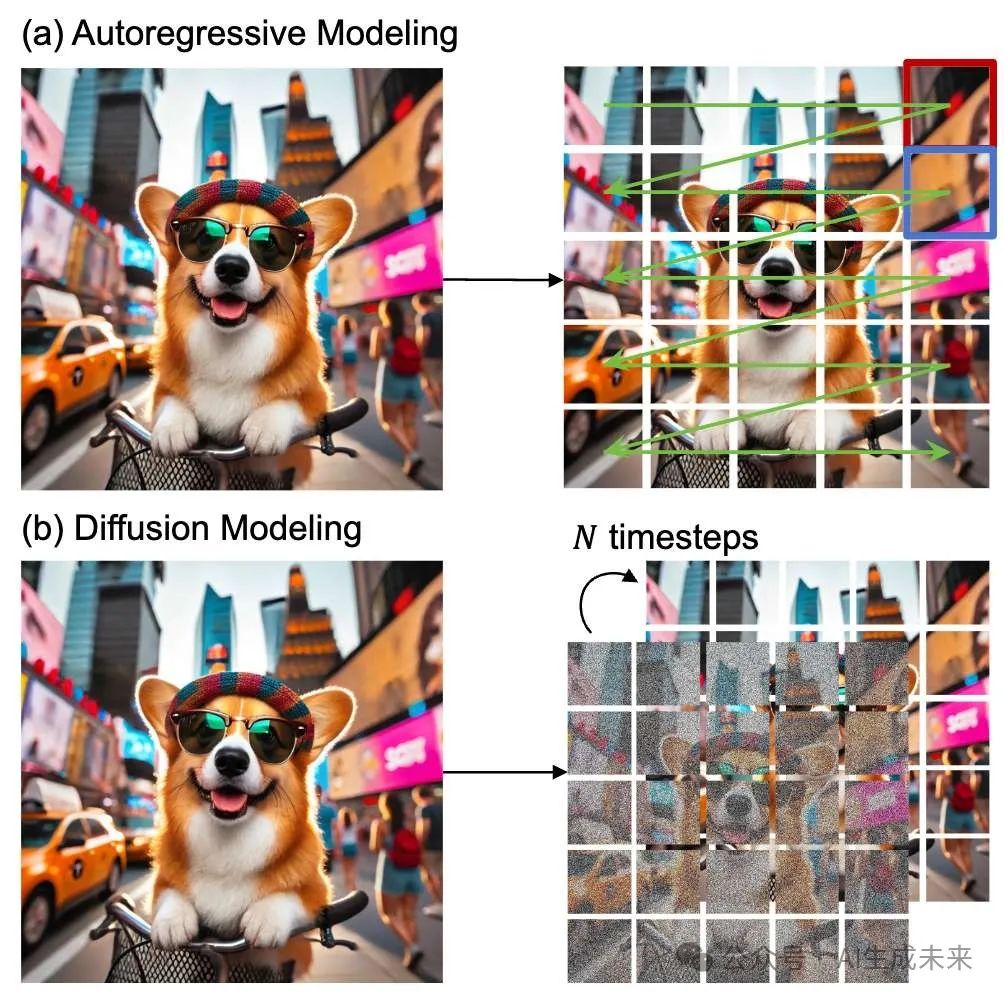

当前的大型视觉模型大多直接从自然语言处理架构中改造而来,使用低效的自回归技术,这种方法破坏了视觉数据中至关重要的空间关系,并且在高维度视觉数据的生成任务中表现有限。

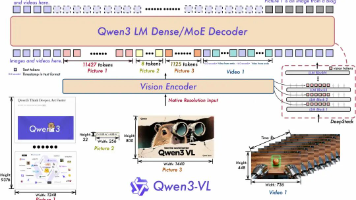

通义千问VL模型是强大的多模态AI视觉理解工具,具备图像问答、视频分析、物体定位、文档解析、视觉编码生成代码等功能。Qwen3-VL版本在视觉感知、空间理解、长视频处理和多模态推理方面全面升级,支持32种语言OCR。文章通过实例展示其在图像识别、多图分析和视频理解等场景的应用,并提供API接口使用方法,是程序员学习和应用AI视觉技术的实用指南。

构建一个大型语言模型,了解如何创建、训练和调整大型语言模型 (LLMs)!

文章推荐了两个热门开源GitHub项目:MaxKB和Supervision。MaxKB是基于LLM的企业级知识库问答系统,支持文档上传、自动爬取、文本拆分向量化、RAG等功能,技术栈包括Vue.js、Python/Django和LangChain。Supervision是计算机视觉工具箱,支持人体跟踪、分割、检测等功能,可自定义插入模型,提供数据处理和数据集工具。两者分别由1Panel和Robof

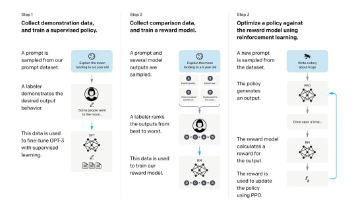

从 GPT3 到 ChatGPT、从GPT4 到 GitHub copilot的过程,微调在其中扮演了重要角色。什么是微调(fine-tuning)?微调能解决什么问题?什么是 LoRA?如何进行微调?本文将解答以上问题,并通过代码实例展示如何使用 LoRA 进行微调。微调的技术门槛并不高,如果微调的模型规模不大 10B 及 10B 以下所需硬件成本也不高(10B模型并不是玩具,不少生产中会使用

本案例集是由国家数据局组织编写的案例集,汇集了来自全国各地的47个优秀数据标注案例,覆盖技术创新、行业赋能、标准应用、生态培育和人才培养等方向。这些案例展示了数据标注在不同领域的创新实践和应用成效,为行业提供了丰富的参考和借鉴。

本文系统梳理了大模型(LLMs)技术体系,涵盖基础架构、微调方法、应用优化等核心内容。基础部分解析了主流开源模型、架构差异及涌现能力;进阶层面探讨了复读机问题、模型选型及长文本处理策略;微调章节详细讲解了显存需求、数据构建及参数高效微调(PEFT)技术;应用方面重点介绍了LangChain框架的文档对话实现及优化方案。全文从理论到实践,为LLMs研发提供了全面的技术指导,包括LoRA微调、提示学习

主流大模型对比与选型指南 本文系统对比了GPT、Claude、Gemini、Llama及国产模型五大主流AI家族,分析其版本差异、优劣势及适用场景。GPT综合能力顶尖但成本高;Claude擅长长文本处理;Gemini原生多模态支持;Llama开源可定制但部署门槛高;国产模型中文优化强且性价比高。文章详细对比了云端API和私有化部署的成本差异,为不同场景提供选型建议:初创企业推荐云端API,敏感数据

摘要:2023-2025年生成式AI快速发展,但企业应用面临"幻觉陷阱"和"逻辑黑箱"问题。2026年供应链智能化进入深水区,70%企业将转向"决策智能化"。LOM(本体大模型)通过将行业标准注入模型底层,实现逻辑推理和业务一致性,解决四大痛点:决策滞后、系统孤岛、人机割裂和价值模糊。LOM通过双引擎架构重塑供应链计划、智能制造等场景,推