收藏!大模型Prompt工程完全指南:从入门到精通15种核心技术

收藏!大模型Prompt工程完全指南:从入门到精通15种核心技术

在AI技术高速迭代的当下,大语言模型(LLM)凭借其强大的语义理解、内容生成与逻辑推理能力,已成为企业降本增效、个人提升生产力的关键工具。无论是智能客服自动处理80%的常规咨询,还是内容创作者借助模型快速生成初稿,亦或是数据分析师用其提炼报告核心——这些场景的高效落地,都离不开精心设计的Prompt。Prompt不仅是人与模型的“沟通桥梁”,更是解锁模型潜力的“钥匙”。

第一节:Prompt的核心定义与科学框架

一、什么是Prompt?

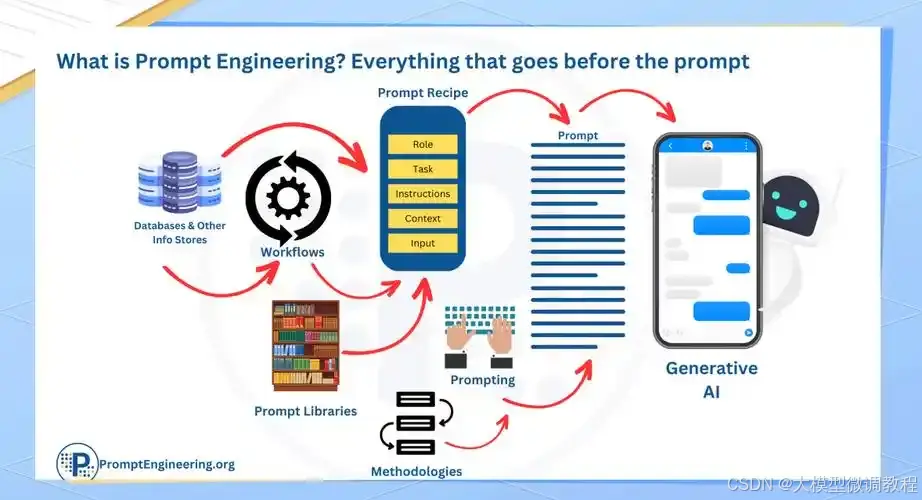

在大语言模型的应用场景中,Prompt是指通过自然语言指令、上下文信息或示例,引导模型调用特定能力(如总结、翻译、推理)以解决实际问题的输入形式。早期Prompt曾被称为“输入模板”或“任务指令”,但随着LLM技术的发展,“Prompt”这一术语因更精准地体现“主动引导模型能力”的核心作用,逐渐成为行业共识。

需要明确的是:大模型的核心能力(如语义理解、常识推理)在预训练阶段已基本成型,Prompt的作用并非“教模型新知识”,而是像“钥匙”一样,从模型的预训练知识库中“唤醒”与任务匹配的能力。例如,当我们需要模型分析用户投诉时,Prompt不是让模型“学习如何分析投诉”,而是引导它调用“情感识别”“关键信息提取”能力,输出结构化的分析结果。

简言之,Prompt的本质是“人与模型的高效沟通语言”,其质量直接决定了模型输出的准确性与实用性。

二、撰写Prompt的科学框架

一个优秀的Prompt并非随意编写的文字,而是包含明确要素、遵循固定逻辑的结构化输入。掌握以下5种框架,可覆盖90%以上的应用场景。

1、Prompt的核心要素

无论采用哪种框架,一个完整的Prompt通常包含4个关键部分:

- 指令(Instruction):明确告诉模型需要完成的具体任务(如“总结以下文档”“分析用户评论的情感倾向”)。

- 上下文(Context):提供与任务相关的背景信息或外部知识(如“基于电商平台的客服场景”“参考2024年新能源汽车销量数据”)。

- 输入数据(Input Data):模型需要处理的原始内容(如用户评论原文、产品说明书文本)。

- 输出指示(Output Guidance):指定模型输出的格式或要求(如“以表格形式呈现”“用Markdown分点说明”“控制在300字以内”)。

2、5大实用Prompt框架

2.1 RTF框架:通用场景的“万能模板”

RTF(Role-Task-Format)框架是最基础、最通用的Prompt结构,适用于绝大多数简单任务(如翻译、摘要、基础问答),核心是通过“指定角色、明确任务、规范格式”让模型输出更精准。

- R(Role):为模型设定具体角色,限定其知识范围与语言风格(如“你是资深电商客服”“你是专业的Python程序员”“你是儿童科普作家”)。

- T(Task):清晰描述模型需要完成的任务(如“回复用户关于商品退换货的咨询”“解释Python中列表与元组的区别”“用500字讲解什么是黑洞”)。

- F(Format):规定输出的格式(如“分3点回复,语气友好”“用代码+注释的形式说明”“以故事开头,结尾加小提问”)。

优势:结构简单易上手,指定“Role”可让模型聚焦特定领域知识(如让“资深医生”角色回答健康问题,比通用角色更专业);结合RAG(检索增强生成)时,还能让模型基于外部知识库输出更精准的内容。

2.2 思考链模式:复杂推理的“逻辑助手”

当面对需要分步分析的任务(如数学计算、故障排查、商业决策)时,普通Prompt容易让模型“跳过步骤、直接给结论”,导致结果错误。思考链模式通过引导模型逐步拆解问题,提升推理准确性。

核心用法:在Prompt末尾添加“请逐步分析推理过程”或“让我们一步步思考”,即可触发模型的分步推理能力。

示例:

# 任务:根据错误日志排查Python程序问题

错误日志:"AttributeError: 'list' object has no attribute 'strip'"

请分析该错误的原因,并给出解决方案。让我们一步步思考。

适用场景:数学题计算、代码Bug排查、复杂事件分析(如“分析某产品销量下降的3个可能原因”)、决策建议(如“某初创公司是否应进入新能源赛道”)。

2.3 RISEN框架:高约束任务的“精准工具”

RISEN(Role-Instructions-Steps-End Goal-Narrowing)框架在RTF基础上增加了“步骤”和“约束条件”,适用于对输出有严格要求的任务(如撰写商业计划书、设计教学方案、制定项目流程)。

- R(Role):模型角色(如“资深商业顾问”“高中数学老师”)。

- I(Instructions):核心指令(如“撰写一份奶茶店创业计划书”“设计一节高二函数的复习课”)。

- S(Steps):完成任务的具体步骤(如“先分析市场需求,再确定产品定位,最后制定运营计划”“先回顾知识点,再讲解例题,最后布置练习题”)。

- E(End Goal):任务的最终目标(如“计划书需能吸引投资人关注”“学生能独立解出同类题目”)。

- N(Narrowing):约束条件(如“计划书控制在5页内,重点写成本预算”“练习题难度不超过高考真题”)。

优势:通过“步骤”引导模型有序思考,通过“约束条件”避免输出偏离需求,尤其适合需要结构化、规范化结果的场景。

2.4 RODES框架:注重细节与验证的“严谨方案”

RODES(Role-Objective-Details-Examples-Sense Check)框架强调“细节补充”和“结果验证”,适用于对准确性要求极高的任务(如法律文书撰写、技术文档翻译、数据标注指导)。

- R(Role):模型角色(如“企业法务专员”“技术文档翻译师”)。

- O(Objective):任务目标(如“起草一份劳动合同补充协议”“将Python官方文档的‘列表方法’部分翻译成中文”)。

- D(Details):任务的关键细节(如“补充协议需包含加班费计算标准,参考《劳动合同法》第31条”“翻译需保留代码示例,专业术语与行业通用译法一致”)。

- E(Examples):提供1-2个示例(如“参考以下加班条款表述:‘员工加班时长以小时为单位,加班费按基本工资的150%计算’”)。

- S(Sense Check):结果验证要求(如“协议条款需无法律漏洞,标注引用的法条编号”“翻译后需检查代码示例是否可正常运行”)。

2.5 密度链模式:高效生成高质量内容的“进阶技巧”

密度链模式是由Salesforce、MIT和哥伦比亚大学联合提出的Prompt技术,核心是通过递归迭代让模型逐步优化输出。例如,生成一篇文章时,先让模型输出初稿,再基于初稿生成更精炼的版本,重复2-3次后得到“高密度、高可读性”的结果。

适用场景:

- 长文档摘要(如将10000字的报告浓缩为500字的核心摘要);

- 内容优化(如将初稿文案修改为更简洁、更有感染力的版本);

- 专业内容生成(如撰写学术论文的摘要、行业分析报告的核心观点)。

提示:该模式可结合“输出指示”使用,例如“先生成300字的报告摘要,再基于该摘要生成100字的核心要点,最后用一句话总结要点”。

第二节:打造高效Prompt的两大核心原则

要让Prompt发挥最大价值,需遵循两大核心原则:指令明确具体(让模型“懂你要什么”)和给予思考时间(让模型“想清楚再答”)。这两大原则是所有高阶Prompt技术的基础。

一、原则一:编写明确、具体的指令

模糊的指令会导致模型“猜需求”,输出偏离预期;而明确的指令能让模型聚焦任务,提升输出准确性。具体可通过4个策略实现:

策略1:用分隔符界定输入边界

当Prompt中包含“指令”和“待处理数据”(如用户评论、文档文本)时,用分隔符将两者分开,可避免模型混淆“什么是指令、什么是需要处理的内容”。

常用分隔符:

- 三重双引号:“”“待处理文本”“”

- 三重单引号:‘’‘待处理文本’‘’

- XML标签:

待处理文本 - 章节符号:#### 待处理文本 ####

示例(情感分析任务):

指令:分析以下用户评论的情感倾向(积极/消极/中性),并说明理由。

用户评论:'''这款扫地机器人续航比宣传的短2小时,不过吸灰尘很干净,总体还算满意。'''

通过三重单引号分隔“用户评论”,模型能清晰识别“需要分析的内容”,避免将“指令”误判为“待处理文本”。

策略2:要求结构化输出

对于需要后续处理(如导入Excel、接入其他系统)的任务,要求模型以结构化格式(如JSON、表格、HTML)输出,可大幅提升效率。

示例1(JSON格式输出):

请从以下产品描述中提取“产品名称、核心功能、价格”三个信息,以JSON格式输出。

产品描述:"""XX牌空气净化器,支持HEPA滤网过滤PM2.5,自带智能APP控制,售价1299元。"""

模型输出:

{

"产品名称": "XX牌空气净化器",

"核心功能": ["HEPA滤网过滤PM2.5", "智能APP控制"],

"价格": "1299元"

}

示例2(表格格式输出):

请将以下3个学生的成绩按“姓名、数学、语文、总分”整理成Markdown表格。

成绩数据:小明数学90分、语文85分;小红数学95分、语文92分;小李数学88分、语文90分。

策略3:让模型先检查前提条件

当任务依赖特定前提(如“数据需为正数”“文本需包含指定关键词”)时,先让模型检查前提是否满足,再执行任务,可避免无效输出。

示例(数学计算任务):

请计算以下表达式的结果,但需先检查两个条件:1. 表达式中是否有负数;2. 是否只有加法运算。若不满足任一条件,输出“无法计算”;若满足,输出结果。

表达式:5 + 8 + 12

模型输出:“检查结果:无负数,仅加法运算。计算结果:25”

策略4:少样本提示(Few-shot Prompting)

对于复杂或有特定格式要求的任务(如自定义分类、特殊句式生成),直接给指令模型可能“理解偏差”,此时提供1-3个“示例”(成功完成任务的案例),让模型“照葫芦画瓢”,可显著提升输出质量。

示例(自定义文本分类):

请将用户咨询按“订单问题、售后问题、产品咨询”分类。

示例1:用户问“我的订单什么时候发货?”——分类:订单问题

示例2:用户问“收到的商品有划痕,能换货吗?”——分类:售后问题

用户咨询:“这款手机支持5G网络吗?”——分类:

模型输出:“产品咨询”

二、原则二:给予模型充足的思考时间

模型在处理复杂任务(如逻辑推理、多步骤计算)时,若急于输出结论,容易出现“跳步骤”导致错误。此时需通过Prompt引导模型“慢下来”,逐步思考后再给结果。

策略1:明确任务步骤

将复杂任务拆解为“步骤清单”,让模型按步骤执行,避免思路混乱。

示例(分析古诗任务):

请按以下步骤分析《静夜思》:

步骤1:概括诗歌的核心主题;

步骤2:找出诗中的关键意象(如“明月”“霜”);

步骤3:分析意象所表达的情感。

《静夜思》:床前明月光,疑是地上霜。举头望明月,低头思故乡。

模型输出:

“步骤1:主题——诗人在夜晚因明月引发的思乡之情;

步骤2:关键意象——明月、霜;

步骤3:情感——“明月”象征故乡的牵挂,“霜”营造清冷氛围,烘托孤独与思乡之感。”

策略2:引导模型先推理、再结论

在Prompt中明确要求模型“先写出推理过程,再给出最终答案”,尤其适用于数学题、逻辑题等需要严谨推导的场景。

示例(逻辑推理题):

甲、乙、丙三人分别是医生、教师、工程师。已知:1. 甲不是医生;2. 丙不是教师。请判断三人的职业,要求先写出推理过程,再给出结论。

模型输出:

“推理过程:

- 职业有3种:医生、教师、工程师,三人各占一种;

- 由“甲不是医生”,可知甲可能是教师或工程师;

- 由“丙不是教师”,可知丙可能是医生或工程师;

- 假设甲是教师,则丙只能是医生(因丙不能是教师,且甲已占教师),剩余乙为工程师;

- 验证:无矛盾,该假设成立。

结论:甲=教师,乙=工程师,丙=医生”

三、模型的“幻觉”问题与应对策略

“幻觉”是大模型的常见问题——模型会生成看似合理、但与事实不符的内容(如编造不存在的文献引用、错误的历史事件时间)。其根源在于:模型虽训练了海量数据,但无法精准记住所有知识,也难以判断“自己是否知道”。

核心应对策略:让模型“基于指定信息回答”,而非依赖自身记忆。具体操作是:在Prompt中提供与任务相关的“参考文档”,要求模型从文档中提取信息并引用,再生成答案。

示例(基于文档回答问题):

请根据以下参考文档,回答“南北战争的核心矛盾是什么”,并标注答案在文档中的依据。

参考文档:"""1861-1865年的美国南北战争,本质是北方工业资本主义与南方种植园奴隶制的矛盾激化。北方主张废除奴隶制、发展工业,需要自由劳动力;南方依赖奴隶制维持棉花种植经济,反对废除奴隶制。最终北方胜利,为美国工业化扫清了障碍。"""

模型输出:

“南北战争的核心矛盾是北方工业资本主义与南方种植园奴隶制的矛盾(依据:文档中“本质是北方工业资本主义与南方种植园奴隶制的矛盾激化”)。北方需自由劳动力发展工业,主张废除奴隶制;南方依赖奴隶制维持种植园经济,反对废除奴隶制。”

第三节:15项核心Prompt技术解析与应用

在深入探索 prompt 技术的征程中,我们将逐一解析多种关键技术,助力您精准把握其核心要点与应用场景,切实提升应用能力。

一、零样本提示(Zero-Shot Prompting)

零样本提示是一种让模型在没有特定任务示例展示的情况下直接处理任务的技术。其原理在于模型经过大量数据训练和指令调整后,自身具备了一定的通用知识和任务理解能力。例如:

"判断此文本的情感倾向为积极、消极或中性:这部电影情节紧凑,特效惊人。情感:"# 模型会依据自身预训练知识对这个提示进行处理并输出结果

模型能依据自身预训练知识输出“积极”。然而,由于缺乏具体示例引导,对于复杂任务,其效果可能受限。

二、少样本提示(Few-Shot Prompting)

少样本提示在零样本提示效果不佳时发挥作用。它通过为模型提供少量任务示例,帮助模型学习任务模式和规律。例如:

"""“whatpu”是坦桑尼亚的一种小型毛茸茸的动物。一个使用 whatpu 这个词的句子的例子是:我们在非洲旅行时看到了这些非常可爱的whatpus。“farduddle”是指快速跳上跳下。一个使用 farduddle 这个词的句子的例子是:"""# 模型会根据前面的示例学习并生成新的句子

通过提供如上述新词汇造句的示例,模型能够模仿示例的结构和逻辑生成新的内容。不过在复杂推理任务中,仍需进一步优化。

三、思维链提示(Chain-of-Thought Prompting)

思维链提示旨在为模型提供清晰的推理步骤引导,从而显著提升其在复杂推理任务中的表现。它通过在提示中展示详细的推理过程,让模型学习如何逐步分析和解决问题。比如:

"""Roger 有 5 个网球,他又买了 2 罐网球,每罐有 3 个球,他现在共有多少球?Roger 一开始有 5 个球。2 罐网球,每罐 3 个,共 6 个球。5 + 6 = 11。答案是 11。"""# 模型按照提示中的推理步骤进行计算和回答

此技术可与少样本提示结合,增强效果,尤其适用于算术、常识推理等任务,帮助模型更有条理地处理问题。

四、自我一致性(Self-Consistency)

自我一致性技术主要用于优化思维链提示中的推理路径选择。其核心思想是通过提供多个少样本推理示例,让模型从多样的推理结果中筛选出最一致的答案,增强模型在算术和常识推理任务中的可靠性。比如:

"""Q:林中有 15 棵树。林业工人今天将在林中种树。完成后,将有 21 棵树。林业工人今天种了多少棵树?A:我们从 15 棵树开始。后来我们有 21 棵树。差异必须是他们种树的数量。因此,他们必须种了 21 - 15 = 6 棵树。答案是 6。Q:停车场有 3 辆汽车,又来了 2 辆汽车,停车场有多少辆汽车?A:停车场已经有 3 辆汽车。又来了 2 辆。现在有 3 + 2 = 5 辆汽车。答案是 5。Q:当我 6 岁时,我的妹妹是我的一半年龄。现在我 70 岁了,我的妹妹多大?A:"""# 模型会参考前面的推理示例对最后一个问题进行回答,并从多个可能的回答中选择最一致的答案

五、生成知识提示(Generated Knowledge Prompting)

生成知识提示主要用于解决模型在处理需要额外知识的任务时出现的局限性。它的操作方式是先让模型生成与任务相关的知识,再整合这些知识得出准确答案。比如:

"""输入:高尔夫球的一部分是试图获得比其他人更高的得分。知识:高尔夫球的目标是以最少的杆数打完一组洞。一轮高尔夫球比赛通常包括 18 个洞。每个洞在标准高尔夫球场上一轮只打一次。每个杆计为一分,总杆数用于确定比赛的获胜者。解释和答案:"""# 模型根据生成的知识对问题进行回答

像这样先生成相关知识,再整合知识得出准确答案“不是,高尔夫球的目标是以最少杆数完成比赛,而非追求更高得分”,有效提升模型在常识推理任务的准确性。

六、链式提示(Prompt Chaining)

链式提示是将复杂任务拆解为多个子任务,通过逐个子任务生成提示并传递结果的方式来实现复杂任务的有序处理。以文档问答为例:

# 第一个提示用于提取相关引文"""你是一个很有帮助的助手。你的任务是根据文档回答问题。第一步是从文档中提取与问题相关的引文,由####分隔。请使用<quotes></quotes>输出引文列表。如果没有找到相关引文,请回应“未找到相关引文!”。#### {{文档}} ####"""# 假设这里有一个文档变量 doc,将其代入提示中进行处理# 处理后得到引文列表,假设为 quotes_list# 第二个提示根据引文和文档生成回答"""根据从文档中提取的相关引文(由<quotes></quotes>分隔)和原始文档(由####分隔),请构建对问题的回答。请确保答案准确、语气友好且有帮助。#### {{文档}} #### <quotes>{quotes_list}</quotes>"""# 模型根据第二个提示生成最终回答

这种方式提高了任务处理的准确性与可靠性,使得模型能够逐步深入地处理复杂问题。

七、思维树(ToT)

思维树框架是为了帮助模型应对复杂的探索性任务而设计的。它通过维护一棵思维树,让模型在解决问题时能够生成和评估中间思维步骤,并结合搜索算法进行系统性探索。示例如下:

# 假设给定数字为 4、9、10、13"""输入: 4 9 10 134 + 9 = 13 (left 10 13 13)10 - 4 = 6 (left 6 9 13)13 - 6 = 7 13 - 9 = 44 + 6 = 10 (left 7 9 4 * 6 = 24 (left 4 6)评估是否能得到 24: sure"""# 模型按照思维树的步骤进行推理和计算,并根据评估结果继续搜索或得出答案

八、检索增强生成(RAG)

检索增强生成(RAG)技术将信息检索与文本生成相结合,专门用于处理知识密集型任务。它通过检索相关文档来为模型提供额外的知识支持,从而缓解模型的“幻觉”问题。例如:

# 假设这里有一个检索函数 retrieve_documents 和一个生成答案的函数 generate_answer"谁是首次登上月球的人?""根据以下文档回答问题:"" 问题是:"# 最终得到的 answer 即为模型结合检索结果生成的答案

这有效确保答案基于可靠知识源,在自然问题、事实验证等基准测试中表现卓越。

九、自动推理并使用工具(ART)

自动推理并使用工具(ART)技术使模型能够自动生成包含推理步骤的程序,并在需要时调用外部工具。例如:

"""计算 16 个苹果平均分给 4 个人,每人几个,再加上 3 是多少?请生成解决这个问题的程序步骤。"""# 模型会生成类似下面的程序步骤# result = (16 / 4) + 3# 然后可以在代码中执行这个程序步骤得到最终答案

在 BigBench 和 MMLU 基准测试中,ART 在多种任务上表现突出,显著超越少样本提示和自动 CoT 等方法,提升了模型解决问题的能力和效率。

十、自动提示工程师(APE)

自动提示工程师(APE)技术能够自动生成和筛选任务指令。它通过利用大型语言模型生成指令候选项,再依据评估分数选择最佳指令,从而提升提示生成的效率与效果。比如:

# 假设这里有一个生成指令候选项的函数 generate_candidates 和一个选择最佳指令的函数 select_best_instruction"这里是一篇新闻文章的内容"" "# 模型根据最终的 prompt 生成文章总结

例如总结新闻文章时,它先利用大型语言模型生成如“提取文章关键人物、事件和时间”“概括文章主要内容并突出重点”等指令候选项,再依据评估分数选择最佳指令,指导模型生成高质量总结。

十一、Active-Prompt

Active-Prompt 技术主要用于解决思维链示例有效性的问题。它通过先查询模型生成多个答案,计算不确定度后挑选最不确定的问题由人类注释示例,再用新示例推断其他问题,从而优化模型对不同任务的适应性。比如:

# 假设这里有一个查询模型生成答案的函数 query_model 和一个计算不确定度的函数 calculate_uncertainty"对以下文本进行分类:这是一篇科技类文章。"# 生成 5 个答案if# 如果不确定度大于设定阈值# 选择最不确定的问题由人类注释示例,然后更新提示并重新查询模型else# 最终得到的 final_answer 即为经过 Active-Prompt 处理后的答案

通过这种方式,能够提高模型在文本分类等任务中的准确性。

十二、方向性刺激提示(Directional Stimulus Prompting)

方向性刺激提示通过训练策略 LM 生成引导提示,增强对模型生成结果的掌控力。例如文本摘要任务:

"这里是一篇文章的内容""请根据文章内容生成一个引导提示,重点关注文章的主要事件和结果。"# 策略 LM 会根据这个提示生成如“重点提取文章中事件的主体、发生的时间和最终结果”的引导提示# 然后可以将这个引导提示用于后续的文本摘要任务中

在文本摘要任务中,策略 LM 依据文章主题、关键信息等生成引导提示,指导模型生成符合需求的摘要,提升摘要质量。

十三、PAL(程序辅助语言模型)

PAL(程序辅助语言模型)技术让模型生成程序来解决问题,借助编程运行时提升解决复杂问题的能力。以日期计算问题为例:

"今天是 2023 年 2 月 27 日,我出生于 25 年前,我的出生日期是多少?""""import datetimefrom dateutil.relativedelta import relativedelta# Q: 2015 年在 36 小时后到来。从今天起一周后的日期是多少(格式为 MM/DD/YYYY)?# 如果 2015 年在 36 小时后到来,那么今天是 36 小时前。today = datetime(2015, 1, 1) - relativedelta(hours=36)# 从今天起一周后,one_week_from_today = today + relativedelta(weeks=1)# 格式化后的答案one_week_from_today.strftime('%m/%d/%Y')# Q: 今天是 2023 年 2 月 27 日,我出生于 25 年前,我的出生日期是多少?"""# 模型会生成类似下面的代码# today = datetime(2023, 2 27)# born = today - relativedelta(years=25)# born.strftime('%m/%d/%Y')# 然后可以在代码中执行模型生成的代码得到最终答案

十四、ReAct 框架

ReAct 框架使模型交错生成推理轨迹和操作,提升答案的可靠性与可解释性。以回答问题为例:

"除苹果遥控器外,哪些设备可控制其设计交互的程序?""""问题:除苹果遥控器外,哪些设备可控制其设计交互的程序?思考 1:我需要搜索苹果遥控器相关程序及可替代控制设备。操作 1:搜索 [苹果遥控器 可替代控制设备]观察 1:搜索结果为……思考 2:根据搜索结果,分析哪些设备符合要求。操作 2:筛选 [符合要求的设备]观察 2:筛选结果为……思考 3:整理最终答案。操作 3:整理 [最终答案]"""# 模型会按照提示中的推理轨迹和操作步骤进行处理,并最终得出答案

在知识密集型和决策任务中表现良好,通过与外部环境交互获取信息来辅助推理。

十五、自我反思(Reflexion)

自我反思框架包含参与者、评估者和自我反思三个模型,旨在帮助模型从错误中学习并提升性能。模拟编程任务的示例如下:

# 假设这里有参与者模型 actor、评估者模型 evaluator 和自我反思模型 reflexion"这里是一段初始代码"# 参与者模型生成尝试解决问题的代码和动作# 评估者模型评价输出# 自我反思模型根据评价结果生成改进建议# 将改进建议应用到下一次的代码生成中,实现自我学习和提升

如代码出现语法错误,自我反思模型会提示可能错误原因及修正方向,帮助模型快速学习。

附录

一、术语表

- Prompt:在大语言模型应用中,用于“提示”模型唤起特定能力以解决实际问题的提问方式,是prompt工程的核心。

- RTF框架:Role - Task - Format框架,通过指定角色、任务和格式规范大模型输出,简单通用。

- 思考链模式:在提示末尾添加“让我们逐步思考”,引导大模型逐步分析复杂任务,改善推理能力。

- RISEN框架:包含角色、指示命令、步骤、最终目标和缩小范围(约束条件),适合特定约束或明确指导方针的任务。

- RODES框架:涵盖角色、目标、详细细节、示例和感官检查的提示框架。

- 密度链模式:利用递归创建更好输出的提示,生成的摘要更密集且适合理解,适用于总结等任务。

- 少样本提示(Few - shot prompting):为模型提供少量任务示例,帮助其学习任务模式和规律,提升在复杂或特定格式任务中的表现。

- 零样本提示(Zero - Shot Prompting):模型在无特定任务示例展示下,依靠自身预训练知识和任务理解能力直接处理任务。

- 思维链提示(Chain - of - Thought Prompting):为模型展示详细推理过程,提升其在复杂推理任务中的表现,可与少样本提示结合。

- 自我一致性(Self - Consistency):通过提供多个少样本推理示例,让模型筛选最一致答案,增强在算术和常识推理任务中的可靠性。

- 生成知识提示(Generated Knowledge Prompting):先让模型生成与任务相关知识,再整合知识得出准确答案,解决模型处理需额外知识任务的局限性。

- 链式提示(Prompt Chaining):将复杂任务拆分为多个子任务,逐个子任务生成提示并传递结果,提高任务处理准确性与可靠性。

- 思维树(ToT):通过维护思维树,让模型生成和评估中间思维步骤,结合搜索算法应对复杂探索性任务。

- 检索增强生成(RAG):将信息检索与文本生成结合,检索相关文档为模型提供知识支持,缓解“幻觉”问题。

- 自动推理并使用工具(ART):使模型自动生成包含推理步骤的程序,并在需要时调用外部工具,提升解决问题能力和效率。

- 自动提示工程师(APE):利用大型语言模型生成指令候选项,依据评估分数选择最佳指令,提升提示生成效率与效果。

- Active - Prompt:先查询模型生成多个答案,计算不确定度后挑选最不确定问题由人类注释示例,优化模型对不同任务的适应性。

- 方向性刺激提示(Directional Stimulus Prompting):训练策略LM生成引导提示,增强对模型生成结果的掌控力,提升文本摘要等任务的质量。

- PAL(程序辅助语言模型):让模型生成程序来解决问题,借助编程运行时提升解决复杂问题的能力。

- ReAct框架:使模型交错生成推理轨迹和操作,提升答案的可靠性与可解释性,在知识密集型和决策任务中表现良好。

- 自我反思(Reflexion):包含参与者、评估者和自我反思三个模型,帮助模型从错误中学习并提升性能。

二、常见问题解答

1.如何选择合适的Prompt框架?

根据任务类型和需求选择。如简单对话场景可选用RTF框架;复杂分析任务可考虑思考链模式或RISEN框架;对输出格式有严格要求的,可在RTF、RISEN框架中关注格式或约束条件设定;进行总结类任务,密度链模式可能更合适。

2.为什么模型会出现“幻觉”现象?

模型虽经大量数据训练,但无法完美记住所有知识,也难以精准把握知识边界,面对复杂或生疏主题问题时,就可能编造看似合理但错误的内容。

3.如何利用少样本提示提升模型性能?

提供与任务相关、格式规范的成功示例,示例要涵盖任务的关键要素和模式,让模型学习示例中的规律和逻辑,从而在处理实际输入时生成更符合预期的结果。尤其适用于复杂任务或对输出格式有特定要求的情况。

4.链式提示在实际应用中有哪些优势?

将复杂任务拆解为子任务,使模型处理过程更清晰、有序,逐步深入解决问题,提高了任务处理的准确性与可靠性,避免模型在处理复杂问题时因任务过于复杂而出现混乱或错误。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。我们整理出这套 AI 大模型突围资料包:

- ✅ 从零到一的 AI 学习路径图

- ✅ 大模型调优实战手册(附医疗/金融等大厂真实案例)

- ✅ 百度/阿里专家闭门录播课

- ✅ 大模型当下最新行业报告

- ✅ 真实大厂面试真题

- ✅ 2025 最新岗位需求图谱

所有资料 ⚡️ ,朋友们如果有需要 《AI大模型入门+进阶学习资源包》,下方扫码获取~

① 全套AI大模型应用开发视频教程

(包含提示工程、RAG、LangChain、Agent、模型微调与部署、DeepSeek等技术点)

② 大模型系统化学习路线

作为学习AI大模型技术的新手,方向至关重要。 正确的学习路线可以为你节省时间,少走弯路;方向不对,努力白费。这里我给大家准备了一份最科学最系统的学习成长路线图和学习规划,带你从零基础入门到精通!

③ 大模型学习书籍&文档

学习AI大模型离不开书籍文档,我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

④ AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

⑤ 大模型项目实战&配套源码

学以致用,在项目实战中检验和巩固你所学到的知识,同时为你找工作就业和职业发展打下坚实的基础。

⑥ 大模型大厂面试真题

面试不仅是技术的较量,更需要充分的准备。在你已经掌握了大模型技术之后,就需要开始准备面试,我精心整理了一份大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

以上资料如何领取?

为什么大家都在学大模型?

最近科技巨头英特尔宣布裁员2万人,传统岗位不断缩减,但AI相关技术岗疯狂扩招,有3-5年经验,大厂薪资就能给到50K*20薪!

不出1年,“有AI项目经验”将成为投递简历的门槛。

风口之下,与其像“温水煮青蛙”一样坐等被行业淘汰,不如先人一步,掌握AI大模型原理+应用技术+项目实操经验,“顺风”翻盘!

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

以上全套大模型资料如何领取?

更多推荐

已为社区贡献170条内容

已为社区贡献170条内容

所有评论(0)