收藏!LLM、RAG、Agent三大AI架构详解:小白必学的区别与选择指南

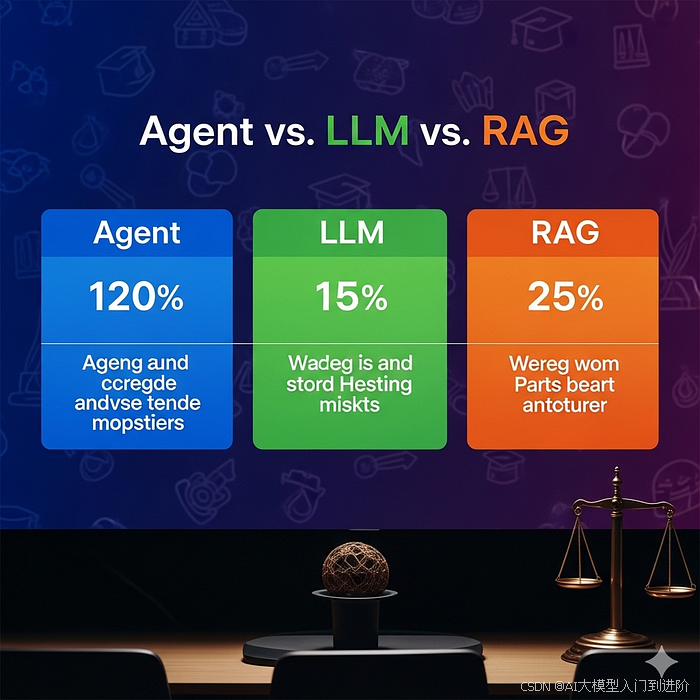

本文详细解析了人工智能领域三大主流架构:大语言模型(LLM)、检索增强生成(RAG)和AI智能体(Agent)。LLM是静态知识基础的文本生成系统;RAG结合LLM与外部知识检索,提供实时准确信息;Agent则是目标导向的自主智能系统,可多步骤规划并调用工具。文章从知识来源、任务复杂度、自主性等维度进行对比,并提供了不同场景下的选择指南和实施要点,帮助读者根据需求选择合适的AI解决方案。

相信很多热爱人工智能的小伙伴都常遇见Agent、LLM、RAG这三个单词,那么它们到底代表什么含义,有什么关联,又有什么区别呢?

今天我们一篇文章彻底理清!

人工智能领域正以前所未有的速度演进,当前三种截然不同的架构思路占据了主流话语权:大语言模型(LLM)、检索增强生成(RAG),以及 AI 智能体(AI Agents)。

尽管这些术语常被混用,但它们实际上代表了构建智能系统的三种根本不同的路径。对于任何从事AI研发或希望落地智能解决方案的人而言,厘清它们的区别、优势及适用场景至关重要。

大语言模型(LLM):基石

什么是 LLM?

大语言模型是基于海量文本数据训练而成的神经网络,能够理解和生成类人语言。它们本质上是高阶的模式识别系统,通过统计规律预测序列中的下一个词。

核心特征

• 静态知识:所有知识在训练阶段即被固化进模型参数;

• 纯文本交互:主要接口为自然语言;

• 生成能力:可依据提示创作全新内容;

• 上下文受限:只能在固定上下文窗口内工作;

• 无外接能力:无法获取训练数据之外的新信息;

LLM 如何工作?

LLM采用带注意力机制的Transformer架构来处理词元(token)序列,训练过程中,它们通过预测序列中的下一个词元,逐渐掌握语言模式、事实以及被编码在参数内的各种关系。

User Input: "Explain photosynthesis"LLM Process: Accesses embedded knowledge → Generates responseOutput: Detailed explanation based on training data

真实场景示例:内容创作

场景:健身公司的营销团队需要为博客策划新文章选题。

实施方式:

Prompt: "Generate 10 blog post ideas for a fitness company targeting beginners"

LLM Response:1. "5 Simple Exercises You Can Do at Home Without Equipment"2. "The Beginner's Guide to Understanding Macronutrients"3. "How to Build a Sustainable Workout Routine in 30 Days"... (continues with relevant ideas)

优势

• 快速:只需一条提示即可批量产出创意;

• 富有想象力:能给出出人意料的角度;

• 零额外基础设施:直接调用现成的 LLM 即可;

局限

• 可能流于通用:选题缺乏品牌个性或行业深度;

• 无实时数据:无法抓取最新健身潮流、热点或公司私有数据;

检索增强生成(RAG):让智能再升级

什么是 RAG?

RAG把大语言模型的生成能力与外部知识检索系统结合起来,相比仅依赖训练时固化的知识,RAG 可以实时访问并融合外部数据库、文档或知识库中的最新信息。

核心特征

• 动态知识:始终获取最新、最相关的信息;

• 两阶段流程:先检索,再生成;

• 事实准确:通过“有出处”的上下文显著降低幻觉;

• 领域定制:可针对特定行业或企业内部知识做深度优化;

• 来源可追溯:回答可直接引用原文,便于核查;

RAG 工作流程

- 查询处理:将用户问题转成向量(embedding);

- 检索:通过向量相似度搜索,召回最相关的文档或段落;

- 上下文组装:把检索到的内容整理成可供 LLM 使用的上下文;

- 生成:LLM 结合原始问题与检索到的上下文,生成最终回答;

User Query: "What's our company's Q3 revenue?"↓Retrieval System: Searches company documents↓Found Context: "Q3 2024 revenue: $2.3M, up 15% YoY"↓LLM Generation: Combines query + context → Response

真实场景示例:智能客服系统

场景:电商公司希望自动化客服,同时确保回答准确且信息实时更新。

实施方式:

- 构建知识库:将最新商品目录、价格、库存、退换货政策、物流状态等文档向量化并存储到向量数据库。

- 查询处理:顾客在聊天窗口输入问题(如“我的订单什么时候到?”),系统将其转为向量。

- 检索:通过向量相似度搜索,实时定位与该订单号或物流状态最相关的内部记录与政策条款。

- 上下文组装:把检索到的订单详情、物流节点、对应政策拼接成上下文。

- 生成回答:大语言模型结合顾客问题与检索到的实时信息,生成个性化、准确且带引用来源的回复。

优势

• 信息永不过时:始终基于最新数据进行回答;

• 企业级精准:答案贴合公司专属业务与政策;

• 显著降低幻觉:所有生成内容均可溯源到真实文档;

典型用例

• 技术文档问答;

• 法律文件分析;

• 医疗信息系统;

• 企业知识管理;

AI 智能体(Agent):自主智能

什么是 AI 智能体(Agent)?

AI 智能体(Agent)是能够感知环境、自主决策并采取行动以实现特定目标的系统。与仅对提示做出一次性回应的LLM 不同,智能体可以规划多步工作流、调用工具、并根据反馈动态调整行为。

核心特征

• 目标导向:围绕明确目标持续工作;

• 工具调用:可与外部系统、API 交互;

• 多步规划:将复杂任务拆解为子任务;

• 记忆能力:跨会话保持上下文;

• 自主决策:无需人工每一步干预;

AI 智能体的工作循环

- 感知:分析当前状态与可用信息;

- 规划:确定达成目标的步骤;

- 工具选择:挑选合适的工具或动作;

- 执行:实施动作并收集结果;

- 评估:检查进展并调整策略;

Goal: "Book a flight from NYC to LA for next Friday under $300"↓Agent Planning:1. Search flight prices2. Compare options3. Check calendar for conflicts4. Make reservation if criteria met↓Tool Usage: Flight APIs, calendar integration, payment processing

真实场景示例:研究助理智能体

场景:一家风险投资公司需要对可再生能源领域的潜在投资机会进行深度调研。

实施方式:

- 目标设定:智能体接收“本周内生成可再生能源初创公司的投资简报”这一目标。

- 感知:解析当前任务列表、已有的公司名单及最新行业关键词。

- 规划:

• 子任务 1 → 搜索并过滤近 3 个月获得种子轮至 B 轮融资的初创公司;

• 子任务 2 → 抓取这些公司的官网、Crunchbase、PitchBook 等公开数据;

• 子任务 3 → 汇总市场规模、竞争格局、技术路线、创始团队背景;

• 子任务 4 → 生成评分模型并排序,输出 PDF 报告与可视化图表。 - 工具调用:

• 网络搜索 API(实时抓取融资新闻、专利数据库)

• 财务数据 API(获取营收预测、估值区间)

• 报告生成插件(自动生成带图表的 PPT/PDF)

• 邮件/Slack API(向合伙人推送每日进度摘要) - 执行与迭代:

• 每完成一个子任务,将结果写入长期记忆向量库;

• 根据合伙人反馈调整评分权重,重新排序候选公司;

• 最终交付一份实时更新的可再生能源投资白皮书,并自动安排投决会演示日程。

# Simplified agent workflowclass ResearchAgent: def __init__(self): self.tools = [web_search, pdf_analyzer, database_query, report_generator] self.memory = ConversationMemory()

def research_company(self, company_name): # Step 1: Gather basic information company_info = self.web_search(f"{company_name} renewable energy")

# Step 2: Financial analysis financials = self.database_query("financial_data", company_name)

# Step 3: Competitive analysis competitors = self.analyze_market_position(company_name)

# Step 4: Generate investment report report = self.report_generator.create_report({ 'company': company_info, 'financials': financials, 'competition': competitors })

return report

智能体执行流程

研究阶段

• 同时检索公开数据库、行业报告、新闻源、专利库等多源信息,收集候选公司的融资、技术、团队、市场数据。

分析阶段

• 调用财务模型 API,评估收入增长率、现金流、估值倍数;

• 利用市场情报工具,对比竞品市占率、技术壁垒与政策风险;

• 依据预设评分规则,为每家公司生成健康度、成长潜力、风险等级量化分值。

综合阶段

• 将量化评分与定性洞察(团队背景、专利优势)整合成结构化投资要点;

• 自动生成 SWOT、Boston Matrix 等可视化图表。

呈现阶段

• 调用报告模板引擎,输出包含图表、投资建议、风险提示的 PDF / PPT;

• 通过邮件或 Slack 自动推送给合伙人,并附带可交互的数据看板链接。

结果:完整的投资分析全流程无人化完成,为分析师节省 10–15 小时的人工研究时间。

横向对比

| 维度 | LLM | RAG | Agent |

|---|---|---|---|

| 知识来源 | 静态(训练数据) | 动态(外部检索) | 动态 + 工具调用 |

| 任务复杂度 | 简单到中等 | 中等 | 复杂多步骤 |

| 自主性 | 低(依赖提示) | 中(依赖检索) | 高(目标驱动) |

| 实时数据 | 无 | 有 | 有 |

| 工具集成 | 无 | 有限 | 广泛 |

| 规划能力 | 无 | 无 | 有 |

何时选用

选 LLM

• 需要快速文本生成或改写;

• 任务无需外部数据;

• 追求极简与低成本;

示例:内容写作、代码补全、头脑风暴;

选 RAG

• 必须保证信息最新、准确;

• 面向特定领域知识库;

• 需要降低幻觉、可溯源;

示例:客服问答、技术文档、知识库检索;

选 Agent

• 任务需多步骤、多工具协同;

• 需要长时间自主运行;

• 涉及复杂决策与系统集成;

示例:虚拟助手、自动化研究、工作流自动化;

实施要点

LLM 实现要点:

# Simple LLM usageresponse = openai.ChatCompletion.create( model="gpt-4", messages=[{"role": "user", "content": "Write a product description for..."}])

RAG实现:

# RAG system componentsclass RAGSystem: def __init__(self): self.embeddings = SentenceTransformer('all-MiniLM-L6-v2') self.vector_store = ChromaDB() self.llm = ChatOpenAI()

def query(self, question): # Retrieve relevant documents docs = self.vector_store.similarity_search(question) # Generate response with context response = self.llm.invoke(f"Context: {docs}\nQuestion: {question}") return response

Agent实现:

# Agent with tool usageclass ResearchAgent: def __init__(self): self.llm = ChatOpenAI() self.tools = [SearchTool(), AnalysisTool(), ReportTool()] self.memory = ConversationBuffer()

def execute(self, goal): plan = self.create_plan(goal) for step in plan: result = self.use_tool(step) self.memory.add(step, result) return self.synthesize_results()

成本与性能对比

• LLM

- 成本:低至中等(按 token 计费);

- 延迟:快(单次 API 调用);

- 可扩展性:高(无状态);

• RAG

- 成本:中等(检索 + 生成双重计费);

- 延迟:中等(需检索开销);

- 可扩展性:中等(受向量数据库规模影响);

• Agent

- 成本:高(多工具调用、长会话);

- 延迟:慢(多步骤执行);

- 可扩展性:低(需复杂状态管理);

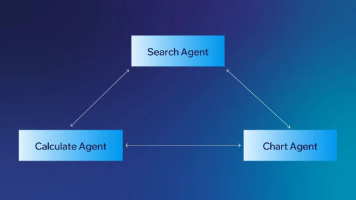

混合架构与未来趋势

现代 AI 系统常将三者融合:

• RAG + Agent:智能体在执行知识密集型任务时调用 RAG,实现“检索-决策-行动”闭环。

class SmartAgent: def __init__(self): self.rag_system = RAGSystem() self.tools = [calculator, web_search, email_sender]

def handle_query(self, query): if self.needs_external_knowledge(query): return self.rag_system.query(query) elif self.needs_tools(query): return self.use_tools(query) else: return self.llm_response(query)

多智能体 RAG(Multi-Agent RAG):

由多个各司其职的专业智能体共用同一知识库,协同完成复杂任务。

• 检索智能体:负责实时拉取并更新外部知识;

• 分析智能体:对检索结果进行领域化评估与过滤;

• 决策智能体:基于共享记忆制定下一步行动;

• 执行智能体:调用工具或生成最终输出。

通过共享向量知识库与统一状态存储,各智能体既保持专业分工,又能避免信息孤岛,实现高效协作与持续学习。

class MultiAgentSystem: def __init__(self): self.knowledge_base = SharedRAGSystem() self.agents = { 'research': ResearchAgent(self.knowledge_base), 'analysis': AnalysisAgent(self.knowledge_base), 'writing': WritingAgent(self.knowledge_base) }

新兴趋势

• 多模态融合:系统同时处理文本、图像与音频;

• 联邦学习:无需集中数据即可实现分布式知识共享;

• 自适应架构:系统根据查询类型自动选择 LLM / RAG / Agent 方案;

• 边缘部署:在本地运行以满足隐私与低延迟需求;

以上就是RAG vs Agent vs LLM全部内容,欢迎大家评论区留言讨论!

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)