字节深夜开源 Seed-OSS:512K 超长上下文实力亮相,长度较主流模型劲增 4 倍!

字节跳动Seed团队开源大模型Seed-OSS-36B,具备长文本、推理和智能体能力。该360亿参数模型支持512K上下文,采用GQA注意力机制,在MMLU、GSM8K等基准测试中表现优异。特色功能包括可调节思维预算控制,用户能根据任务复杂度调整推理长度。模型以Apache-2.0许可证开放商用,并提供含/不含合成指令数据的两个版本。Seed-OSS-36B在知识、数学、编程等任务上表现突出,如M

字节 Seed 团队开源首个 LLM:Seed-OSS-36B。该模型具备长上下文、推理、智能体和通用能力,开发者友好,而且还主要针对国际化场景进行了优化。尽管仅用 12T 数据训练,依然在多项主流基准上表现优异,并以 Apache-2.0 许可证开放商用。

核心特性

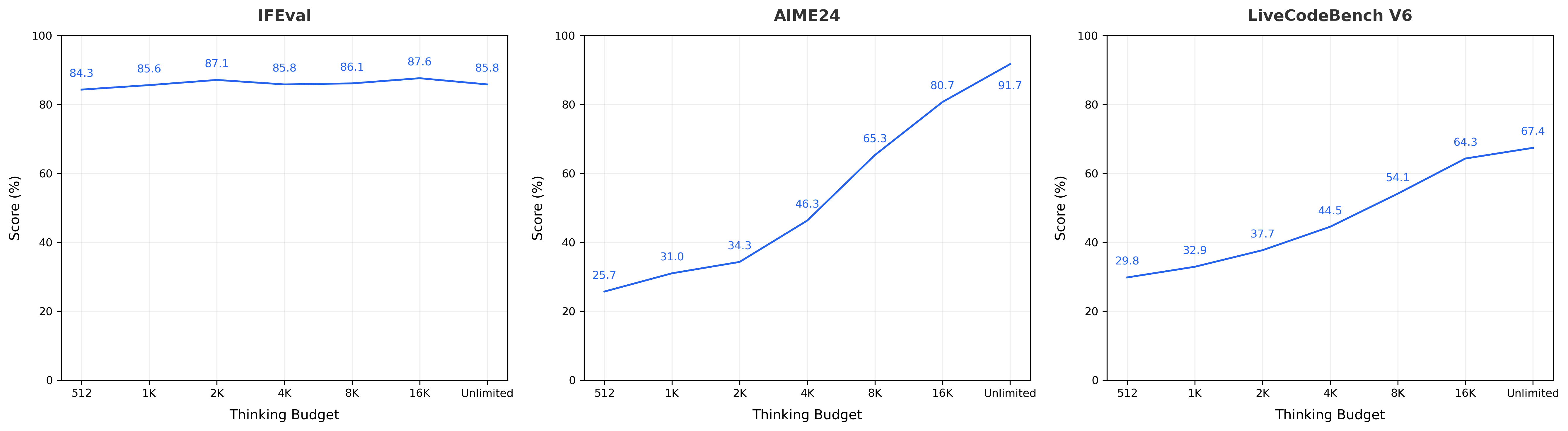

- 灵活的思维预算控制:允许用户根据需求灵活调整推理长度,这一动态控制推理长度的能力提升了实际应用场景中的推理效率。例如,对于简单任务,可设置较短预算;复杂任务则可延长预算。

- 增强的推理能力:在推理任务上进行了专门优化,同时保持了均衡且出色的通用能力,在 BBH、AGIEval-en 等推理相关基准测试中成绩较好。

- 智能代理能力:在工具使用和问题解决等代理任务中表现卓越,如在 TAU1-Retail 等代理相关测试里有突出表现。

- 研究友好性:考虑到预训练中合成指令数据的加入可能影响训练后研究,团队发布了包含和不包含指令数据的两种预训练模型,为研究社区提供了更多样化的选择。

- 原生长上下文:原生支持高达 512K 的长上下文,在 RULER(128K)等长上下文测试中表现出色。

模型架构方面,Seed-OSS采用了成熟稳定的设计:

360亿参数的稠密模型(不是MoE),使用了RoPE位置编码、GQA注意力机制、RMSNorm归一化和SwiGLU激活函数。整个模型有64层,隐藏层维度5120,词汇表大小155K。

| 参数 | 详情 |

|---|---|

| 参数规模 | 36B |

| 注意力机制 | GQA |

| 激活函数 | SwiGLU |

| 层数 | 64 |

| QKV 头数 | 80 / 8 / 8 |

| 头大小 | 128 |

| 隐藏层大小 | 5120 |

| 词汇表大小 | 155K |

| 上下文长度 | 512K |

| RoPE 基础频率 | 1e7 |

Seed-OSS-36B一大特色是支持用户设置thinking budget参数来灵活指定模型的思考预算,和谷歌的Gemini 2.5 Flash一样。下图展示了在不同任务下,随着思考预算变化的性能曲线。对于较简单的任务(如 IFEval),模型的链式思维(CoT)较短,分数在思考预算增加时会出现波动;而在更具挑战性的任务(如 AIME 和 LiveCodeBench)中,模型的 CoT 更长,分数会随着思考预算的增加而提升。

eed-OSS-36B-Base

在多数基准测试中,预训练加入合成指令数据能提升性能,以下是部分关键基准测试结果:

- 知识类:MMLU-Pro 得 65.1 分,MMLU 得 84.9 分,TriviaQA 得 82.1 分。

- 推理类:BBH 得 87.7 分,AGIEval-en 得 70.7 分。

- 数学类:GSM8K 得 90.8 分,MATH 得 81.7 分。

- 编程类:MBPP 得 80.6 分,HumanEval 得 76.8 分 。

| Benchmark | Seed1.6-Base | Qwen3-30B-A3B-Base-2507* | Qwen2.5-32B-Base* | Seed-OSS-36B-Base (w/ syn.) |

Seed-OSS-36B-Base-woSyn (w/o syn.) |

|---|---|---|---|---|---|

| Knowledge | |||||

| MMLU-Pro | 70 | 59.8 | 58.5 (55.1) | 65.1 | 60.4 |

| MMLU | 88.8 | 82.7 | 84 (83.3) | 84.9 | 84.8 |

| TriviaQA | 91 | 76.2 | 76 | 82.1 | 81.9 |

| GPQA-D | 43.4 | 37 | 29.3 | 31.7 | 35.2 |

| SimpleQA | 17.1 | 7.2 | 6.1 | 5.8 | 7.4 |

| Reasoning | |||||

| BBH | 92.1 | 81.4 | 79.1 (84.5) | 87.7 | 87.2 |

| AGIEval-en | 78 | 66.4 | 65.6 | 70.7 | 70.1 |

| Math | |||||

| GSM8K | 93.1 | 87 | 87.5 (92.9) | 90.8 | 90.3 |

| MATH | 72.9 | 61.1 | 63.5 (57.7) | 81.7 | 61.3 |

| Coding | |||||

| MBPP | 83.6 | 78.8 | 77.8 (84.5) | 80.6 | 74.6 |

| HumanEval | 78 | 70.7 | 47.6 (58.5) | 76.8 | 75.6 |

同时也发布了不含合成指令数据的 Seed-OSS-36B-Base-woSyn 模型,其在部分测试中成绩与含合成数据模型接近,如 MMLU 得 84.8 分。

Seed-OSS-36B-Instruct

在与其他模型的对比中表现亮眼,部分关键结果如下:

- 知识类:MMLU-Pro 得 82.7 分,MMLU 得 87.4 分。

- 数学类:AIME24 得 91.7 分,AIME25 得 84.7 分,BeyondAIME 得 65 分。

- 推理类:ArcAGI V2 得 40.6 分,KORBench 得 70.6 分。

- 编程类:LiveCodeBench v6 得 67.4 分。

- 指令遵循类:IFEval 得 85.8 分。

- 代理类:TAU1-Retail 得 70.4 分,SWE-Bench Verified (OpenHands) 得 56 分 。

- 多语言类:MMMLU 得 78.4 分。

- 长上下文类:RULER (128K) 得 94.6 分。

- 安全类:AIR-Bench 得 75.6 分。

| Benchmark | Seed1.6-Thinking-0715 | OAI-OSS-20B* | Qwen3-30B-A3B-Thinking-2507* | Qwen3-32B* | Gemma3-27B | Seed-OSS-36B-Instruct |

|---|---|---|---|---|---|---|

| Knowledge | ||||||

| MMLU-Pro | 86.6 | 76.2 | 81.9 (80.9) | 81.8 | 67.5 | 82.7 |

| MMLU | 90.6 | 81.7 (85.3) | 86.9 | 86.2 | 76.9 | 87.4 |

| GPQA-D | 80.7 | 72.2 (71.5) | 71.4 (73.4) | 66.7 (68.4) | 42.4 | 71.4 |

| SuperGPQA | 63.4 | 50.1 | 57.3 (56.8) | 49.3 | - | 55.7 |

| SimpleQA | 23.7 | 6.7 | 23.6 | 8.6 | 10 | 9.7 |

| Math | ||||||

| AIME24 | 90.3 | 92.7 (92.1) | 87.7 | 82.7 (81.4) | - | 91.7 |

| AIME25 | 86 | 90.3 (91.7) | 81.3 (85) | 73.3 (72.9) | - | 84.7 |

| BeyondAIME | 60 | 69 | 56 | 29 | - | 65 |

| Reasoning | ||||||

| ArcAGI V2 | 50.3 | 41.7 | 37.8 | 14.4 | - | 40.6 |

| KORBench | 74.8 | 72.3 | 70.2 | 65.4 | - | 70.6 |

| Coding | ||||||

| LiveCodeBench v6 (02/2025-05/2025) |

66.8 | 63.8 | 60.3 (66) | 53.4 | - | 67.4 |

| HLE | 13.9 | 12.7 (10.9) | 8.7 | 6.9 | - | 10.1 |

| Instruction Following | ||||||

| IFEval | 86.3 | 92.8 | 88 (88.9) | 88.4 (85) | 90.4 | 85.8 |

| Agent | ||||||

| TAU1-Retail | 63 | (54.8) | 58.7 (67.8) | 40.9 | - | 70.4 |

| TAU1-Airline | 49 | (38) | 47 (48) | 38 | - | 46 |

| SWE-Bench Verified (OpenHands) |

41.8 | (60.7) | 31 | 23.4 | - | 56 |

| SWE-Bench Verified (AgentLess 4*10) |

48.4 | - | 33.5 | 39.7 | - | 47 |

| Multi-SWE-Bench | 17.7 | - | 9.5 | 7.7 | - | 17 |

| Multilingualism | ||||||

| MMMLU | 84.3 | 77.4 (75.7) | 79 | 79 (80.6) | - | 78.4 |

| Long Context | ||||||

| RULER (128K) |

94.5 | 78.7 | 94.5 | 77.5 | - | 94.6 |

| Safety | ||||||

| AIR-Bench | - | - | - | - | - | 75.6 |

快速上手

1 、安装依赖

pip3 install -r requirements.txt

pip install git+ssh://git@github.com/Fazziekey/transformers.git@seed-oss

2、基础使用代码示例

from transformers import AutoModelForCausalLM, AutoTokenizer

import os

import re

model_name_or_path = "ByteDance-Seed/Seed-OSS-36B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name_or_path)

model = AutoModelForCausalLM.from_pretrained(model_name_or_path, device_map="auto") # 可根据需求使用 bfloat16 和/或移至 GPU

messages = [

{"role": "user", "content": "How to make pasta?"},

]

tokenized_chat = tokenizer.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_tensors="pt",

thinking_budget=512 # 控制思维预算

)

outputs = model.generate(tokenized_chat.to(model.device), max_new_tokens=2048)

output_text = tokenizer.decode(outputs[0])

Seed-OSS-36B 仅仅是字节跳动进军开源大模型领域的起点,后续其大概率还会推出更多开源模型

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)