Dify+DeepSeek-R1: 我的超强AI工作流,详细的部署与使用实录,看到就是赚到!!

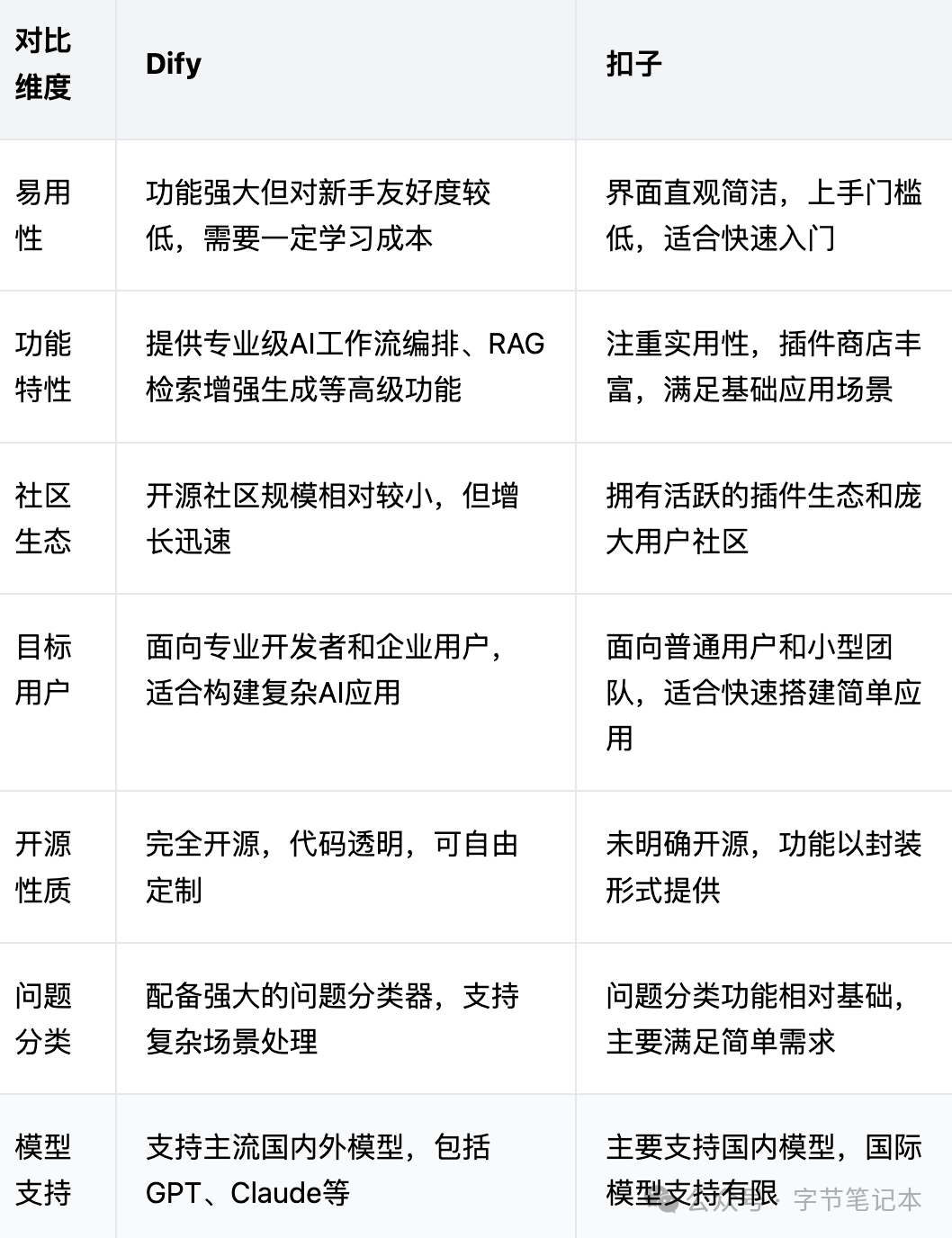

Dify是一个开源的LLM应用开发平台,它通过直观的可视化界面,帮助开发者快速构建和部署AI应用,支持包括模型管理、知识库、工作流编排等全方位功能,你可以把它理解为一个类似于扣子的"AI应用的乐高积木系统"。

Dify是何方神圣?

—

Dify是一个开源的LLM应用开发平台,它通过直观的可视化界面,帮助开发者快速构建和部署AI应用,支持包括模型管理、知识库、工作流编排等全方位功能,你可以把它理解为一个类似于扣子的"AI应用的乐高积木系统"。

来!安装试试看

—

在开始安装之前,我们需要确保系统满足以下基本要求:

- CPU至少2核心

- 内存至少4GB(建议8GB以上)

- 硬盘空间至少20GB(为了后续扩展)

- 操作系统支持:Windows、macOS或Linux

- Docker环境(Windows用户建议开启WSL2)

1. dify的安装步骤

首先,让我们来安装dify。虽然有多种部署方式,但我建议使用Docker方式部署,这样最简单稳妥也最不容易出错:

- 下载代码:

git clone https://github.com/langgenius/dify.git

cd dify/docker

- 配置环境:

cp .env.example .env

- 启动服务:

如果你使用的是Docker Compose V2:

docker compose up -d

如果是V1版本:

docker-compose up -d

安装完成后,通过以下命令检查服务状态:

docker compose ps

检查要特别关注以下几个关键容器的状态:

- docker-api-1:API服务

- docker-web-1:Web界面

- docker-worker-1:后台任务处理

- docker-db-1:数据库

- docker-redis-1:缓存服务

- docker-nginx-1:反向代理

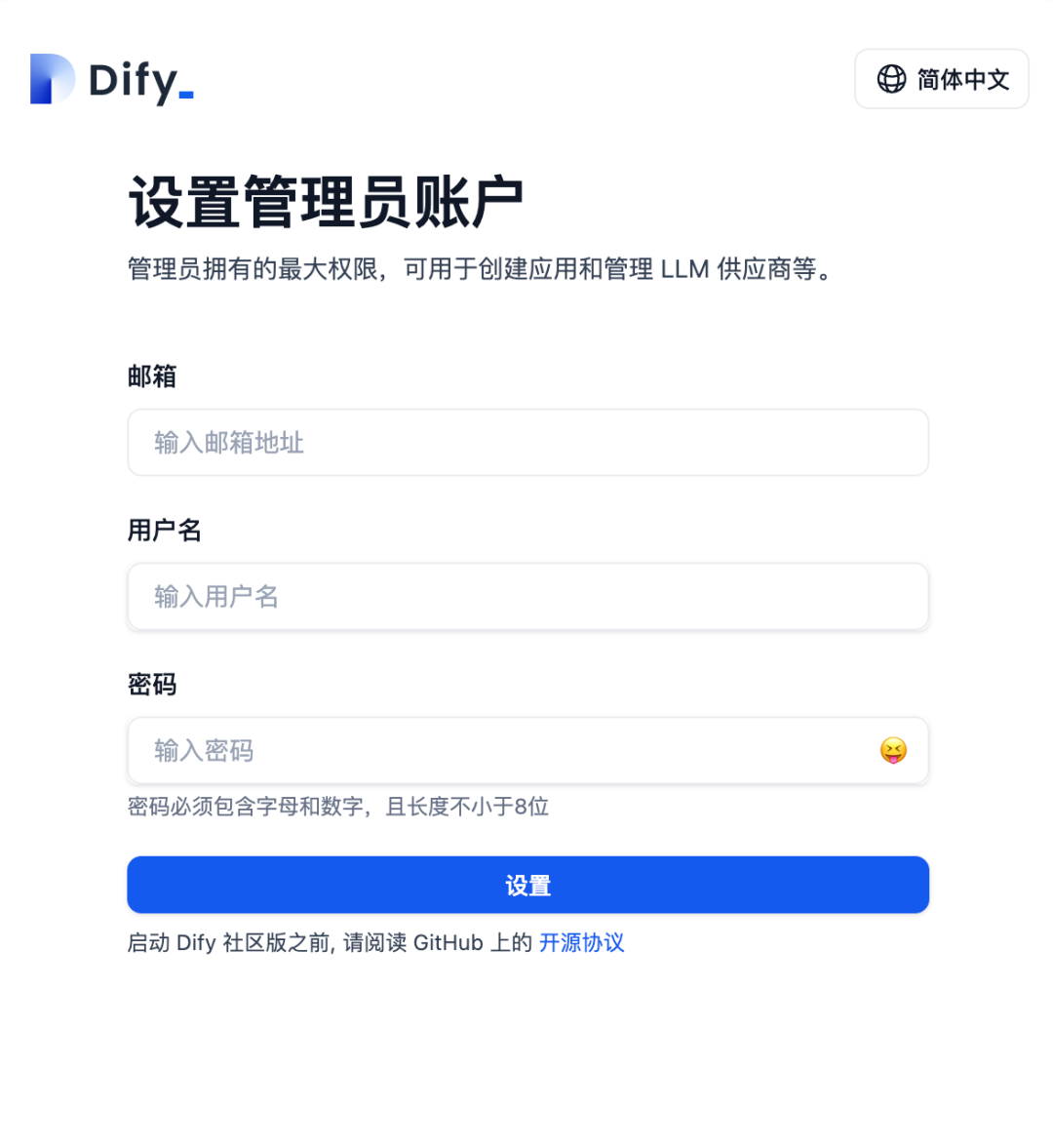

所有容器都应该显示"Up"状态。然后我们可以通过浏览器访问:

http://localhost/install

2. deepseek-r1的部署

接下来是安装deepseek-r1。这个过程相对简单,但需要注意一些细节:

- 安装Ollama:Windows用户:从官网下载安装包.Linux用户:使用curl安装

curl -fsSL https://ollama.ai/install.sh | bash

- macOS用户:使用Homebrew安装

brew install ollama

安装完成后,打开终端验证:

ollama -v

- 下载deepseek-r1模型:基础版本(推荐新手使用):

ollama run deepseek-r1:7b

高性能版本(需要较好的硬件配置):

ollama run deepseek-r1:14b

下载过程可能需要一段时间,取决于你的网络速度。7b版本大约需要4.7GB空间,14b版本需要约9GB空间。

3. 系统联调与配置

现在两个系统都装好了,需要进行整合配置:

dify基础配置:打开.env文件,配置以下关键参数:

CONSOLE_URL=http://localhost

SERVICE_API_URL=http://localhost

UPLOAD_FILE_SIZE_LIMIT=50 # 文件上传限制,单位MB

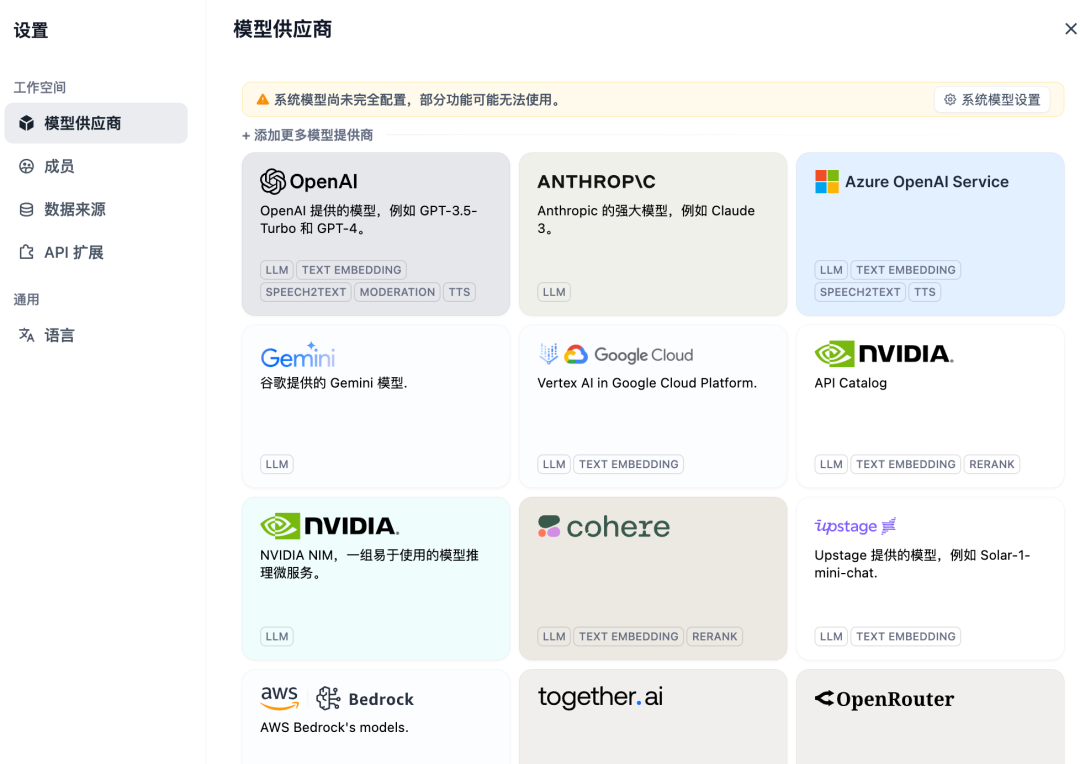

UPLOAD_FILE_MIME_TYPES=.pdf,.doc,.docx,.txt # 允许上传的文件类型在dify控制台中添加模型配置:访问http://localhost,完成注册,登录后进入Settings → Model Provider添加Local Model配置,这里选择ollama就可以了

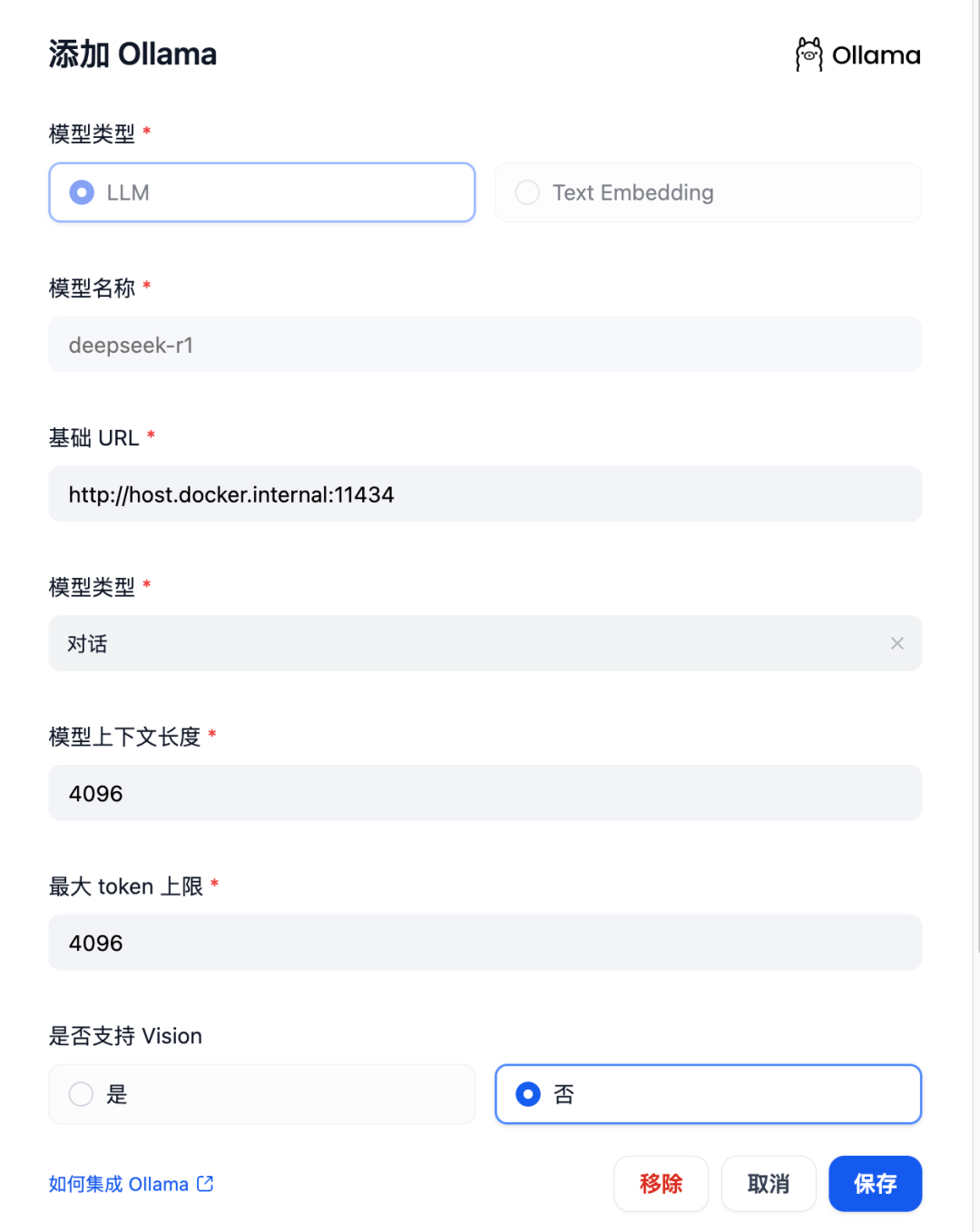

选择API格式为Ollama,相关的配置如下,因为我是使用的docker来进行部署的,访问部宿主机的地址记得使用host.docker.internal这个地址,你也可以使用你局域网电脑中的网址!

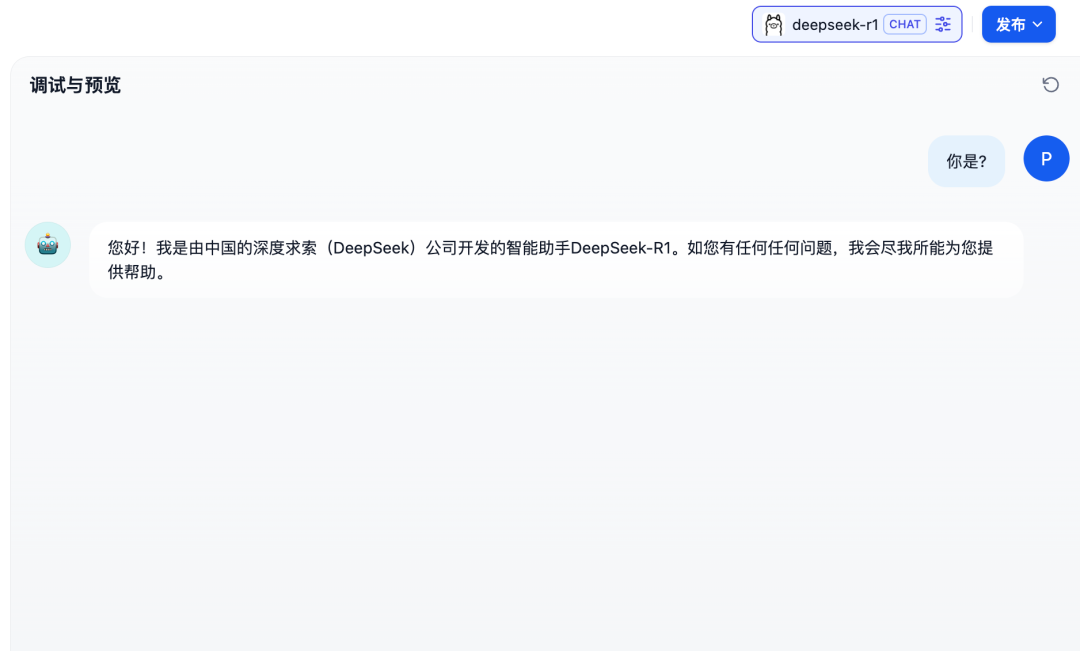

测试整合,来创建一个简单的聊天会话应用创建一个新的应用

选择刚配置的deepseek-r1模型,我发送测试消息发送测试消息验证响应

实战应用案例

—

现在来分享一些实际应用场景和具体的操作步骤。

智能文档案例

什么是知识库?知识库就像是一个智能的企业大脑,你可以往里面放入公司的各种资料,比如产品手册、培训文档、客户案例等。当有人需要找什么信息时,不用再到处问同事或者翻文件夹,直接在知识库里搜索就能快速找到答案。它最大的特点是可以帮你管理和查找各种资料,让公司的知识经验能够保存下来,新员工也能更快上手工作。

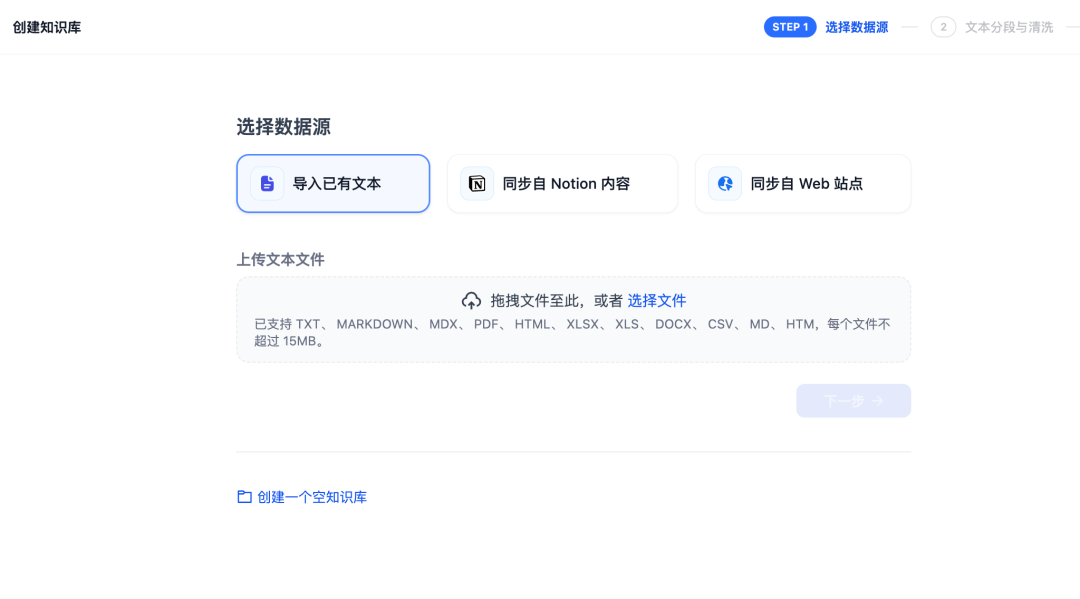

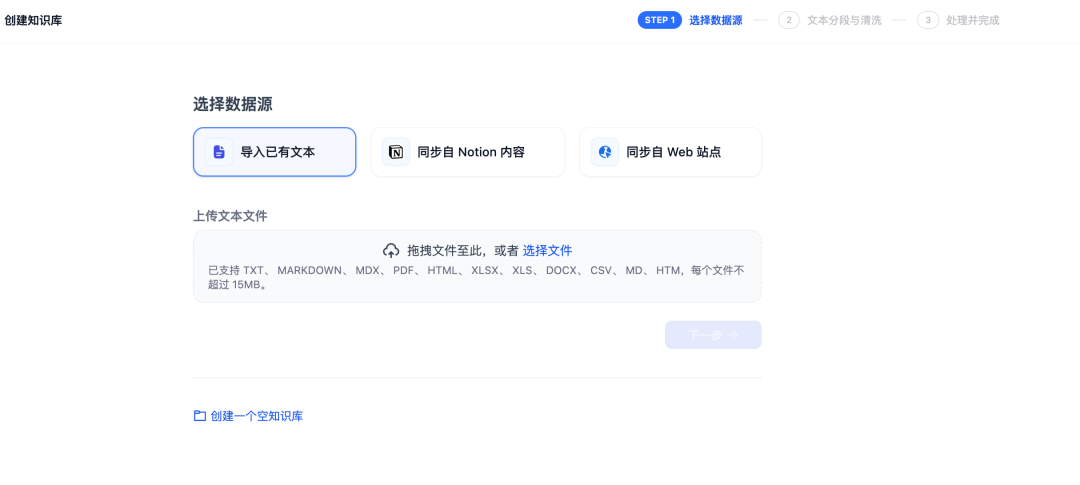

创建知识库:进入dify控制台,选择"Dataset"→"Create New",上传文档文件,这里的文档支持多种格式,也支持从notion当中导入,还可以同步外部的站点

设置索引参数和检索规则,这里我推荐使用 nomic-embed-text:latest作为你的文件嵌入模型,也是使用 ollama来拉取和运行,pull一下就可以了,完全不用操心其他的操作!

设置索引参数和检索规则,这里我推荐使用 nomic-embed-text:latest作为你的文件嵌入模型,也是使用 ollama来拉取和运行,pull一下就可以了,完全不用操心其他的操作!

ollama pull nomic-embed-text

完成上面的步骤之后,我们就可以导入自己需要检索的文档。在后面的对话或者工作流中直接引用

工作流案例

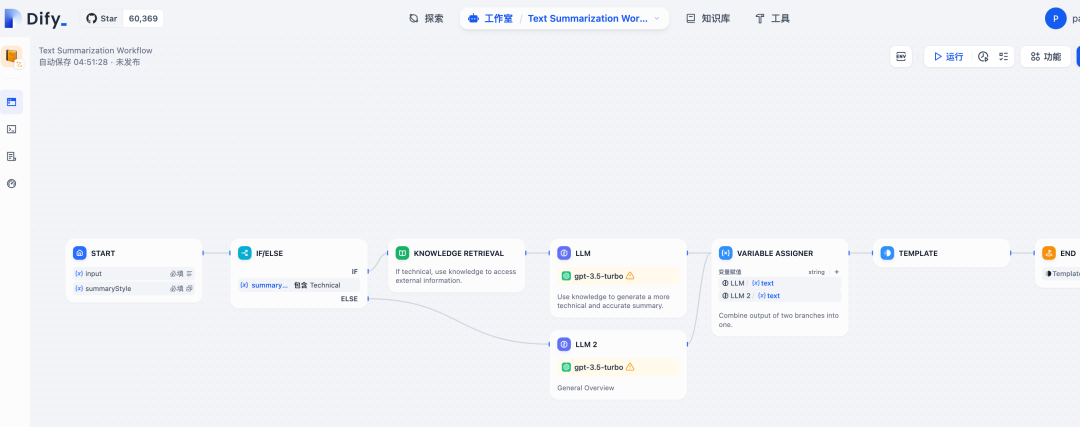

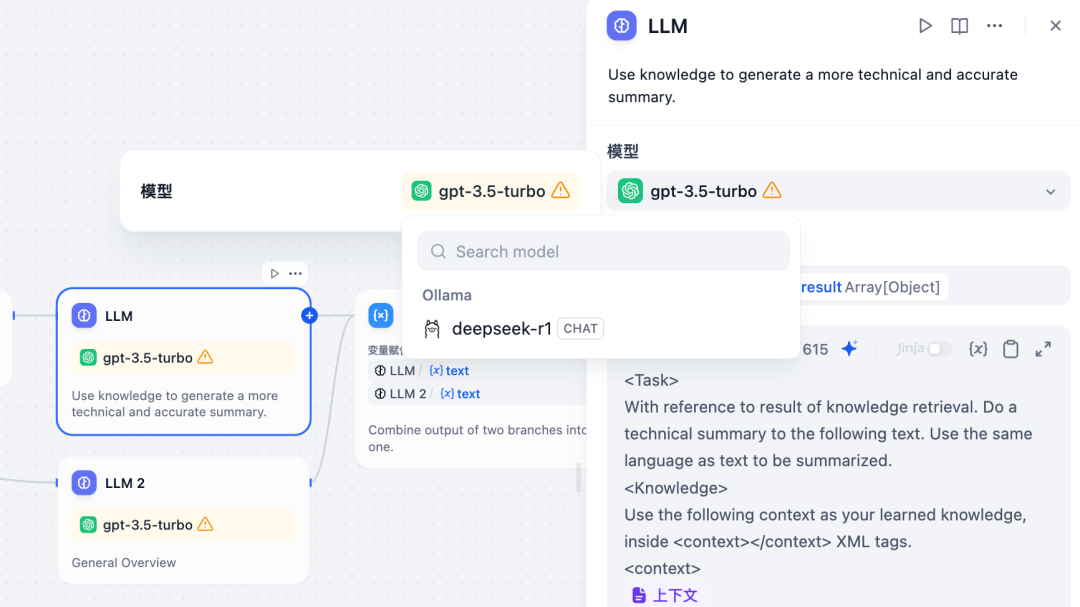

配置工作流:创建新的Workflow,我这里直接选择一个已有的工作流: 文档总结工作流

然后添加文档处理节点,这里只需把之前的GPT3.5换成DeepSeek-R1就可以了

然后添加文档处理节点,这里只需把之前的GPT3.5换成DeepSeek-R1就可以了

操作步骤如下:

当然你也可以自定义设置提示词模板:

任务:分析以下文档并提取关键信息

文档内容:{{context}}

要求:

1. 提取主要观点

2. 总结关键数据

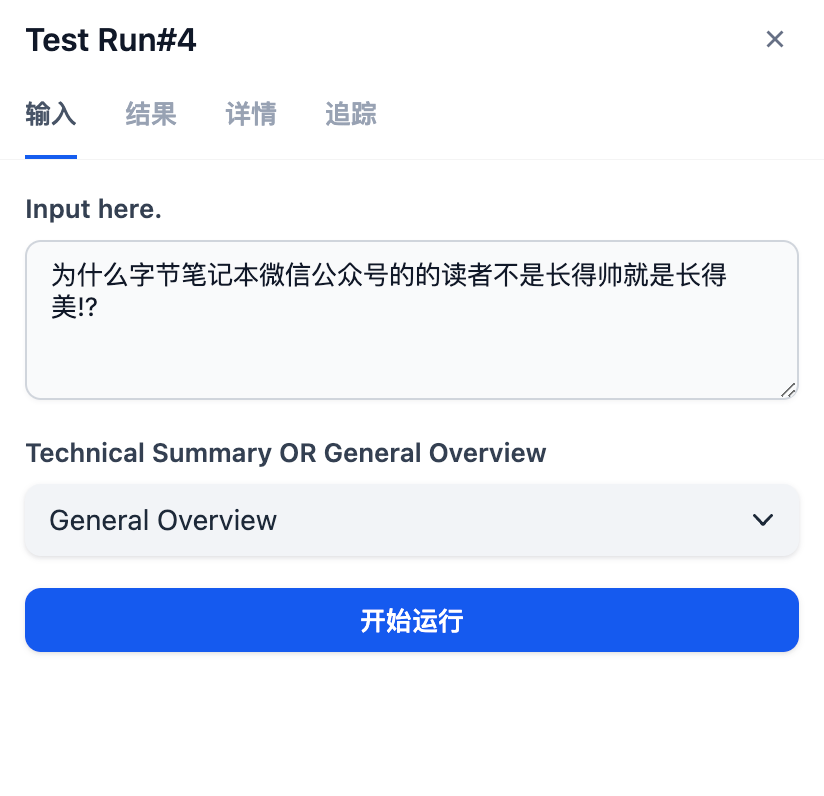

3. 生成行动建议之之后击运行输入要总结的内容

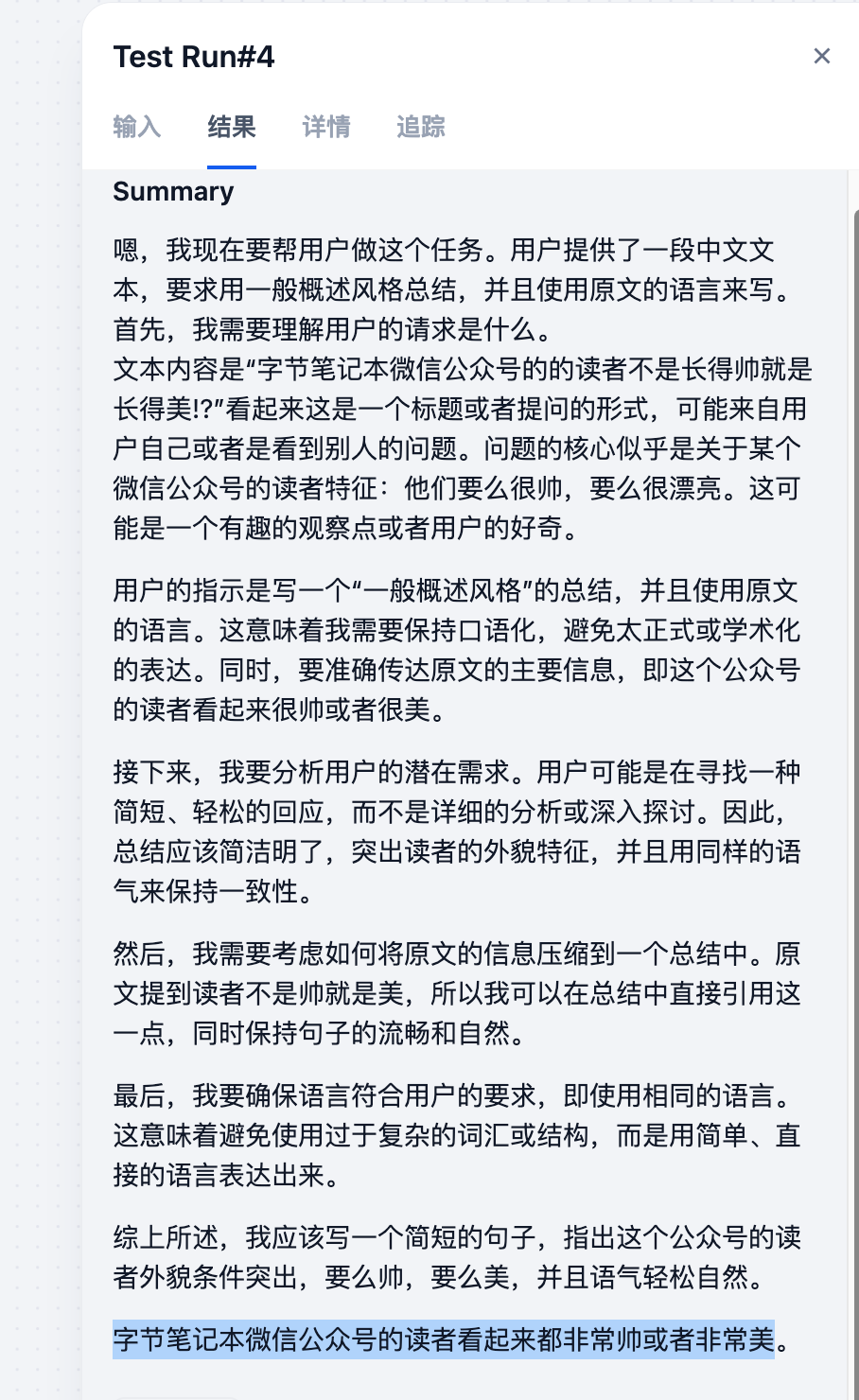

最后的运行结果是:

最后

—

上面演示的只是Dify最简单的聊天应用知识库和工作流的使用,还有更多的功能和工作流值得您挖掘,更多高级的用法

玩Dify的工作流本身就像搭积木一样,用它来搭建各种有趣的 AI 应用。比如做一个智能客服,帮你自动回答客户的问题;或者做个私人助理,帮你整理文档、写邮件、做会议记录;甚至可以做个创意助手,帮你写文案、做营销策划、设计广告语。

你不需要写复杂的代码,只要像拖拽积木一样,把不同的功能模块组合在一起,就能做出你想要的应用。它就像是给你一套 AI 魔法工具,让你能轻松地把脑子里的想法变成现实。

而且扣子能做的,它统统都能做!

因为deepseek已经把开源的威力充分的展示给大家看了!相信随着AI技术的快速发展,dify和deepseek-r1的结合使用将会迎来更多可能性!

最后的最后

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)