简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

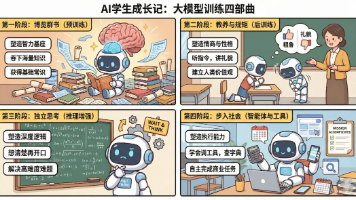

本文以"培养天才学生"为比喻,详解大模型训练四阶段:预训练(构建基础知识)、后训练对齐(学习人类价值观)、推理增强(提升逻辑能力)、智能体阶段(工具调用与执行)。通过Transformer、MoE、SFT、RLHF等核心技术,模型从"百科全书"进化为能解决实际问题的智能助手。这种深入浅出的解析,让读者理解大模型从数据到智能的完整蜕变过程。

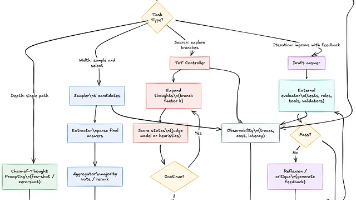

文章介绍了大语言模型(LLM)的四种推理时计算技术:链式思维推理(CoT)通过深度思考提升推理能力;自洽性采样(SC)通过多数投票提高答案可靠性;思维树探索(ToT)采用搜索策略找到最优解;反思与自我改进(SR)通过迭代优化答案。这些技术无需重新训练模型,仅在推理阶段增加计算投入,就能显著提升LLM在数学推理、编程和规划等任务上的表现,但需注意成本与适用场景的平衡。

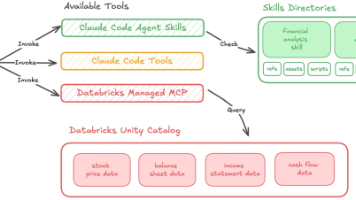

文章介绍AI自动化三大核心组件:Agent(决策执行核心)、MCP(标准化通信协议)和Skill(可复用能力模块)。三者构成"决策-通信-执行"闭环,解决工具调用标准化、任务自主推进、上下文控制与能力复用等痛点,推动AI从单点工具向可协同自动化系统演进,为2026年AI自动化发展提供技术基础。

近年,类似于ChatGPT的大语言模型(Large Language Model,LLM)在全球迅速普及,展示出巨大的应用潜力。通过海量数据的训练,这些模型能够生成连贯且语义合理的文本,并具有卓越的问答能力。在政务服务领域,公众一般通过政府官网、移动应用查询政策法规、办事流程等信息,或者前往政务服务大厅求助。传统的政务服务主要依赖人工窗口服务和电话咨询,服务效率和响应速度往往受到限制,尤其是在遇到

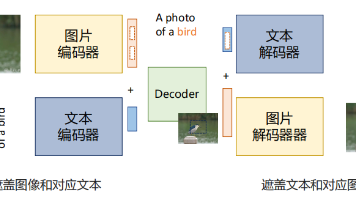

本文详细介绍了多模态大模型的架构与训练方法,重点讲解了视觉-语言模型(VLM)和语音-语言模型(SLM)。VLM包括对比学习、掩码预测、生成式学习和映射学习四种训练思路;SLM探讨了输入输出模式、语音表示方法及语音文本融合架构。这些模型结合不同模态信息,使AI具备看图说话、听懂回答等接近人类的能力,为人机交互提供了更自然的方式。

Ollama是一款专注于简化大型语言模型本地部署和运行的开源框架,基于Go语言实现,支持跨平台运行,并以“开箱即用”为核心理念,适合个人开发者和轻量化场景。而vLLM是一个高效的大模型推理与服务引擎,基于PyTorch构建,创新性地引入了PagedAttention技术,旨在解决大模型服务中的显存效率与吞吐量瓶颈,支持张量并行和流水线并行,可横向扩展至多机多卡集群。

文章探讨了AI知识库的三种部署方式(本地+本地、本地+云端、全云端)的优劣势,从数据安全、技术门槛、成本等维度进行分析。知识库可作为AI大模型的"外脑",弥补其在专业领域的知识不足。不同部署方式各有特点,用户可根据自身需求、技术能力和预算选择合适的方案,同时需关注使用过程中的Tokens消耗成本。

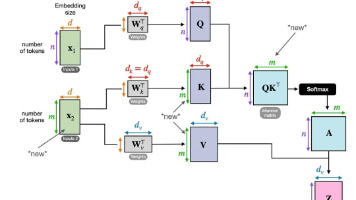

文章详细解释了大模型中的QKV机制,这是注意力机制的核心组成部分。QKV通过线性变换将输入向量转换为查询、键和值,通过计算注意力分数对值向量进行加权求和,生成融合上下文信息的新表示。QKV占据大模型50%以上权重,其优化对提升模型效率至关重要。文章通过实例和代码角度,阐明了单头和交叉注意力机制下QKV的工作原理和实际应用。

本文详细解析Anthropic的Claude Skills机制,这是一种让AI Agent获得新能力的产品级解决方案。Agent Skill作为"能力包",包含必需的SKILL.md文件和可选脚本资源,实现了能力从prompt中的抽离,形成可共享、可复用、可版本化的工程制品。文章通过简单与复杂案例,展示了如何设计标准目录结构、实现渐进式披露和构建标准化工作流,让AI Agent能像软件一样获得稳定

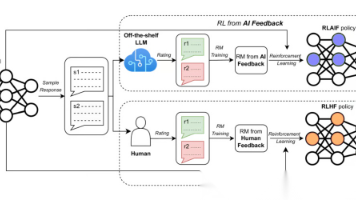

本文详细对比了2026年大模型训练中的六种主流强化学习算法,包括经典稳定的PPO、省显存的GRPO、序列级优化的GSPO、工业级优化的DAPO、平衡机制的BAPO以及专为AI Agent设计的ARPO。文章分析了各算法的原理、优缺点及适用场景,为不同规模和需求的训练任务提供了算法选择指南,是开发者入门大模型训练的实用参考。