简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

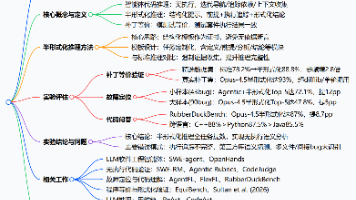

本文研究了LLM智能体的**Agentic Code Reasoning(智能体代码推理)** 能力——即无需执行代码,通过迭代探索代码库、追踪依赖完成深度语义分析的能力,并提出**半形式化推理**这一结构化提示方法。该方法通过任务定制化模板,强制智能体明确陈述前提、追踪执行路径、推导形式化结论,避免无依据断言。在补丁等价验证、故障定位、代码问答三大任务中的评估表明,半形式化推理实现了全面的精度提

本研究采用混合方法,以挪威公共部门敏捷组织NAV IT为对象,探究GitHub Copilot对开发者活动与感知生产力的影响。研究分析2年间703个仓库的26,317次非合并提交,对比25名Copilot用户与14名非用户的周级开发数据,并结合13次访谈与63份调查的定性反馈。结果显示:Copilot用户在工具引入前已显著更活跃(提交频率约为非用户2倍),工具使用后客观提交活动无统计显著变化;尽管

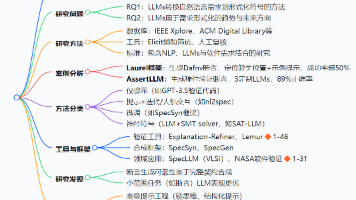

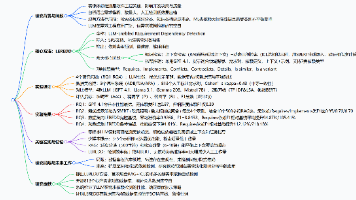

该研究系统解析了大语言模型(LLM)越狱攻击的安全威胁。研究首先提出"方法-对象-目标"三要素定义框架,区分正常应答、安全防护和越狱攻击场景;进而从LLM技术演进和安全认知变迁角度,揭示"服务属性与价值观不匹配"的核心矛盾。论文创新性地将攻击方法分为5大类16小类,防御策略归为5种类型,通过AdvBench等数据集验证最优攻击成功率超91%。研究构建了完整的

AI编码工具让开发者快速生成代码,也引发了“低经验Vibe Coder能否替代资深开发者”的问题。本研究分析AIDev数据集1719名Vibe Coder的22953个GitHub PR,将开发者分为低/高经验组,对比贡献规模和PR合并难度。结果显示,低经验组PR的提交次数是高经验组的2.15倍、修改文件数1.47倍,但评审评论数4.52倍、接受率低31%、解决时间5.16倍。研究发现低经验者聚焦

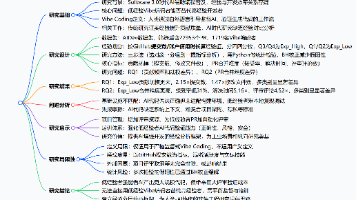

需求间存在固有依赖关系,其识别对软件开发至关重要,但自然语言需求的模糊性、需求规模的扩大使该任务极具挑战,现有方法也存在诸多局限。大语言模型(LLM)在自然语言处理中表现优异,但在需求依赖检测中的应用尚未被探索。本文提出LLM赋能的需求依赖检测方法LEREDD,融合检索增强生成(RAG)和上下文学习(ICL),可直接从自然语言需求中识别多类依赖。在813个标注需求对的实证评估中,LEREDD实现0

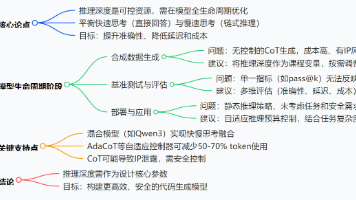

本文解读了代码生成模型领域的最新研究——将推理深度作为可控资源进行全生命周期管理。研究指出,当前LLMs在代码生成中面临正确性、延迟和成本的三角矛盾,而通过动态调度"快速思考"与"慢速思考"模式,可在数据生成、基准测试和部署阶段实现最优权衡。该研究为构建更高效、安全的代码生成系统提供了全新思路。

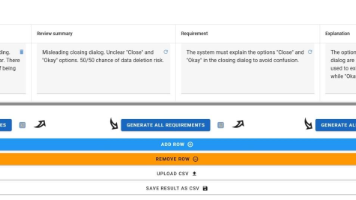

本文介绍了一篇关于“从用户评论自动生成软件可解释性需求与解释”的研究。现代软件越来越复杂,用户常因不理解功能而困惑,但将这些反馈转化为具体改进要求并不容易。该研究提出了一种AI辅助的自动化方法,能从用户评论中提取核心需求,生成结构化的开发要求和界面解释文本,并开发了相应工具。通过对比实验发现,AI生成的解释在清晰度和风格上有优势,但需求的准确性和相关性仍不及人工。研究强调了人机协作的重要性,并提供

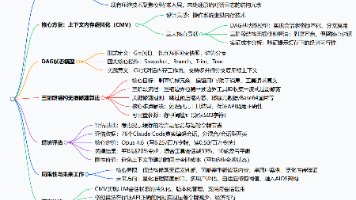

LLM在扩展推理任务中会在上下文窗口积累大量架构映射、决策等状态,而会话触达窗口上限后的有损压缩会丢失这些理解。本文提出上下文内存虚拟化(CMV),将LLM积累的理解视为版本化状态,借鉴OS虚拟内存,将会话历史建模为带快照、分支、修剪原语的DAG,实现跨并行会话的上下文复用。本文设计三阶段结构无损修剪算法,在保留用户和助手响应原文的前提下剥离原始工具输出等机械冗余,平均减少20%令牌数,高冗余会话

自主编码代理日益频繁地在GitHub提交拉取请求(PR),但这类贡献如何融入人类主导的代码评审工作流仍知之甚少。本研究基于公共AIDev数据集对代理编写的PR开展大规模实证研究,分析其整合结果、决议速度和评审期协作信号。通过带仓库聚类标准误的逻辑回归发现,评审者参与度与整合成功的相关性最强,而更大的改动量、强制推送等破坏协调的行为会降低合并概率,考虑协作信号后,单纯的迭代强度仅具有有限的解释力。定

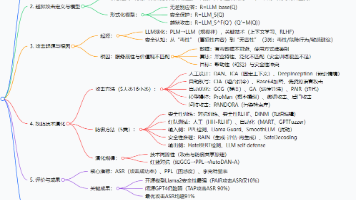

本文深度解读了利用大语言模型(LLMs)辅助软件需求形式化的最新研究进展,揭示了传统自然语言需求存在的歧义性与形式化验证的高门槛问题。通过系统综述35篇核心文献,分析了LLM在断言生成、规范合成、需求验证等场景的应用方法,提出提示工程优化、神经符号融合等未来方向,为理解LLM在软件工程中的前沿应用提供了清晰框架。