[论文阅读] 人工智能 + 软件工程 | 解决仓库级代码补全三大痛点!CodeRAG框架实现SOTA性能,还能降成本

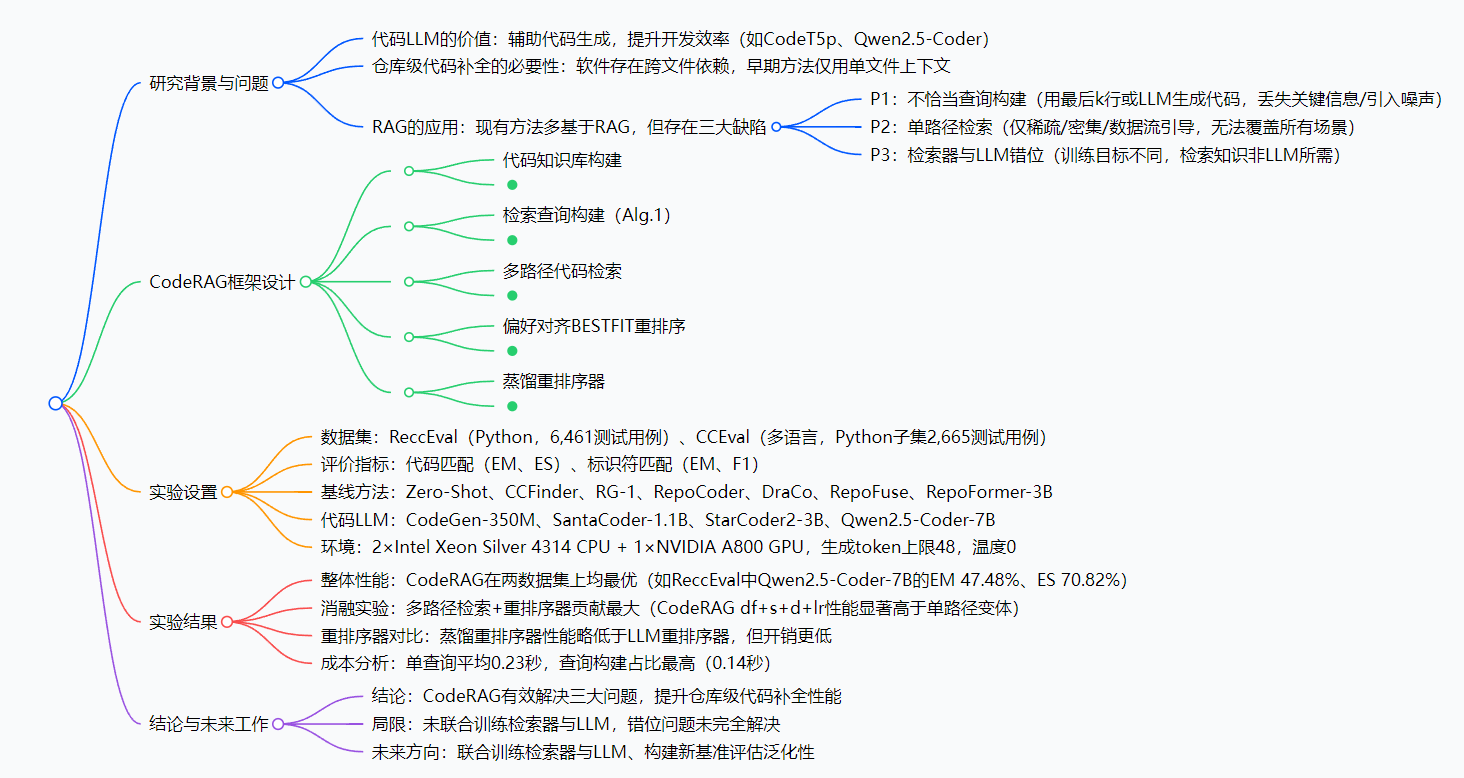

现有仓库级代码补全方法多基于检索增强生成(RAG),但存在查询构建不恰当、检索路径单一、检索器与代码LLM错位三大问题。为此,本文提出CodeRAG框架:首先,通过对数概率引导的探测策略,利用代码LLM的置信度筛选关键代码块构建检索查询;其次,融合稀疏检索、密集检索与数据流引导检索,实现多路径代码知识获取;最后,设计偏好对齐的BESTFIT重排序机制,用Qwen3-8B筛选最优知识,并蒸馏为轻量重

解决仓库级代码补全三大痛点!CodeRAG框架实现SOTA性能,还能降成本

论文信息

- 论文原标题:CodeRAG: Retrieval-Augmented Generation for Repository-Level Code Completion with Probability-Guided Query and Preference-Aligned Reranking

- 论文链接:https://arxiv.org/pdf/2509.16112

一段话总结

针对现有仓库级代码补全中“查询构建不恰当、检索路径单一、检索器与LLM错位”三大问题,研究者提出CodeRAG框架:先通过代码LLM的对数概率筛选关键代码块构建查询,再融合稀疏、密集、数据流三种路径检索相关代码,最后用Qwen3-8B做偏好对齐重排序(还蒸馏轻量模型降开销)。在ReccEval(6461个测试用例)和CCEval(2665个测试用例)上,CodeRAG在代码匹配(EM/ES)、标识符匹配(EM/F1)指标上,显著优于Zero-Shot、RepoCoder等SOTA(State of the Art,顶尖)方法,且在350M到7B参数的代码LLM上都能稳定发挥。

思维导图

研究背景:代码补全的“查资料难题”

咱们写文章时,遇到忘记的知识点会查资料;代码工程师写代码,也需要“查仓库”——比如调用之前定义的函数、引用全局变量,这就是“仓库级代码补全”。

早期代码LLM只看“当前文件的几行代码”,就像写文章只翻当前页,完全不管之前的章节,根本应对不了跨文件的复杂依赖。后来大家用RAG(检索增强生成)帮LLM“查仓库”,但新问题又冒出来了:

- 查的“关键词”不对:有的方法直接用“光标前最后几行代码”当查询,比如要补全“调用func()”,但func()的定义在文件开头,这就漏了关键信息;还有的用LLM生成一段代码当查询,反而引入无关噪声,越查越偏。

- 查资料的“渠道太单一”:有的只按关键词匹配(比如TF-IDF),遇到“功能相似但名字不同”的代码就瞎了;有的只看语义相似(比如嵌入匹配),碰到需要追溯变量来源的场景又不行了。

- 查的资料“不是LLM想要的”:检索器和LLM是分开训练的,检索器觉得“相关”的代码,LLM补全时根本用不上——就像你查了一堆物理学资料,却要写文学论文,完全不搭边。

这些问题导致仓库级代码补全的准确率一直上不去,CodeRAG就是为解决这些“查资料难题”而生的。

创新点:CodeRAG的三个“神操作”

CodeRAG没有全盘否定现有方法,而是针对三大痛点做了精准创新,每一步都踩在关键问题上:

- 用“LLM置信度”选查询,告别“固定行数”:不强行用“最后几行”,而是把代码拆成小块,每个小块和“待补全代码”拼在一起,喂给小模型CodeT5p-220m,看模型生成代码时的“置信度”(对数概率)——置信度高,说明这个小块和待补全内容关联强,最后选top-g个强关联小块当查询,精准又高效。

- 三种“查资料渠道”融合,覆盖所有场景:同时用“关键词匹配(稀疏检索)”“语义相似(密集检索)”“变量依赖(数据流引导检索)”,就像查资料时既用搜索引擎、又翻学术数据库、还查参考文献,不管是找同名函数、相似功能代码,还是追溯变量来源,都能搞定。

- 让LLM自己“挑有用的资料”,还能降成本:先用大模型Qwen3-8B当“筛选员”,给它一堆检索到的代码,让它选“最有助于补全的片段”(单轮推理,速度快);再把大模型的“筛选能力”蒸馏到小模型Qwen3-0.6B上,既保证筛选质量,又把推理开销降下来,普通设备也能跑。

研究方法和思路:CodeRAG的“五步工作流”

CodeRAG的逻辑很清晰,从“建仓库”到“出结果”分五步走,每一步都简单易懂:

第一步:建“高质量代码仓库”

不是把代码拆成纯文本片段,而是用AST(抽象语法树,能识别代码结构)提取关键元素,比如函数定义、全局变量、类函数、类变量——就像把仓库里的东西分类整理,贴上“函数”“变量”标签,后续查起来更快。

第二步:用“置信度”构建查询(对应创新点1)

- 把待补全的代码文件拆成“每f行一个小块”(默认f=3);

- 每个小块和“待补全的代码段”拼接,喂给CodeT5p-220m,生成m个token(默认m=1);

- 计算每个小块的“生成对数概率和”(置信度),选置信度最高的g个小块(默认g=1),和待补全代码拼在一起,就是最终查询。

第三步:多路径检索(对应创新点2)

用三种方式同时检索“代码仓库”,共返回15个结果(默认):

- 稀疏检索(TF-IDF):按关键词匹配,找含相同标识符的代码;

- 密集检索(CodeT5p编码):算向量相似度,找语义相似的代码;

- 数据流引导检索:画数据流图,找变量依赖相关的代码。

第四步:偏好对齐重排序(对应创新点3)

- 大模型筛选:把15个检索结果拆成“窗口”(默认每个窗口3个片段),用Qwen3-8B按指令“选最有用的片段”,用堆排序快速选出top-10最优结果;

- 蒸馏小模型:用大模型筛选过的样本(5次筛选有4次一致的样本才保留),微调Qwen3-0.6B(加LoRA降参),得到轻量重排序器,替代大模型做日常筛选。

第五步:生成补全结果

把“待补全代码+top-10最优代码”拼在一起,喂给目标代码LLM(比如Qwen2.5-Coder-7B),生成最终的补全代码。

主要成果和贡献:数据说话,效果碾压

CodeRAG的成果用“硬数据”说话,在两个权威数据集上都跑赢了现有方法,还平衡了性能和成本:

1. 核心实验结果(表格更清晰)

| 评估维度 | 具体结果 |

|---|---|

| 整体性能(ReccEval) | 用Qwen2.5-Coder-7B时,代码匹配EM达47.48%(比最优基线DraCo高18.7%),ES达70.82% |

| 消融实验 | 多路径检索+重排序器贡献最大:加了这两个组件后,EM比单路径检索高近3个百分点 |

| 重排序器对比 | 蒸馏模型性能略低(EM 44.34% vs 大模型47.57%),但参数从8B降到0.6B,开销大减 |

| 成本分析 | 单查询平均0.23秒,接近现有方法;查询构建占60.9%耗时,后续可优化加速 |

2. 核心贡献(实实在在的价值)

| 贡献类型 | 具体内容 |

|---|---|

| 理论贡献 | 提出“对数概率查询构建”“偏好对齐重排序”,解决了RAG在仓库级补全的三大核心痛点 |

| 实践贡献 | 提供轻量方案:蒸馏重排序器让普通设备也能跑,单查询0.23秒满足实时补全需求 |

| 鲁棒性贡献 | 在350M(CodeGen)到7B(Qwen2.5-Coder)参数的LLM上都有效,适配不同场景 |

关键问题:用问答搞懂核心

Q1:CodeRAG的“对数概率引导查询”,比“用最后几行代码当查询”好在哪?

A:比如待补全代码是“print(result)”,result的定义在文件开头的“result = func(data)”。用“最后几行”当查询,根本没包含“result = func(data)”,检索不到相关代码;而对数概率引导会发现“result = func(data)”这个小块和“print(result)”的置信度高,把它加入查询,就能精准检索到result的定义,补全更准确。

Q2:三种检索路径缺一不可吗?如果只用电线数检索会怎样?

A:缺一不可,三种路径是互补的。比如只用电线数检索(TF-IDF),遇到“函数名不同但功能相同”的场景(比如“calc_sum()”和“compute_total()”都算总和),就检索不到;只用水流引导检索,找语义相似的代码又不行。融合三种路径才能覆盖“关键词匹配、语义相似、变量依赖”所有场景。

Q3:为什么要蒸馏重排序器?直接用Qwen3-8B不行吗?

A:直接用Qwen3-8B当然行,但成本太高——8B参数的模型需要高性能GPU,推理速度也慢,不适合日常开发场景。蒸馏到0.6B后,普通GPU甚至CPU都能跑,推理速度更快,还能保留90%以上的筛选性能,性价比更高。

Q4:CodeRAG能适配其他编程语言吗?目前只测了Python。

A:论文里主要在Python数据集(ReccEval、CCEval的Python子集)上测试,但框架本身具有通用性:AST提取代码元素、多路径检索、重排序这些步骤,只要适配对应的编程语言解析工具(比如Java的AST解析器),就能扩展到其他语言,未来可能会有相关实验验证。

总结

CodeRAG针对仓库级代码补全的“查询、检索、对齐”三大痛点,提出了一套精准、高效的解决方案:用对数概率选查询,解决“查错关键词”问题;用多路径检索,解决“渠道单一”问题;用偏好对齐重排序+蒸馏,解决“检索-LLM错位”和成本问题。

实验证明,它在两个权威数据集上都实现了SOTA性能,还能适配不同参数规模的LLM,兼顾性能和实用性。不过它也有局限——目前没把检索器和LLM联合训练,“错位”问题只是缓解,没完全根治。未来如果能实现联合训练,再扩展到更多编程语言,相信会成为代码工程师的“刚需工具”。

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)