简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

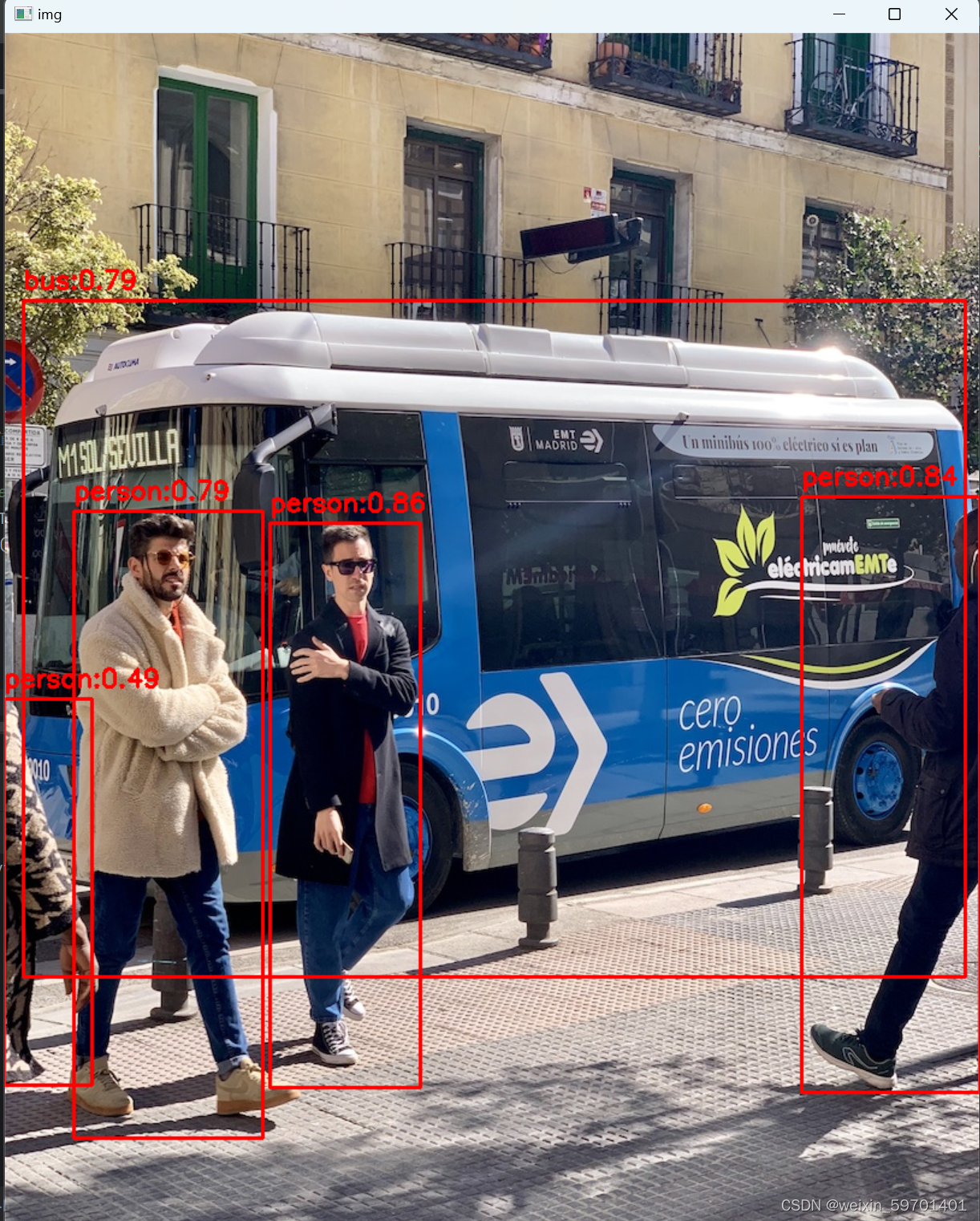

bboxes: 1004变为4100 4。scores:100变为4 100。后续抽空再补上TenormousrtC++的推理部分。labels:80变为4 80。num_dets:1变为4 1。

3.推理耗时来看:fp16下:0.00583fp32下:0.00900, fp16耗时提升3.17ms,性能提升35.22%,可以看出单张推理耗时上,fp16的优势较大。2.GPU占用:显卡使用的是NVIDIA GeForce RTX 4060,波动性较大,在1.1G - 4.2G之间,没有查明原因。4.模型大小来看:fp16:14.9MBfp32:27.9MB,缩小13MB ,46.59%1.从

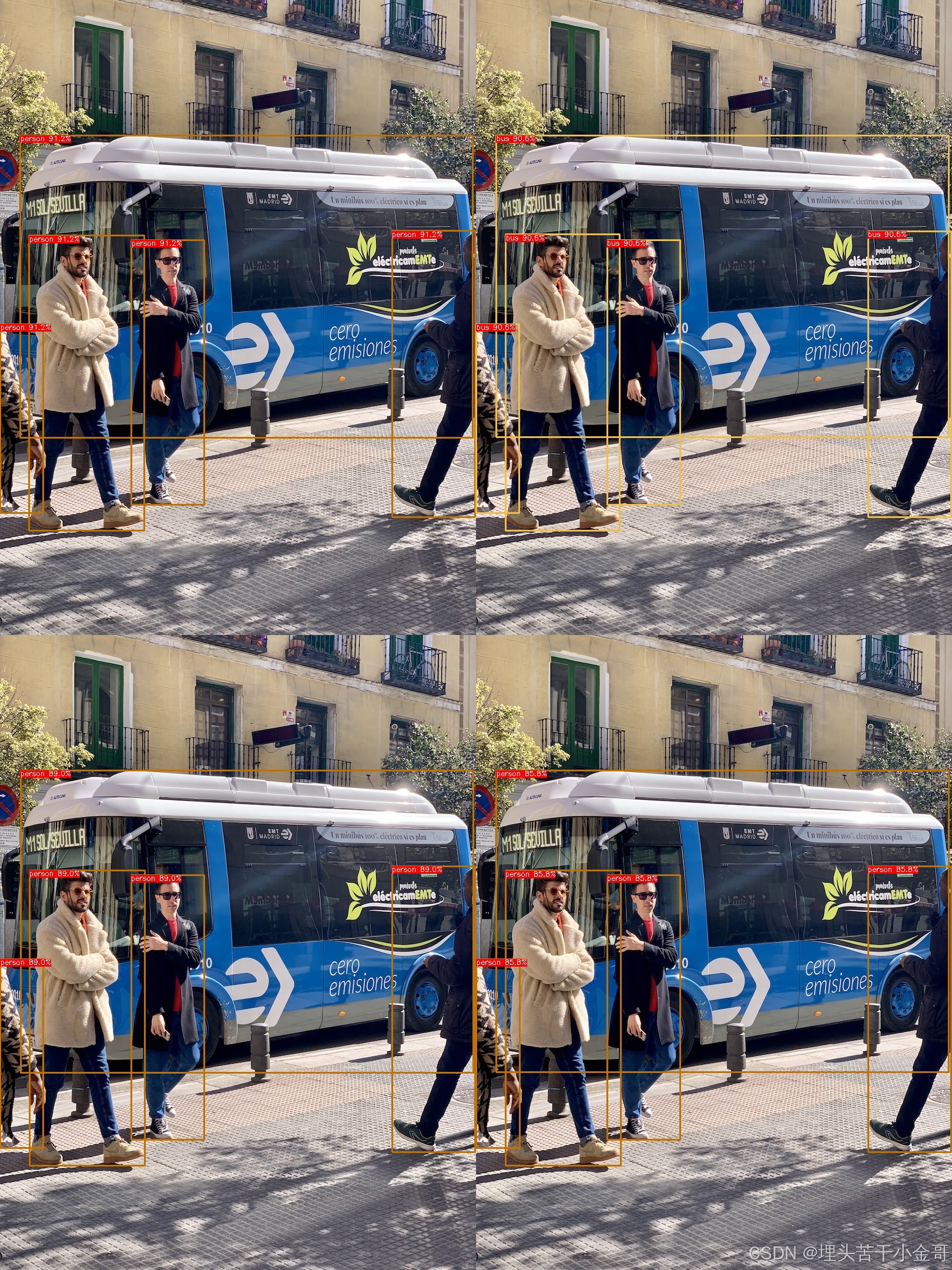

由于个人的项目特殊性,需要检测的图片分辨率很大,通常需要将一张图片切分4张/5张进行检测,尽管C++上TensorRT部署,模型的推理耗时已经得到了非常大的提升了,不过本着优化到极致的初衷,花了两周时间研究了下yolov8的python版本:onnx、tensorrt下的多batch部署和C++下TensorRT的多Batch部署,有感兴趣的可以下载学习,也可以加我微信,手把手教程。有需要可私信你

由于个人的项目特殊性,需要检测的图片分辨率很大,通常需要将一张图片切分4张/5张进行检测,尽管C++上TensorRT部署,模型的推理耗时已经得到了非常大的提升了,不过本着优化到极致的初衷,花了两周时间研究了下yolov8的python版本:onnx、tensorrt下的多batch部署和C++下TensorRT的多Batch部署,有感兴趣的可以下载学习,也可以加我微信,手把手教程。有需要可私信你

最近正好有空,准备研究一下yolov11,训练和部署跑通之后,发现没有找到详细点的训练教程,呢就自己做一个,顺便分享一下,后续会分享yolov11的 python推理部署 和 C++(tensorrt)推理部署的手把手教程,路过的点个关注先,以免错过~运行完之后,会在datasets根目录下生成以下三个训练所需的文件:train.txt 、 val.txt 、 test.txt。对于yolov11