简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

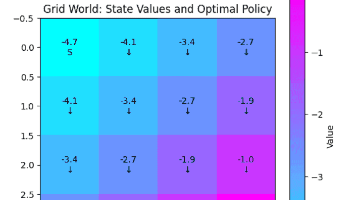

强化学习是一种通过与环境交互学习最优决策策略的机器学习方法,其核心是马尔可夫决策过程(MDP)框架。MDP由状态空间、动作空间、状态转移概率和奖励函数组成,通过动态规划方法如值迭代求解最优策略。本文以网格世界为例,演示了如何使用值迭代算法计算状态价值函数并导出最优策略,展示了强化学习在序列决策问题中的应用价值。该框架为机器人控制、游戏AI等实际问题提供了理论基础和解决方案。

本文系统介绍了机器学习中不同任务的评估指标。分类任务使用准确率、精确率、召回率、F1值和ROC-AUC等指标;回归任务采用均方误差(MSE)、平均绝对误差(MAE)和决定系数(R²);聚类任务则使用轮廓系数、归一化互信息(NMI)和调整兰德指数(ARI)。通过实例分析,详细展示了这些指标的计算方法和适用场景。合理选择评估指标能全面反映模型性能,为模型优化提供依据。

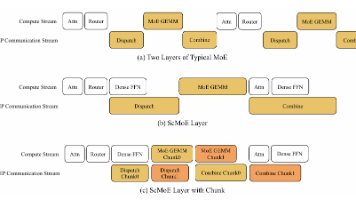

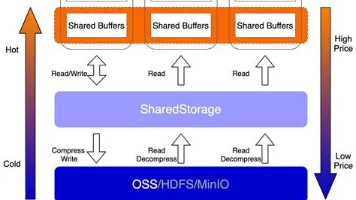

最近,美团开源的 LongCat-Flash 彻底炸了 AI 圈。一方面,它用 国产算力 完成了一个 5600 亿参数的大模型训练;另一方面,它用一系列极具工程狠劲的设计,解决了很多 DeepSeek 一直头疼的系统级瓶颈。LongCat-Flash 可以说是一次真正懂大模型训练痛点的人干出来的技术工程奇迹。

在过去几年,人工智能的发展让单个智能体已经能完成越来越复杂的任务,比如写文章、做数据分析、甚至协助编程。但当任务变得更复杂、需要多个智能体分工协作时,我们就会遇到一个问题:不同智能体之间怎么有效沟通?如果每个智能体各说各话,就像一个人说中文、一个说英文,合作就会非常困难。这时候,一套统一的通信标准就显得至关重要——这就是今天要介绍的 Agent2Agent 协议。

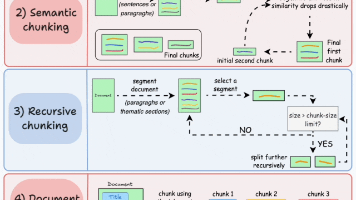

《RAG系统文档切分策略详解》介绍了构建检索增强生成(RAG)系统的5种关键文档切分方法:1)固定大小切分简单但易破坏语义;2)语义切分利用NLP技术保持上下文连贯性;3)递归切分结合固定长度与语义结构;4)基于文档结构的切分利用格式标记;5)基于LLM的智能切分精度高但成本大。文章强调实际应用中需混合策略,并推荐可视化工具ChunkViz辅助理解。该系列持续更新于GitHub项目LLMHub,涵

面试官:你觉得大模型的幻觉(Hallucination)是怎么产生的?能不能从原理上讲讲?那我们又该如何去抑制?别小看这问题,几乎所有大模型都被幻觉困扰——从 ChatGPT 到多模态模型,没有一个能逃得了。

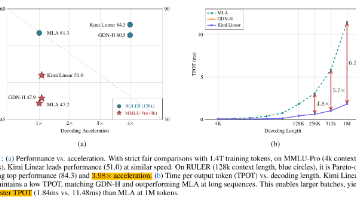

Kimi最近提出了Kimi Linear,这是一种混合线性注意力(Hybrid Linear Attention)架构。它首次在公平比较中,于短上下文、长上下文和强化学习(RL)等多种场景下,全面超越了全注意力(Full Attention)架构。

继 LLaMA 1 的“小而强”、LLaMA 2 的“对齐进化”之后,LLaMA 3 带着更大规模的数据、更强的推理能力以及完全开放的商用许可横空出世。Meta 声称:LLaMA 3-70B 在多个任务中已逼近甚至超越 GPT-3.5,并将在未来挑战 GPT-4 的王座。

在大模型时代,AI 的训练与推理已经不再是单纯的算力问题。随着模型参数规模进入百亿级、数据量级扩展到 TB~PB,数据管线与存储架构往往成为影响训练速度的决定性因素。算力再强,如果数据加载跟不上,也会出现 GPU 空闲等待 I/O 的情况,训练效率大打折扣。

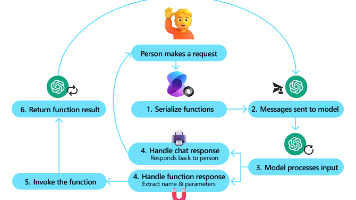

在现代 AI 系统中,语言模型不仅可以生成文本,还可以直接调用外部功能或服务。这种机制被称为 Function Calling。Function Calling 的原理、工作流程是什么?与 MCP(模型上下文协议)的区别又是什么呢?