简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

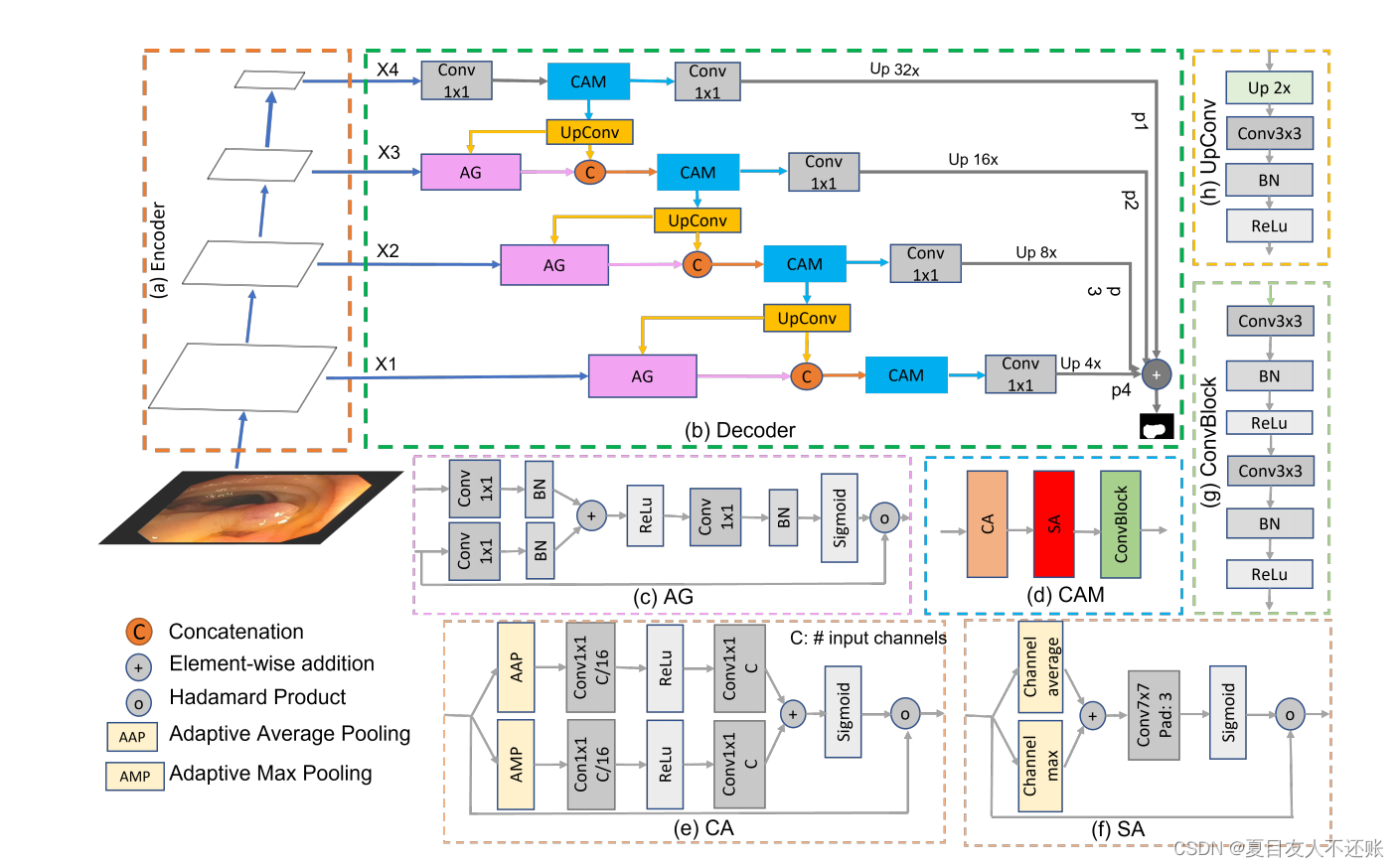

Transformer在医学图像分割中表现出了巨大的前景,因为它们能够通过自注意力捕获长期依赖关系。然而,它们缺乏学习像素之间的局部(上下文)关系的能力。以前的工作试图通过在Transformer的编码器或解码器模块中嵌入卷积层来克服这一问题,因此有时会出现特征不一致的情况。为了解决这个问题,本文提出了一种新的基于注意力的解码器,即级联注意解码器(CASCADE),它利用了分层Vision Tra

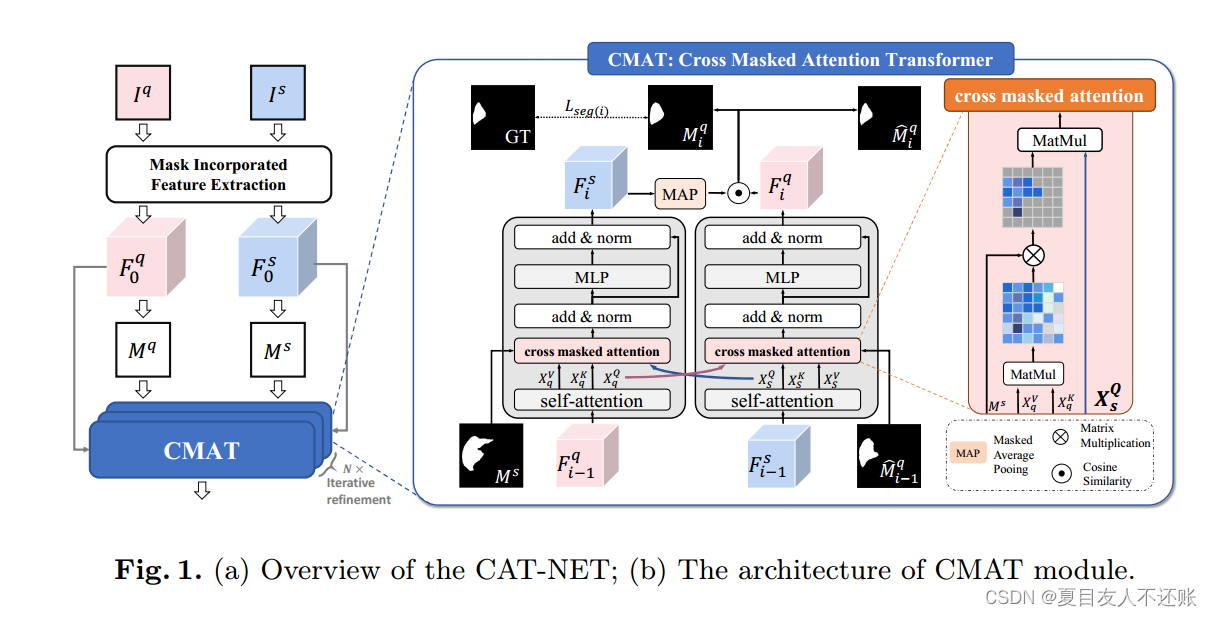

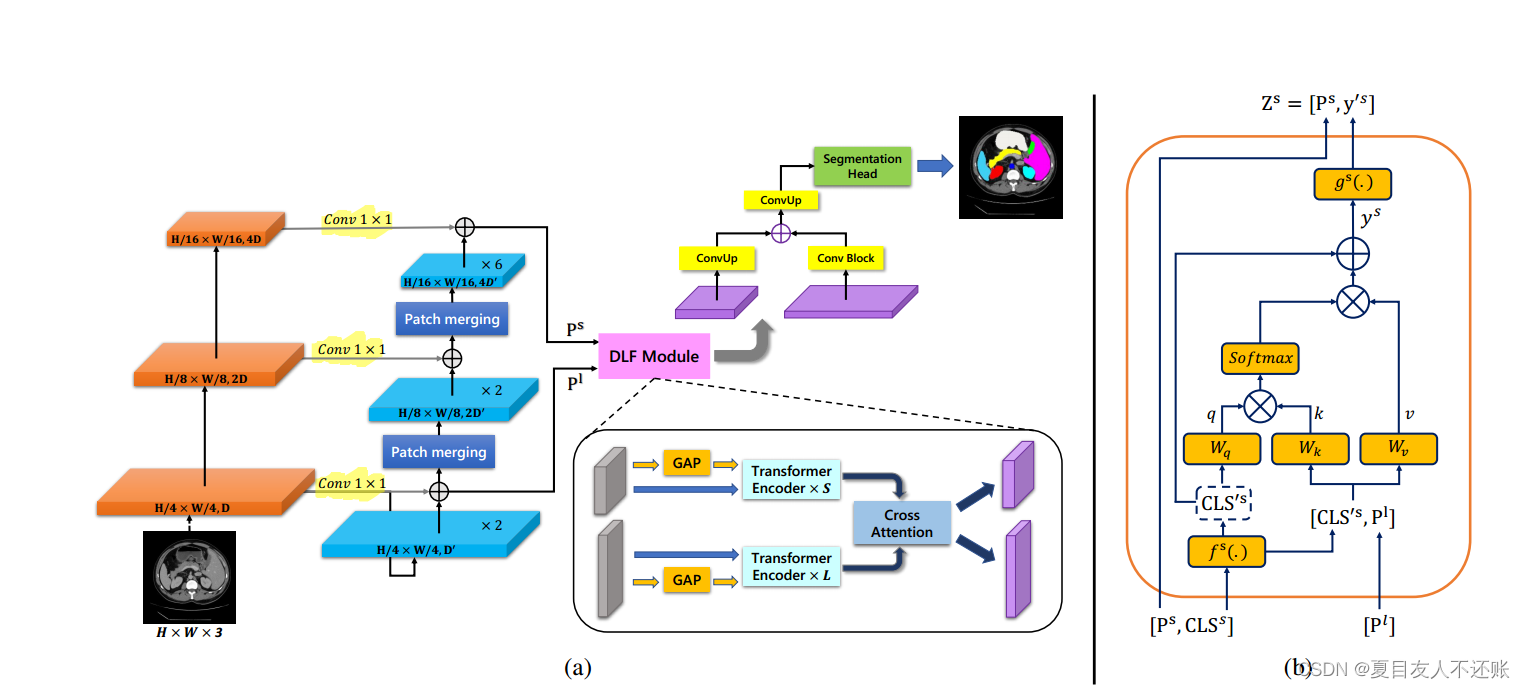

在深度学习医学图像分割领域,训练一个性能强,可以大规模部署落地的模型,往往需要大量手动标注的数据进行监督训练,其中花费的成本是非常高的。为了解决这一挑战,少样本学习(few-shot)技术有潜力从有限的几个sample中学习新类别的能力。本文提出了一种基于交叉掩码注意力的少样本医学图像分割新框架CAT-Net:通过挖掘support和query图像之间的相关性,并限制模型仅关注有用的前景信息,来提

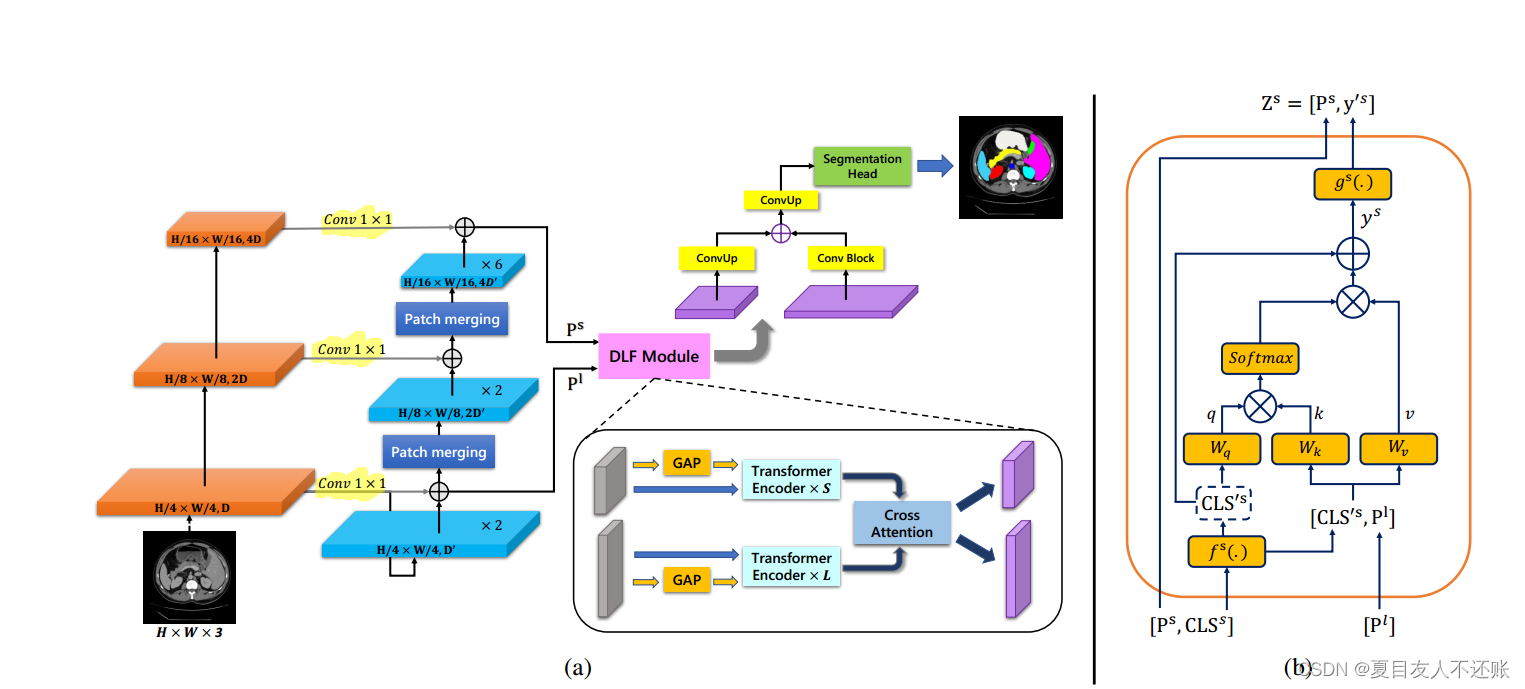

由于卷积神经网络的卷积运算的特性,它们在建模长程相关性和空间相关性时受到限制。虽然Transformer最初是为了解决这个问题而开发的,但它们无法捕获低级别的特征。相比之下,局部和全局特征对于密集预测(例如在具有挑战性的环境中进行分割)都是至关重要的。在本文中,我们提出了一种新的方法HiFormer,该方法有效地连接了CNN和用于医学图像分割的Transformer。具体来说,我们使用开创性的Sw

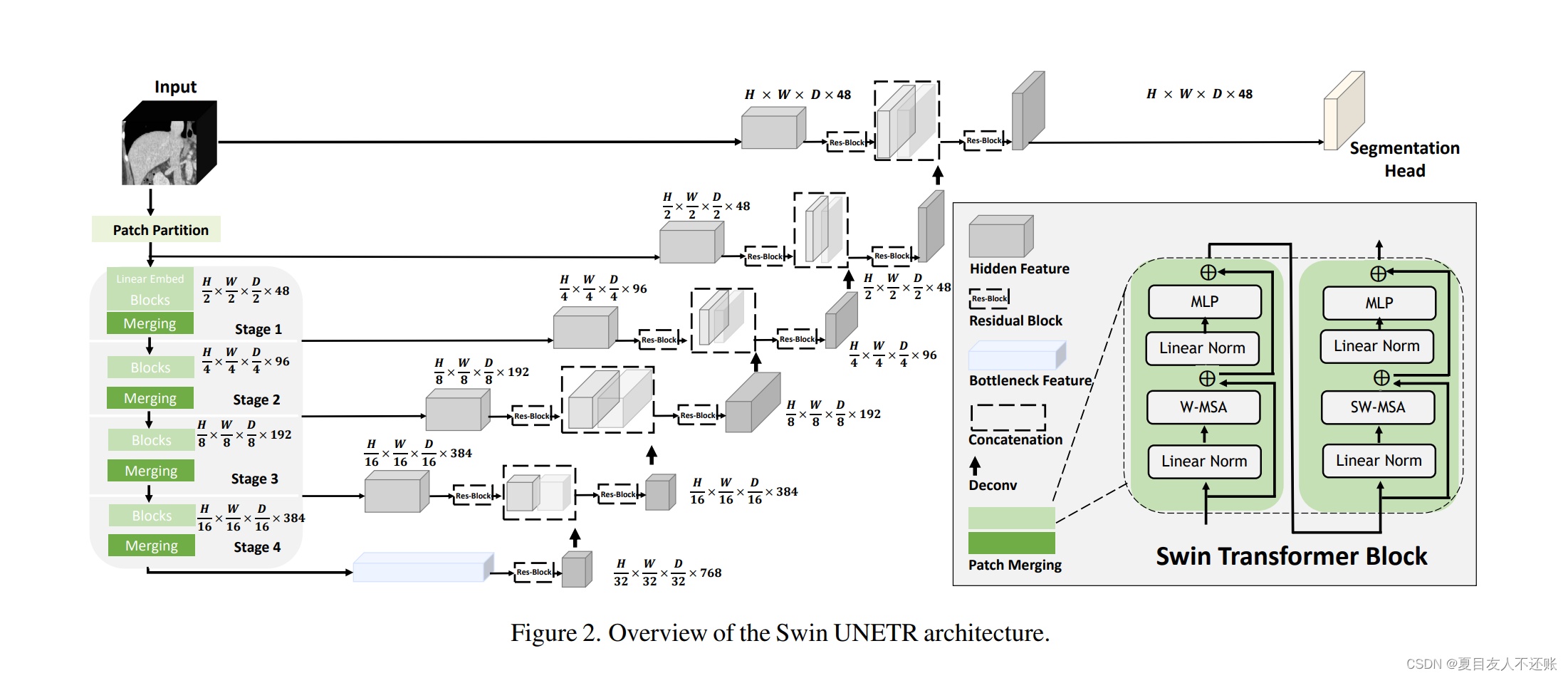

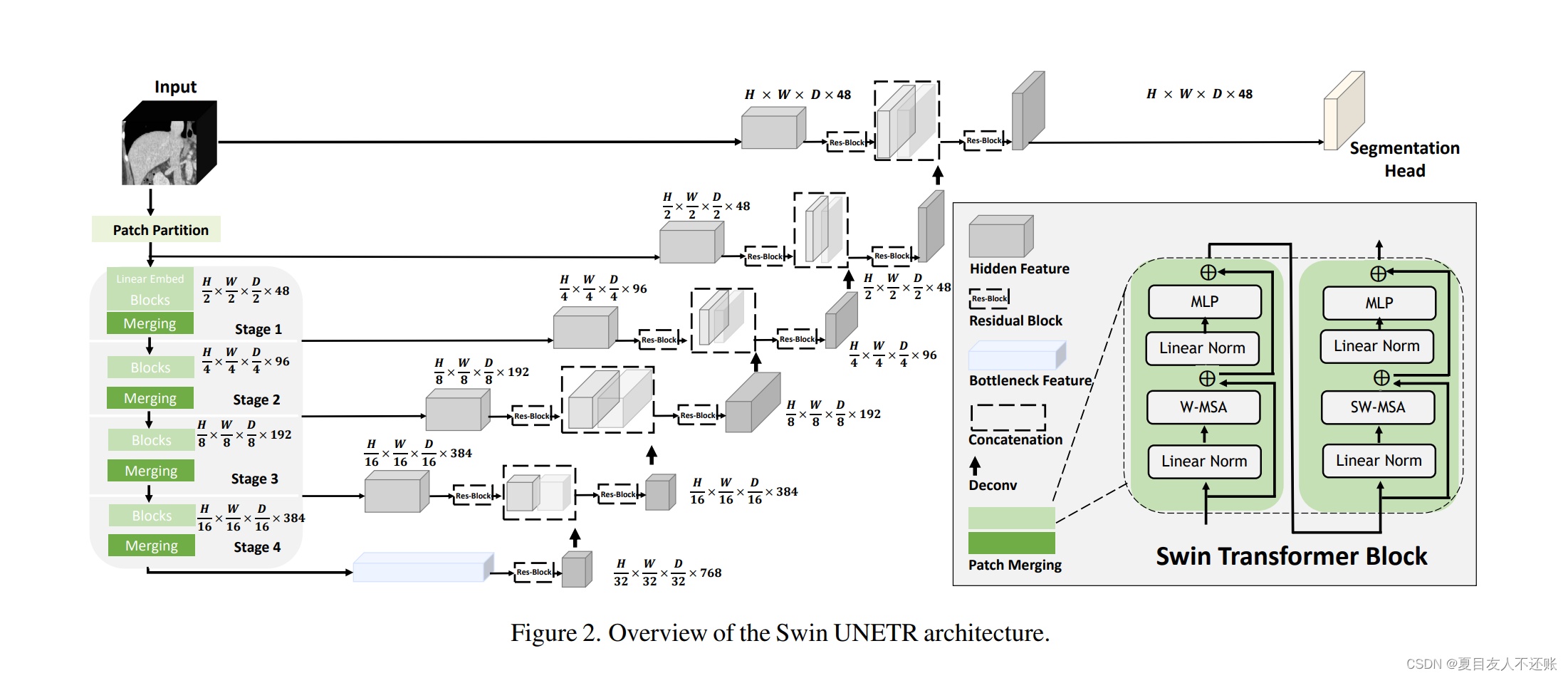

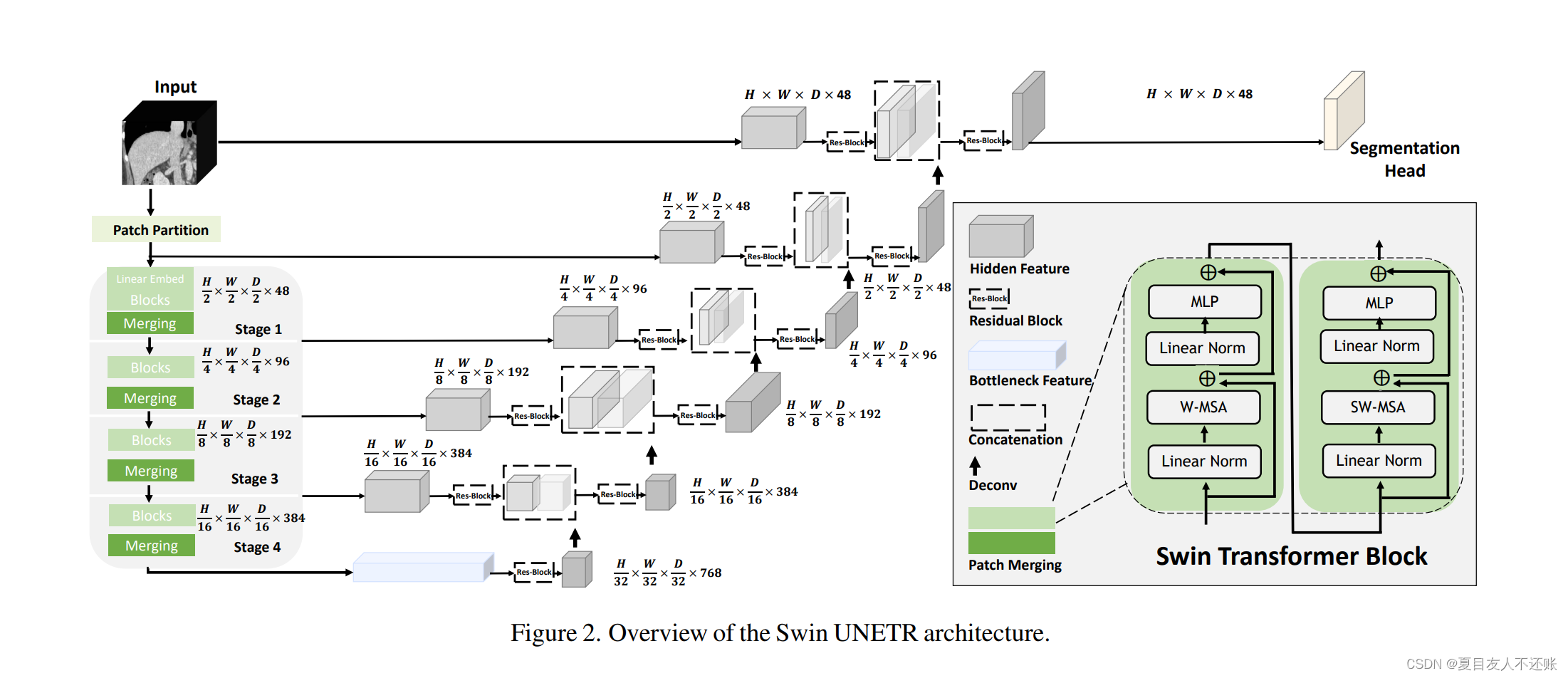

Vision Transformer(ViT)在全局和局部表示的自监督学习方面表现出了出色的性能,这些表示它可以转移到下游任务的应用中。提出模型:提出一种新的自监督学习框架Swin UNETR,它具有定制的代理任务,用于医学图像分析。模型介绍:(1)一种新的基于3D变压器的模型,称为Swin UNEt Transformer (Swin UNETR),具有用于自我监督前训练的分层编码器;(2)为学

Vision Transformer(ViT)在全局和局部表示的自监督学习方面表现出了出色的性能,这些表示它可以转移到下游任务的应用中。提出模型:提出一种新的自监督学习框架Swin UNETR,它具有定制的代理任务,用于医学图像分析。模型介绍:(1)一种新的基于3D变压器的模型,称为Swin UNEt Transformer (Swin UNETR),具有用于自我监督前训练的分层编码器;(2)为学

由于卷积神经网络的卷积运算的特性,它们在建模长程相关性和空间相关性时受到限制。虽然Transformer最初是为了解决这个问题而开发的,但它们无法捕获低级别的特征。相比之下,局部和全局特征对于密集预测(例如在具有挑战性的环境中进行分割)都是至关重要的。在本文中,我们提出了一种新的方法HiFormer,该方法有效地连接了CNN和用于医学图像分割的Transformer。具体来说,我们使用开创性的Sw

Vision Transformer(ViT)在全局和局部表示的自监督学习方面表现出了出色的性能,这些表示它可以转移到下游任务的应用中。提出模型:提出一种新的自监督学习框架Swin UNETR,它具有定制的代理任务,用于医学图像分析。模型介绍:(1)一种新的基于3D变压器的模型,称为Swin UNEt Transformer (Swin UNETR),具有用于自我监督前训练的分层编码器;(2)为学

还有一个更快的方法,就是单击 PDF 查看器上的 “下载 PDF” 按钮,如下所示。第一种模式(内联)编写的公式是文本中的一部分,第二种模式(显示)编写的公式不在段落中,而是放在单独的行上。在这里,universe 是包含不带扩展名的图片文件的名称,图片文件名不应包含空格或多个点。在序言中,可以定义要编写的文档的类型,要编写的语言,要使用的包(稍后会详细介绍)和其他的元素。要在 PDF 中查看更改