简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

Qwen3-14B vLLM 从 0 到 1 部署方案(包含详细步骤跟着做就可以部署)

本文详细介绍了Qwen3-14B大模型基于vLLM框架的部署方案,包含INT8量化和API服务搭建。部署要求:48GB显存显卡(如RTX 6000 Ada)、32GB内存、50GB存储空间,推荐Ubuntu 24.04系统。核心步骤包括:1)创建conda环境并安装Python 3.10、PyTorch 2.1.0+cu120等基础依赖;2)配置vLLM 0.14.1、bitsandbytes 0

Qwen3-14B vLLM 从 0 到 1 部署方案(包含详细步骤跟着做就可以部署)

本文详细介绍了Qwen3-14B大模型基于vLLM框架的部署方案,包含INT8量化和API服务搭建。部署要求:48GB显存显卡(如RTX 6000 Ada)、32GB内存、50GB存储空间,推荐Ubuntu 24.04系统。核心步骤包括:1)创建conda环境并安装Python 3.10、PyTorch 2.1.0+cu120等基础依赖;2)配置vLLM 0.14.1、bitsandbytes 0

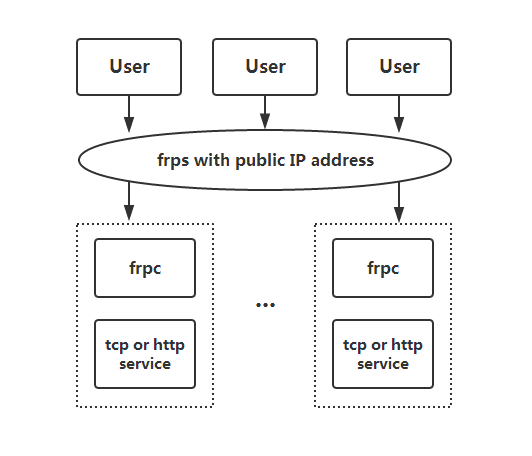

linux下frp客户端服务端部署(超详细)

frp的详细部署流程,快来一起内网穿透吧!

到底了