简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

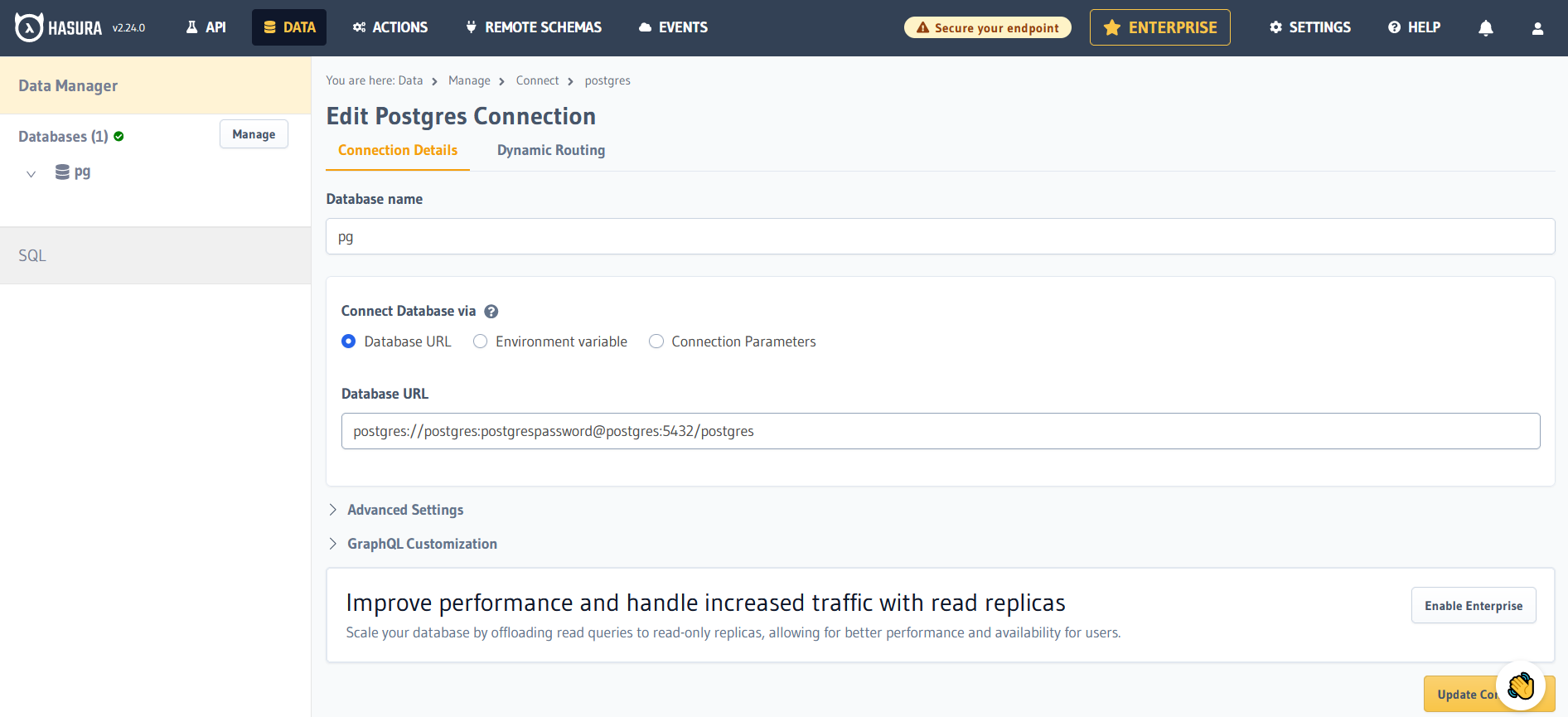

Hasura 是一个开源的 GraphQL 引擎,它可以帮助开发人员快速构建和部署现代应用程序的后端。它提供了一个自动化的 GraphQL API ,可以直接连接到现有的数据库,并提供实时数据推送和订阅功能。 Hasura 团队总部位于印度。作为一款后端低代码平台,也推荐使用对标 Hasura 的国产替代产品:飞布:飞布是可视化API开发平台,对标 hasura ,灵活开放、多语言兼容、简单易学,

本文通过使用Dify平台的工作流编排功能,结合阿里百炼的大型语言模型(如qwen2.5-14b-instruct等),成功打造了一个专属的AI数据分析师。能够根据用户提供的自然语言问题生成对应的SQL查询语句,并通过部署好的API服务执行这些查询,最终由另一个LLM节点对查询结果进行专业的数据分析和可视化展示。可以统计创作唐诗最多的作者、分析唐诗中特定元素的出现频率,以及联合查询作者信息与作品数量

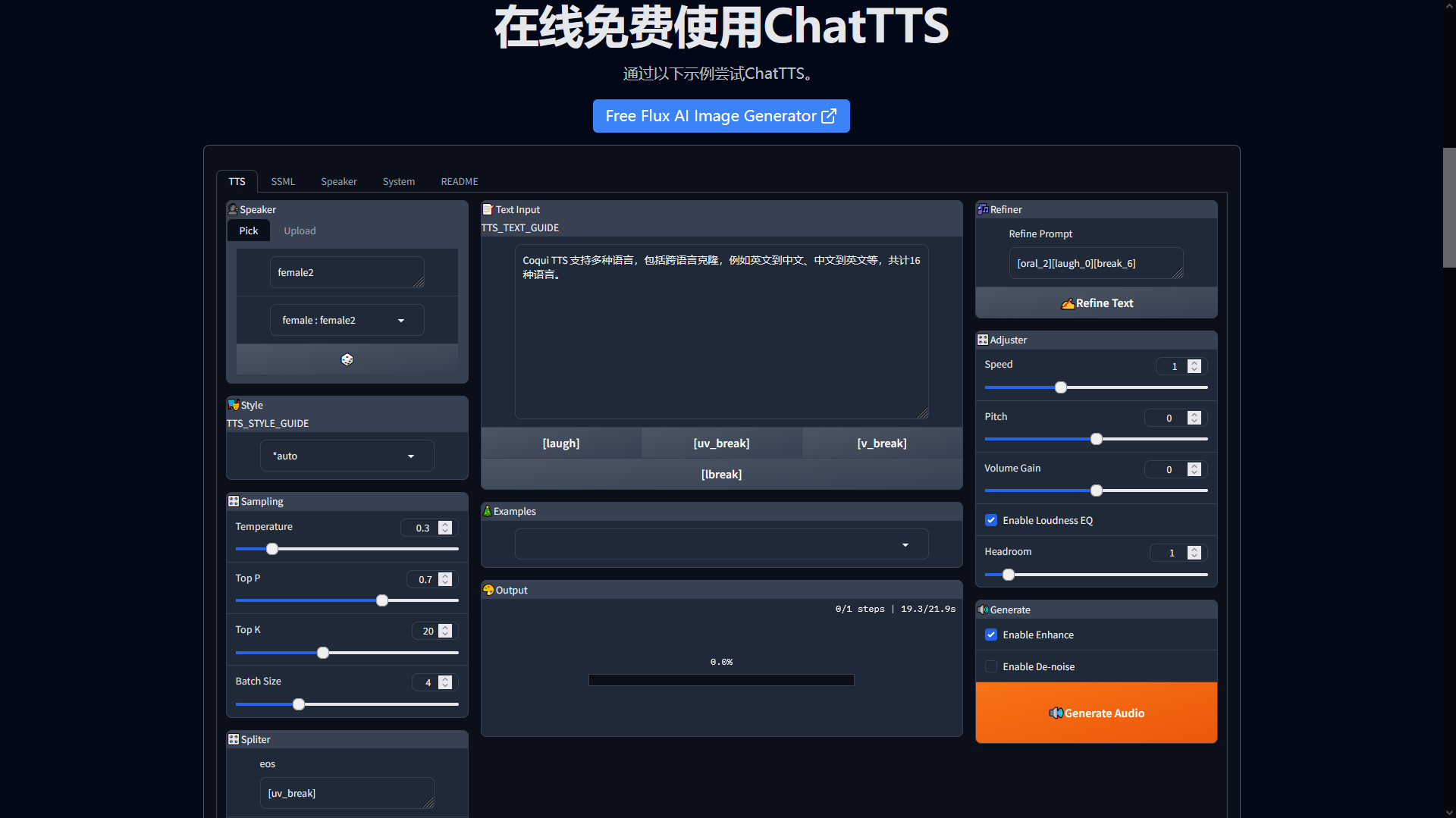

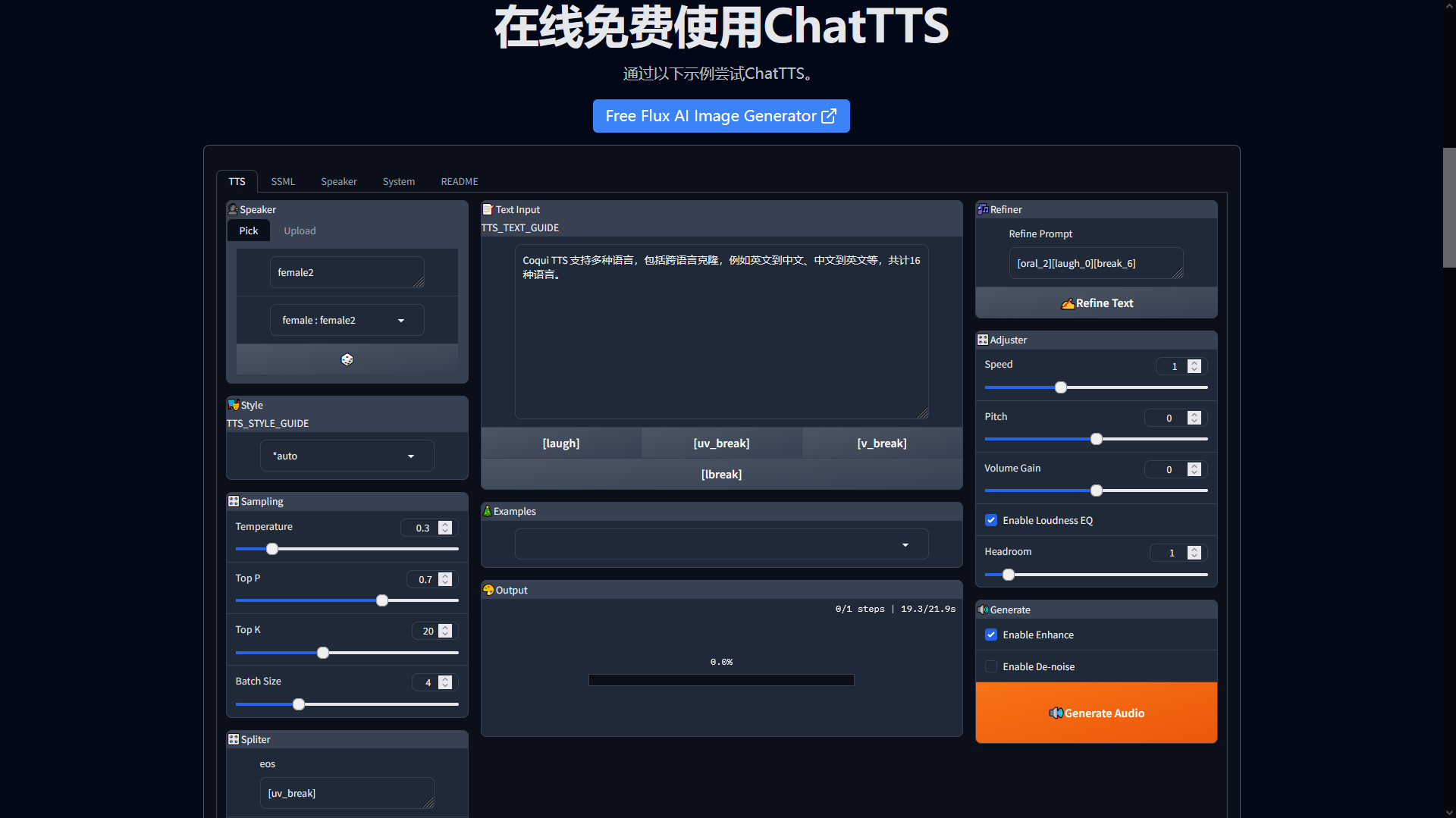

结合实际的应用场景,本次主要关注在纯CPU场景下,对于中文文本的合成效果(人声自然)与合成效率(时间短)两个方面。以下将通过对eSpeak,ChatTTS,CoquiTTS这三种语音合成TTS服务离线部署测试,分析三种方案的优劣。

本文通过使用Dify平台的工作流编排功能,结合阿里百炼的大型语言模型(如qwen2.5-14b-instruct等),成功打造了一个专属的AI数据分析师。能够根据用户提供的自然语言问题生成对应的SQL查询语句,并通过部署好的API服务执行这些查询,最终由另一个LLM节点对查询结果进行专业的数据分析和可视化展示。可以统计创作唐诗最多的作者、分析唐诗中特定元素的出现频率,以及联合查询作者信息与作品数量

结合实际的应用场景,本次主要关注在纯CPU场景下,对于中文文本的合成效果(人声自然)与合成效率(时间短)两个方面。以下将通过对eSpeak,ChatTTS,CoquiTTS这三种语音合成TTS服务离线部署测试,分析三种方案的优劣。

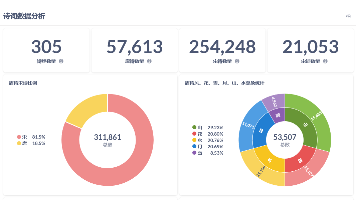

本文介绍了开源商业智能工具Metabase的技术特点及其在古诗词数据库分析中的应用。Metabase采用Clojure+Java技术栈,支持多数据源查询与可视化,降低了数据分析门槛。文章展示了基于唐诗宋词数据库(包含诗歌、作者、诗经等5张表)构建的Dashboard效果图,并详细列出了各表结构(如poetry表含id、title、content等字段)。通过该案例,体现了Metabase在非结构化

综上,我们通过Python爬取上市公司利润表数据:数据抓取、数据入库与数据可视化一气呵成,体验了Python在爬虫和数据可视化方面具有简单易学、强大的库和框架支持、多线程和异步支持、数据处理能力强等优势。这次实践用到的 Python 库如下:requestsBeautifulSoup4jsonmatplotlibpandaspymysql

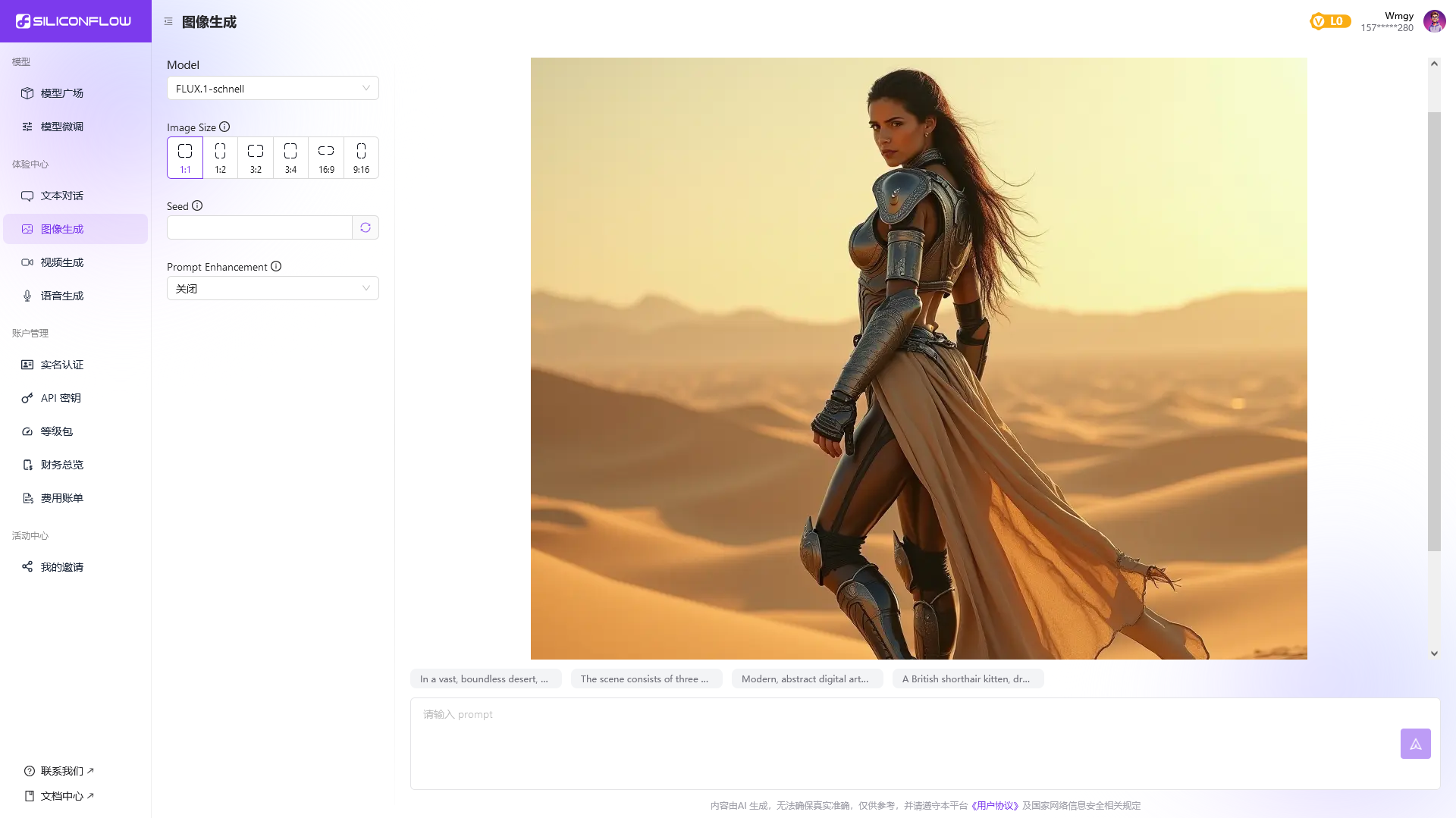

介绍了如何使用Dify平台结合Qwen2.5(7B)模型和Flux.1文生图工具,打造一个专属的文生图智能体(Agent),实现了中文输入到高质量图片生成的功能。文章详细说明了从创建应用、配置工具、编写提示词到实际使用的完整流程,并展示了多个成功的文生图示例。主要技术要点:1. 使用Dify的Agent功能作为基础框架2. 集成SiliconFlow的FLUX.1-schnell作为文生图工具3.

本文通过使用Dify平台的工作流编排功能,结合阿里百炼的大型语言模型(如qwen2.5-14b-instruct等),成功打造了一个专属的AI数据分析师。能够根据用户提供的自然语言问题生成对应的SQL查询语句,并通过部署好的API服务执行这些查询,最终由另一个LLM节点对查询结果进行专业的数据分析和可视化展示。可以统计创作唐诗最多的作者、分析唐诗中特定元素的出现频率,以及联合查询作者信息与作品数量

本文通过组合 Dify 的工作流编排、 Tavily Search 搜索引擎工具以及 Qwen2.5 模型,成功实现了一个能够回答实时问题的 AI 搜索引擎,步骤详细,极具可操作性。后续想办法解决模型对相对时间(今天、昨天、去年等)的理解存在局限性。这个 AI 搜索引擎能够回答一些实时新闻和事件相关的问题,展示了 Dify 工作流编排功能的便捷性、实用性。