简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文调研了编程agent在自动化测试领域的发展趋势。随着AgentSkills的兴起,传统MCP功能正被各种自动化测试工具取代,如Playwright BrowserAutomation、pypict-claude-skill等测试工具。研究指出,未来的测试agent将整合设计、开发、调试全流程,并覆盖Web端和移动端测试。重点介绍了UI-TARS等智能测试agent,它们通过自然语言指令实现自动

输入:Figma 文件链接(+ 可选节点 ID)+ Figma API 令牌(由 AI 工具传递给项目);输出:轻量化、标准化的 Figma 设计数据(JSON),而非前端代码;前端代码形式:由 AI 工具生成,支持 HTML/CSS/JS、React/Vue/Svelte 等主流框架、Tailwind/Styled Components 等 CSS 方案,粒度覆盖单组件到整页布局。是「数据翻译层

大型验证器系统医学领域适应备注:应该是参考kimi k2的技术。但kimi k2是用于预训练,他们这个现如今,AI医疗可谓是大模型落地趋势中的垂直领域之一。它备受AI大佬以及硅谷顶尖公司关注,是最重视的落地领域——比如在开源模型gpt-oss的评测中,医疗领域的表现排在数学、代码等热门能力之前展现;GPT-5发布会上,Altman就专门花时间体现了ChatGPT在医疗问诊场景中的实际价值。深度学习

小米MiMo团队在12月16日晚上发布并开源了团队在官方博客中介绍,这是一款强大、高效且超快速的基座语言模型,在推理、编程和智能体场景中表现尤为出色,同时也是处理日常任务的优秀通用助手。

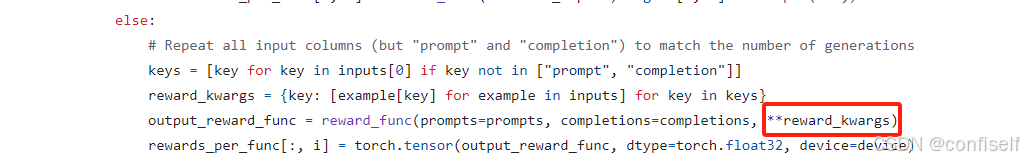

注意:这里的必须按照trl的格式定义text字段,将提示词和答案包含进去2、GRPO训练注意自定义的俩个奖励函数的传参,这样就将answer字段传进来了。

背景:如果想将一篇文章,拆分成多段,然后组成多段信息组,每个信息组包括标题+片段内容。现在要求将进行信息组进行压缩到10*10的矩阵中,每个矩阵元素有10中表达方式,有什么算法。要求每篇文章的所有信息组,其编码形式是一样的。如果借助于大模型,该怎么做。

此外,他们还提出了「Soft Overlong Punishment」(等式 13),这是一种长度感知惩罚机制,旨在塑造截断样本的奖励。在这个区间内,响应越长,受到的惩罚就越大。使用该算法,该团队成功让 Qwen2.5-32B 模型在 AIME 2024 基准上获得了 50 分,优于同等规模的 DeepSeek-R1-Zero-Qwen-32B,同时 DAPO 版 Qwen2.5-32B 使用的训

英语和中文数学推理:我们在英语和中文基准上对我们的模型进行了全面评估,涵盖了数学问题从小学到大学水平。英语基准包括 GSM8K(Cobbe 等人,2021)),MATH(Hendrycks 等人,2021)),SAT(Azerbayev 等人,2023)),OCW 课程(Lewkowycz 等人,2022a)),MMLU-STEM(Hendrycks 等人,2020)。

GPT-4 的零样本指代消解能力,核心在于指令模板的结构化引导与对话状态的隐式建模。其 81.5 的 F1 分数和 15% 的性能提升,在工业级对话系统(如客服、代码助手)中已显著降低人工标注成本并提升交互流畅性。随着 GPT-4.1 在长上下文和工具调用方向的增强,指代消解正从“上下文感知”迈向“知识增强推理”的新阶段。

生成反馈。