简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

我们都知道CPU适合串行计算,GPU适合大规模并行计算,大脑的硬件就像是一个GPU,大脑的操作系统和所有算法都是运行在GPU上,在高层次的计算上则模拟CPU的串行计算模式,如算术计算,代数计算,自然语言操作等等。所以某种程度来说,这些高层次的计算是模拟计算,所以速度很慢; 而像图像识别,语音识别是非模拟计算其速度很快。这个和现代计算机刚好相反操作系统和大多数算法运行在CPU上,GPU目前还主要是辅

这篇文章是用Markdown重写了原来的文章。图像分类中,深度学习训练时将图片随机剪裁(random crop)已经成为很普遍的数据扩充(data augmentation)方法,随机剪裁不但提高了模型精度,也增强了模型稳定性,但是它如此有效的核心原因是什么呢?仅仅是因为数据扩充吗?这个是下面我们需要研究的问题。

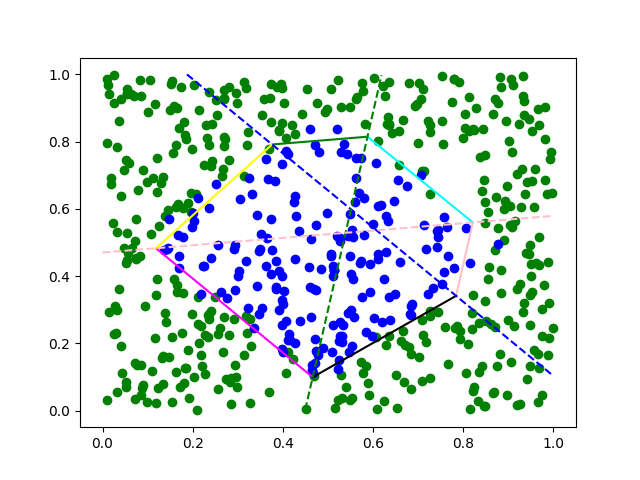

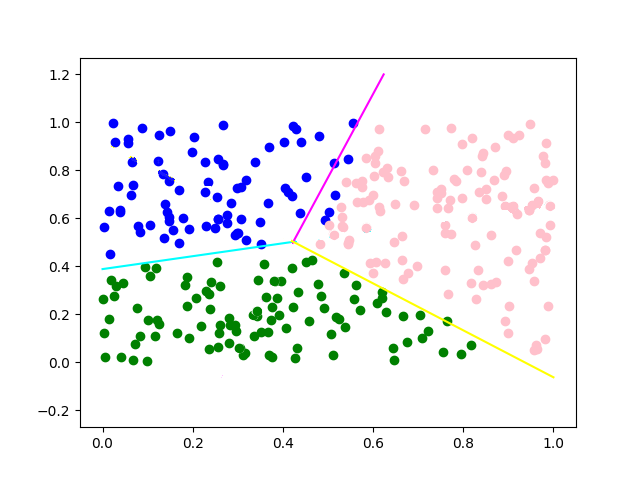

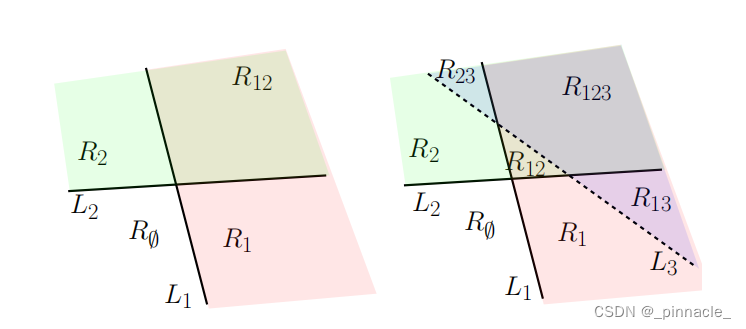

上一篇文章解析了单层全连接分类模型的(输入)空间划分(Space Partitioning)与编码逻辑或数学原理,这篇文章将主要是解析多层感知机(Multi-Layer Perceptron,MLP)或多层全连接层构成的模型的空间划分与编码逻辑。多层感知机与单层全连接分类模型较大的区别在于,隐藏层的空间划分与编码并不遵循理想情况下使得每一个线性区域(Linear Regions)只包含单个类别的数

几年前就想写这篇文章,但是在解析神经网络的数学原理问题上断断续续,加上个人能力有限,很多问题并没有研究的很明白,以及神经网络本身高维问题的复杂性,导致这个问题的理解也是片面的。个人希望在这篇文章里抛砖引玉,让大家能更深入理解神经网络内部的基础数学原理与编码逻辑,启发大家后面的工作,如有错误请不吝啬指出。本文不会过多的介绍梯度下降或反向传播等参数更新的原理或动力学过程,而是以前向过程(Feed Fo

以前的文章主要描述了神经网络,即多层感知机、全连接模型的运行原理,还是以实验为主,数学描述为辅的方式,这篇文章以纯数学的视角来描述神经网络的运行原理,主要以前馈过程为主(反向传播的动力学过程还是比较复杂,正向过程还未完全研究清楚,暂时还未考虑)。通过本篇文章,希望大家能理解神经网络的数学原理,如有错误请不吝指出。

最近思考激活函数的时候,突然想到神经网络中残差连接是不是和函数的泰勒展开很像,尤其是在激活函数fxx2f(x)=x^2fxx2时(这个激活函数想法来源于fxReLU2x3fxReLU2x3),所以验证了一下就顺便写下来了,本文抛砖引玉,如果有建议或更好的想法可以写到评论区。

这篇文章是用Markdown重写了原来的文章。图像分类中,深度学习训练时将图片随机剪裁(random crop)已经成为很普遍的数据扩充(data augmentation)方法,随机剪裁不但提高了模型精度,也增强了模型稳定性,但是它如此有效的核心原因是什么呢?仅仅是因为数据扩充吗?这个是下面我们需要研究的问题。

最近几年深度学习的快速发展对目标检测(Object Detection)领域也产生了巨大的影响,各种SOTA(State of Art)的模型也层出不穷,包括但不限于Faster-RCNN,YOLO,SSD,FCOS等等,很多时候我们看论文和模型容易陷入其复杂的细节之中,而得不到全局的视野,尤其是像Yolo系列各种堆版本也是看的眼花缭乱。事物的发展也许就是这样的吧,刚开始都是各种复杂,越到后面越能

最近研究超平面排列(Hyperplane Arrangement)问题的时候,发现ReLU有其缺陷,即举例来说,ReLU 无法使用单一的超平面将分离的所有数据,完整的输出,即只会输出半个空间映射的数据,而另一半空间的数据被置为0;ReLU 要完整的映射输入空间的所有数据需要至少3个节点才能办到,比如在2维的输入空间上,当只有2个节点时构成的超平面排列将输入空间划分4个区域,其中其中一定有一个区域全

未见过类别未见过类别(unseen category)或者叫不知道类别(unknown category)。简单来说,如我们定义类别{苹果,香蕉} 且其数据集为D,那么定义一个二分类器C,将D分割为训练集和测试集,那么训练出的分类器只能区分两个类别。假设我们拥有数据Dx,其中拥有的分类为{小狗,小猫},这个时候将Dx混入D的测试集,二分类器C如何分类Dx中的数据?这时我们将Dx包含的数...