简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

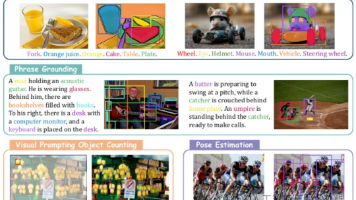

TAP:Tokenize Anything via Prompting,发表于2023年。我们提出了一种统一的、可提示的模型,能够同时对任何事物进行分割、识别和描述。与 SAM 不同,我们旨在通过视觉提示构建一个通用的多功能区域表示。为实现这一目标,我们使用大量的分割掩码(如 SA-1B 掩码)以及来自具有 50 亿参数的预训练 CLIP 模型的语义先验来训练一个可泛化的模型。具体来说,我们通过给

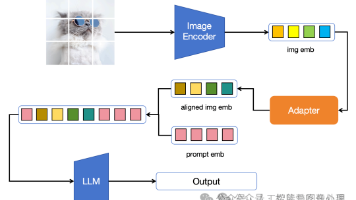

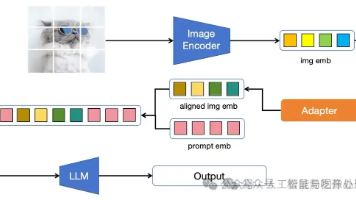

模型结构上:LLaVA仅用简单的线性链接层就完成了视觉模型与LLM的结合,结合方法简单但有效。训练数据上:LLaVA给出了一种使用ChatGPT造训练数据的方法。虽然类似的方法在语言大模型的训练中较为常见,但该文是在多模态大模型上的首次尝试。训练方法上:作者先采用了大量的易学数据训练少量参数让模型学会认图,再用少量难学的数据训练大量参数让模型学会基于图像的多轮对话和逻辑推理能力。

QWenVL提出来能力增强的训练阶段,并使用了B级别的对齐训练数据,M级别的能力增强数据和K级别的指令跟随数据,训练多模态大模型。能力增强训练可能较为耗费资源但能极大程度提升模型效果。后续自己构建大模型时可以考虑构建和下游任务接近的训练任务用于能力增强训练。

DINO-X,2024年11月20号IDEA Research 开发的具有最佳开放世界物体检测性能的统一的以物体为中心的视觉模型。为了使长尾物体检测变得简单,DINO-X 扩展了其输入选项以支持文本提示、视觉提示和自定义提示。

一,理论知识K-means算法是聚类中的经典算法,数据挖掘十大经典算法之一。算法接受参数k,然后将事先输入的n个数据对象划分k个聚类;同一聚类中的对象相似度较高;不同聚类中的对象相似度较小。算法思想:以空间中k个点为中心点进行聚类,对最靠近他们的对象归类。通过迭代的方法,逐次更新各聚类中心的值,直至得到最好的聚类结果算法描述:...

目标检测算法-YOLOV8解析(附论文和源码)

点击获取基于CNN的MNIST识别源代码(GitHub) 一,CNN等理论参考:卷积神经网络(CNN) 二,Tensorboard可视化代码:# coding: utf-8import tensorflow as tffrom tensorflow.examples.tutorials.mnist import input_data#载入数据集mnist ...

先占坑,以后补成自己的理解。其实我觉得,只要理解了LSTM,GRU很好理解,只是变了一下内部结构。下面这篇文章是写GRU的,写的很好https://blog.csdn.net/wangyangzhizhou/article/details/77332582...

https://zhuanlan.zhihu.com/p/386553691、Chinese Text in Wild (CTW)32285张图像,1018402个中文字符(来自于腾讯街景);包含平面文本,凸起文本,城市文本,农村文本,低亮度文本,远处文本,部分遮挡文本。图像大小2048*2048,数据集大小为31GB。(8:1:1)比例训练集(25887张图像,812...

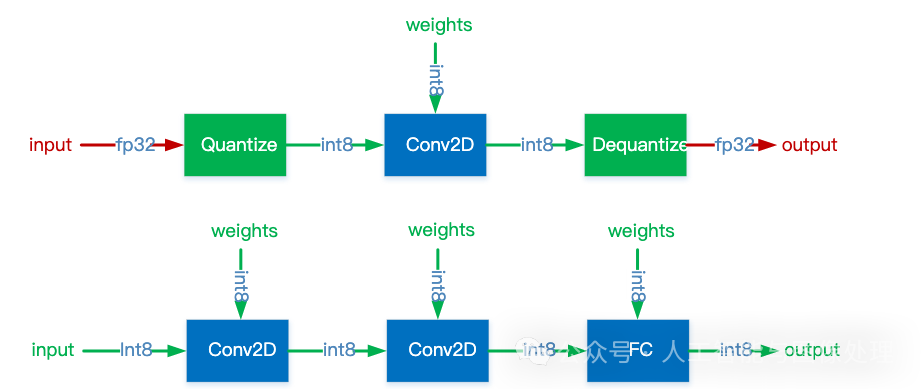

深度学习模型量化是一项重要的技术,旨在通过减少网络参数的比特宽度(比特宽度是指在特定时间内,数据传输过程中每个比特所占用的时间或空间)来减小模型大小和加速推理过程,同时保持模型性能,以便将模型部署到边缘或低算力设备上,实现降低成本、提高效率的目标。