简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章介绍了具有6710亿参数的混合专家模型DeepSeek-V3,通过创新架构、高效训练和优化策略,在性能上超越开源模型且与闭源模型相当,同时保持较低训练成本。fill:#333;color:#333;color:#333;fill:none;研究背景模型架构训练基础设施预训练后训练研究结论大语言模型发展迅速,开源模型追赶闭源模型DeepSeek-V3旨在提升开源模型能力,平衡性能和成本基础架构:

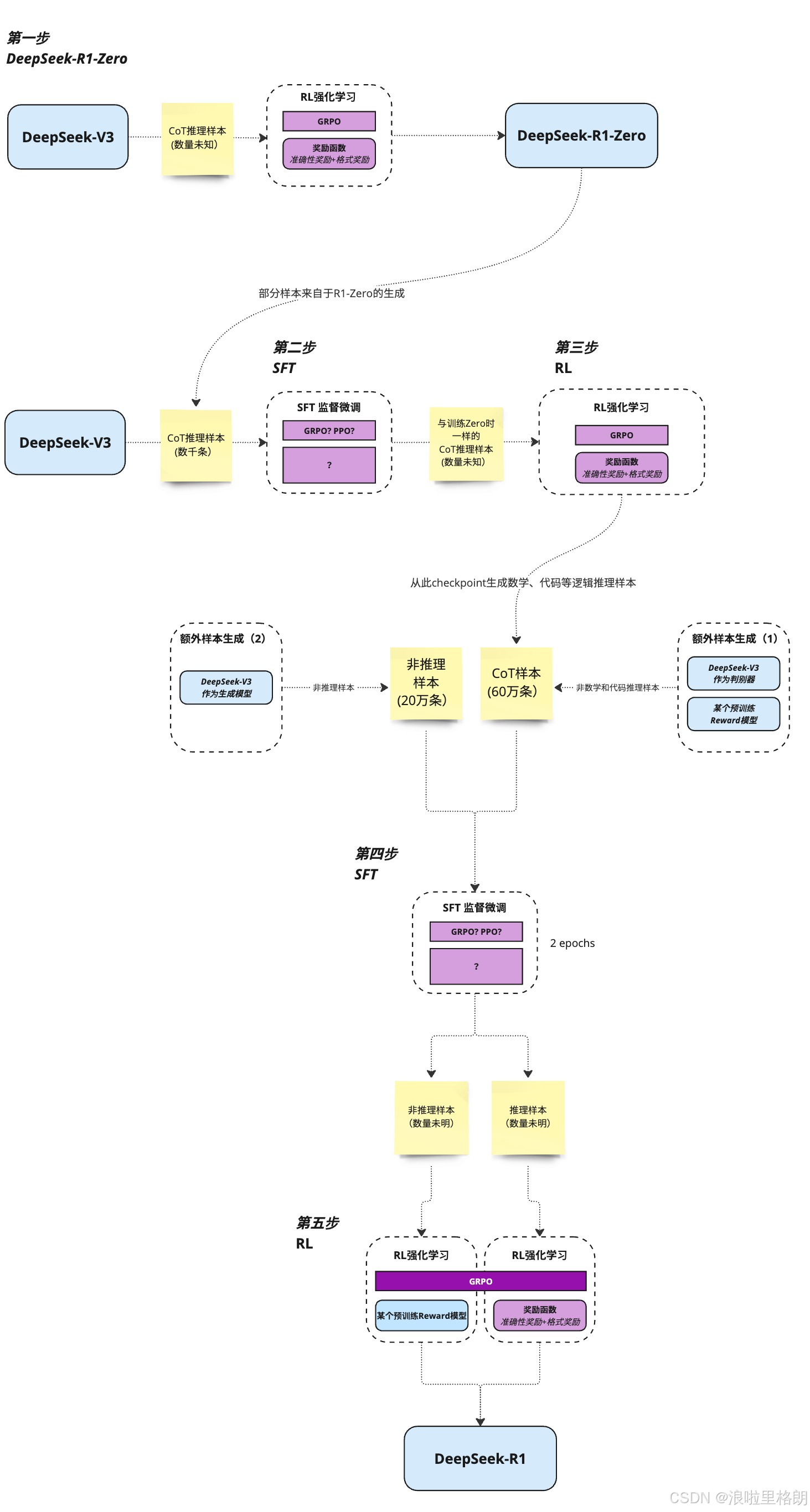

文章介绍了通过强化学习提升大语言模型推理能力的研究,提出DeepSeek-R1-Zero和DeepSeek-R1模型,探索了强化学习在模型训练中的应用,展示了模型在多种任务上的优异性能,并讨论了研究中的经验和未来方向。fill:#333;color:#333;color:#333;fill:none;大语言模型推理能力研究研究背景创新模型方法实验评估研究讨论研究结论后训练创新模型蒸馏成果直接应用R

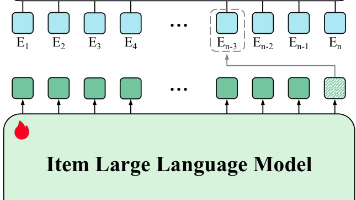

各位技术大佬们,大家好!今天咱们来聊点硬核的——推荐系统。这玩意儿,大家都不陌生吧?从刷抖音到逛淘宝,从看电影到听音乐,它无处不在,默默地影响着我们的每一个选择。可以说,推荐系统就是我们数字生活里的“贴心小棉袄”(也可能是“剁手小恶魔”)。传统的推荐系统,大家最熟悉的就是基于ID的那些模型了。简单来说,就是把用户和商品都变成一串串ID,然后用各种花式算法去学习这些ID之间的关系。比如协同过滤、矩阵

Qwen2.5-Omni是首个支持文本、图像、音频、视频全模态输入与流式文本/语音输出的端到端多模态大模型。通过块处理音视频编码器将长序列多模态数据解耦,利用TMRoPE时间对齐位置编码实现音视频时序同步,创新提出Thinker-Talker架构Thinker作为多模态推理核心,处理跨模态语义融合;Talker作为双轨生成引擎,并行输出文本与自然语音,通过滑动窗口DiT模型降低流式生成延迟。针对多

重点解决的问题:旨在打造更优的大语言模型,解决过往模型在数据、规模、应用等方面的局限,提升模型的通用性、准确性和效率,以满足多样化的使用需求,推动大语言模型在各领域的应用与发展。创新点数据处理创新:如Figure 1所示,预训练数据从7万亿token扩展到18万亿token,通过优化数据筛选、融入高质量领域数据、生成合成数据以及平衡数据分布等手段,提升数据质量。利用Qwen2-Instruct模型

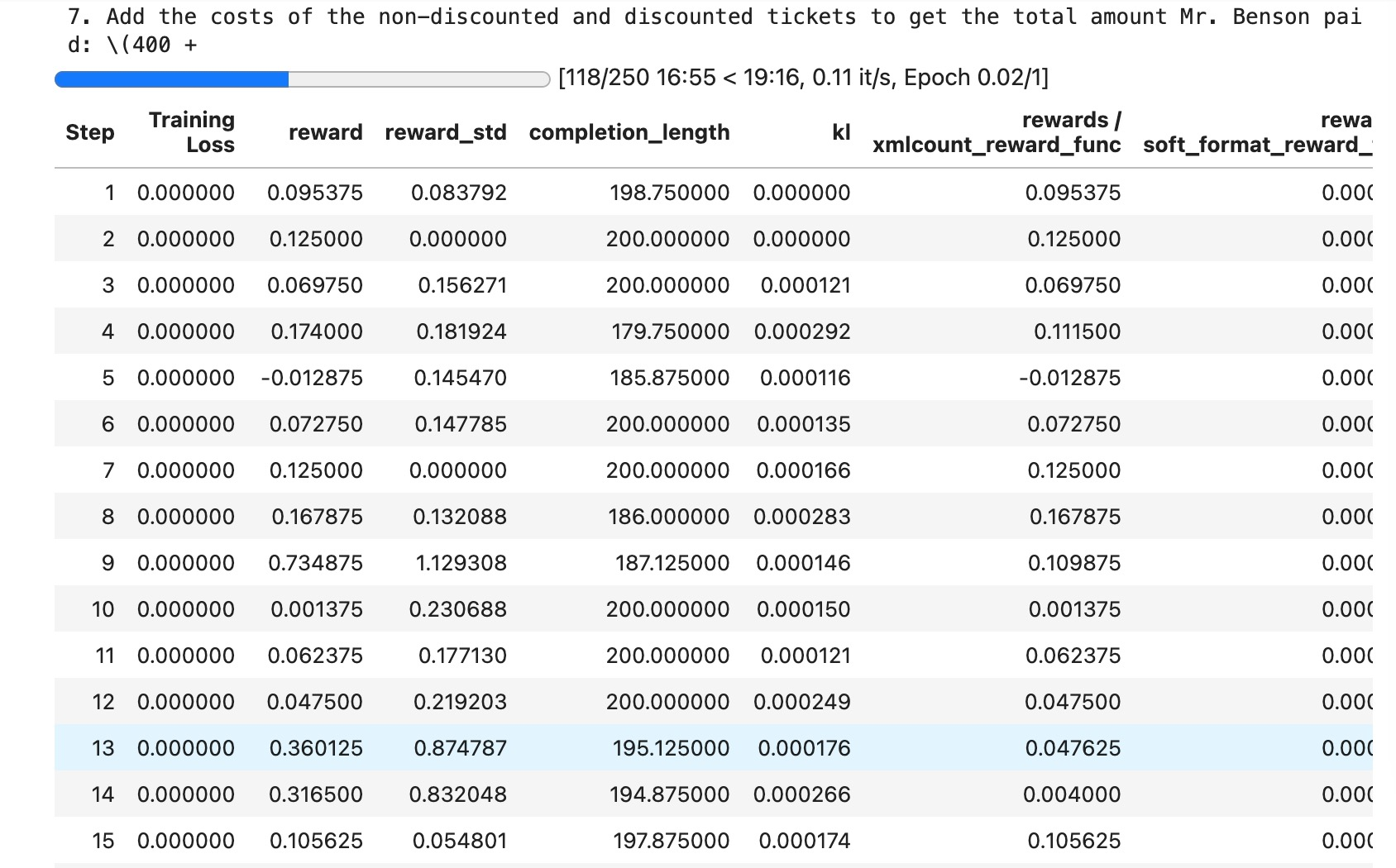

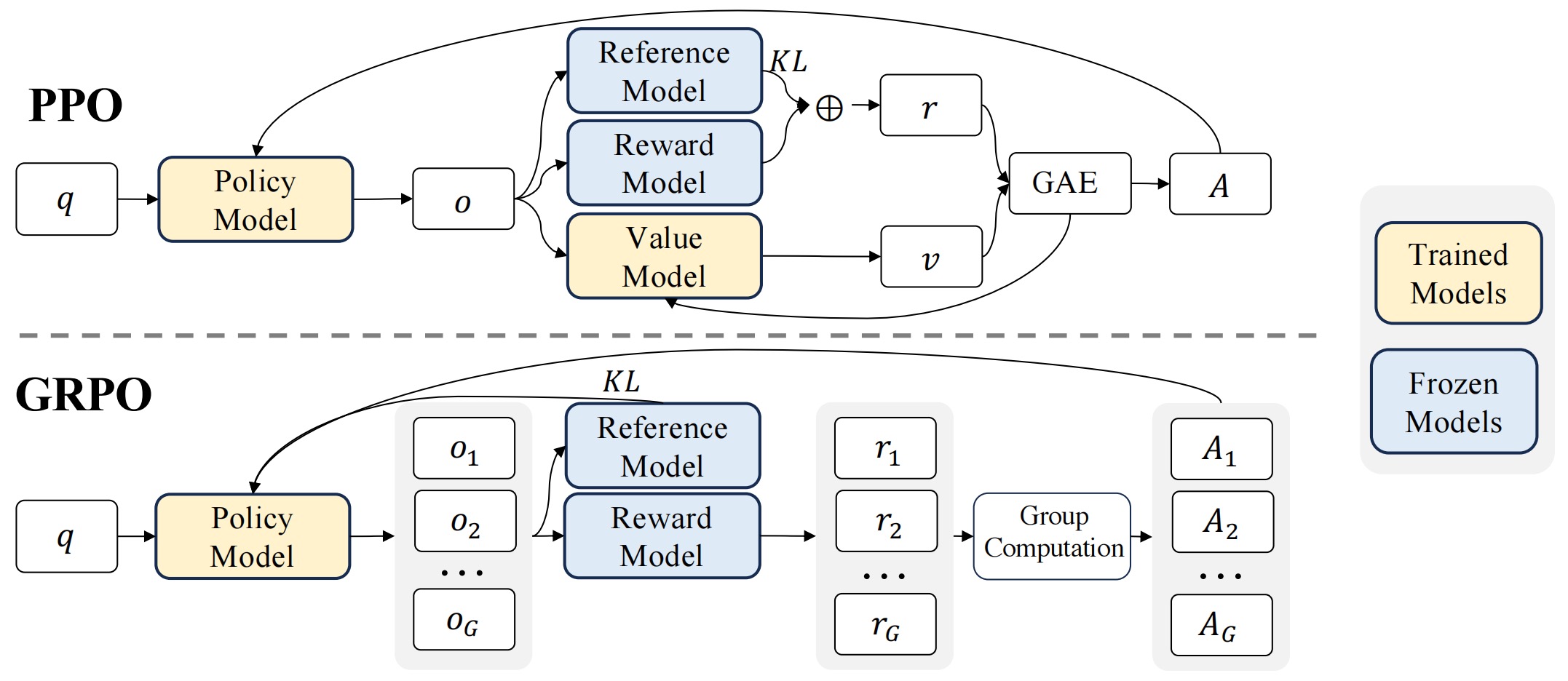

本教程主要目的是完成 在的GPU服务器 4090 上,对 大模型(Qwen2.5_Coder_3B)进行GRPO训练,所使用的数据集是 “gms8k”。当然,也可以使用其他类型的GPU,实现训练过程中 24G的显存也会用到了7G, 模型可以完美切换到其他Qwen模型进行微调,我这里只是为了演示选择了较少的3B模型。

DeepSeekMath 通过大规模数学预训练和高效强化学习(GRPO)算法,显著提升了开源模型的数学推理能力,在 MATH 基准上首次突破 50% 准确率,接近闭源模型水平。其方法论为开源社区提供了重要参考,未来在数据质量和算法效率上仍有优化空间。fill:#333;color:#333;color:#333;fill:none;DeepSeekMath数学推理模型研究研究背景与目标核心贡献方法

本教程可在的 4090 GPU 实例上运行。

2025年3月24号,也就是周一,Deepseek突然发布他们 DeepSeek V3 的新版本模型 DeepSeek-V3-0324。目前还有技术报告只有一个news和模型,不过从效果上来看也是很炸裂的,对标都是最新的闭源模型的前排选手。主要改进点有:推理性能大幅提升,更强的前端开发技能,以及更智能的工具使用能力。我们一起来看看吧。

深度 Q 学习(Deep Q - Learning,简称 DQN)是强化学习领域中结合了与的算法。其核心目标在于借助深度神经网络来近似 Q 函数,从而克服传统 Q - Learning 在处理大规模或连续状态空间时所面临的计算难题。DQN 的核心思想是采用深度神经网络(通常为卷积神经网络或者多层感知机)作为函数逼近器,用以估计动作 - 值函数(action - value function),也就