简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

一键生成图像标注,视觉问答,代码开源,官方 Demo 可玩、一线 AI 资讯速递

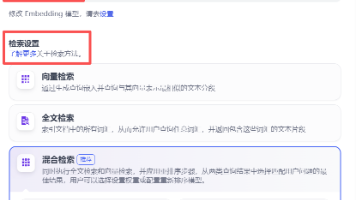

Dify 中为知识库模型选择:Embedding 模型:BGE-M3;Rerank 模型:bce-reranker-base_v1这是一个非常先进且合理的组合,尤其适合中文场景下的高精度语义检索。下面我为你详细解析这两个模型在知识库检索流程中的分工、作用与协同机制。

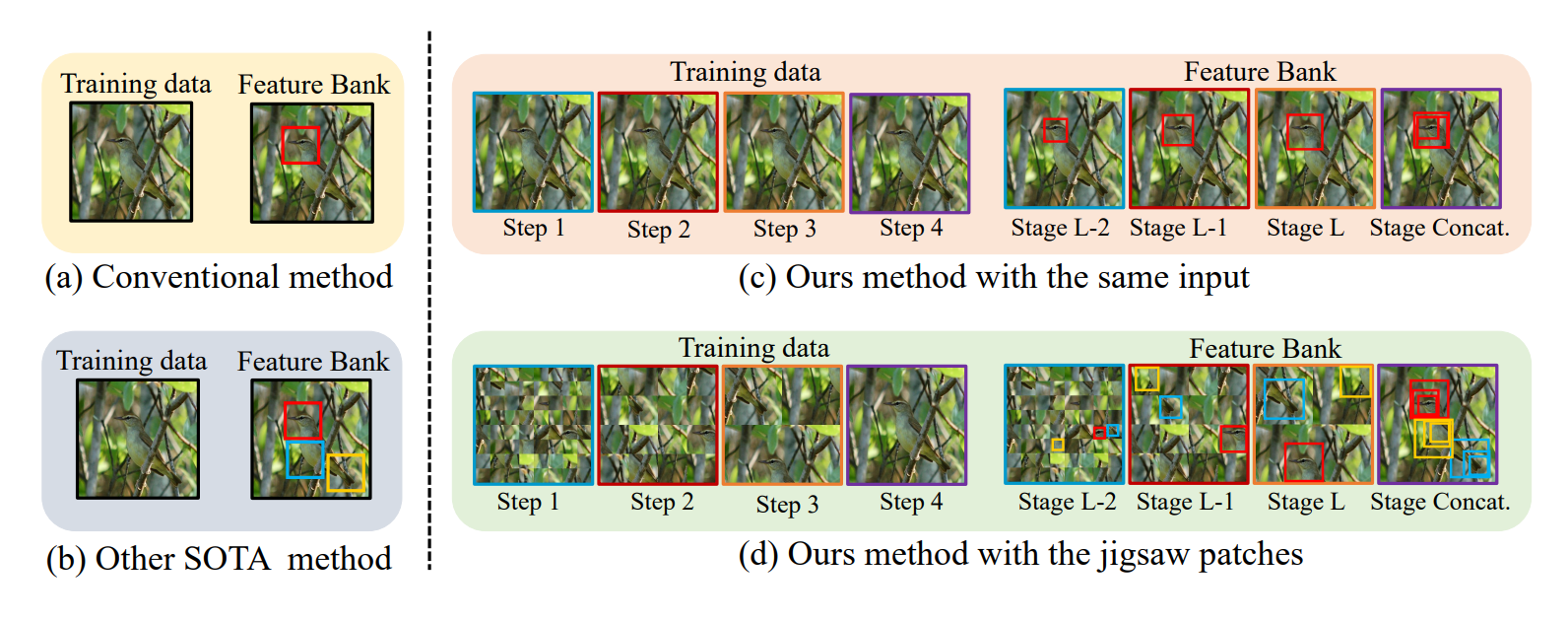

由于类内对象本身的细微变化,细粒度视觉分类(FGVC)比传统的分类任务更具挑战性。最近的工作主要通过关注如何定位最具辨别力的部分、更多互补部分和各种粒度的部分来解决这个问题。然而,对于哪些粒度最具区分性,以及如何跨多粒度融合信息,所做的工作较少。在这项工作中,我们提出了一种新的细粒度视觉分类框架来解决这些问题。特别地,我们提出:(i)一种新的渐进式训练策略,该策略在每个训练步骤中添加新的层,以利用

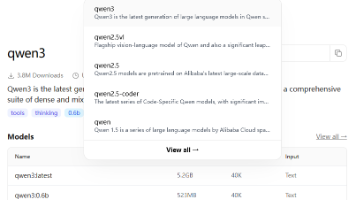

Ollama大模型本地部署与管理指南:介绍了Ollama平台(ollama.com)的基本使用方法,包括不同参数模型(0.6B/1.7B/4B)的运行命令。详细说明了模型管理方法:查看模型列表、删除单个/批量模型、完全卸载软件及清理数据目录的步骤。同时介绍了通过open-webui实现大模型交互的安装方法(pip安装后访问8082端口)。最后附有操作注意事项和验证方法,帮助用户有效管理本地大模型资

./test_main: error while loading shared libraries: libopencv_imgcodecs.so.405: cannot open shared object file: No such file or directory

基于噪声和核函数的精细退化盲图像超分辨率重建,这篇测评文章用心写了一个下午,个人觉得作为一个初学者入门教程,再合适不过了,敬请查阅

细粒度图像分析(FGIA)是计算机视觉和模式识别中一个长期存在的基本问题,是一系列实际应用的基础。FGIA的任务是分析下属类别的视觉对象,例如鸟类物种或汽车模型。细粒度图像分析固有的小类间变化和大类内变化使其成为一个具有挑战性的问题。利用深度学习的进步,近年来我们见证了以深度学习为动力的FGIA的显著进步。在本文中,我们对这些进展进行了系统的综述,试图通过整合两个基本的细粒度研究领域——细粒度图像

使用,shell 工具远程连接服务器,然后就可以开始配置 我的深度学习体验环境了;对于我们而言,最重要的就是使用 conda 来进行相应的深度学习环境独立搭建,它的好处是:不同项目可以依赖并安装各自的环境,互不干扰。

open-mmlab/mmocr 环境搭建、推理和训练入门教程

增强技术对于提升 YOLO 模型的鲁棒性和性能至关重要,通过引入训练数据的数据增强,帮助模型更好地泛化到未见数据。这些设置可以根据数据集和任务的具体要求进行调整。尝试不同的值可以帮助找到最佳的增强策略,从而实现最佳的模型性能。