简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

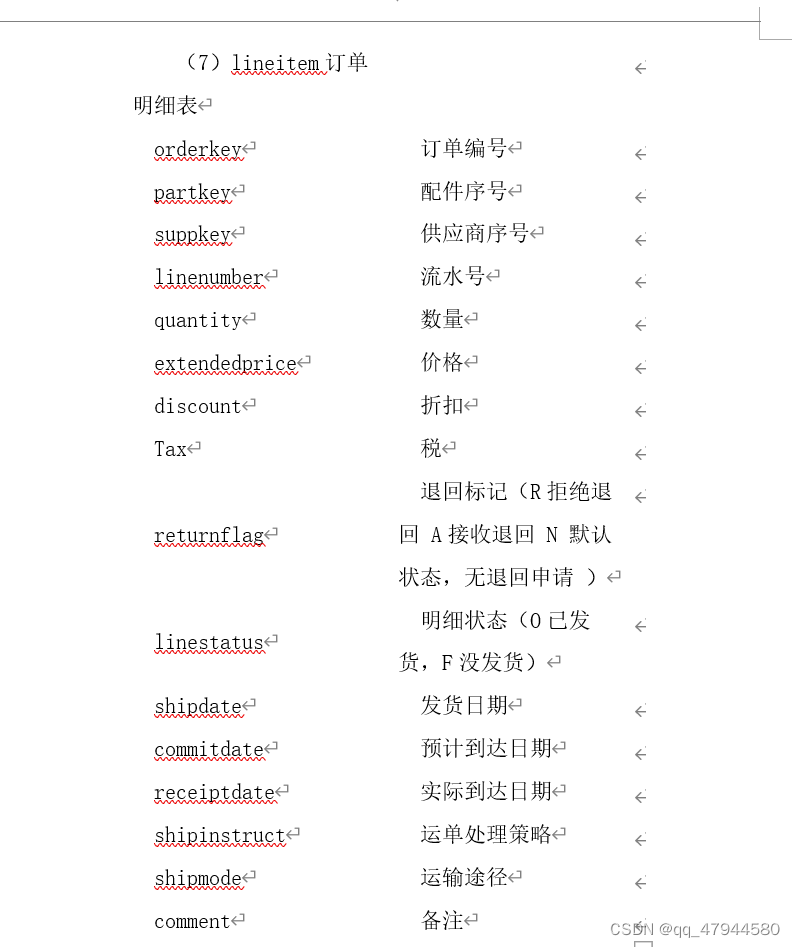

一个简单的小时级数据仓库构建

利用Kafka作为中间件,通过spring boot项目开放一个接口传数据,通过生产者发送,消费者来接收数据后按照小时划分存为文件,后load到hive仓库。原因百度应该是有什么特殊符号问题可能是命令行换行符,,但是我截取出来只有数字。可能是shell哪里的问题吧。一开始直接把时间切分剩小时,结果报错 ambiguous redirect,又切分一下就好了。把文件load到hive数据仓库,根据小

基于flink,kafka实时计算订单topN,存到redis

主要难点是计算一定时间内订单总数topN,使用aggregate算子,重写方法自定义聚合函数

到底了