简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

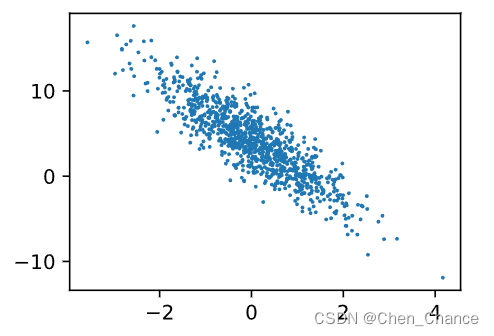

是 Jupyter Notebook 或 JupyterLab 中的一个魔术命令,用于在 Notebook 中显示 matplotlib 图形的输出。导入了 Python 的 random 模块,用于生成随机数。导入了 PyTorch 库,用于深度学习任务。导入了 d2l 模块,并将其重命名为 d2l。d2l 是 Dive into Deep Learning (D2L) 图书的一个开源教学库,用

ε-贪心算法是强化学习中一个基本而有效的探索策略。通过简单的随机探索和基于当前知识的利用,智能体可以在复杂环境中学习并找到最优策略。随着对强化学习更深入的研究,我们可以期待更高级的探索策略将被开发出来,以进一步提高学习效率和性能。

Robbins-Monro 算法是一种用于求解非线性方程的迭代算法,通常用于根的搜索和估计。它的主要思想是通过不断迭代来逼近方程的根,而无需显式地解出方程。这个算法在统计学和机器学习中有广泛的应用,特别是在参数估计和优化问题中。算法的一般步骤如下:初始化:选择一个初始估计值x0。

【代码】We couldn‘t connect to ‘https://huggingface.co‘ to load this file, couldn‘t find it in the cached fi。

Buzz 是一个开源项目,能够在个人电脑上离线转录和翻译音频,这一切都得益于OpenAI的Whisper技术。它提供了一个本地化的解决方案,无需依赖网络连接即可处理音频文件,使其成为处理敏感信息时的理想选择。Buzz支持多种安装方式,包括通过PyPI、Homebrew(针对macOS用户)、下载Windows可执行文件以及Linux上的Snap安装。此外,它还在App Store提供了Mac原生版

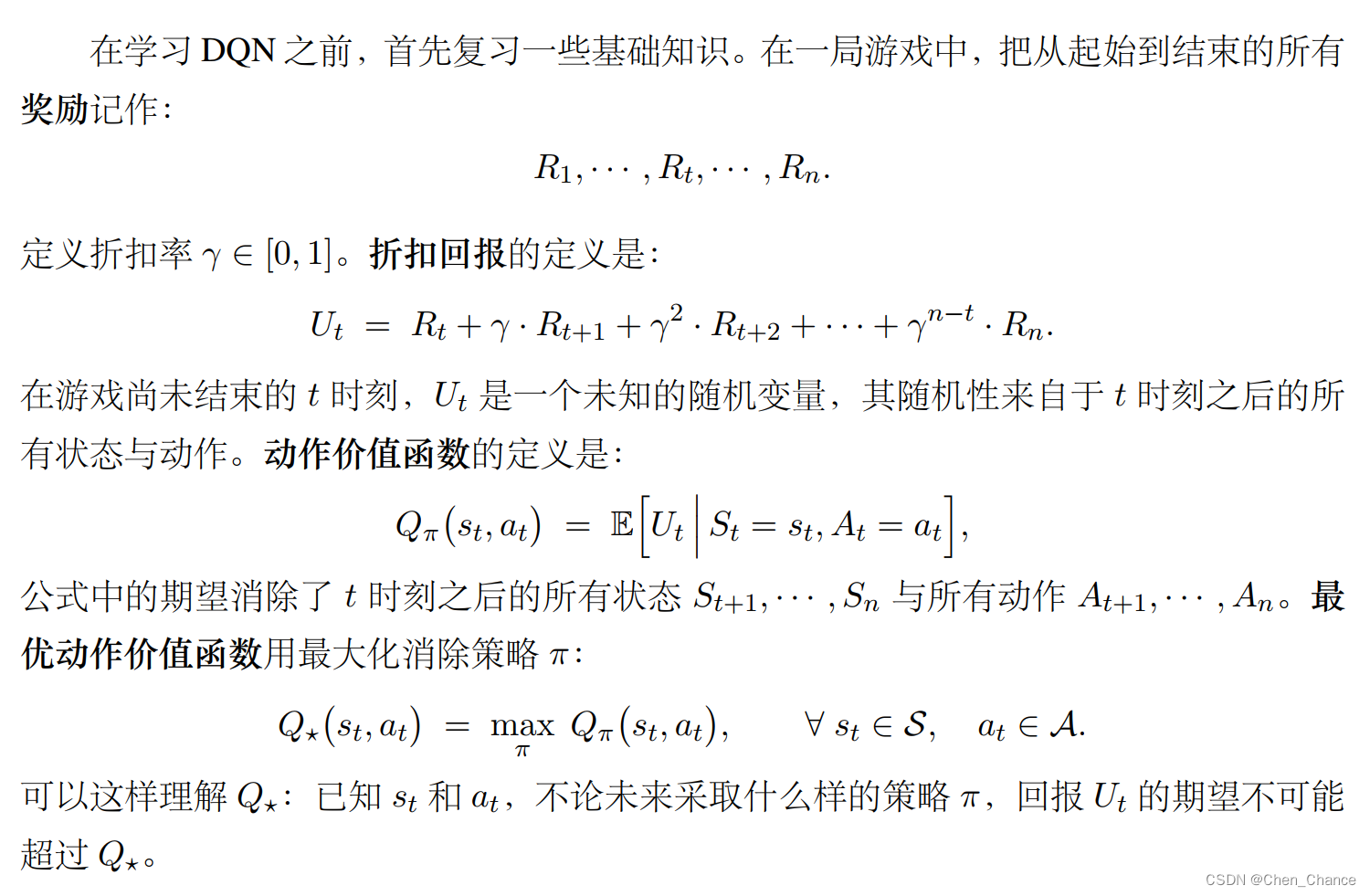

Q⋆Q⋆Q⋆Q⋆Q⋆对于超级玛丽这样的游戏,学出来一个“先知”并不难。假如让我们重复玩超级玛丽一亿次,那我们就会像先知一样,看到当前状态,就能准确判断出当前最优的动作是什么。这说明只要有,就能训练出超级玛丽中的“先知”。

在这两种情况下,确定性和不确定性会影响智能体如何处理和学习环境的信息,以及制定最佳策略。确定性环境可以更容易地建立模型和预测结果,而不确定性环境则需要更多的适应性和探索来应对变化和风险。在强化学习中,"环境是确定的"通常指的是环境的状态转移概率是不变的。具体来说,这意味着给定当前的环境状态和智能体的动作,环境下一时刻的状态和奖励是确定的。

Q-learning告诉智能体在每种情况下,应该选择哪个动作以便获得最多奖励。具体来说,Q-learning使用一个叫做Q值的表格,其中每一行表示一种情况(也叫状态),每一列表示可选的动作。每个单元格中的数字表示采取某个动作后,可以获得的奖励预期值。智能体在每个时刻根据当前情况,查看Q值表格,然后选择具有最高Q值的动作。但为了探索新的可能性,有时候它也会随机尝试其他动作。随着不断的尝试和奖励的反馈

解决办法:1. 打开设置,搜索compact2. 将第一个勾去除即可

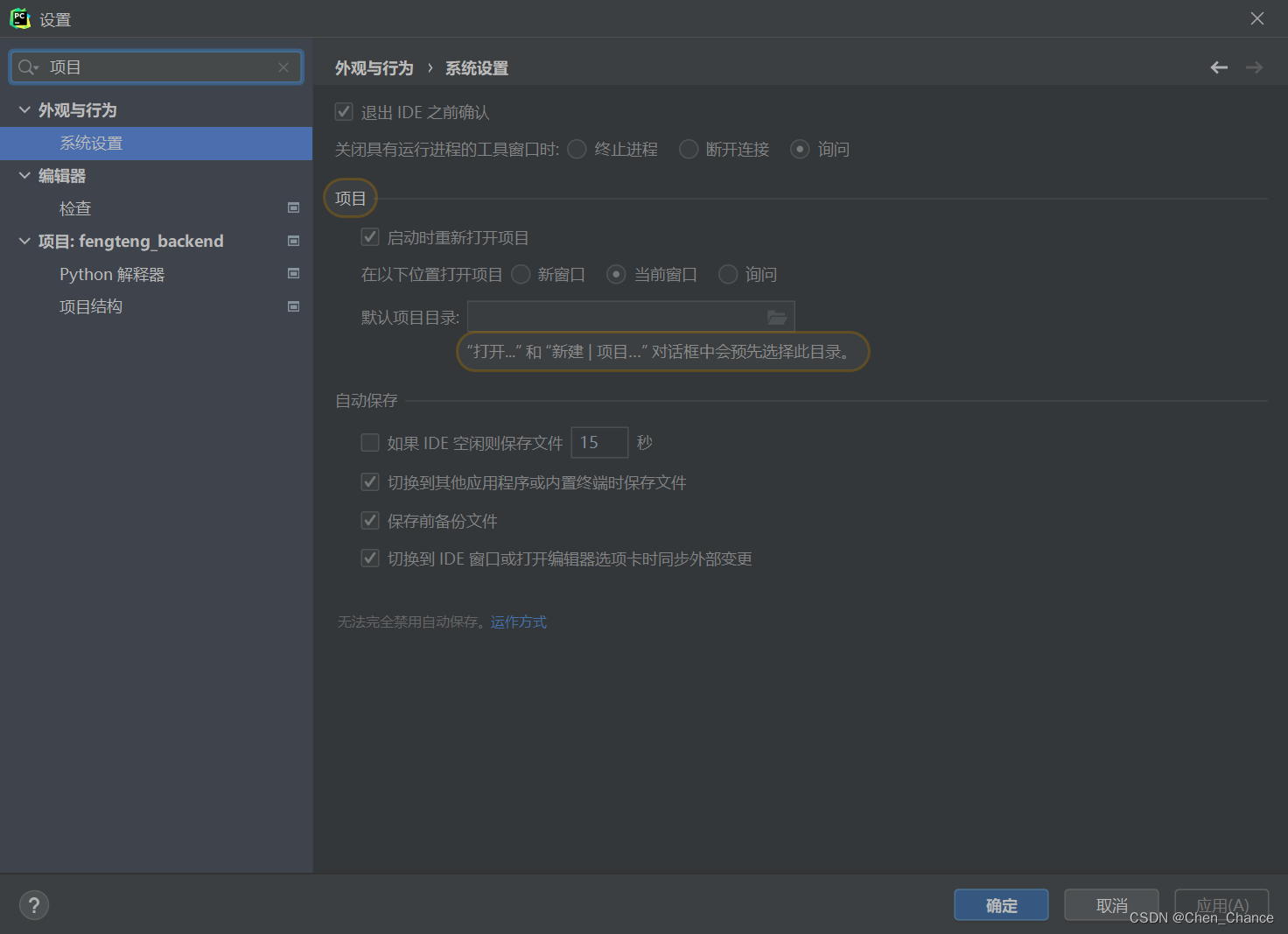

进入设置,搜索项目,选择新窗口或询问都可以。下面是选择了询问后打开新项目会弹出的页面。