简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

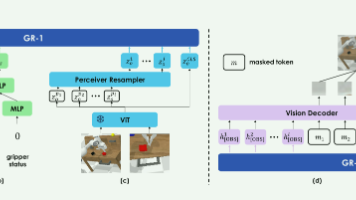

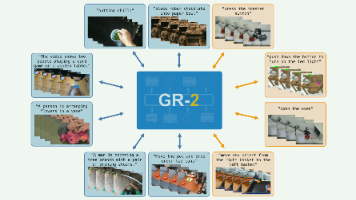

传统的机器人学习太依赖昂贵的机器人数据,难以扩展。GR-2借力打力,利用互联网上无穷无尽的人类视频,通过“预测未来画面”的预训练任务,让模型先学会物理世界的运作规律。在这个强大的“常识底座”上,只需喂给它少量的机器人数据,它就能迅速学会各种操作,并且即便换了环境、换了物体也能稳定工作。这为通用的具身智能(Embodied AI)指出了一条极具潜力的道路——从视频生成迈向机器人控制。

传统的机器人学习太依赖昂贵的机器人数据,难以扩展。GR-2借力打力,利用互联网上无穷无尽的人类视频,通过“预测未来画面”的预训练任务,让模型先学会物理世界的运作规律。在这个强大的“常识底座”上,只需喂给它少量的机器人数据,它就能迅速学会各种操作,并且即便换了环境、换了物体也能稳定工作。这为通用的具身智能(Embodied AI)指出了一条极具潜力的道路——从视频生成迈向机器人控制。

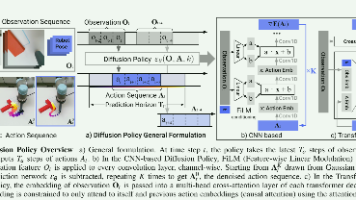

这篇文章的核心点之一是关于连续动作序列的建模,以保持一致性,还有一篇文章ACT也有体现。总的来说。提出,将用于机器人视觉-运动策略学习(visuomotor policy)。旨在解决传统策略学习在多模态动作、长序列一致性、高维动作空间和训练稳定性上的问题。核心方法将机器人动作预测建模为DDPM去噪过程初始动作从高斯噪声采样 → 多轮去噪 → 得到最终动作序列。动作预测是条件化的(condition

提出了一个能够在真实世界中进行多任务机器人操作、并且具备高样本效率和泛化能力的框架。通过语义场景增强快速扩增小规模机器人数据集训练一个多任务、语言条件控制的策略模型MT-ACT,能够吸收经过增强后的多模态数据。文章结合并改进了多个原本用于单任务策略的设计(例如,(动作块预测)、(时间聚合)),并证明这些方法在我们的多任务设置中仍然能显著提升性能。,对时间序列上的多个预测或数据进行整合处理,对预测动

提出了一个能够在真实世界中进行多任务机器人操作、并且具备高样本效率和泛化能力的框架。通过语义场景增强快速扩增小规模机器人数据集训练一个多任务、语言条件控制的策略模型MT-ACT,能够吸收经过增强后的多模态数据。文章结合并改进了多个原本用于单任务策略的设计(例如,(动作块预测)、(时间聚合)),并证明这些方法在我们的多任务设置中仍然能显著提升性能。,对时间序列上的多个预测或数据进行整合处理,对预测动

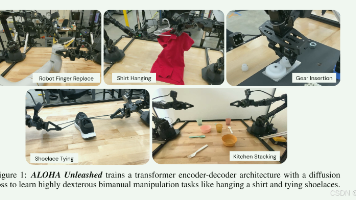

提出了,1.在ALOHA 2 平台上收集了超过 26,000 个示范、2.使用这些数据训练了基于 Transformer 的、3.在真实和模拟环境中,充分展示了机器人灵巧行为。ALOHA Unleashed 证明,一个简单的方法就可以提升双臂灵巧操作的能力。局限性,策略每次只训练单一任务(其他方法可能使用单一模型权重,通过语言或目标图像条件化,实现多任务操作)、2.策略每 1 秒重新规划一次(对于

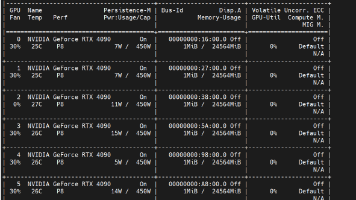

采用docker,一个必要的步骤就是需要安装nvidia-container-toolkit,这样才能实现容器内的gpu访问。支持gpu共享,用户环境内能够正常访问宿主机 GPU,支持 PyTorch、TensorFlow 等深度学习框架的 GPU 功能。考虑了lxd,lxc,docker,Determined等方案,由于一些客观因素,这次计划采用docker进行管理。2.进行配置,这里只针对do

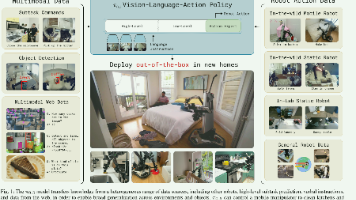

π0.5,一个基于 π0 VLA 的联合训练模型,能够整合多种数据源,并在新环境中实现泛化。π0.5 可控制移动机械臂在未见过的家庭环境中执行任务,训练数据包括400h的移动机械臂操作数据,和其他类型机器人的数据以及互联网和高层任务数据。π0.5 展示了联合训练方案能够有效迁移,即使只有中等规模的移动操作数据,也能实现高度泛化的控制能力。但是,仍然存在一些比较难解决的问题,解决这些问题可以通过更好

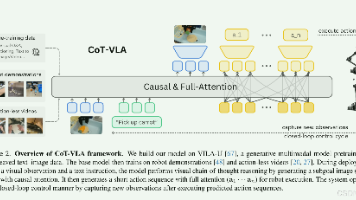

提出CoT-VLA:把视觉-语言-动作模型和思维链结合,通过引入中间视觉目标(subgoal images)作为显式推理步骤,与传统用或关键点的抽象表示不同,使用视频中采样的子目标图像,既可解释又有效,基于VILA-U模型构建,在多种机器人操作上表现较好。但是也存在计算开销大,视觉质量欠佳(自回归图像生成不如扩散模型),动作分块导致动作可能不连续(这一个动作片段和下一个动作片段不连续),视觉推理泛