简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

作为一个写了10年代码的老程序员,我见过太多"颠覆性"技术最后沦为PPT产品。什么"低代码平台让人人都是开发者",什么"AI将取代程序员"…每次听到这种话,我都会心一笑:写代码哪有那么简单?但这次,我决定认真测试一下。不是简单地让ChatGPT写个Hello World,而是真刀真枪地测试100个实际编程场景,从简单的工具函数到复杂的业务逻辑,从算法题到系统设计。

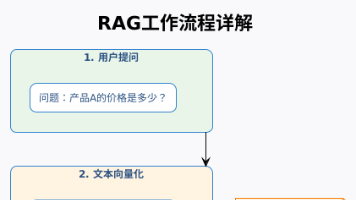

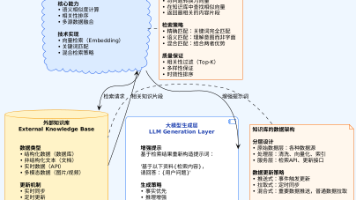

什么是RAG?为什么准确率这么低?这篇文章绝对是纯干货,对于正在做RAG项目的开发者来说价值巨大!🎉

字节跳动正式开源AI Agent平台Coze,推出三大核心模块:低代码开发平台Coze Studio、运维调试工具Coze Loop和编排框架Eino,全面覆盖Agent开发到运维流程。项目采用Apache 2.0协议,支持商业应用,GitHub Star数已突破13K。Coze实现轻量化部署(2核4G+Docker),为开发者提供可视化工作流、Prompt调试和模型编排能力,标志着AI Agen

摘要:视频测评Bright Data Web MCP与Claude Code的企业级数据采集方案,推荐关注官方技术博客(CSDN/GitHub/知乎)获取最新资源。新用户通过专属链接注册可获30美元试用额度,适合AI开发者、数据工程师及创业团队进行项目测试。包含产品体验入口和技术支持渠道信息。(149字)

亮数据(Bright Data)推出MCP网页工具,助力AI开发者连接实时互联网并理解网络内容。该工具支持AI项目开发,提供30美元注册优惠,适合AI开发者、数据工程师和创业团队进行原型验证和轻量级部署。官方推荐关注CSDN技术博客、GitHub中文区和知乎机构号获取最新技术资源。

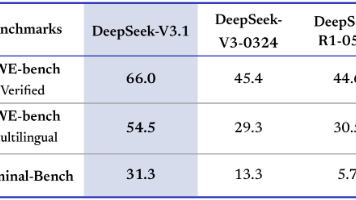

《DeepSeek-V3.1「终极版」发布:体验优化,V4/R2蓄势待发》 DeepSeek最新模型V3.1-Terminus正式推出,作为V3系列的收官之作,主打稳定性与体验优化。核心升级包括: 语言一致性提升:减少中英文混杂和符号乱码,长文写作更流畅; Agent能力强化:代码生成、检索整合和多任务协同表现更稳定,尤其Search Agent检索效率显著提升。 性能测试显示,Terminus在

Fastjson是阿里开源的高性能JSON处理库,主要用于Java对象与JSON字符串的高效转换。本文介绍了其核心功能JSON.toJSONString()和JSON.parseObject()的用法,通过告警对象、Map/List等实战示例演示了对象转JSON的过程,并展示了在WebSocket推送等场景中的应用。文章还提供了Maven依赖配置和注意事项,建议使用最新版本以规避安全风险。Fast

OpenAI发布新一代视频生成模型Sora2,标志着AI视频创作进入全民时代。该模型突破物理模拟限制,支持120秒连贯视频和音画同步,并推出独立社交应用Sora,构建纯AI内容生态。上线初期即引发市场热潮,邀请码遭疯抢,股价剧烈波动。影视、广告等行业成本骤降,但版权、虚假内容和能耗问题也随之浮现。Sora2被视为"视频领域的ChatGPT时刻",或将重塑人类视觉表达方式。

RAG技术:让大模型拥有实时知识库的AI革命 RAG(检索增强生成)技术解决了大模型知识时效性和幻觉问题,通过"检索-增强-生成"的闭环实现更准确的AI回答。该技术将知识存储与推理分离,使大模型可以实时访问外部知识库,显著提升了专业领域问答的准确性。RAG已在智能客服、医疗辅助等场景取得显著效果,但仍面临检索质量依赖、延迟等技术挑战。技术演进从基础RAG发展到多模态、智能代理等

DeepSeek-V3.1发布:迈向Agent时代的关键升级 核心亮点: 首创混合推理架构,支持思考/非思考双模式一键切换 Agent能力显著提升:工具调用成功率提高20%-50%,任务执行更稳定 工程优化:128K长上下文支持、严格模式Function Calling、兼容Anthropic API 思维链压缩技术使思考模式token消耗减少20%-50% 模型全面开源,包含Base和训练后版本