简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

偶然发现Github上某位大佬开源的DIFY源码注释和解析,目前还处于陆续不断更新地更新过程中,为大佬的专业和开源贡献精神点赞。先收藏链接,后续慢慢学习。相关链接如下:DIFY源码解析

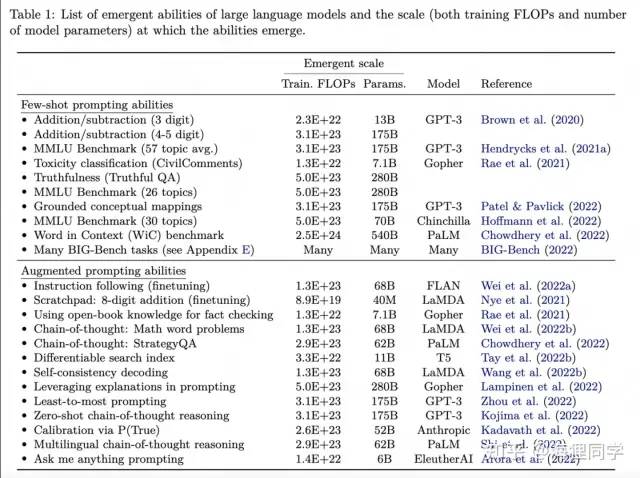

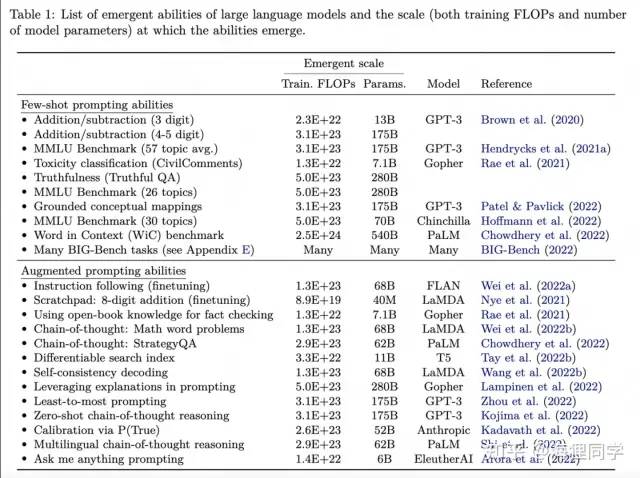

few-shot prompting的emergent主要体现为模型在没有达到一定规模前,得到的表现较为随机,在突破规模的临界点后,表现大幅度提升。虽然本文主要探究模型超过一定规模后出现emergent ability, 但模型仍然有可能通过数据,算法的改进在更小规模出现emergence. 比如在BIG-Bench任务上,LaMDA在137B,GPT-3在175B上出现emergent abil

综上所述,GPT是自然语言处理领域中最强大的模型之一,它的出色表现已经使得它在各种应用场景中得到了广泛的应用。

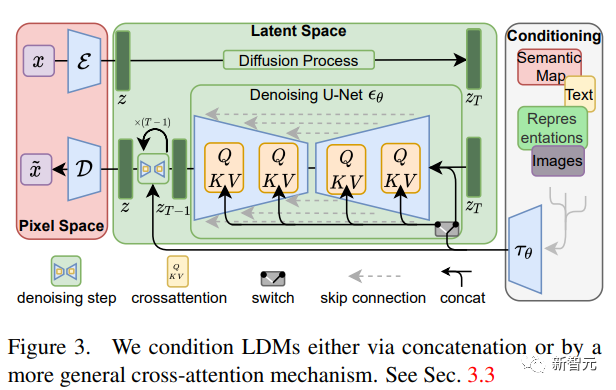

不过图像生成真正进入全民化还要数Stable Diffusion的开源,仅在消费级的GPU上即可运行,用户可以在自己的数据集上进行微调,也不用忍受各大绘画网站为了「安全」设立的各种过滤词表,真正实现了「绘画自由」。通过将图像形成过程分解为自动编码器去噪的顺序应用,扩散模型实现了对图像数据和其他数据的最新合成结果,并且扩散模型的公式能够接受一个引导机制来控制图像生成过程,而不需要重新训练。为了能够在

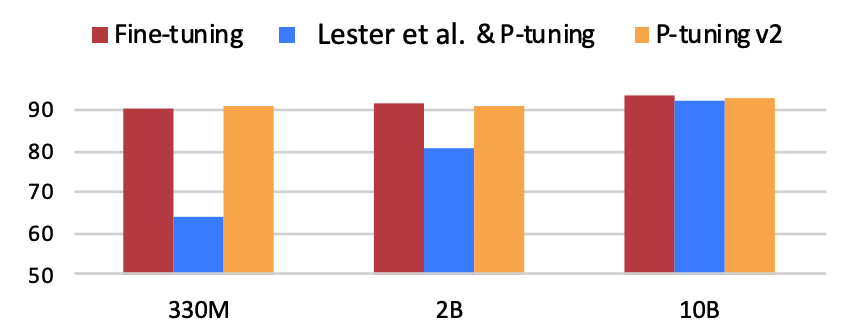

Bert时代,我们常做预训练模型微调(Fine-tuning),即根据不同下游任务,引入各种辅助任务loss和垂直领域数据,将其添加到预训练模型中,以便让模型更加适配下游任务的方式。每个下游任务都存下整个预训练模型的副本,并且推理必须在单独的批次中执行。那么能不能将所有自然语言处理的任务转换为语言模型任务?就是所有任务都可以被统一建模,任务描述与任务输入视为语言模型的历史上下文,而输出则为语言模型

我们需要充分利用ChatGPT的优势和潜力,同时也需要警惕其可能带来的负面影响,采取适当的措施来保障人们的利益和权益,推动人工智能技术的健康发展和应用。技术风险和安全问题:ChatGPT需要依赖计算机系统和网络技术,这可能会带来技术风险和安全问题,如黑客攻击、数据泄露、人工智能算法错误等,这些问题需要加强技术和安全措施来保障人们的安全和权益。对人类智能的替代:随着ChatGPT的发展和应用,它有可

我们需要充分利用ChatGPT的优势和潜力,同时也需要警惕其可能带来的负面影响,采取适当的措施来保障人们的利益和权益,推动人工智能技术的健康发展和应用。技术风险和安全问题:ChatGPT需要依赖计算机系统和网络技术,这可能会带来技术风险和安全问题,如黑客攻击、数据泄露、人工智能算法错误等,这些问题需要加强技术和安全措施来保障人们的安全和权益。对人类智能的替代:随着ChatGPT的发展和应用,它有可

few-shot prompting的emergent主要体现为模型在没有达到一定规模前,得到的表现较为随机,在突破规模的临界点后,表现大幅度提升。虽然本文主要探究模型超过一定规模后出现emergent ability, 但模型仍然有可能通过数据,算法的改进在更小规模出现emergence. 比如在BIG-Bench任务上,LaMDA在137B,GPT-3在175B上出现emergent abil

偶然发现Github上某位大佬开源的DIFY源码注释和解析,目前还处于陆续不断更新地更新过程中,为大佬的专业和开源贡献精神点赞。先收藏链接,后续慢慢学习。相关链接如下:DIFY源码解析

我们需要充分利用ChatGPT的优势和潜力,同时也需要警惕其可能带来的负面影响,采取适当的措施来保障人们的利益和权益,推动人工智能技术的健康发展和应用。技术风险和安全问题:ChatGPT需要依赖计算机系统和网络技术,这可能会带来技术风险和安全问题,如黑客攻击、数据泄露、人工智能算法错误等,这些问题需要加强技术和安全措施来保障人们的安全和权益。对人类智能的替代:随着ChatGPT的发展和应用,它有可