简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

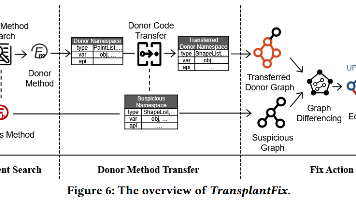

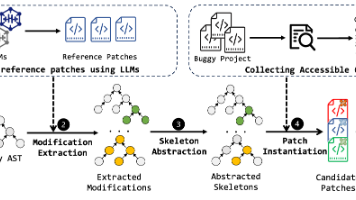

自动程序修复 (APR) 有望帮助手动调试活动。经过十多年的发展,人们提出了广泛的 APR 技术,并在一组真实的错误数据集上进行了评估。然而,尽管越来越多的错误得到了正确修复,但我们观察到,近年来通过 APR 技术修复的新错误的增长已经遇到了瓶颈。在这项工作中,我们提出 TransplantFix 来探索解决复杂错误的可能性,TransplantFix 是一种新颖的 APR 技术,利用捐赠者方法中

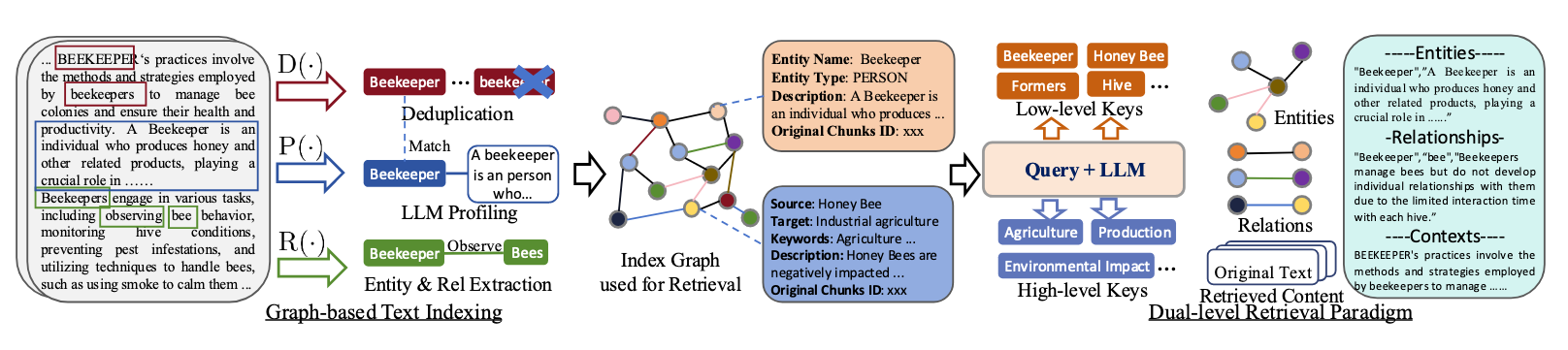

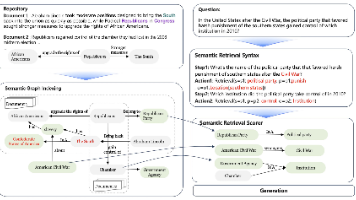

KAG框架提出了一种知识增强生成方法,通过在RAG技术中集成知识图谱的语义推理能力,显著提升了专业领域问答的准确性。该框架采用语义图索引(结合稀疏符号与稠密向量)、语义解析与推理(将问题转化为逻辑形式)、语义检索三大模块,解决了传统RAG方法依赖相似度检索和共现生成的局限性。实验表明,KAG在多跳QA任务中优于现有RAG方法,并在电子政务场景中验证了其专业性能提升。该项目已开源,支持OpenSPG

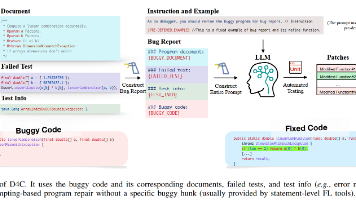

本文提出D4C框架,通过目标对齐优化大语言模型(LLM)在自动程序修复(APR)中的应用。研究发现现有方法存在两个关键问题:1)解码器LLMs的预测目标与填充式修复方法不一致;2)传统错误定位-修复流程限制LLMs发挥预训练能力。D4C将修复任务重构为程序精炼问题,让LLMs直接生成完整函数而非局部补丁,并与训练目标对齐。实验表明,D4C在Defects4J数据集上修复180个缺陷,性能超越当前最

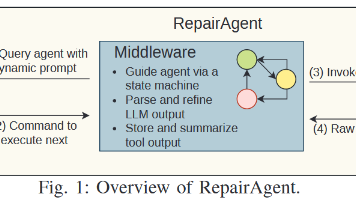

自动程序修复已成为一种强大的技术,可以减轻软件错误对系统可靠性和用户体验的影响。本文介绍了 RepairAgent,这是第一个通过基于大语言模型 (LLM) 的自治代理来解决程序修复挑战的工作。现有的基于深度学习的方法通过固定提示或固定反馈循环来提示模型,而本文的工作将 LLM 视为能够自主规划和执行操作以通过调用合适的工具来修复错误的代理。RepairAgent 自由地交叉收集有关错误的信息、收

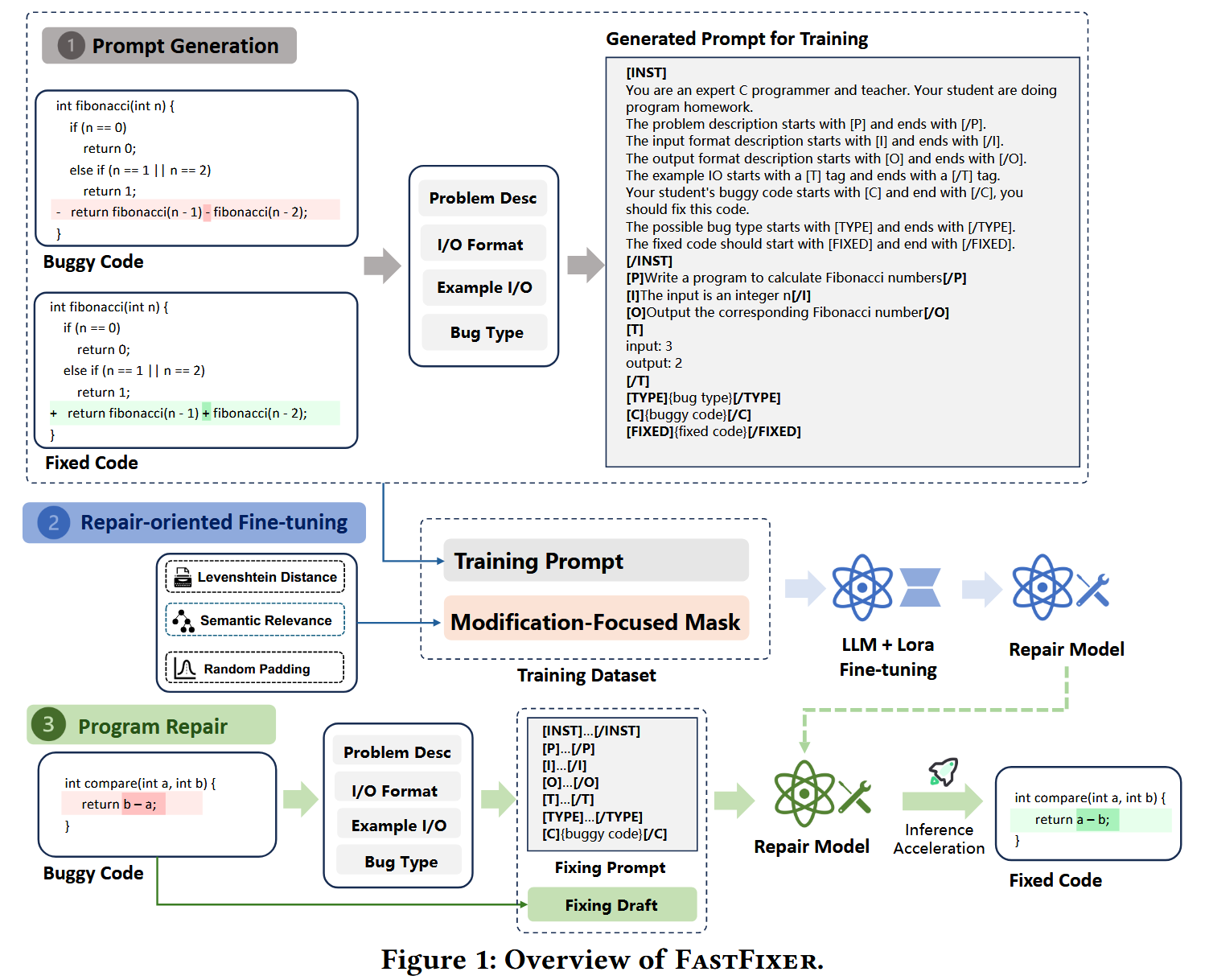

为学生的编程作业提供个性化和及时的反馈对于编程教育至关重要。自动程序修复 (APR) 技术已被用于修复编程作业中的错误,其中基于大型语言模型 (LLM) 的方法已显示出可喜的结果。鉴于在高级编程作业中识别和修复错误的复杂性日益增加,当前 APR 的微调策略不足以指导 LLM 在生成修复过程中识别错误并进行准确编辑。此外,LLM 采用的自回归解码方法可能会阻碍修复的效率,从而阻碍提供及时反馈的能力

自动化程序修复(APR)技术因有望为开发人员简化漏洞修复流程,已受到广泛关注。近年来,基于大型语言模型(LLM)的 APR 方法在修复真实世界漏洞方面展现出潜力。然而,现有 APR 方法往往直接使用 LLM 生成的补丁,未进行进一步优化,因缺乏程序特定知识导致效果受限。此外,这些 APR 方法的评估通常基于 “完美故障定位” 假设,而这一假设可能无法准确反映其在真实场景中的有效性。为解决这些局限性

提出了AGENTLESS——一种自动解决软件开发问题的无代理方法。AGENTLESS使用简单的定位、修复和补丁验证三阶段方法。与先前基于代理的方法相比,AGENTLESS故意不允许LLM用于自主工具使用或规划。通过对流行的SWE-bench Lite基准测试的评估表明,与其他开源技术相比,AGENTLESS可以实现最高的性能,同时最大限度地降低成本。此外,作者还对SWE-bench Lite中的问

软件工程师在复杂多变的环境中工作,需要不断适应需求变化、从经验中迭代学习,并基于新见解重新考虑方法。然而当前基于大型语言模型(LLM)的软件代理通常遵循线性、顺序的流程,无法回溯或探索替代解决方案,限制了其在初始方法无效时重新思考策略的能力。为了解决这些挑战,本文提出了SWE-Search,这是一种多代理框架,将蒙特卡洛树搜索(MCTS)与自我改进机制相结合,以提升软件代理在仓库级软件任务上的性

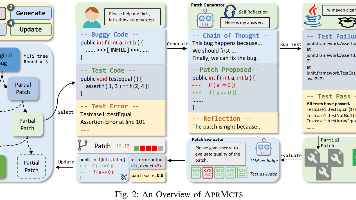

自动程序修复(APR)尝试在无需人工干预的情况下修复软件漏洞,这在软件开发和维护中起着关键作用。近年来,随着大型语言模型(LLM)的发展,APR技术的数量迅速增加,且性能显著显著。然而,现有基于LLM的APR技术通常采用试错策略,但存在两个主要缺点:(1)由于本地探索导致补丁效果有限,(2)由于冗余探索导致搜索效率较低。本文提出了APRMCTS,利用迭代树搜索改进基于LLM的APR。APRMCTS

检索增强生成(RAG)在通过外部知识集成增强大语言模型(LLM)方面取得了显著的成功,但其应用主要集中在文本内容上,而多模态视频知识的丰富领域则主要未被探索。本文介绍了 VideoRAG,这是第一个专门用于处理和理解超长上下文视频的检索增强生成框架。本文的核心创新在于其双通道架构,该架构无缝集成了 (i)基于图的文本知识对齐,用于捕获跨视频语义关系,以及(ii)多模态上下文编码,用于有效保留视觉特