简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

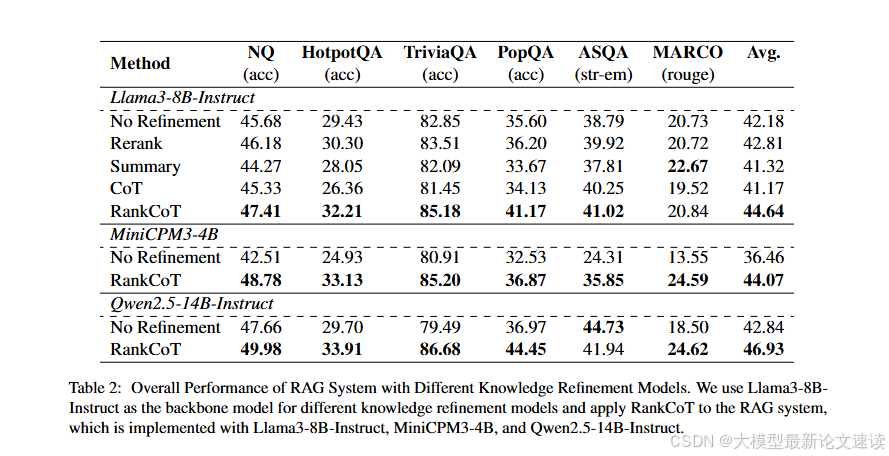

RankCoT:提高RAG系统准确性的新手段——让大模型学会对召回文档排序

通过让大模型学会对召回文档排序,提高RAG系统的准确性

search-r1:让大模型学会自己使用搜索引擎

通过强化学习让大模型学会使用搜索引擎,自主判断何时搜索、搜什么内容、整理结果

提示词压缩方法总结与开源工具包

对各类提示词压缩方法的总结

LUFFY(路飞): 使用DeepSeek指导Qwen强化学习

在RL过程中加入外部强力模型,让policy在探索的同时也模仿学习

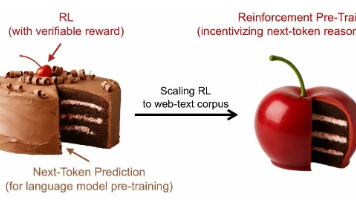

RPT:拿强化学习做 LLM 预训练

结合预训练的规模优势与强化学习的决策优势

LUFFY(路飞): 使用DeepSeek指导Qwen强化学习

在RL过程中加入外部强力模型,让policy在探索的同时也模仿学习

KSOD: 更精细地向LLM中添加特定知识

提出了一种向大模型注入知识的新方法

LLM-as-Judge真的更偏好AI输出?

系统性探究“自我偏好”的真实性,以及相应的优化手段

Qwen团队新发现:大模型推理能力的提高仅由少数高熵 Token 贡献

逻辑分叉、连词是提高推理能力的关键

LUFFY(路飞): 使用DeepSeek指导Qwen强化学习

在RL过程中加入外部强力模型,让policy在探索的同时也模仿学习