简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

深度学习笔记之BERT(四)DistilBERT

本节将介绍一种参数、消耗计算资源少的BERT改进模型——DistilBERT模型。

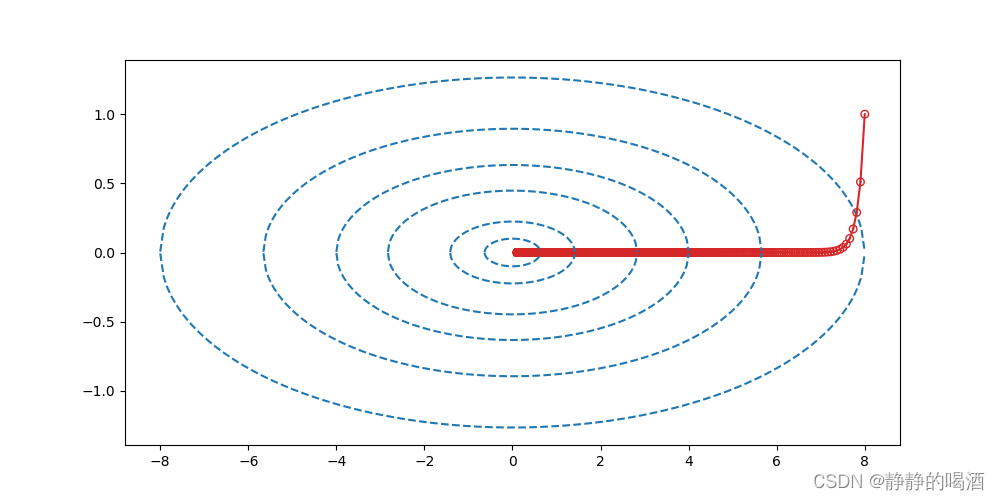

机器学习笔记之优化算法(九)收敛速度的简单认识

本节对收敛速度简单介绍。

机器学习笔记之计算学习理论(二)PAC学习

上一节从霍夫丁不等式为切入点,介绍了样本平均值和全样本期望,本节将继续介绍PAC学习。

深度学习笔记之循环神经网络(四)铺垫:Softmax函数的反向传播过程

上一节介绍了递归神经网络前馈计算过程的基本逻辑,以及作为语言模型时,衡量一个语言模型的优劣性指标——困惑度。本节介绍Softmax函数的反向传播(Backward Propagation,BP)过程。

深度学习笔记之优化算法(五)AdaGrad算法的简单认识

上一节对Nesterov动量法进行了简单认识,本节将介绍AdaGrad方法。

机器学习笔记之线性分类——朴素贝叶斯分类器(Naive Bayes Classifier)

本节将介绍一个经典的基于线性分类的概率生成模型——朴素贝叶斯分类器(Naive Bayes Classifier)。

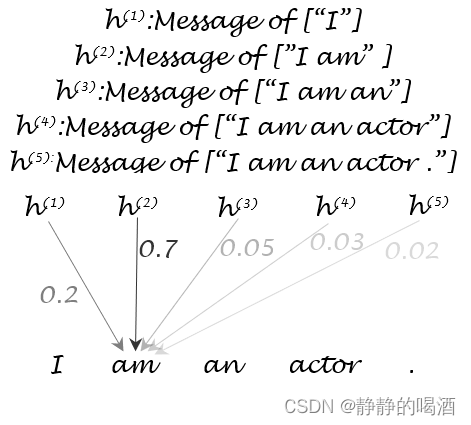

深度学习笔记之Seq2seq(二)基于Seq2seq注意力机制的动机

上一节介绍了Seq2seq网络常用的基本结构以及在机器翻译任务中,关于目标函数与预测概率的描述。本节依然以机器翻译任务为例,对Seq2seq中的注意力机制(Attention)进行描述。

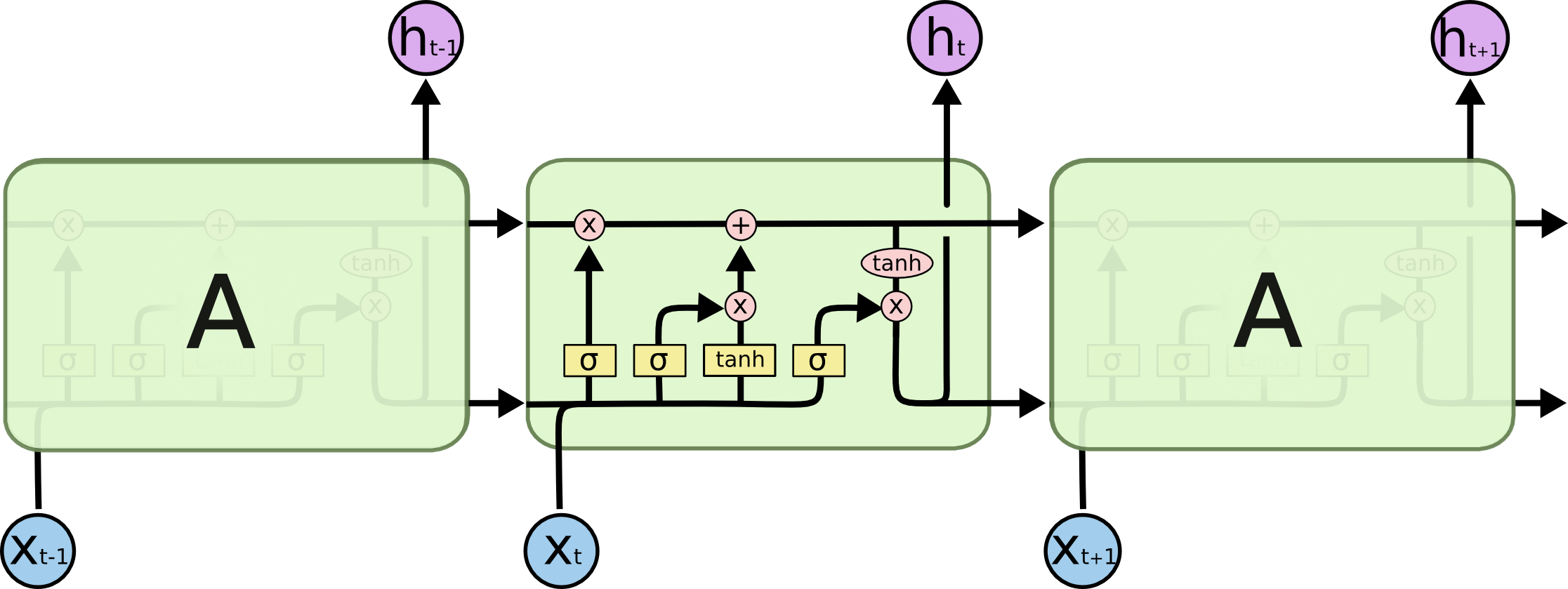

深度学习笔记之循环神经网络(六)长短期记忆神经网络(LSTM)

上一节介绍了循环神经网络(Recurrent Neural Network,RNN)的反向传播过程,本节将针对RNN存在的梯度消失问题,介绍一种新的网络——长短期记忆神经网络(Long-Short Term Memory,LSTM)。

深度学习笔记之循环神经网络(四)铺垫:Softmax函数的反向传播过程

上一节介绍了递归神经网络前馈计算过程的基本逻辑,以及作为语言模型时,衡量一个语言模型的优劣性指标——困惑度。本节介绍Softmax函数的反向传播(Backward Propagation,BP)过程。

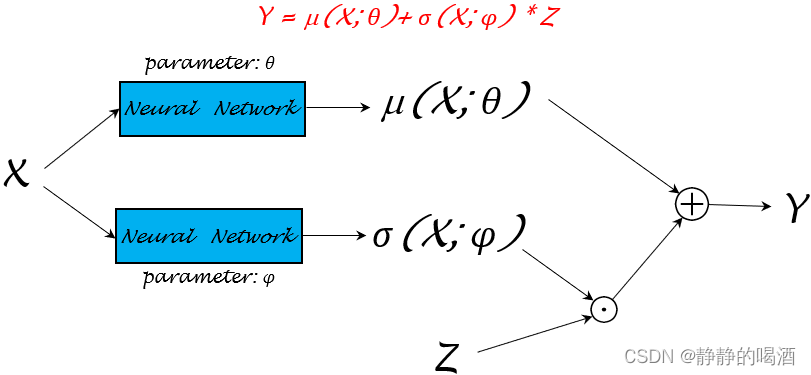

机器学习笔记之生成模型综述(五)重参数化技巧(随机反向传播)

本节将系统介绍重参数化技巧。