简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

一、过拟合1.过拟合现象过拟合(overfitting)是指在模型参数拟合过程中的问题,由于训练数据包含抽样误差,训练时,复杂的模型将抽样误差也考虑在内,将抽样误差也进行了很好的拟合。具体表现就是最终模型在训练集上效果好;在测试集上效果差。模型泛化能力弱。2.过拟合产生的原因?(1)在对模型进行训练时,有可能遇到训练数据不够,即训练数据无法对整个数据的分布进行估计的时候(2)权值学习迭代次数足够多

一、过拟合1.过拟合现象过拟合(overfitting)是指在模型参数拟合过程中的问题,由于训练数据包含抽样误差,训练时,复杂的模型将抽样误差也考虑在内,将抽样误差也进行了很好的拟合。具体表现就是最终模型在训练集上效果好;在测试集上效果差。模型泛化能力弱。2.过拟合产生的原因?(1)在对模型进行训练时,有可能遇到训练数据不够,即训练数据无法对整个数据的分布进行估计的时候(2)权值学习迭代次数足够多

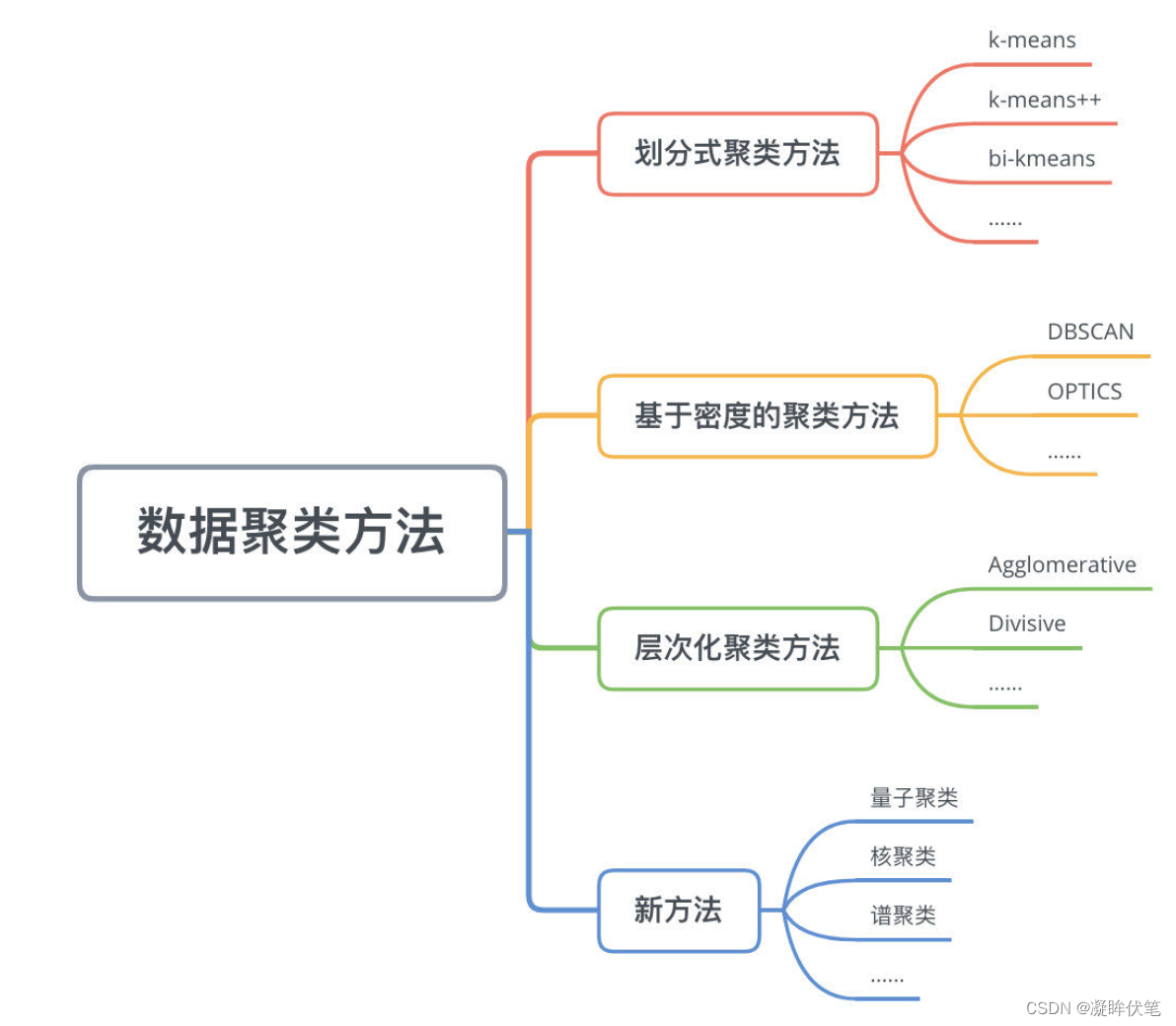

聚类(Clustering)是按照某个特定标准(如距离)把一个数据集分割成不同的类或簇,使得同一个簇内的数据对象的相似性尽可能大,同时不在同一个簇中的数据对象的差异性也尽可能地大。也即聚类后同一类的数据尽可能聚集到一起,不同类数据尽量分离。聚类和分类的区别聚类(Clustering):是指把相似的数据划分到一起,具体划分的时候并不关心这一类的标签,目标就是把相似的数据聚合到一起,聚类是一种无监督学

问题现场:背景:Python3.6,pytorch1.+,使用huggingface.co工具去finetuning bert模型,在多gpu上训练保存模型,在cpu上加载去做预测。加载模型,对同一条数据测试结果不一样。当时检查了:11.模型的状态是否是model.eval()?————不是这个问题2.是否使用torch.no_grad(),这句代码的意思是使得本次过的样本不会更新梯度。————不

当用Spark和Hadoop做大数据应用的时候,你可能会反复的问自己怎么解决这一的一个问题:“Container killed by YARN for exceeding memory limits. 16.9 GB of 16 GB physical memory used. Consider boosting spark.yarn.executor.memoryOverhead”这个错

参考:1.总结的非常好:https://www.cnblogs.com/yh-blog/p/12877922.html2.官方文档模型并行:https://pytorch.apachecn.org/docs/1.2/intermediate/model_parallel_tutorial.html3.数据并行的一个Gitdemo:https://github.com/fnangle/text_cl

转自:https://www.kaggle.com/c/mdd-cup-2018/discussion/639441.关于比赛流程和leaderboard基本是 数据分析、数据清洗、特征工程、模型训练、验证调参与优化 这样一些基本环节,下面再细说。特别说明一下Kaggle 在计算得分的时候,有Public Leaderboard (LB)和 Private LB 之分。具体而言,参赛选...

tokenizer.tokenize() :使用 tokenize() 函数对文本进行 tokenization(分词)之后,返回的分词的 token 词。tokenizer.encoder():encode() 函数对 文本 进行 tokenization 并将 token 用相应的 token id 表示。

依次介绍RankNet,LambdaRank,LambdaMart。1.引言:RankNet 是 2005 年微软提出的一种 Pairwise 的 Learning to Rank 算法,它从概率的角度来解决排序问题。RankNet 的核心是提出了一种概率损失函数来学习 Ranking Function,并应用 Ranking Function 对文档进行排序。这里的 Ranking Fu...

WOE 全拼 Weight of Evidence,即证据权重,用于风险评估、授信评分卡等。i表示第i分段。也可转换后得到.从上公式可知,WOE 实际展现的是 “该分段下的好用户数和坏用户数的比值” 与 “好用户总数与坏用户总数的比值” 的差异。WOE 越大,差异越大,好用户的可能性越大。同时 WOE 变换常应用于特征工程,当我们对某些特征变量进行等频或等距等分箱后发现,发现每级分段 WOE 不满