简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

自动语音识别 (ASR) 是呼叫中心、智能设备工程等领域众多商业应用的基石。ASR 模型(也称为语音转文本 (STT))的核心是智能识别人类语音并将其转换为书面格式。现代ASR 引擎综合运用了多项突破性技术,包括自然语言处理 (NLP)、AI、ML 和 LLM。虽然 ASR 依赖于所有这些技术,但它在根本上与每一项技术都有很大不同。以 NLP 为例,它经常与 ASR 混淆。该技术旨在

2025年2月18日,马斯克旗下公司发布Grok3模型。号称性能全面碾压DeekSeek在线试用地址:模型HF下载地址:https://huggingface.co/IntelligentEstate/Baby_Grok3-1.5b-iQ4_K_M-GGUF这是 Grok-3 风格小型模型的应用程序,具有多种工具用途,适用于边缘设备。具有多轮功能调用的低资源前沿模型。这个小宝贝不仅具有推理和工具用

鲁棒性:SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED。可接受的预处理器:SoftEdge_PIDI、SoftEdge_PIDI_safe、SoftEdge_HED、SoftEdge_HED_safe。软边缘顾名思义,检测的边缘会显得稍微柔和些。训练数据:SoftEdge_PIDI、SoftEdge_PI

人工智能的快速有望重塑各行各业,重新定义工作角色,并从根本上改变全球经济那些曾经被认为不受自动化影响的白领职业——法律、会计、市场营销、金融、设计、保险、人力资源,甚至软件工程。然而,社会保障框架仍然过时,无力应对这种颠覆性变革。工人、他们的家庭以及整个社区都站在经济悬崖的边缘,容易受到人工智能突然导致的失业的影响。政策制定者必须立即着手实现社会保障的现代化,而不是等到大规模裁员发生后才仓促应对。

TNT-LLM是微软为Bing Copilot开发的一种分类系统,旨在从对话日志中生成可解释的用户意图分类体系,并利用该体系进行日志标注和分类器训练。该系统特别适用于处理大规模对话数据,支持用户行为分析和模型优化等下游任务。TNT-LLM在LangGraph中实现为一个多步骤工作流,利用状态图协调多个LLM调用和数据处理步骤。其核心

在StableDiffusion中用Script中的XYZ功能测试大批量生成的图片时,出现这个错误。看字面意思是最终的Grid太大了。超过了配置中的200MPixels。其实我只需要测试3种Sampler即可。这样X和Y的综合少了很多。这个配置在SD的config.json文件中。或者,减去一些Sampler的选择项目。Y 我选中了很多Sampler。可以自行修改大一些,问题解决。结果运行生成出现

之前我们其实在对比分析所有的Ollama框架中使用的各种大模型的能力时,有简单用过Deepseek-r1 的模型。考虑到v3版本的能力貌似更强大,我们来进行下对比。DeepSeek-v3 的 Github地址:https://github.com/deepseek-ai/DeepSeek-V3个人技术博客:更多技术资讯下载:相关配图由微信小程序【字形绘梦】免费生成我们基础框架还是ollama+we

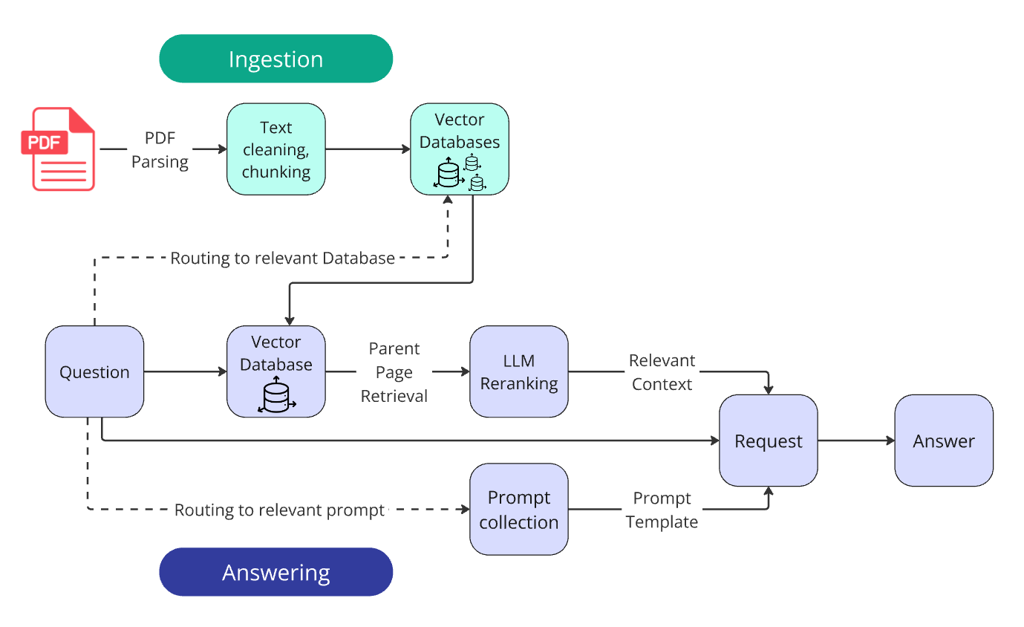

任务是创建一个基于公司年报的问答系统。每个答案都必须包含包含答案证据的页面的引用,以确保系统真正得出答案而不是产生幻觉。

截至2025年5月13日,AIChatBot的可靠性和幻觉问题仍是人工智能领域的核心挑战。幻觉指AI生成虚假或无意义信息并将其呈现为真实,这一问题在大语言模型(LLMs)中尤为突出,显著影响其应用价值。最新研究表明,尽管技术进步,幻觉问题在某些新型推理模型中反而加剧。例如,OpenAI的o3和o4-mini模型在简单事实性问题测试中的幻觉率分别高达51%和79%。幻觉的根源包括训练数据问题、模型固

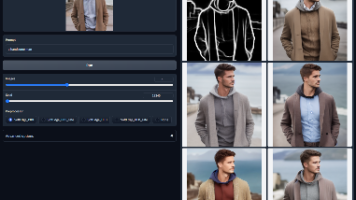

通过随笔简单的勾勒出来一个轮廓图形,类似和边缘检测形成得到的物件轮廓图,再用RA/SD填充颜色和内容,形成实体图。Scribble 涂鸦,也可称作 Sketch 草图,同样是一款手绘效果的控图类型,但它检测生成的预处理图更像是蜡笔涂鸦的线稿,在控图效果上更加自由。可接受的预处理器:合成的涂鸦(Scribble_HED、Scribble_PIDI 等)或手绘的涂鸦。这里,随便画了山和河流,后侧还是试