简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章摘要 本文解析了AI对话接口的入参和响应设计,以通义千问(QW)和DeepSeek(DS)为例。核心参数包括session_id和parent_msg_id,用于标识对话链路和消息顺序。两者在参数获取流程和设计理念上存在差异:QW采用冗余设计确保数据独立性,而DS追求极简传输效率。响应方面,QW采用全量快照式结构,DS则为增量补丁式。文章还对比了Header设计的认证机制和流式传输实现,最后提

摘要: 随着大语言模型(LLM)能力的提升,提示词工程从传统的结构化“引导型”向简洁的“目标驱动型”转变。传统提示词依赖角色、任务等六要素描述,而目标驱动型只需提供必要信息和清晰目标(如任务背景+核心要求),即可激发模型的创造力。实验表明,简化后的提示词在生成小红书文案等任务中效果更佳,甚至超预期满足需求。但需注意任务边界的精准定义(如禁用词、合规要求),以平衡简洁性与约束力。目标驱动提示词的核心

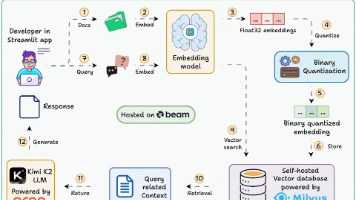

本文探讨了在大规模RAG系统中使用二进制量化技术提升效率的方法。面对海量文档处理时标准向量检索的内存消耗问题,二进制量化通过将浮点向量转换为1位二进制码,实现32倍内存压缩和毫秒级响应。尽管牺牲了部分精度,但高维向量的整体语义模式仍保持有效,配合高效的汉明距离计算,能显著提升检索速度。文章详细介绍了技术原理、优势权衡及实践应用方案,证明该技术是处理千万级以上数据的高性价比选择,体现了"以

本文介绍了优化大型语言模型(LLM)Prompt token的实用策略。主要内容包括:精简Prompt内容(清晰指令、限制示例、结构化输出);管理上下文窗口(截断、输入输出平衡、内容总结);高级技术(RAG检索增强、思维骨架提示、批处理);API参数微调(最大长度、停止序列等)。还提出落地应用建议:自适应RAG系统、任务分解让LLM专注自然语言处理部分,结合传统API提高效率。这些方法可在保证输出

本文摘要: 文章深入探讨了RAG(检索增强生成)中的文本分块技术及其重要性。首先解释了RAG的核心思想是将LLM转变为“开卷考试”模式,通过检索相关资料来回答问题。然后重点分析了文本分块的必要性,包括LLM上下文窗口限制、提高检索精度和降低噪声等因素。文章提出了分块大小的权衡标准,建议采用小块+重叠的方式平衡信息完整性与检索效率。通过评估召回率和精确率来判断分块质量,并给出了具体测试方法。最后介绍

摘要 本文介绍了LangChain中文本转向量存储的关键步骤,主要包含两部分:嵌入模型(Embeddings)和向量数据库(Vector Stores)。嵌入模型(如HuggingFaceEmbeddings)将文本转换为语义向量,向量数据库(如Chroma)则高效存储和检索这些向量。文章通过代码示例展示了如何使用RecursiveCharacterTextSplitter分割文本、Hugging

摘要 啾啾的博客分享了RAG开发中向量数据库的存储环节。向量数据库(如ChromaDB、FAISS)专为高效存储和查询高维向量设计,擅长语义查找,支持通过模糊语义(如"找一本Java内存管理的书")检索,而无需精确匹配。其核心数据结构包括向量、元数据(灵活JSON格式)和ANN索引,采用分层存储策略优化性能。集合(Collection)是主要操作单位,可分区管理,支持增删改查操

摘要:Prompt工程基础与实践指南 本文系统介绍了Prompt(提示词)的核心概念与应用方法。首先阐述了优质Prompt的标准:输出符合预期、能提升AI准确性并节省沟通成本。文章从人类视角分解Prompt构成要素(角色、任务、上下文等),并解释LLM如何将Prompt转换为token序列进行预测。 在实践层面,提出了三种处理用户输入的方案:规则解析、LLM预处理和结构化UI设计(主流做法)。重点

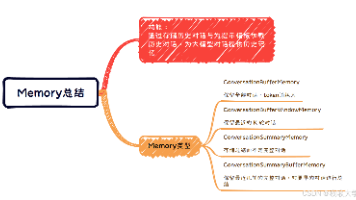

摘要 本文介绍了LangChain中的Memory组件功能及其在多轮对话中的应用。Memory通过存储和加载历史对话内容,使大模型能够保持上下文连贯性。文章重点演示了两种基础Memory类型: ConversationBufferMemory - 完整记录所有历史对话,适用于需要完整上下文的场景。代码示例展示了如何初始化内存、创建对话链并进行多轮对话测试。 ConversationBufferWi

本文分享LLM应用开发的学习路线与资源汇总,包含Python基础、LLM核心技术(RAG/Agent)的进阶路径。作者在GitHub开源了系统化学习资料库(https://github.com/tataCrayon/LLM-DEV-COOKBOOK),提供从入门到实践的完整教程与代码Demo。内容涵盖核心知识图谱、学习框架图及分阶段教程索引,适合开发者快速掌握大语言模型应用开发的关键技能。欢迎交流