简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本周学习了三种不同的自注意力机制,Local Attention 专注于输入序列的一个局部窗口,使得模型在处理一个特定元素时,只关注其附近的其他元素。相对地,Global Attention 考虑输入序列的全部元素,为每个元素分配不同的权重。Stride Attention 则是介于两者之间,它按照一定的步长(stride)选择性地关注输入序列的元素,从而在保证模型性能的同时,降低了计算复杂性。聚

卷积神经网络(CNN)是一种馈前神经网络,其采用卷积、池化和全连接等结构,在图像分类、目标检测、语义分割等视觉任务上有着广泛应用。CNN主要由卷积层、池化层和全连接层组成。卷积层使用卷积核对输入进行卷积运算,可以自动学习输入的空间特征。池化层对卷积层输出进行下采样,用于降维和提取主要特征。全连接层用于分类或回归任务。CNN全称是卷积神经网络(Convolutional Neural Network

本文研究了物理信息神经网络(PINNs)在求解二维浅水方程(SWES)自由表面流问题中的应用。开发和分析了两种类型的PINN:物理信息全连接神经网络(PIFCN)和物理信息卷积神经网络(PICN)。PINN通过采用SWE、初始和边界条件作为要最小化的损失函数的分量,消除了对用于训练的标记数据的需要。来自一组理想化和真实世界测试的结果表明,预测精度和计算时间(即,当与通过有限体积(FV)模型的解决方

本周我阅读的文献《Next Item Recommendation with Self-Attentive Metric Learning》中,提出了一种新的序列感知推荐模型,通过自注意力机制,能够估计用户交互轨迹中每个item的相对权重,以更好地表示用户的瞬时兴趣。论文最主要的核心点是提出结合度量学习和Self-Attention的方法来解决序列推荐问题,以及显式地控制了长短期兴趣对模型的影响。

自注意力(Self-attention)是一种在深度学习领域的关键技术,其目的在于捕捉序列数据中的长距离依赖关系。自注意力通过计算序列元素间的相互关联,使模型能够关注与当前元素相关的其他元素。主要实现方式包括:将输入序列映射到查询(Query)、键(Key)和值(Value)空间;计算注意力权重;对值进行加权求和;输出序列。自注意力在自然语言处理和计算机视觉等领域有广泛应用。computing;a

本周我阅读了一篇题为《Convolutional LSTM Network: A Machine Learning Approach for Precipitation Nowcasting》的文献。该文献主要介绍了ConvLSTM结构,并将其应用于降水预测,取得了令人满意的结果。随后,我手动推导了一遍RNN的前向传播过程,以便更好地理解RNN的计算过程,并弄清了其中参数维度的变化。此外,我还学习

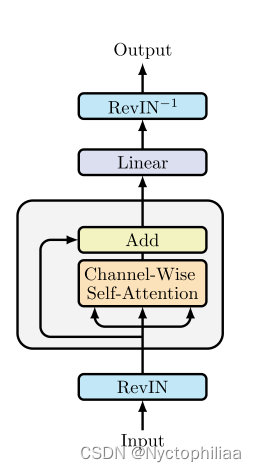

本周我阅读了一篇题目为《Unlocking the Potential of Transformers in Time Series Forecasting with Sharpness-Aware Minimization and Channel-Wise Attention》的文献,该文献引入了一种浅层、轻量级的Transformer模型(SAMformer),该模型采用锐度感知优化技术。

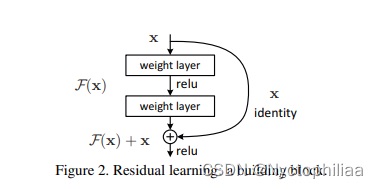

本周我阅读了一篇题目为Deep Residual Learning for Image Recognition的文献,文章的贡献是作者提出了残差网络的思想,且证明了更深层的残差网络具有比VGG网络更低的复杂度和更高的准确性,同时,残差网络实现了更容易的训练过程。其次,对PINN进行了继续的学习,PINN 是一种科学机器在传统数值领域的应用方法,特别是用于解决与偏微分方程相关的各种问题,包括方程求解