简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

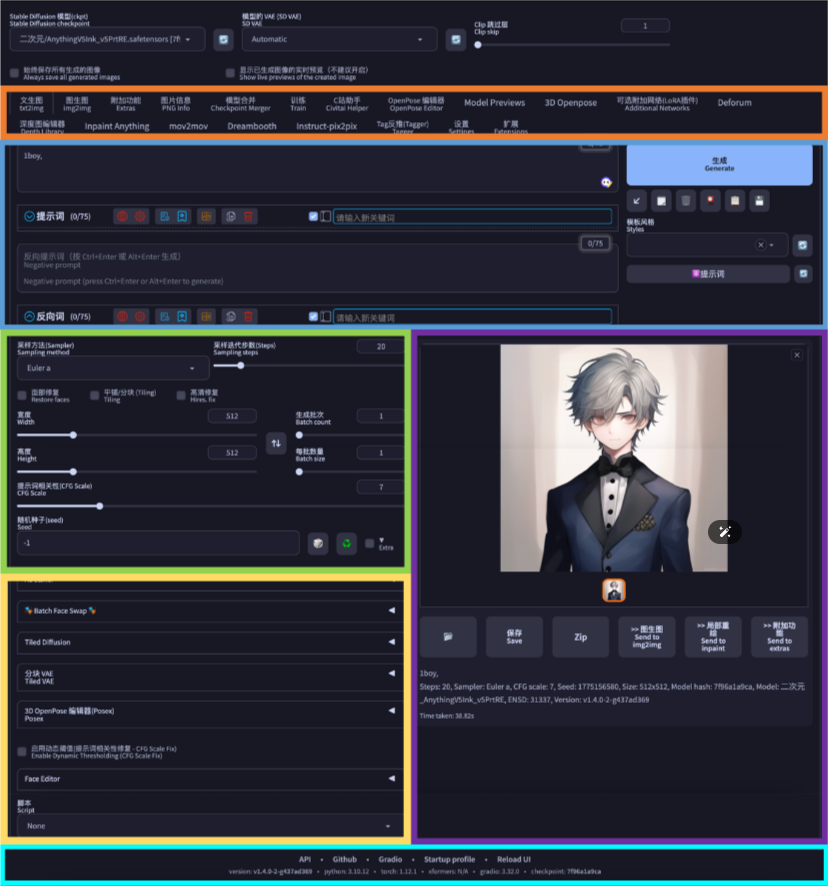

帮助用户快速掌握Stable Diffusion WebUI的基础操作,为后续AI绘图创作打下基础。

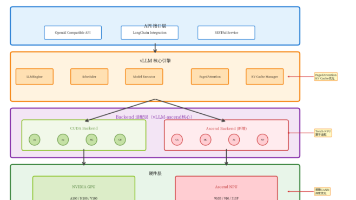

华为UB灵衢总线构建的超节点架构突破传统服务器资源边界,实现多节点资源池化与统一通信

随着云原生体系不断演进,算力形态正从传统 CPU 主导逐渐迈向 GPU、NPU、AI 加速器、FPGA、DPU/IPU 等多种计算单元协同发展的异构格局。在这种环境下,不同硬件在驱动模型、加速框架、容器化支持和调度方式上存在显著差异,使得应用迁移、资源管理和运维复杂性急剧增加。在多样化算力高速增长、AI 工作负载愈发主导的趋势下,openFuyao 提出了清晰的技术目标:构建一个屏蔽硬件差异、统一

vLLM-ascend是昇腾NPU适配的高性能大模型推理框架,通过PagedAttention和Continuous Batching两大核心技术实现显著性能提升。PagedAttention借鉴操作系统内存管理,将KV Cache分块存储,内存利用率提升至89%;Continuous Batching实现动态请求调度,GPU利用率达92%。vLLM-ascend通过后端适配层实现CUDA到NPU

本文提出CangPkg智能包管理器构想,旨在为仓颉语言打造集高效依赖管理、智能冲突解决和安全审查于一体的生态系统。通过分布式缓存、并行安装和AI版本推荐实现快速构建,内置安全引擎进行漏洞扫描和签名验证,深度集成编译器优化性能。原型验证显示其可自动解决依赖冲突,理论构建时间减少60%,缓存复用率达65%,为开发者提供更安全高效的开发体验。

在如今数字化时代,搜索引擎是企业获取流量和用户洞察的重要工具。无论是SEO平台还是其它相关行业,精准掌握关键词排名、竞争对手动向和AI搜索结果,都是业务决策的重要依据。然而,跨区域、跨设备、跨引擎的搜索结果采集并非易事跨区域 or 跨设备:同一个关键词在不同地区或不同设备(移动端/桌面端)上排名可能差别巨大。如手动查询不仅效率地下,还非常容易出错支持爬取Google、bing等热门引擎传统爬虫在高

vLLM-ascend是昇腾NPU适配的高性能大模型推理框架,通过PagedAttention和Continuous Batching两大核心技术实现显著性能提升。PagedAttention借鉴操作系统内存管理,将KV Cache分块存储,内存利用率提升至89%;Continuous Batching实现动态请求调度,GPU利用率达92%。vLLM-ascend通过后端适配层实现CUDA到NPU

昇腾平台以其完善的软件栈和高效的并行算子执行能力,为 vLLM 提供了新的运行后端。综合来看,vLLM 的轻量架构与昇腾平台的高性能算力是非常契合的一对组合 前者解决了推理内存瓶颈,后者在硬件层面提供了高吞吐支撑,两者结合能在。其中 VLLM_USE_ASCEND=1 用于显式启用昇腾推理模式,确保 vLLM 在加载模型时调用对应的算子库。以下数据来自昇腾社区公开测试结果,对比了 vLLM 在不同

它从底层 UB CNI/CSI、Node Controller、调度器增强,到上层 Service Mesh、分布式缓存 / 消息 / 文件系统的灵衢化,再到不依赖硬件的 UB 开发者工具链,形成了完整的。openFuyao 最终让灵衢超节点从 “硬件底座” 升级为 “云原生就绪的超级计算单元”,为 AI 大模型、高性能计算等算力密集型场景提供了标准化、高性能、低门槛的云原生解决方案。但超节点硬件

随着云原生体系不断演进,算力形态正从传统 CPU 主导逐渐迈向 GPU、NPU、AI 加速器、FPGA、DPU/IPU 等多种计算单元协同发展的异构格局。在这种环境下,不同硬件在驱动模型、加速框架、容器化支持和调度方式上存在显著差异,使得应用迁移、资源管理和运维复杂性急剧增加。在多样化算力高速增长、AI 工作负载愈发主导的趋势下,openFuyao 提出了清晰的技术目标:构建一个屏蔽硬件差异、统一