简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

CLIP(对比语言-图像预训练)是OpenAI提出的多模态模型,通过4亿图文对进行对比学习训练。该模型采用双流架构,分别处理图像和文本数据,在嵌入空间进行语义对齐。核心是对比学习策略,通过比较正负样本优化特征表示。训练完成后,CLIP可转换为零样本分类器,将类别名称嵌入并与图像特征匹配实现分类。该模型在零样本学习和图像搜索等任务中表现优异,能有效识别新类别并实现图文跨模态检索。

1. Vision Transformer(ViT)是一种基于Transformer架构的深度学习模型,它将Transformer模型从自然语言处理(NLP)领域成功扩展到计算机视觉(CV)领域。2. Vision Transformer由Google Brain团队在2020年提出,该模型挑战了卷积神经网络(CNN)在视觉任务中的主导地位,证明了Transformer架构不仅在处理序列数据(如文

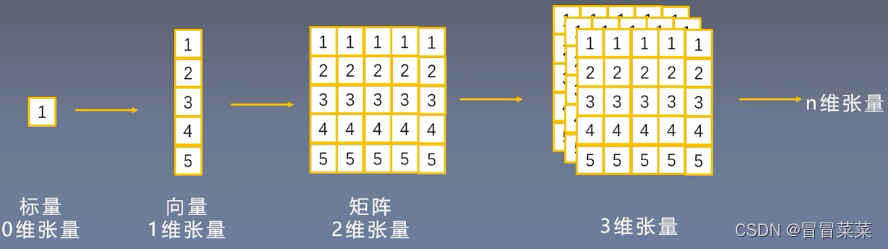

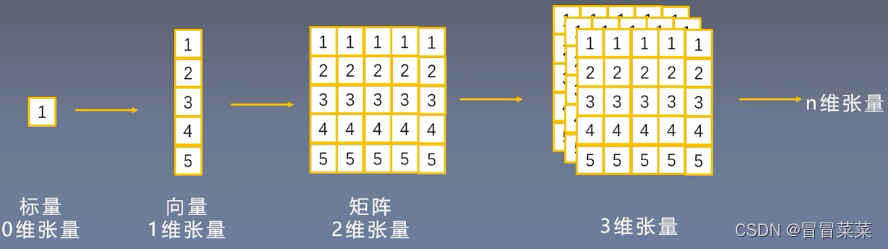

1. 张量是一个多维数组,它是标量、向量、矩阵的高维拓展。2. 在张量的定义中,方括号用于表示张量的形状。例如,定义了一个2x3的二维张量,其中方括号 [[…], […]] 表示该张量有2行3列。例如,定义了一个2x2x3的三维张量,其中方括号 [[[…, …], […, …]], [[…, …], […, …]]] 表示该张量有2个2x3的矩阵。3. PyTorch中的张量(Tensor)和数组

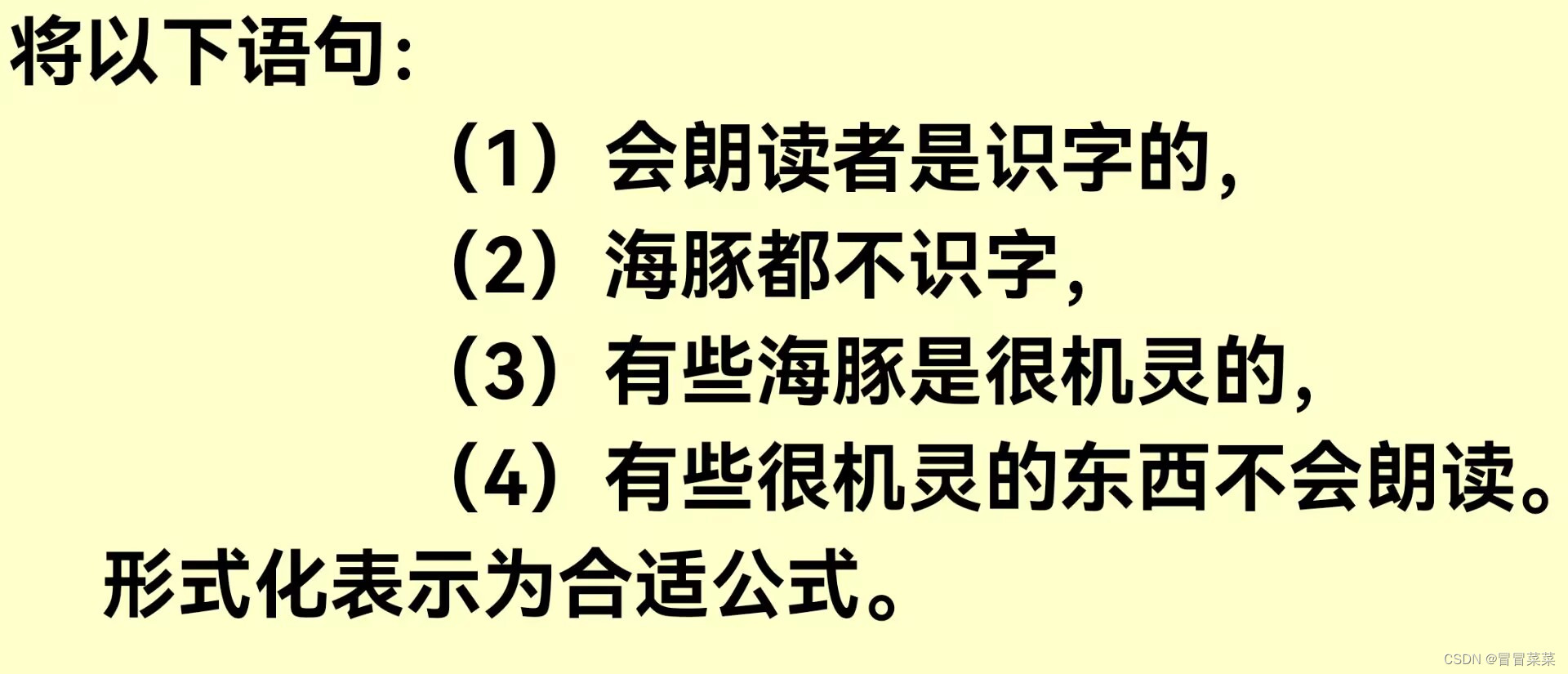

包含了知识表示这一章的一些习题。

(5)DBMS接到回答信号后,将缓冲区的数据经过模式映射,变成用户的逻辑记录送到用户工作区,同时给用户回答成功与否的信息。对于DBMS的要求除上述外,用户在不同环境还要更多的要求,例如:①对分布式应用的支持。④数据的组织和存取。它主要功能是建立和维护数据库,接受和完成用户访问数据库的各种请求。一般来说主要由数据库定义,数据库存取,数据库运行处理,数据库组织、存储和管理,数据库建立、维护和其他主要模

1. 张量是一个多维数组,它是标量、向量、矩阵的高维拓展。2. 在张量的定义中,方括号用于表示张量的形状。例如,定义了一个2x3的二维张量,其中方括号 [[…], […]] 表示该张量有2行3列。例如,定义了一个2x2x3的三维张量,其中方括号 [[[…, …], […, …]], [[…, …], […, …]]] 表示该张量有2个2x3的矩阵。3. PyTorch中的张量(Tensor)和数组

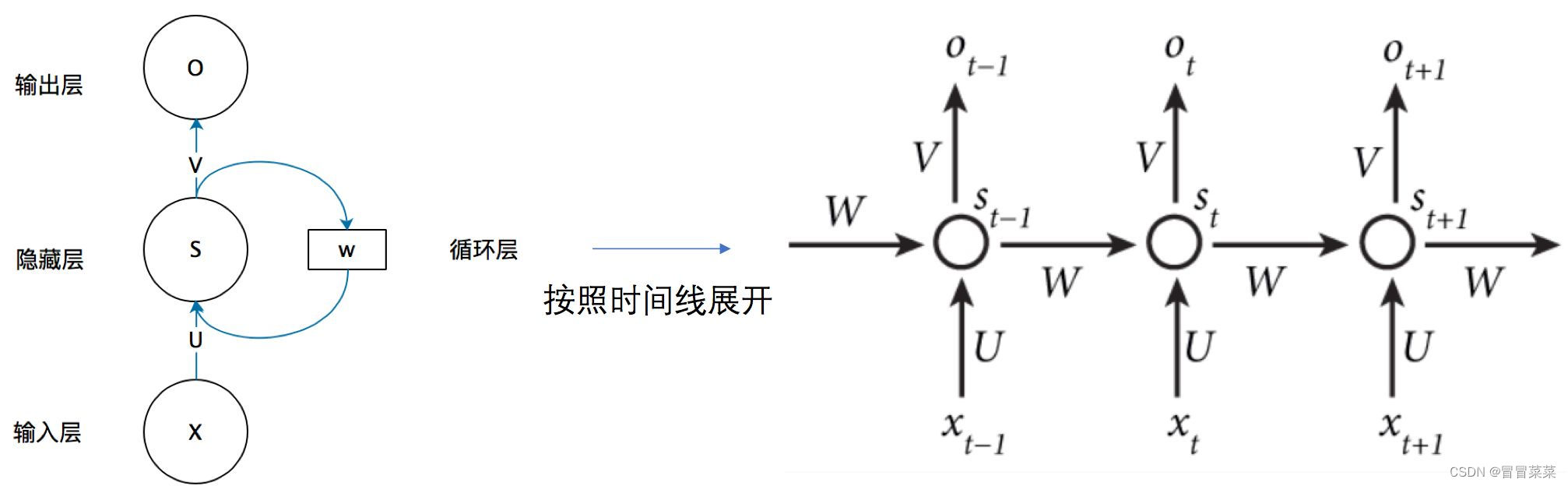

循环神经网络(Recurrent neural networks,简称RNN)是针对序列数据而生的神经网络结构,核心在于循环使用网络层参数,避免时间步增大带来的参数激增,并引入隐藏状态(Hidden State)用于记录历史信息,有效的处理数据的前后关联性。考虑这样一个问题,如果要预测句子的下一个单词是什么,一般需要用到当前单词以及前面的单词,因为句子中前后单词并不是独立的。比如,当前单词是“很”

1. 我们有两种方式使用我们的xgboost库。第一种方式是直接使用xgboost库自己的建模流程:2. 其中最核心的,是DMtarix()这个读取数据的类,以及train()这个用于训练的类。与sklearn把所有的参数都写在类中的方式不同,xgboost库中必须先使用字典设定参数集,再使用train()来将参数集输入,然后进行训练。会这样设计的原因,是因为XGB所涉及到的参数实在太多,全部写在

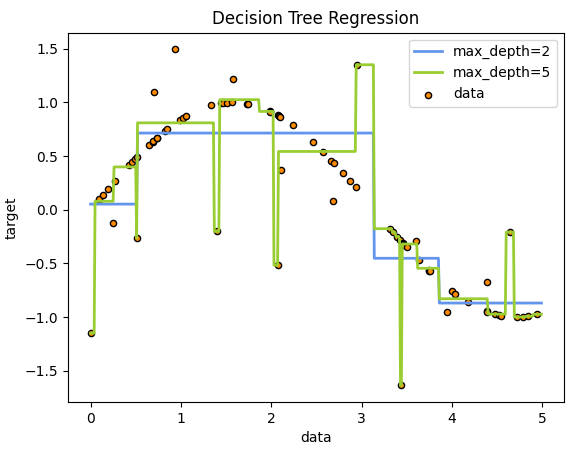

1. 回归树通过将输入空间划分为多个矩形区域,并在每个区域内拟合一个简单的线性模型来建立预测模型。选择一个特征和一个切分点,将数据集划分为两个子集。对于每个子集,计算目标变量的均值作为预测值。选择最佳的特征和切分点,使得划分后的子集的预测值与真实值之间的误差最小化。重复以上步骤,直到达到预定的停止条件。

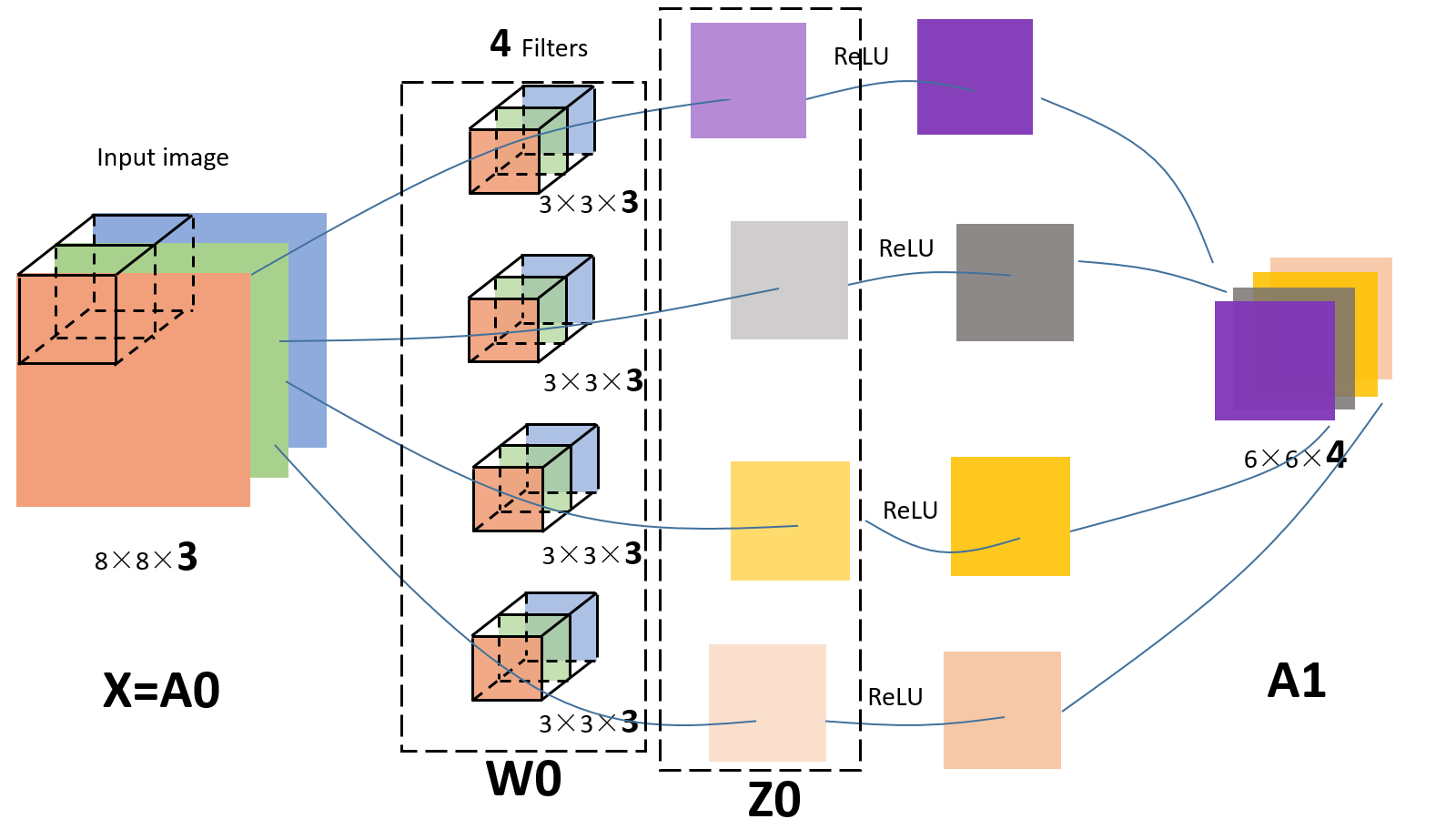

本篇文章讲述了深度学习的必备基础:卷积神经网络。包含CNN的发展史、卷积层和池化层操作。