简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

理解一下这个loss到底是什么,根据查阅相关资料和程序分析,这个loss应该是这个批次,即这64个十维向量输出的所有概率损失求平均或者求和得到的,根据球的的这个损失使用后续的优化算法找到使其梯度下降的最快的方向,这里这个梯度的求取是矩阵梯度的运算,这个在高等数学和线性代数中并没有深入了解过,但可以类比一下微积分里梯度的概念,只不过微积分是连续的函数,矩阵是离散的数据,这样的数据也是可以求取梯度的。

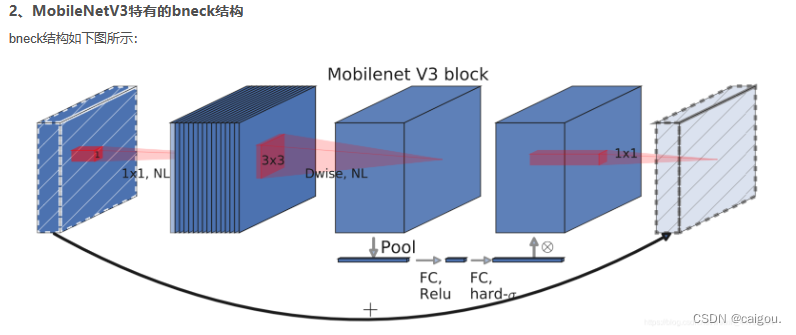

提取用于DW卷积的池化后一维向量,两个fc全连接层,第一个全连接把和特征图通道数一样长度的一维向量缩短为1/4,之后第二个全连接把通道数还原回原来的长度,经过训练的一维向量每个位置的值就是经过DW卷积后的特征矩阵的每一层的权重,把这个每一层的权重和每个通道上的数值相乘。1、MobileNetV1的深度可分离卷积DW(depthwise separable convolutions)。减少第一层卷积

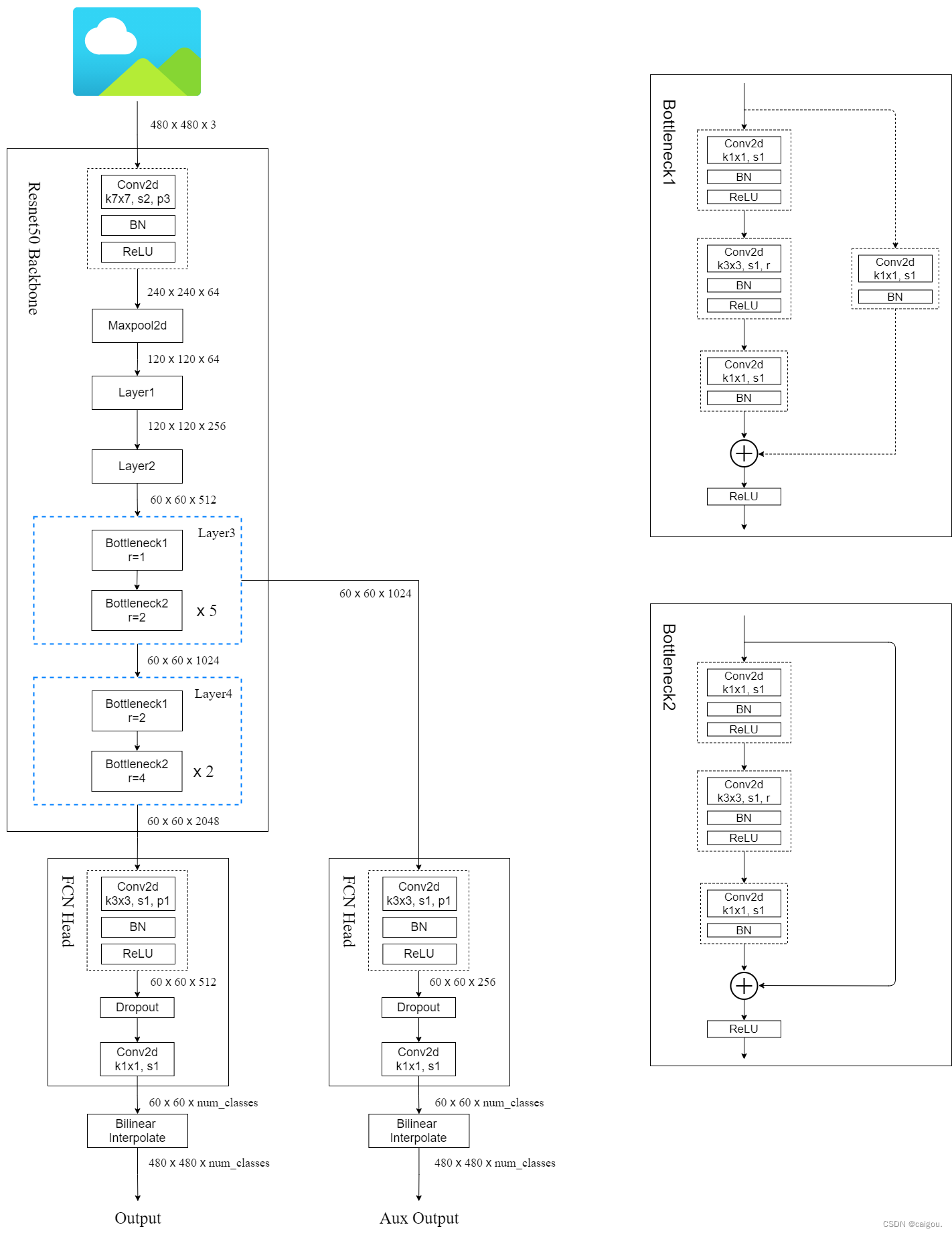

【代码】FCN(pytorch)

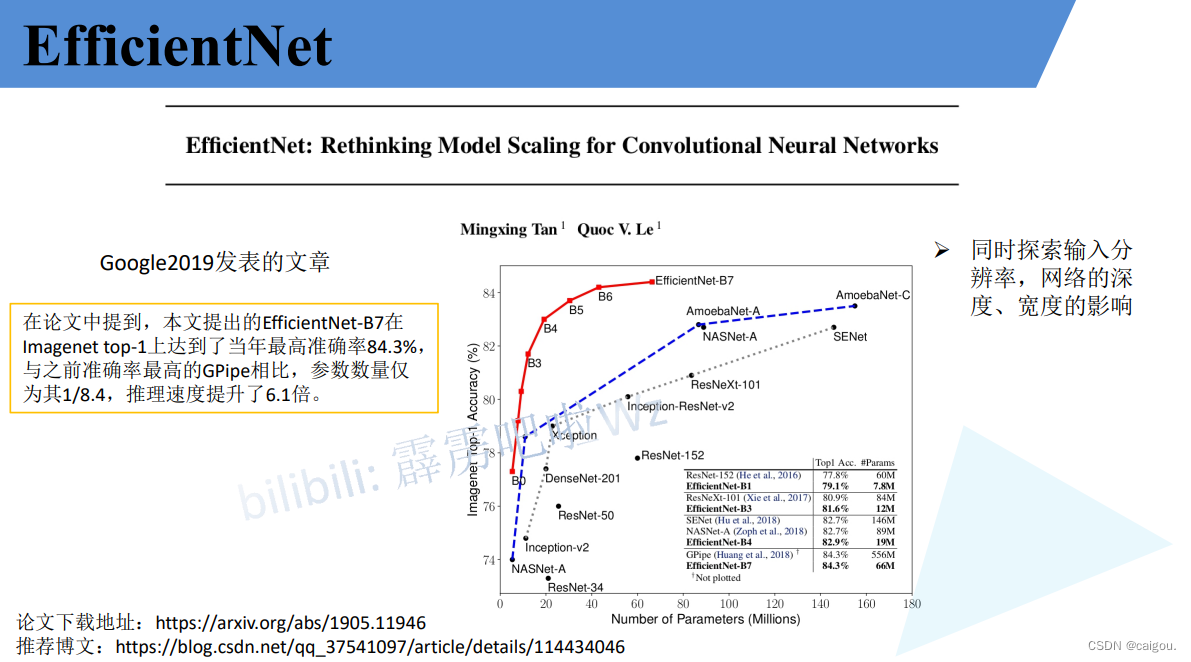

读模型代码我喜欢从最下面的 def efficientnet_b2(num_classes=1000):模型定义时候开始看,从传参调用一个一个去看模型的整个结构,包括所有MBConv模块参数的构建,所有层的构建,小模块的构建等等细节。这个和MobileNetV3有些不同,第一层全连接长度不是升维后的3*3DW卷积维度的1/4,二是PW升维前的输入通道的1/4。之前的研究探索的是单个因改变的影响,这

比如先更新NVIDIA显卡驱动,创建虚拟环境,安装一个cuda版本的putorch的国内安装方法,先装轮子文件,再使用pip再Anoconda Prompt控制台下使用特定语句安装,新版pycharm配置anoconda的python环境在环境目录下找不到解释器的问题,等等。查看已经安装的包,进入相关环境,conda list,可以查看到pytorch三个包版本以及是不是cuda版,以及哪个cud