简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

区块链技术的学习总结

参与节点需要通过解决一定难度的数学问题来证明自己在网络中的工作量,并获得记账权。这个过程需要大量的计算能力和电力消耗。3. 权益证明(Proof of Authority,PoA):PoA是一种基于授权的共识机制。区块链技术的共识机制是指在区块链网络中,参与节点之间如何达成共识并确认交易的有效性和顺序的一种机制。由于区块链是去中心化的,没有中央机构来验证和确认交易,因此需要一种共识机制来确保网络的

八股总结----数据库(MySQL和Redis)

1.MySQL部分2.Redis部分

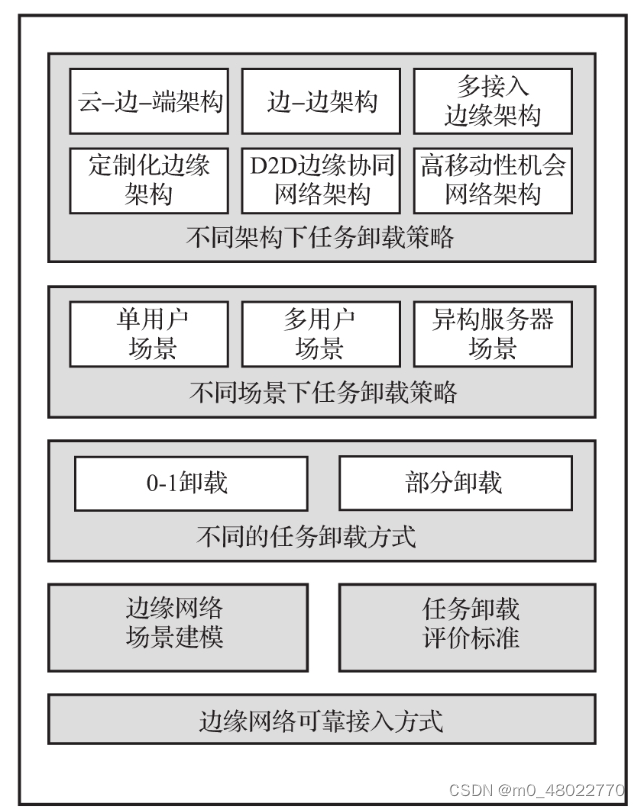

边缘计算----计算卸载

任务上传是指利用无线传输技术通过移动接入点把任务卸载至边缘服务器(这个边缘服务器往往是部署于移动蜂窝网的接入基站附近,也就是说不是固定的),任务上传要选择合适的通信技术。结果返回是在边缘服务器处理后,把处理结果通过接入节点返回至用户终端,一般返回数据远远小于上传数据(因为上传的是整个终端收集到的数据,而返回的只需要是个指令就可以),而且返回结果可能也不是同一个节点(因为终端是可以移动的,边缘服务器

到底了