简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

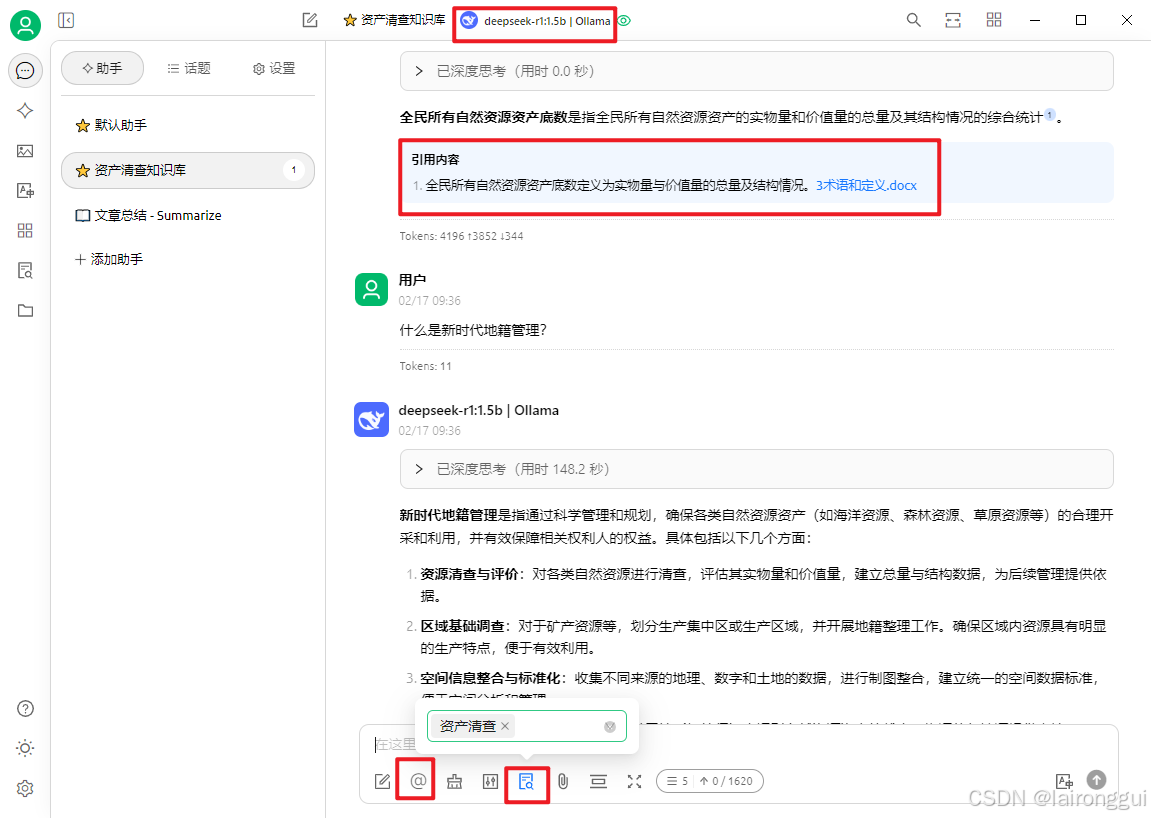

在Ollama的基础上,安装Cherry Studio搭建本地知识库

安装Cherry Studio搭建本地知识库

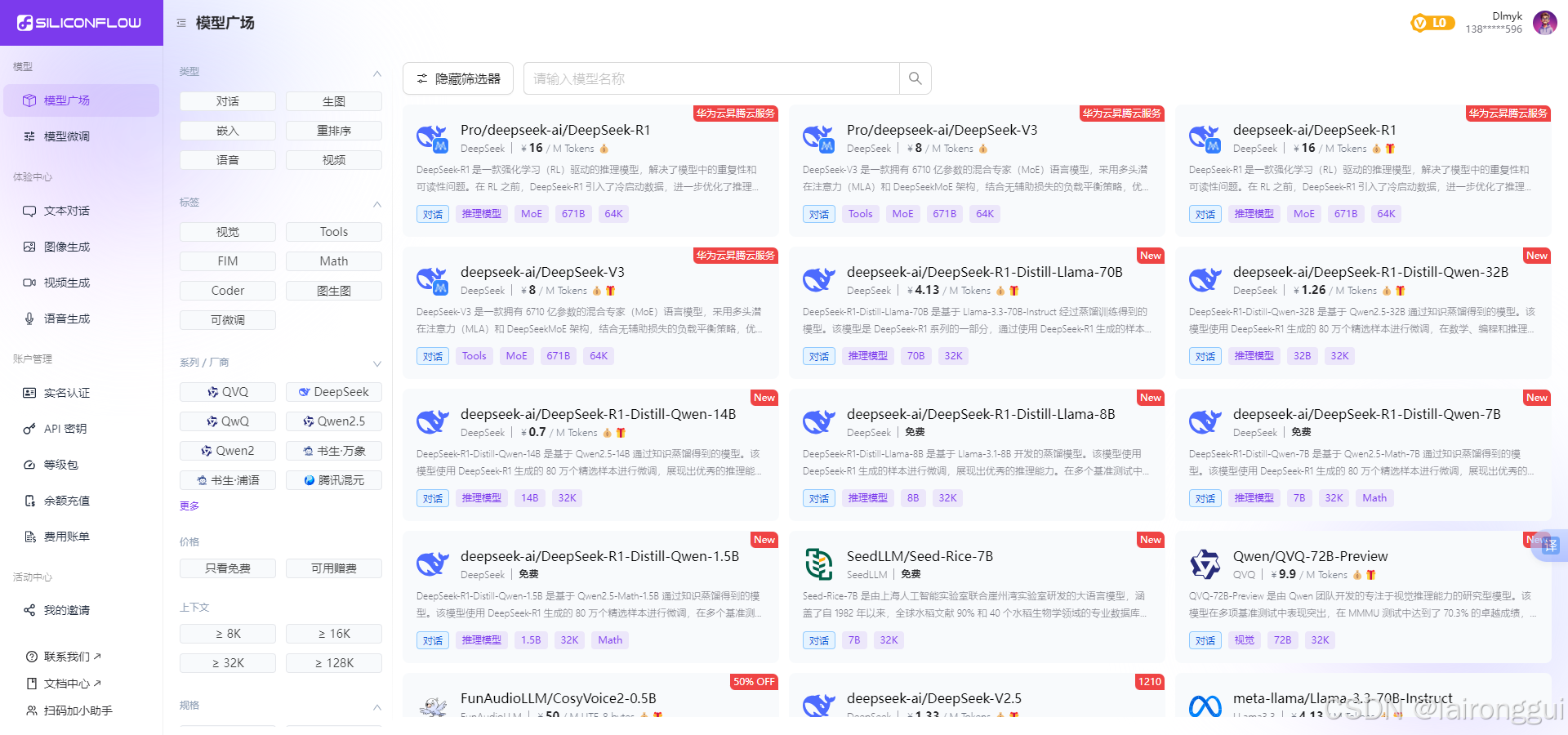

Python调用硅基流动(siliconflow)上的模型

前面的文章提到了调用本地部署好的ollama的API,这里试一下调用硅基流动上的API试试看效果。

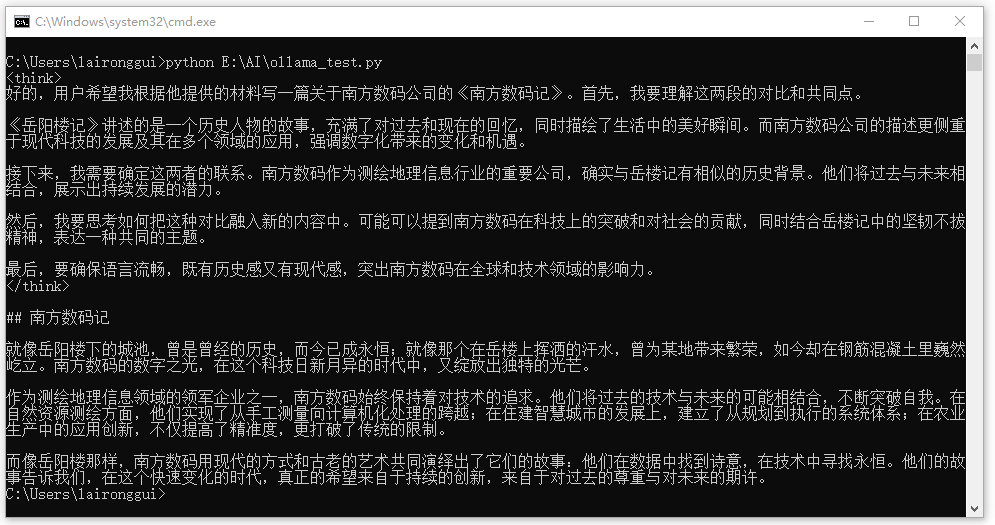

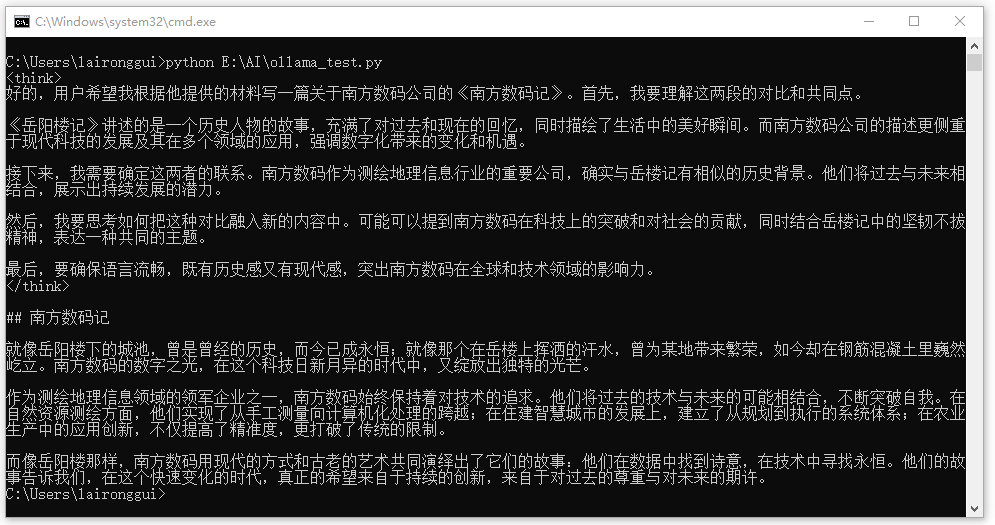

调用本地部署好的ollama的API—stream:True流式返回

调用本地部署好的ollama的API—stream:True流式返回

Ollama本地化部署

本地化部署ollama,加载特定模型。

调用本地部署好的ollama的API—stream:False 非流式返回

ollama本地api调用

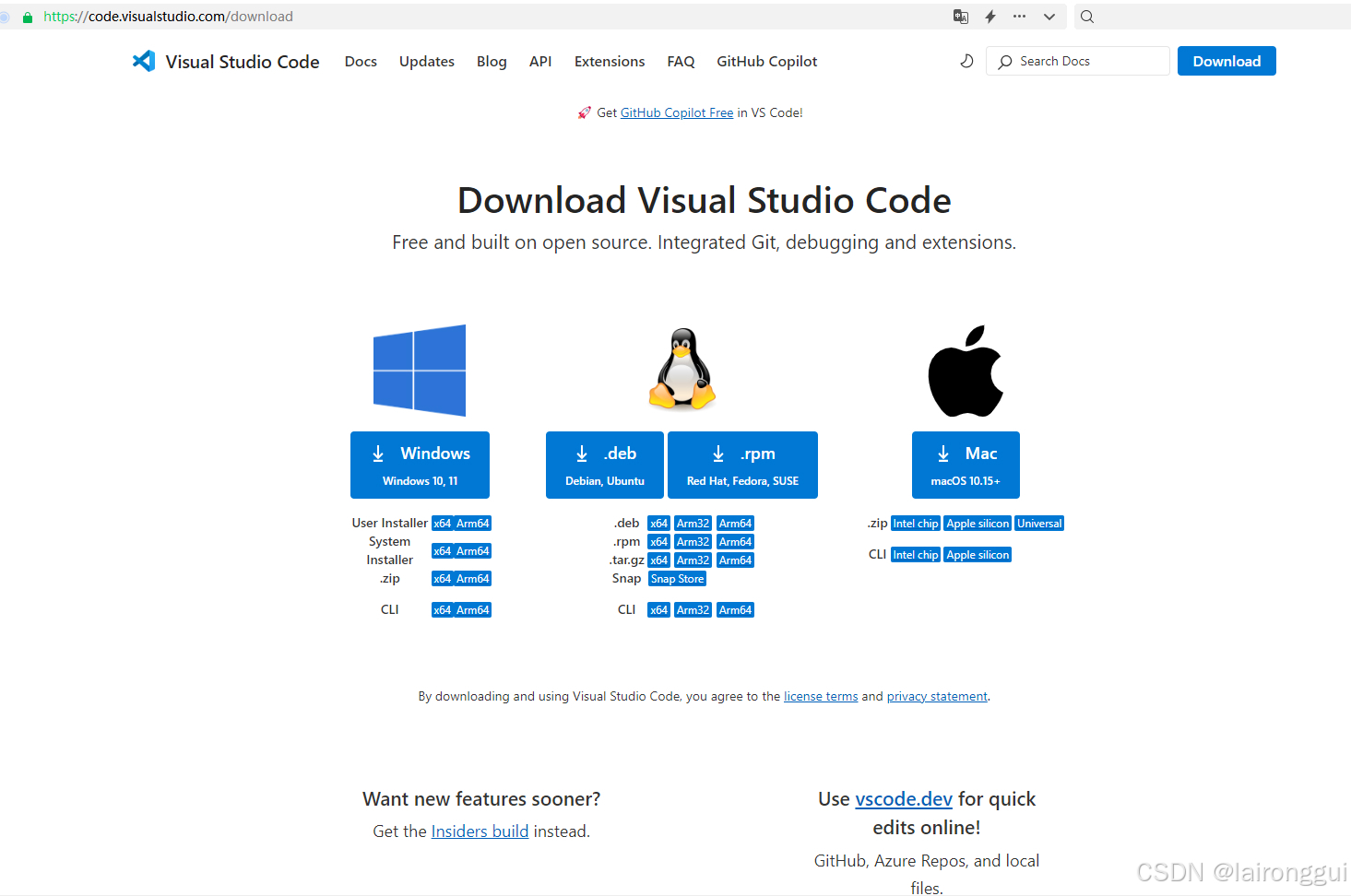

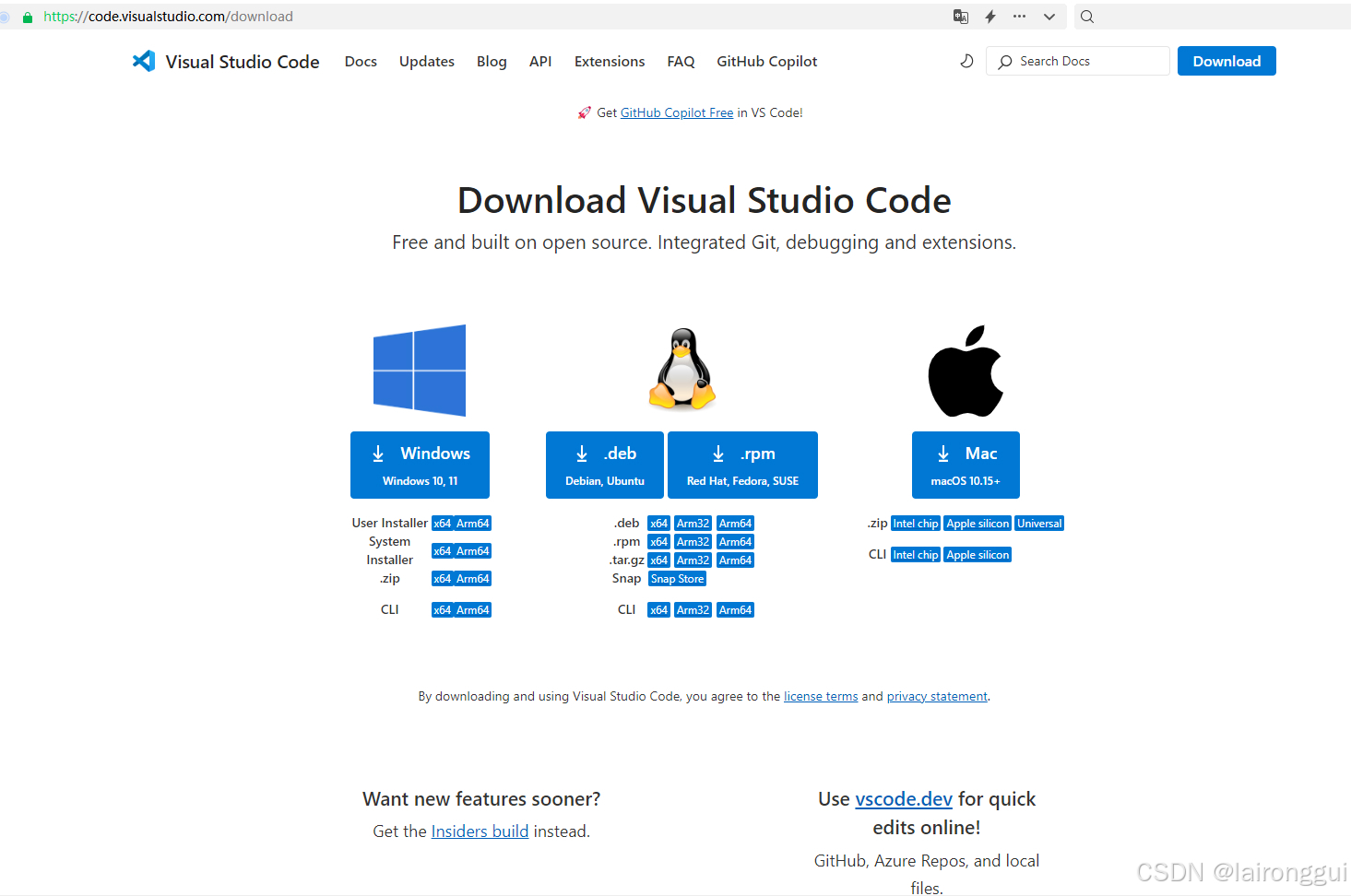

Visual Studio Code + Cline 实现AI自动编程

Visual Studio Code + Cline 实现AI自动编程,可接入DeepSeek、硅基流动等。

FastGPT 官方文档 | 使用 Docker Compose 快速部署 FastGPT

修改文件,并执行再执行重起容器。具体配置,参考配置详解。可以查看日志,在启动容器后,第一次请求网页,会进行配置文件读取,可以看看有没有读取成功以及有无错误日志。进入 FastGPT 容器,可以通过ls data查看目录下是否成功挂载文件。可通过查看配置文件。可能不生效的原因挂载目录不正确配置文件不正确,日志中会提示,配置文件需要是标准的 JSON 文件。修改后,没有再,restart是不会重新挂载

调用本地部署好的ollama的API—stream:True流式返回

调用本地部署好的ollama的API—stream:True流式返回

Visual Studio Code + Cline 实现AI自动编程

Visual Studio Code + Cline 实现AI自动编程,可接入DeepSeek、硅基流动等。

到底了