简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

经历了MiniMind-V1的低质量预训练数据,导致模型胡言乱语的教训,2025-02-05之后决定不再采用大规模无监督的数据集做预训练。进而尝试把匠数大模型数据集的中文部分提取出来,清洗出字符<512长度的大约1.6GB的语料直接拼接成预训练数据,hq即为high quality(当然也还不算high,提升数据质量无止尽)。文件数据格式为{"text": "如何才能摆脱拖延症?治愈拖延症并不容易

例如,如果用户想修改文本解码器的某一层,可能需要通过遍历模型的子模块并替换相应的层。此外,针对qwen2-2B-VL这个模型,可能需要特定的处理,比如视觉特征的提取部分如何与文本部分结合,是否需要调整图像处理的分辨率或通道数等。嗯,用户的问题是关于如何使用transformers库加载预训练的大模型,比如qwen2-2B-VL,然后加载预训练参数,修改部分网络结构,再进行重新训练。最后,提醒用户在

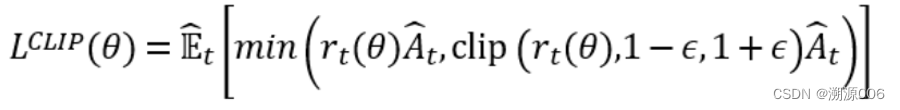

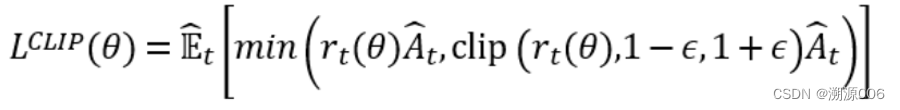

PPO算法的原理解读以及代码实现

摘要:tokenizer.apply_chat_template是Hugging Face Transformers库中处理对话数据的方法,将聊天消息转换为模型输入格式。当参数设置为tokenize=False, add_generation_prompt=True时,会输出格式化字符串并在末尾添加模型生成标记(如Mistral模型的\n<|im_start|>assistant\n)

例如,如果用户想修改文本解码器的某一层,可能需要通过遍历模型的子模块并替换相应的层。此外,针对qwen2-2B-VL这个模型,可能需要特定的处理,比如视觉特征的提取部分如何与文本部分结合,是否需要调整图像处理的分辨率或通道数等。嗯,用户的问题是关于如何使用transformers库加载预训练的大模型,比如qwen2-2B-VL,然后加载预训练参数,修改部分网络结构,再进行重新训练。最后,提醒用户在

PPO算法的原理解读以及代码实现

条件判断(返回两个数中的较大值)print(max_value(5, 8)) # 输出 8与普通函数的区别特性lambda 表达式普通函数 (def)名称匿名(无函数名)有函数名代码复杂度仅限单个表达式,无语句(如循环、赋值)可包含任意复杂代码块可读性适合简单逻辑适合复杂逻辑复用性通常一次性使用可重复调用注意事项避免滥用:复杂逻辑应使用def定义普通函数,保证代码可读性。变量作用域。

例如,如果用户想修改文本解码器的某一层,可能需要通过遍历模型的子模块并替换相应的层。此外,针对qwen2-2B-VL这个模型,可能需要特定的处理,比如视觉特征的提取部分如何与文本部分结合,是否需要调整图像处理的分辨率或通道数等。嗯,用户的问题是关于如何使用transformers库加载预训练的大模型,比如qwen2-2B-VL,然后加载预训练参数,修改部分网络结构,再进行重新训练。最后,提醒用户在

查看完整的命令列表和详细说明。如果有特定需求(如自定义模型),可以参考官方文档或社区资源。Ollama 的命令设计简洁易用,涵盖了模型的下载、运行、管理、自定义等操作。Ollama 提供了一系列命令来管理和使用模型。