简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

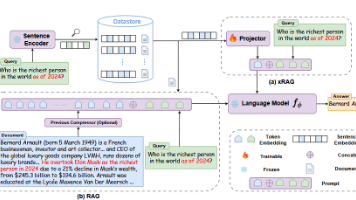

本博客探讨了**自我蒸馏**和**模仿学习**两种技术在**xRAG**(Retrieval-Augmented Generation)模型中的应用。自我蒸馏通过让模型模仿自己生成的输出进行优化,而模仿学习则通过模仿专家行为来提高模型生成性能。结合这两种技术,xRAG能够更有效地利用检索到的上下文信息,提升生成质量。通过对比自我蒸馏和传统蒸馏技术,本文阐述了它们在生成任务中的优势和实际应用。

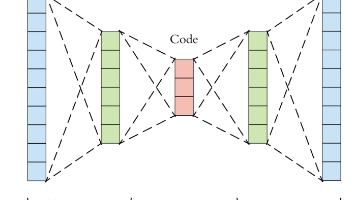

本文系统性地介绍了生成式深度学习的三大核心模型:RNN、VAE和GAN,从理论基础到代码实战提供了完整的知识体系。

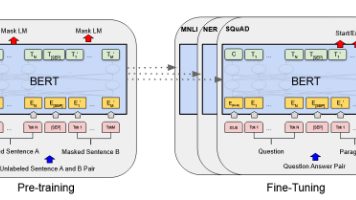

大模型微调主要有两种方式:不冻结参数的全模型微调和冻结主干仅训练线性分类头。全模型微调更新所有参数,适用于数据量大、任务复杂的场景,能获得最佳性能但计算成本高;冻结主干方式仅训练分类层,计算效率高、避免过拟合,适合小数据集和简单任务。本文对比了两种方法的优缺点,提供了BERT模型微调的代码示例,并列举了相关论文应用案例。

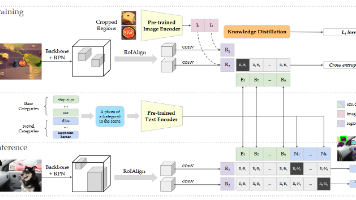

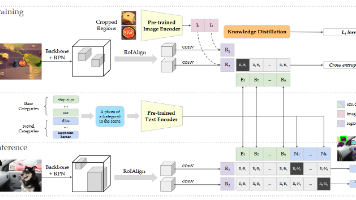

知识蒸馏是一种将大模型知识迁移到小模型的技术,通过让学生模型学习教师模型的预测概率分布(软目标)来提升性能。该方法广泛应用于模型压缩、移动设备和NLP任务,能提高泛化能力并加速推理。核心流程包括训练教师模型、生成软目标和训练学生模型,损失函数结合软硬目标。扩展方法包括温度调节、多教师蒸馏和中间层蒸馏。PyTorch示例展示了蒸馏实现,而ViLD模型则结合视觉和语言知识进行蒸馏,提升跨模态任务性能。

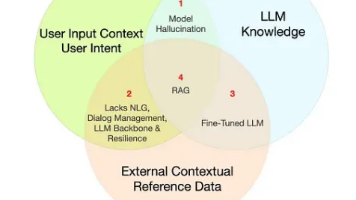

摘要: RAG(Retrieval-Augmented Generation)模型通过结合外部检索与生成技术,有效提升大语言模型(LLM)的文本生成质量。其核心架构包括检索模块(从文档库动态获取相关信息)和生成模块(基于检索内容生成文本),解决了传统LLM的幻觉、知识过时和上下文理解不足等问题。RAG支持实时信息更新,适用于问答系统、对话机器人等场景,显著增强生成内容的准确性与时效性。论文《Ret

知识蒸馏是一种将大模型知识迁移到小模型的技术,通过让学生模型学习教师模型的预测概率分布(软目标)来提升性能。该方法广泛应用于模型压缩、移动设备和NLP任务,能提高泛化能力并加速推理。核心流程包括训练教师模型、生成软目标和训练学生模型,损失函数结合软硬目标。扩展方法包括温度调节、多教师蒸馏和中间层蒸馏。PyTorch示例展示了蒸馏实现,而ViLD模型则结合视觉和语言知识进行蒸馏,提升跨模态任务性能。

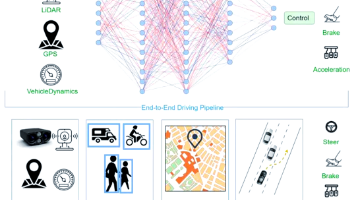

端到端训练是深度学习的革命性范式,通过构建单一可微分模型,直接将原始输入映射到最终输出。其核心突破在于四大要求:1.全局可微分性 - 确保梯度顺畅回流2.统一优化目标 - 单一损失函数3.指导全局优化3.协调特征学习 - 自动演化最优内部表示4.稳定训练动力学 - 管理梯度流保证收敛

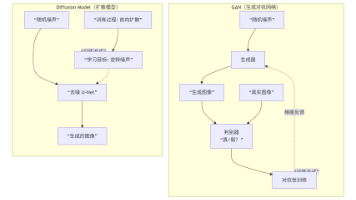

Diffusion Model通过渐进式加噪/去噪过程生成图像,训练稳定、质量高但速度慢;GAN采用对抗训练,生成快但训练不稳定。当前Diffusion Model已成为AIGC主流,正解决速度瓶颈,未来可能与GAN技术融合。