简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

免费风格微调的完整教程,基于(找图+清理筛选+打标+训练+推理验证

使用命令行前,请确保已经通过pip install modelscope 安装ModelScope。

结论pytorch 、cudatoolkit、cuda驱动的版本需一致问题描述使用多GPU训练stylegan3 模型时:python train.py --outdir=training-runs --cfg=stylegan3-r \--data=datastes/your_data.zip \--cfg=stylegan3-r --gpus=4 --batch=32 --gamma=8 --

免费风格微调的完整教程,基于(找图+清理筛选+打标+训练+推理验证

可以在消费显卡运行的多视图一致性图片生成(文生多图,图生多图)

一张图微调qwen-vl

Qwen-VL-7B`是阿里基于语言模型`Qwen-7B`(LLMs),研发的**大规模视觉语言模型**(Large Vision Language Model, **LVLM**)> Qwen-VL-Chat =大语言模型(Qwen-7B) +视觉图片特征编码器(Openclip's `ViT-bigG`)+ 位置感知视觉语言适配器(可训练Adapter)+`约15亿`训练数据+`多轮训练`

一张图微调qwen-vl

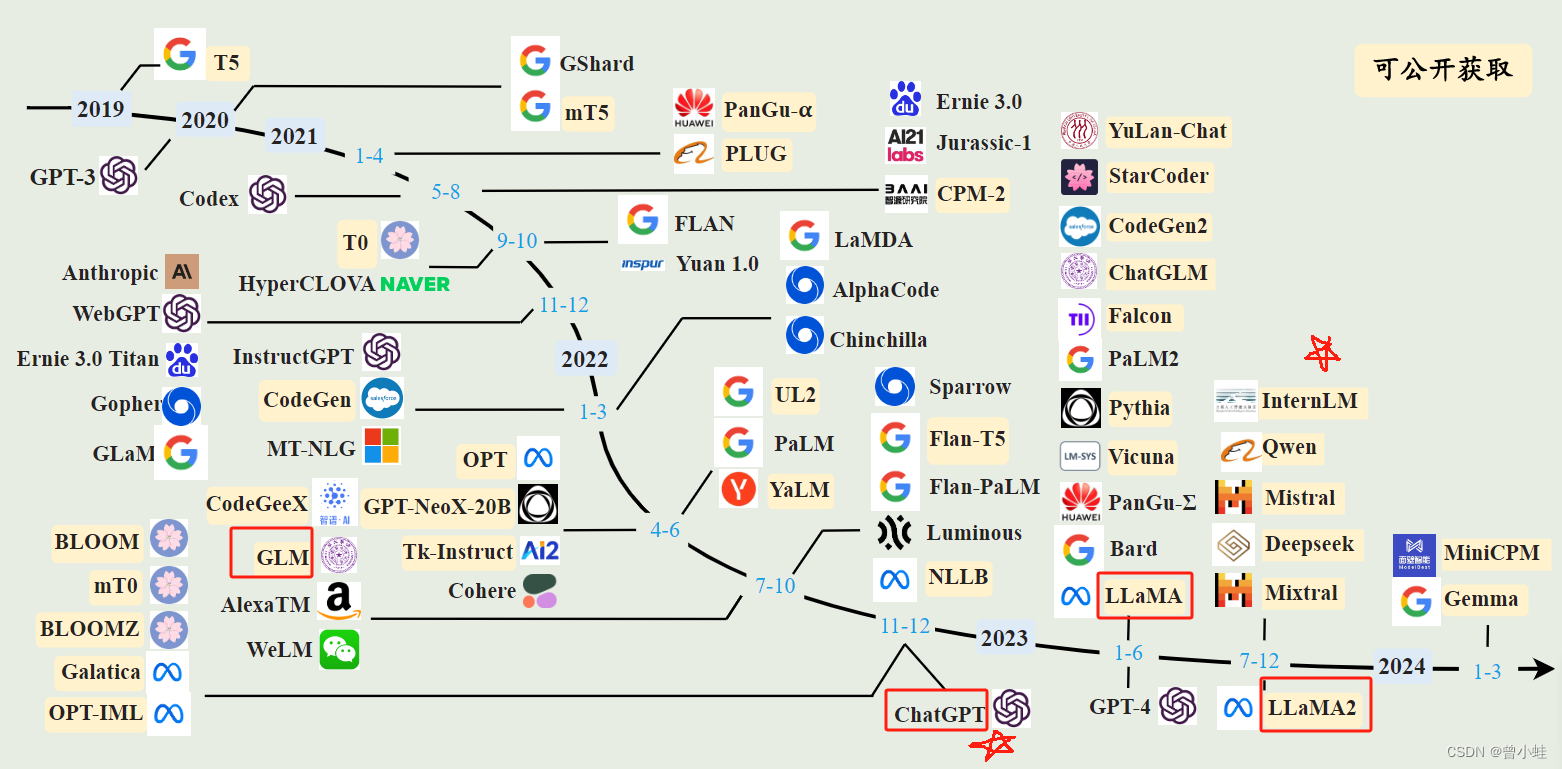

大语言模型使用无标注语料库进行预训练,当模型大小达到一定数量,出现智能涌现,能够进行小模型不具备的能力:下文学习,在未经过特定任务微调的情况下能够理解并响应复杂指令**;以及对新任务的适应性,即基于给定的输入示例就能够推断出相应的输出模式

23.06 LLaVA-Med 使用通用领域( general-domain)的 LLaVA 进行初始化.然后60W+6W的数据以课程学习方式(curriculum learning)持续训练(首先是**生物医学概念对齐**(biomedical concept alignment), 然后是全面的指令微调( instruction-tuning))。