简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

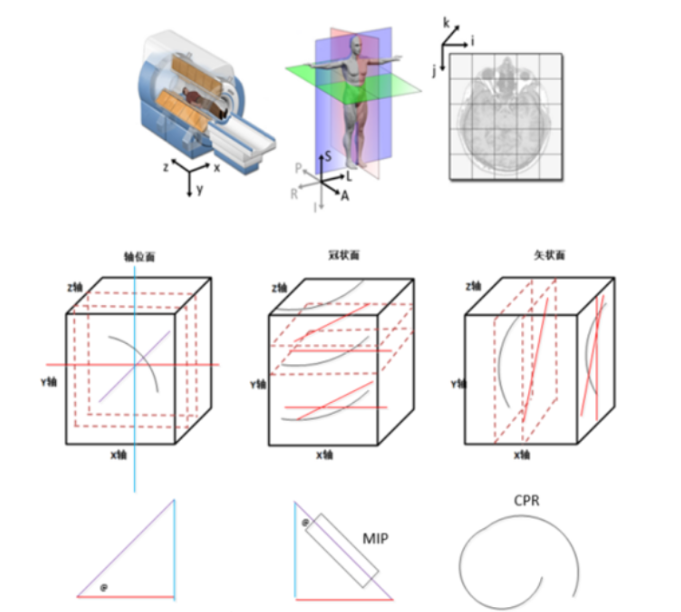

采用原生算法开发的MPRCPR ,正交面、斜面、曲面

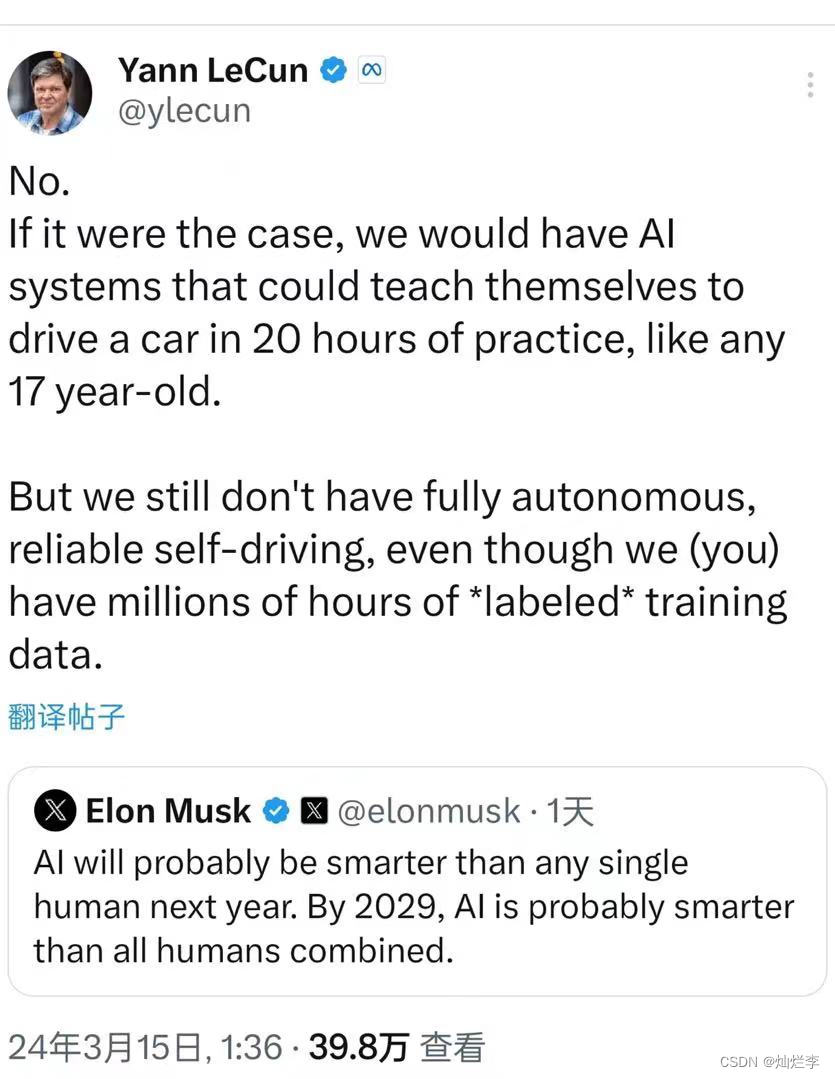

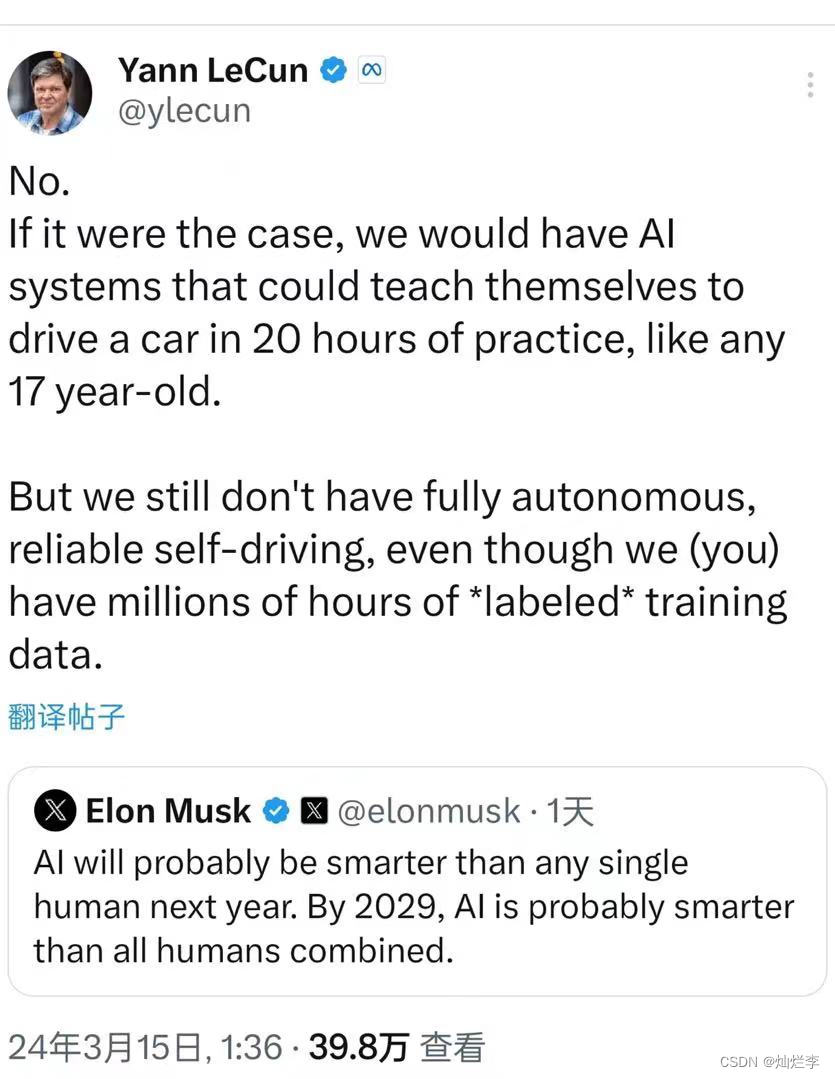

杨立坤:不,如果是这样的话,我们会有Alsystems,可以像任何17岁的孩子一样,在20个小时的练习中自学驾驶汽车。但我们仍然没有完全自主、可靠的自动驾驶,尽管我们(您)有数百万小时的“标记”培训数据。埃隆·马斯克:AI明年可能会比任何一个人都聪明。到2029年,Alis可能比所有人类加起来都聪明。

随着技术的不断进步,我们期待BitNet b1.58能够在成本更低的硬件上运行,进一步推动LLM的普及和应用。BitNet b1.58的内存占用是LLAMA LLM的1/3.32(基于3B模型的数据),所以70B参数的BitNet b1.58的内存占用大约是80GB / 3.32 ≈ 24GB。随着技术的成熟,我们期待它在更多领域中的应用,为我们的生活带来更多便利。最近,微软研究院的研究人员提出了

Lehigh大学的Lichao Sun教授作为共同通讯作者,对Mora项目的未来充满期待,他表示:“我们希望Mora能够指导视频生成技术的未来发展方向,通过协作AI智能体,推动视频内容创造和利用方式的重大进步。Mora采用多智能体协作的方式,通过分解视频生成过程为多个子任务,并由专门的智能体负责执行,从而实现了文本到视频、图像到视频、视频编辑和模拟数字世界等多种视频生成任务。随着技术的不断进步和开

杨立坤:不,如果是这样的话,我们会有Alsystems,可以像任何17岁的孩子一样,在20个小时的练习中自学驾驶汽车。但我们仍然没有完全自主、可靠的自动驾驶,尽管我们(您)有数百万小时的“标记”培训数据。埃隆·马斯克:AI明年可能会比任何一个人都聪明。到2029年,Alis可能比所有人类加起来都聪明。

模型参数内存为14GB不变,但由于大幅降低了优化器状态和激活内存占用,最终总内存消耗仅为21.3GB,这意味着,我们现在可以在一张24GB显存的RTX 4090显卡上,轻松完成70亿参数模型的从头训练!这篇论文提出了一种名为GaLore的全新训练算法,让我们可以在单台24GB显存的消费级GPU上,高效训练70亿参数量级的大型语言模型。然而,训练这些大模型需要消耗大量的计算资源和内存,这对硬件提出了

随着技术的不断进步,我们期待BitNet b1.58能够在成本更低的硬件上运行,进一步推动LLM的普及和应用。BitNet b1.58的内存占用是LLAMA LLM的1/3.32(基于3B模型的数据),所以70B参数的BitNet b1.58的内存占用大约是80GB / 3.32 ≈ 24GB。随着技术的成熟,我们期待它在更多领域中的应用,为我们的生活带来更多便利。最近,微软研究院的研究人员提出了

随着技术的不断进步,我们期待BitNet b1.58能够在成本更低的硬件上运行,进一步推动LLM的普及和应用。BitNet b1.58的内存占用是LLAMA LLM的1/3.32(基于3B模型的数据),所以70B参数的BitNet b1.58的内存占用大约是80GB / 3.32 ≈ 24GB。随着技术的成熟,我们期待它在更多领域中的应用,为我们的生活带来更多便利。最近,微软研究院的研究人员提出了

英伟达GPU采用的是一种更加传统的架构。这种快速的数据流编译技术使SambaNova芯片能够针对给定的AI模型,自动生成最优的计算指令和分布式执行策略,充分利用芯片的硬件能力,突破了传统架构的性能瓶颈。可重构数据流架构是SambaNova芯片的核心,它能够根据不同人工智能模型的需求,动态调整芯片内部的数据通路,实现高效的计算和数据流动。可重构数据流架构代表了人工智能芯片设计的一个重要方向,它通过灵

模型参数内存为14GB不变,但由于大幅降低了优化器状态和激活内存占用,最终总内存消耗仅为21.3GB,这意味着,我们现在可以在一张24GB显存的RTX 4090显卡上,轻松完成70亿参数模型的从头训练!这篇论文提出了一种名为GaLore的全新训练算法,让我们可以在单台24GB显存的消费级GPU上,高效训练70亿参数量级的大型语言模型。然而,训练这些大模型需要消耗大量的计算资源和内存,这对硬件提出了