简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

module类内部state_dict返回对象只是一个copy,所以修改里面的值并不能影响模型中真正的参数,我们可以借助tensor.copy_()方法来赋值。简单例子:a = torch.tensor([[1,2], [3,4]])b = torch.tensor([[7,8],[9,10]])a.copy_(b)print(a)print(b)...

本文介绍了在Linux系统安装GPU版PyTorch的完整步骤:1)检查系统架构和NVIDIA驱动;2)安装匹配的CUDA 11.8 Toolkit;3)配置环境变量;4)创建Python虚拟环境;5)通过国内镜像源安装PyTorch 2.0.1+cu118及相关组件;6)验证安装结果。常见问题解决方法包括检查驱动兼容性、延长pip超时设置、使用虚拟环境隔离依赖等。所需环境依赖为NVIDIA驱动≥

一、问题描述当我们在处理图像识别或者图像分类或者其他机器学习任务的时候,我们总是迷茫于做出哪些改进能够提升模型的性能(识别率、分类准确率)。。。或者说我们在漫长而苦恼的调参过程中到底调的是哪些参数。。。所以,我花了一部分时间在公开数据集CIFAR-10 [1] 上进行探索,来总结出一套方法能够快速高效并且有目的性地进行网络训练和参数调整。CIFAR-10数据集有60000张图片,每张图片均为分辨率

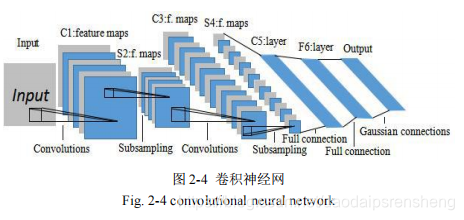

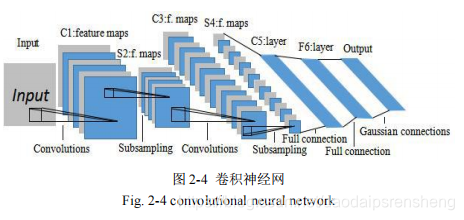

卷积神经网络通常是由四部分组成:输入层、卷积层、下采样层、全连接层和输出层。典型的卷积神经网络中,开始的几层一般是卷积层和下采样层交替出现,靠近输出层的最后几层通常是全连接层,其结构如图2-4所示。一幅原始二维图像输入卷积神经网络网络进入卷积层后,将会被卷积核函数作用提取到输入图像的局部特征,这些局部特征一旦被提取之后,它们之间的位置关系也会随之确定下来。一个卷积核对应一种特征,对同一幅图像采用相

卷积神经网络采用BP算法学习网络参数,BP算法是基于梯度下降原则来更新网络参数。在卷积神经网络中,需要优化的参数有卷积核参数k、下采样层权值β、全连接层网络权值w及各层偏置b。我们以卷积神经网络的期望和输出之间的均方误差为代价函数,目的是最小化该代价函数,使得实际神经网络输出可以对输入做出准确的预测,代价函数如下所示:其中,N为训练样本的数量,是第n个训练样本的真实类别标签,是第n个训练样本经过卷

1. 前言:细微之处,彰显本质;不求甚解,难以理解。一直以来,我都认为,梯度下降法就是最速下降法,反之亦然,老师是这么叫的,百度百科上是这么写的,wiki百科也是这么说的,这么说,必然会导致大家认为,梯度的反方向就是下降最快的方向,然而最近在读Stephen Boyd 的凸优化的书,才发现事实并非如此,梯度下降和最速下降并不相同,梯度方向也不一定总是下降最快的方向。2. 梯度下降法...

卷积神经网络通常是由四部分组成:输入层、卷积层、下采样层、全连接层和输出层。典型的卷积神经网络中,开始的几层一般是卷积层和下采样层交替出现,靠近输出层的最后几层通常是全连接层,其结构如图2-4所示。一幅原始二维图像输入卷积神经网络网络进入卷积层后,将会被卷积核函数作用提取到输入图像的局部特征,这些局部特征一旦被提取之后,它们之间的位置关系也会随之确定下来。一个卷积核对应一种特征,对同一幅图像采用相

卡方检验(Chi-Square Test)是一类基于卡方分布的假设检验方法,常用于检验两个离散变量是否存在关联(独立性检验)、理论分布与观测分布是否一致(适配度检验)检验两个分类变量(离散型变量)之间是否存在统计学上的关联。常见于列联表分析(Contingency Table),又称卡方列联表分析。例如,研究“性别”与“是否违约”之间是否有显著关系。检验一组观测值与某一理论分布(或期望比率)是否匹

安装WSL2首先要保证操作系统可以开启hyper-v功能,默认支持开启的版本为:Windows11企业版、专业版或教育版,而家庭版是不支持开启的,但是我们如果是家庭版,可以自行安装相关组件来开启hyper-v功能。2. 将文件重新命名为:hyper-v.bat,名称可以随意取,但是扩展名要为【.bat】这个表示可执行文件。3. 右键【hyper-v.bat】文件,选择【以管理员身份运行】4. 等待